【Python大数据处理】:使用Hadoop和Spark的高效数据处理

发布时间: 2024-12-19 14:33:00 阅读量: 6 订阅数: 5

# 摘要

本文概述了Python在大数据处理中的应用,深入探讨了Hadoop和Spark生态系统的基础架构、编程模式、集群配置及优化策略。同时,文中详细介绍了Python在大数据处理中的实战技巧,包括数据清洗、预处理、可视化以及安全和隐私保护的方法。文章还通过对构建数据仓库、实时数据处理和机器学习与大数据结合等实际案例的分析,为读者提供了一个全面的大数据处理视角,旨在为大数据项目提供实战指导和解决方案。

# 关键字

大数据处理;Python;Hadoop;Spark;数据仓库;数据可视化;机器学习

参考资源链接:[小甲鱼零基础Python课后习题+答案全集(237页)](https://wenku.csdn.net/doc/3s1rt85089?spm=1055.2635.3001.10343)

# 1. Python大数据处理概述

在当今的信息时代,大数据处理已成为企业和研究机构获取竞争优势和洞察力的关键。Python作为一种高效的编程语言,在数据处理、分析以及机器学习领域已经成为了一个流行选择。本章将为您概述Python在大数据处理中的重要性及其核心概念。

## 1.1 Python在数据科学中的地位

Python因其简洁的语法、强大的库支持和社区的活跃贡献,成为数据科学领域的首选语言。通过Pandas、NumPy和SciPy等库,Python为数据处理提供了高效而优雅的方法。此外,Python在大数据框架如Hadoop和Spark中也能找到它的身影,尤其是在实现复杂数据任务时,Python的灵活性和强大的数据处理能力使其成为不可或缺的工具。

## 1.2 大数据处理的挑战

随着数据量的激增,传统的数据处理方法不再适用。大数据处理面临的挑战包括数据的存储、管理、分析以及可视化。这就要求开发者不仅要理解数据本身,还要掌握分布式计算框架、云计算资源以及高效算法的设计和实现。Python因其广泛的第三方库和框架,为解决这些挑战提供了便利。

## 1.3 本章小结

本章概述了Python在大数据处理中的地位和应用,以及处理大数据时所面临的挑战。接下来的章节将具体介绍Python如何与Hadoop和Spark等大数据技术相结合,进一步探讨其在实际应用中的具体案例。

# 2. Hadoop在大数据处理中的应用

## 2.1 Hadoop生态系统概览

### 2.1.1 Hadoop的核心组件介绍

Hadoop生态系统的出现是为了解决大规模数据集存储和计算的需求。该生态系统中,几个核心组件协同工作,各司其职,为大数据处理提供了全面的解决方案。在Hadoop的核心组件中,最重要的有以下三个:

- **Hadoop Distributed File System (HDFS)**:Hadoop的分布式文件系统,它为存储大数据提供了一个可扩展的、可靠的存储系统。

- **Yet Another Resource Negotiator (YARN)**:负责资源管理和任务调度,它优化了资源分配,使得多种数据处理模型可以在同一集群上运行。

- **MapReduce**:是一个编程模型和处理大数据的软件框架,它能够对大量数据进行并行处理。

这些组件共同构成了Hadoop的核心,使得其能够高效地处理PB级别的数据。

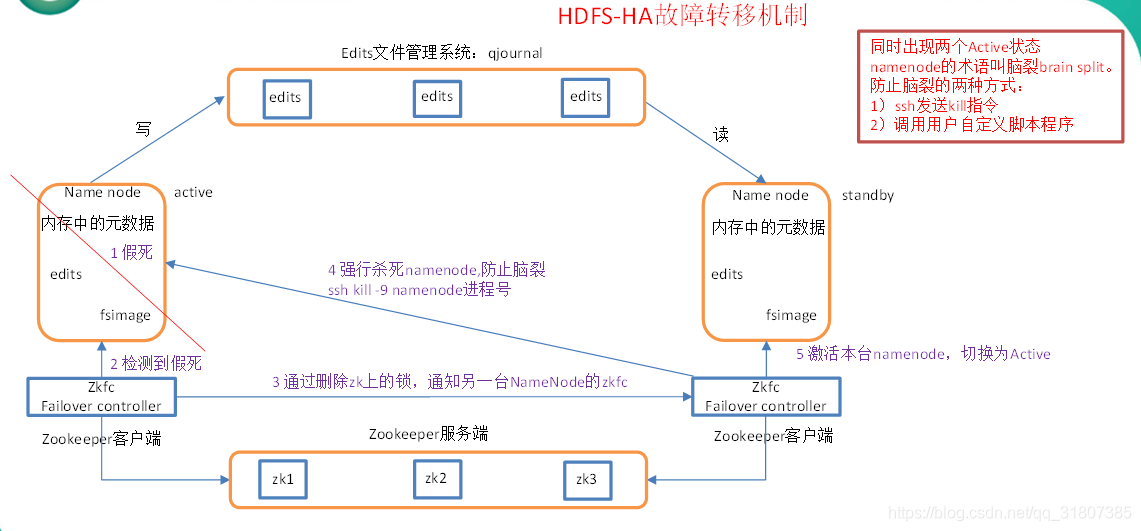

### 2.1.2 Hadoop的工作原理及架构

Hadoop的架构设计允许它在普通硬件上实现高可用性和可扩展性。在Hadoop的典型部署架构中,数据存储在HDFS中,而YARN负责管理计算资源和作业调度。整个架构的运作原理如下:

1. **数据存储**:HDFS将数据分布存储在集群中的多个节点上,每个节点被称为一个DataNode。数据的元信息,如文件目录结构、文件属性等,则存储在主节点NameNode上。

2. **资源管理和调度**:YARN中的ResourceManager负责管理整个集群的资源分配,而每个节点上的NodeManager则负责监视资源的使用情况,并向ResourceManager汇报。

3. **任务处理**:用户提交的MapReduce作业会被ResourceManager调度执行。MapReduce框架将作业分解成Map任务和Reduce任务,这些任务随后会被NodeManager分配到各个DataNode上执行。

通过这种方式,Hadoop实现了数据的高效存储和处理,即使是在数据量巨大和计算需求复杂的情况下。

## 2.2 Hadoop中的Python应用

### 2.2.1 使用Pydoop进行Hadoop编程

Pydoop是Hadoop的一个Python接口,它允许开发者使用Python编程语言进行Hadoop开发和MapReduce编程。Pydoop提供了一个封装好的API,可以方便地访问HDFS和执行MapReduce作业。

下面是一个简单的Pydoop MapReduce示例,它演示了如何统计词频(Word Count):

```python

from pydoop import mapreduce

def mapper(context):

for line in context.input_value:

for word in line.split():

context.emit(word, 1)

def reducer(key, values):

yield key, sum(values)

if __name__ == '__main__':

mapreduce.run(mapper, reducer)

```

在这个例子中,`mapper` 函数对输入的每行文本进行处理,分割成单词,并发出键值对(word, 1)。`reducer` 函数则对相同的key(即单词)对应的值列表进行求和,输出每个单词出现的总次数。

### 2.2.2 Python与Hadoop的MapReduce模式

在Hadoop中使用Python编写的MapReduce程序,其本质运行方式和Java编写的MapReduce程序并无差别。Python程序通过Pydoop库与Hadoop交互,Hadoop将Python程序视为普通的MapReduce任务执行。

Python与Hadoop的结合特别适合数据科学家和分析师,因为它简化了数据处理的复杂性。开发者可以不用深入Java和Hadoop的内部机制,而直接利用Python的简洁语法来编写复杂的MapReduce任务。

### 2.2.3 实际案例分析

让我们通过一个具体的实际案例来了解如何使用Python与Hadoop结合解决一个具体的大数据问题。假设我们需要分析一个大型的文本数据集,目标是统计出现频率最高的10个单词。

步骤如下:

1. **数据预处理**:首先使用Python脚本或工具对原始数据进行清洗,将其转化为适合MapReduce处理的格式。

2. **编写MapReduce作业**:使用Pydoop框架编写MapReduce作业,执行单词统计。

3. **运行作业**:将编写好的MapReduce作业提交到Hadoop集群上执行。

4. **结果输出**:MapReduce作业完成后,将结果输出到HDFS中,或直接从Pydoop脚本中获取。

通过这种方式,Python编程者能够利用Hadoop的强大计算能力,进行大规模数据的分析和处理。

## 2.3 Hadoop集群的配置和优化

### 2.3.1 集群的搭建和配置步骤

搭建Hadoop集群需要考虑的配置参数众多,以下是一个简化的集群搭建流程:

1. **硬件准备**:确保所有节点都具有足够的存储和内存空间,网络连接稳定。

2. **软件环境**:选择一个稳定的Hadoop版本,并在所有节点上安装Java环境。

3. **Hadoop安装**:在NameNode上配置Hadoop环境变量,并解压Hadoop安装包。

4. **配置HDFS**:配置`hdfs-site.xml`,`core-site.xml`和`dfs-site.xml`等文件,设置HDFS的副本数、路径、权限等参数。

5. **配置YARN和MapReduce**:配置`yarn-site.xml`和`mapred-site.xml`文件,设置资源管理器地址、资源调度策略等参数。

6. **格式化NameNode**:在NameNode上执行`hdfs namenode -format`进行格式化。

7. **启动集群**:使用`start-dfs.sh`和`start-yarn.sh`脚本启动HDFS和YARN。

8. **验证集群状态**:通过`jps`命令检查各个节点上的守护进程是否运行正常。

### 2.3.2 性能调优策略和最佳实践

性能调优是提高Hadoop集群运行效率和任务处理速度的关键步骤。以下是一些常见的调优策略和最佳实践:

- **内存管理**:合理分配和调整内存使用,如堆大小、缓存大小等。

- **副本管理**:根据数据的重要性调整HDFS副本数以优化读写性能和存储空间的使用。

- **数据本地化**:尽量将计算任务调度到数据所在的节点执行,减少网络传输。

- **任务调度**:合理配置任务调度策略,如FairScheduler,以均衡各节点的负载。

- **IO优化**:优化磁盘读写,例如使用SequenceFile或Parquet等列式存储格式。

通过这些策略的合理应用,可以显著提高Hadoop集群的整体性能和稳定性。

# 3. Spark在大数据处理中的应用

## 3.1 Spark基础架构解析

### 3.1.1 Spark的核心概念和优势

Apache Spark,作为大数据

0

0