VGGNet的部署与加速:探索VGGNet的实际部署和加速技术,让你的模型落地应用

发布时间: 2024-07-07 04:51:11 阅读量: 89 订阅数: 43

第01章_VGGNet模型.zip

# 1. VGGNet简介**

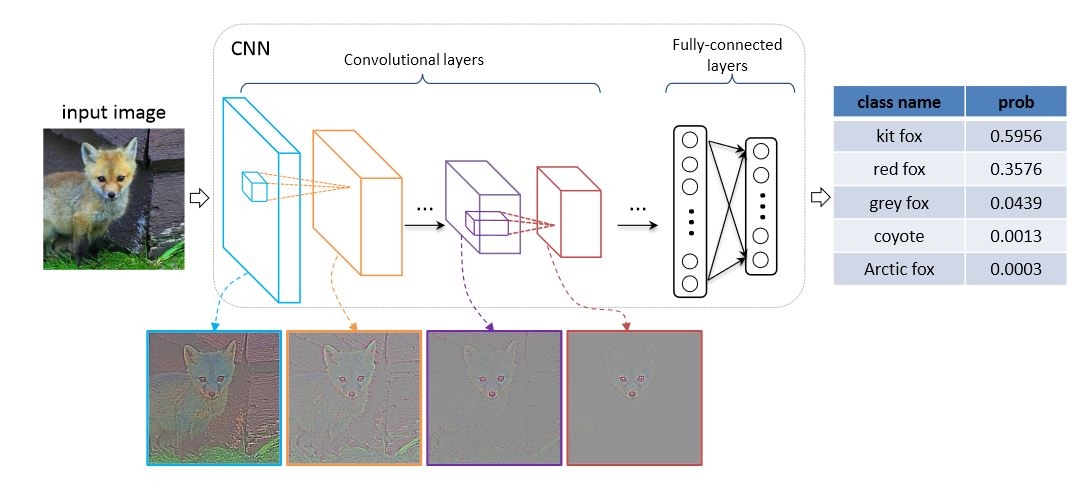

VGGNet是一种卷积神经网络(CNN),由牛津大学视觉几何组开发。它以其简单、易于训练和在图像分类任务上的出色表现而闻名。VGGNet的架构由一系列卷积层和池化层组成,以提取图像特征。其名称源自牛津大学所在的城市牛津(VGG)。

VGGNet有几个变体,最著名的有VGG16和VGG19。VGG16由16个卷积层和3个全连接层组成,而VGG19由19个卷积层和2个全连接层组成。这些网络的深度使其能够学习复杂的高级特征,从而提高了图像分类的准确性。

# 2. VGGNet的部署

### 2.1 VGGNet的部署框架

VGGNet的部署通常涉及将其集成到现有的软件系统或应用程序中。为此,有几种流行的部署框架可供选择:

- **TensorFlow Serving:**一个开源框架,用于部署和提供机器学习模型,包括VGGNet。它提供了一个易于使用的API,用于加载模型、处理输入数据和生成预测。

- **PyTorch Serving:**类似于TensorFlow Serving,PyTorch Serving是一个用于部署和提供PyTorch模型的框架。它具有与TensorFlow Serving类似的功能,但专门针对PyTorch模型进行了优化。

- **ONNX Runtime:**ONNX(开放神经网络交换)是一种标准,用于表示机器学习模型。ONNX Runtime是一个跨平台运行时,用于执行ONNX模型。它支持VGGNet和其他流行的模型。

### 2.2 VGGNet的部署优化

在部署VGGNet时,可以应用多种优化技术来提高其性能和效率。

#### 2.2.1 模型压缩

模型压缩技术旨在减少模型的大小,同时保持其准确性。对于VGGNet,可以使用以下方法:

- **剪枝:**移除对模型准确性贡献较小的权重和神经元。

- **量化:**将浮点权重和激活转换为低精度格式,例如int8或int16。

- **蒸馏:**使用较小的学生模型从较大的教师模型中学习知识。

#### 2.2.2 量化

量化是将浮点权重和激活转换为低精度格式的过程。这可以显着减少模型的大小和内存占用,同时保持其准确性。

```python

import tensorflow as tf

# 创建一个VGGNet模型

model = tf.keras.applications.VGG16()

# 量化模型

quantized_model = tf.keras.models.quantization.quantize_model(model)

# 保存量化模型

quantized_model.save('quantized_vgg16.h5')

```

#### 2.2.3 知识蒸馏

知识蒸馏是一种训练技术,其中较小的学生模型从较大的教师模型中学习知识。这可以创建更紧凑、更有效的模型,同时保持与教师模型类似的准确性。

```python

import tensorflow as tf

# 创建一个VGG16教师模型

teacher_model = tf.keras.applications.VGG16()

# 创建一个VGG11学生模型

student_model = tf.keras.applications.VGG11()

# 训练学生模型

student_model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

student_model.fit(x_train, y_train, epochs=10, validation_data=(x_test, y_test))

# 使用教师模型蒸馏知识

student_model.compile(optimizer='adam', loss=tf.keras.losses.MeanSquaredError(), metrics=['accuracy'])

student_model.fit(x_train, teacher_model(x_train), epochs=10, validation_data=(x_test, teacher_model(x_test)))

```

# 3. VGGNet的加速

### 3.1 并行化

并行化是一种通过同时使用多个处理单元来提高计算速度的技术。在深度学习中,并行化可以应用于数据并行化和模型并行化。

#### 3.1.1 数据并行化

数据并行化是一种将数据拆分成多个部分,然后在不同的处理单元上并行处理的技术。这种方法适用于训练大型数据集,因为可以将数据集拆分成多个小块,然后在不同的处理单元上并行训练。

**代码示例:**

```python

import torch

import torch.nn as nn

import torch.nn.parallel

# 创建一个VGGNet模型

model = nn.Sequential(

nn.Conv2d(3, 64, 3, padding=1),

nn.ReLU(),

nn.MaxPool2d(2, 2),

nn.Conv2d(64, 128, 3, padding=1),

nn.ReLU(),

nn.MaxPool2d(2, 2),

nn.Flatten(),

nn.Linear(128 * 7 * 7, 10)

)

# 将模型并行化到两个GPU上

model = nn.DataParallel(model)

# 加载数据

data = torch.randn(128, 3, 224, 224)

# 在并行化模型上训练数据

optimizer = torch.optim.Adam(model.parameters())

for epoch in range(10):

for i in range(len(data)):

output = model(data[i])

loss = torch.nn.MSELoss()(output, torch.zeros_like(output))

optimizer.zero_grad()

loss.backward()

optimizer.step()

```

**逻辑分析:**

这段代码使用PyTorch的`nn.DataParallel`模块将VGGNet模型并行化到两个GPU上。`nn.DataParallel`模块将模型复制到每个GPU上,并自动将数据拆分成多个部分,然后在不同的GPU上并行训练。

#### 3.1.2 模型并行化

模型并行化是一种将模型拆分成多个部分,然后在不同的处理单元上并行处理的技术。这种方法适用于训练非常大的模型,因为可以将模型拆分成多个小块,然后在不同的处理单元上并行训练。

**代码示例:**

```python

import torch

import torch.nn as nn

import torch.nn.parallel

# 创建一个VGGNet模型

model = nn.Sequential(

nn.Conv2d(3, 64, 3, padding=1),

nn.ReLU(),

nn.MaxPool2d(2, 2),

nn.Conv2d(64, 128, 3, padding=1),

nn.ReLU(),

nn.MaxPool2d(2, 2),

nn.Flatten(),

nn.Linear(128 * 7 * 7, 10)

)

# 将模型并行化到两个GPU上

model = nn.DataParallel(model, dim=1)

# 加载数据

data = torch.r

```

0

0