字符集与编码处理:Guava IO库中的文本文件处理技巧

发布时间: 2024-09-26 15:33:01 阅读量: 99 订阅数: 47

# 1. 字符集与编码处理基础知识

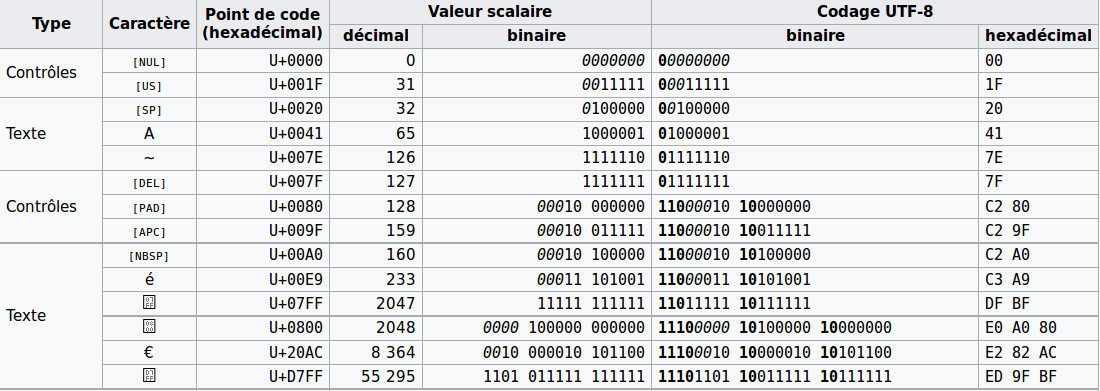

在深入探讨Guava IO库在字符集与编码处理方面的应用前,有必要先了解字符集与编码处理的基础知识。字符集是一组字符的集合,是不同语言、符号的数字化表示。编码则是将字符集中的字符转换成特定格式的字节序列的过程。字符编码分为单字节编码如ASCII和多字节编码如UTF-8。理解这些基础概念对于有效处理文本文件至关重要。在不同的编程语言和库中处理字符编码时,正确的使用字符集和编码方式可以避免数据损坏、乱码等常见问题。这为后续章节探讨如何利用Guava IO库高效地处理文本文件奠定了理论基础。

# 2. Guava IO库概述及文本处理优势

## 2.1 Guava IO库的引入背景

Guava IO库是Google开源的Java核心库的一部分,它提供了一套灵活且强大的输入输出工具,极大地简化了Java中传统的文件操作和数据流处理。在文本处理方面,Guava IO库通过内置的字符集支持、文件编码检测和转换机制、以及流式处理接口,提供了比传统Java IO更为直观和便捷的操作方式。

传统Java IO在处理文本时需要编写较多的样板代码来完成字符集的识别、转换等操作,这不仅增加了开发工作量,也容易产生错误。Guava IO库的引入,可以使得开发者专注于业务逻辑,而将底层的文本处理细节交给库函数去处理。

## 2.2 Guava IO库的功能特点

Guava IO库的功能特点主要包括:

- **字符集处理:** Guava提供了对字符集识别、转换的支持,能够处理多种不同的编码格式。

- **流式处理:** 其流式处理接口允许数据以流的形式被高效处理,而不是一次性加载到内存中。

- **可扩展性:** Guava IO库支持可插拔的编码处理器,开发者可以自定义编码处理器来处理特定的编码需求。

## 2.3 Guava IO库在文本处理中的优势

在文本处理方面,Guava IO库相比传统的Java IO有以下几个优势:

- **简化编码处理:** Guava隐藏了字符集转换的复杂性,开发者可以不必关心底层编码细节。

- **流式读写:** Guava IO库支持流式读写操作,这使得处理大文件或网络IO时不必一次性将数据全部加载到内存。

- **扩展性与兼容性:** Guava提供了易于扩展的接口,使得它很容易与其他IO库或框架进行集成。

## 2.4 Guava IO库与传统Java IO的对比分析

从文本处理的角度来看,Guava IO库与传统Java IO的一个关键差异在于对字符集处理的支持。传统Java IO在没有额外工具类辅助的情况下,处理不同编码格式的文本较为复杂。而Guava IO库提供的工具类和方法大大降低了处理编码问题的难度。例如,Guava的`CharStreams`类就提供了一系列简单的方法来读取和写入字符串,自动处理字符集转换,而不需要手动使用`InputStreamReader`和`OutputStreamWriter`。

另一个关键差异是对流式处理的支持。Guava IO库能够以流的形式处理数据,这在处理大文件时非常有用,因为它可以有效减少内存使用,并且可以边读边写,提高效率。

## 2.5 Guava IO库在不同场景下的应用

由于Guava IO库提供的接口简单、功能强大,因此适用于各种文本处理场景:

- **日志分析:** 对日志文件进行读取和分析时,可以使用Guava IO库来处理各种字符集的文件。

- **配置文件管理:** 在需要动态加载和更新配置文件的场景中,Guava IO库能够简化编码处理和文件操作。

- **多语言文本处理:** 在支持多语言的软件系统中,Guava IO库能够帮助开发者实现国际化和本地化处理。

## 2.6 Guava IO库的未来展望

随着Java生态系统的持续发展,Guava IO库也在不断演进。它将继续增强其功能,包括但不限于提供对新兴编码格式的支持,提升流式处理的效率和稳定性,以及增强与其他现代Java库(如Spring、Apache Commons IO等)的兼容性和集成性。此外,社区反馈和需求也将引导Guava IO库未来的发展方向。

Guava IO库的未来版本将可能引入更多的API改进和性能优化,以适应不断增长和变化的开发者需求。对于文本处理领域来说,Guava IO库将继续扮演重要角色,为开发者提供一个强大而可靠的文本处理工具箱。

通过本章节的介绍,我们可以看到Guava IO库在文本处理方面相比于传统Java IO的优势,以及其在未来可能的发展方向。下一章将深入探讨Guava IO库中字符集与编码的实践细节。

# 3. Guava IO库中的字符集与编码实践

## 3.1 字符集的识别与转换

### 3.1.1 字符集的基本概念

字符集是一套符号和编码的对应关系。在计算机中,字符集用于指定字符与数字代码的映射关系,从而实现文本的数字化存储和处理。常见的字符集包括ASCII、Unicode和UTF-8等。每种字符集都有其特定的用途和优缺点。例如,ASCII字符集是最早的字符集标准,能够表示128个字符,而Unicode旨在表示世界上所有字符,它使用多个字节表示一个字符。

字符编码是字符集的具体实现,将字符映射到字节的过程。不同的编码可能对同一个字符集有不同的字节序列表示。例如,UTF-8是一种变长编码方式,它可以使用1到4个字节表示一个字符,而UTF-16则使用2个或4个字节。

### 3.1.2 Guava中字符集转换的实现

Guava IO库提供了对字符集编码和解码的支持,使得字符集之间的转换变得简单。在Guava中,通过`Charsets`类可以获取到Java平台支持的字符集实例,进而实现编码和解码的操作。

下面是一个使用Guava进行字符集转换的示例代码:

```***

***mon.base.Charsets;

public class CharsetConversionExample {

public static void main(String[] args) throws Exception {

String originalText = "你好,世界!";

// 使用UTF-8编码将字符串转换为字节序列

byte[] utf8Bytes = originalText.getBytes(Charsets.UTF_8);

System.out.println("UTF-8编码的字节序列: " + Arrays.toString(utf8Bytes));

// 使用ISO-8859-1编码将字符串转换为字节序列

byte[] isoBytes = originalText.getBytes(Charsets.ISO_8859_1);

System.out.println("ISO-8859-1编码的字节序列: " + Arrays.toString(isoBytes));

// 将UTF-8编码的字节序列转换回字符串

String decodedTextUtf8 = new String(utf8Bytes, Charsets.UTF_8);

System.out.println("解码回字符串: " + decodedTextUtf8);

// 将ISO-8859-1编码的字节序列转换回字符串

String decodedTextIso = new String(isoBytes, Charsets.ISO_8859_1);

System.out.println("解码回字符串: " + decodedTextIso);

}

}

```

上面的代码演示了如何使用Guava的`Charsets`类获取特定字符集实例,并进行字符串与字节序列之间的转换。我们分别以UTF-8和ISO-8859-1两种字符集编码和解码字符串“你好,世界!”,然后输出了编码后的字节序列和解码后的字符串。

在使用Guava进行字符集转换时,要注意源字符集和目标字符集必须匹配,否则解码时可能会出现乱码或者`CharacterCodingException`异常。此外,对于需要国际化支持的项目,推荐使用UTF-8字符集,因为它能够无损地表示任何字符。

## 3.2 文件编码的检测与处理

### 3.2.1 如何检测文件编码

文件编码的检测是一个常见的需求,特别是在处理来自不同来源的文本文件时。文件编码检测可以帮助我们正确解读文件中的内容,避免乱码的问题。Guava IO库并没有直接提供文件编码检测的API,但是我们可以结合其他工具如Apache Commons IO或者Tika来实现这一功能。

通常,文件编码检测的过程分为以下几个步骤:

1. 读取文件的字节。

2. 分析字节序列,寻找特定的编码标识。

3. 确定文件的编码。

这里以Apache Commons IO库的`FileEncodingDetector`类为例,展示如何使用它来检测文件编码:

```***

***mons.io.input.BOMInputStream;

import java.io.BufferedInputStream;

import java.io.FileInputStream;

import java.io.IOException;

public class FileEncodingDetection {

public static void main(String[] args) throws IOException {

String filePath = "path/to/your/file.txt";

try (FileInputStream fileInputStream = new FileInputStream(filePath);

BufferedInputStream bufferedInputStream = new BufferedInputStream(fileInputStream);

BOMInputStream bomInputStream = new BOMInputStream(bufferedInputStream)) {

String fileEncoding = bomInputStream.getBOMDataCharsetName();

if (fileEncoding != null) {

System.out.println("文件编码: " + fileEncoding);

} else {

fileEncoding = bomInputStream.getEncoding();

if (fileEncoding != null) {

System.out.println("文件编码: " + fileEncoding);

} else {

System.out.println("无法检测到文件编码,可能使用默认编码。");

}

}

}

}

}

```

上面的代码首先使用`FileInputStream`来读取文件,然后通过`BOMInputStream`来检测文件的编码。`BOMInputStream`会检查文件是否有字节顺序标记(BOM),并返回对应的编码名称。如果没有BOM,它会尝试返回文件内容的实际编码。

需要注意的是,文件编码检测并非百分之百准确,尤其是在文件内容不足以进行可靠推测的情况下。因此,正确地记录和管理文件编码信息仍然是处理文件时的最佳实践。

### 3.2.2 文件编码自动适应与转换

文件编码的自动适应是指程序在处理文件时能够自动识别文件的编码,并使用正确的编码进行读取。而文件编码转换则是指将文件从一种编码格式转换为另一种编码格式。

在Java中,我们可以使用`InputStreamReader`和`OutputStreamWriter`来实现文件编码的自动适应和转换。这两个类都允许我们指定编码,并通过它们来读取或写入数据。下面是一个将文件从一种编码转换为另一种编码的示例:

```java

import java.io.*;

public class FileEncodingConversion {

public static void main(String[] args) throws IOException {

String inputPath = "path/to/input/file.txt";

String outputPath = "path/to/output/file.txt";

// 假设我们知道输入文件的编码是GBK,而我们希望将其转换为UTF-8

String inputEncoding = "GBK";

String outputEncoding = "UTF-8";

try (

```

0

0