Rmpi实战:构建机器学习算法的并行版本(机器学习加速器)

发布时间: 2024-11-11 00:40:47 阅读量: 21 订阅数: 35

RPMI_StopMotion_GRA:RMPI中的定格动作。 格鲁波A

# 1. Rmpi简介与并行计算基础

在现代数据科学的舞台上,大规模数据处理的需求正日益增加,传统的单机计算方式已无法满足处理速度和资源消耗的要求。并行计算作为一种高效的计算方式,旨在通过多个计算单元共同工作,提升数据处理和分析的速度,降低处理时间。

## 1.1 并行计算概述

### 1.1.1 并行计算的历史与发展

并行计算的概念可追溯到20世纪60年代,当时的高性能计算主要用于军事和科研领域。随着微处理器技术的飞速发展,个人计算机性能逐渐提升,使得并行计算开始走进商业与民用领域。进入21世纪,多核处理器和云计算技术的普及,让并行计算成为解决大数据问题的主流方法。

### 1.1.2 并行计算的优势与挑战

并行计算的优势在于其几乎线性的处理速度提升潜力,特别适合于需要大量重复计算的任务。然而,它也面临诸如数据通信开销大、编程复杂度高、任务调度困难等挑战。特别是在跨多个节点进行大规模数据集处理时,如何有效地管理资源并减少延迟,是并行计算需要解决的关键问题。

## 1.2 Rmpi的角色与优势

### 1.2.1 Rmpi的定义与特性

Rmpi是一个基于消息传递接口(Message Passing Interface, MPI)的R语言并行计算包,它为R语言提供了强大的并行处理能力。Rmpi利用MPI标准,允许用户在多台计算机上分散运行R程序,实现复杂算法的并行处理。Rmpi的关键特性包括跨平台兼容性好、易于学习使用,以及丰富的接口支持。

### 1.2.2 Rmpi与其它并行工具的对比

与其它并行计算工具相比,Rmpi的优势在于其与R语言的无缝集成,使得统计分析和机器学习领域的研究者可以轻松地将他们的模型转换为并行版本。例如,对比于Hadoop和Spark等大数据框架,Rmpi更专注于统计计算和机器学习的并行化;而与其它并行R包如`parallel`相比,Rmpi提供了更底层的控制,适合进行更复杂的并行任务设计。

## 1.3 Rmpi的工作原理

### 1.3.1 Rmpi的消息传递接口

Rmpi通过消息传递接口,允许不同计算节点间的数据交换。消息传递是并行计算中的基本概念,Rmpi提供了发送、接收消息的标准函数。这些函数使用户能够控制数据的流动,从而协调多个节点间的工作。

### 1.3.2 Rmpi的工作流程

Rmpi的工作流程通常从启动多个R进程开始,然后通过定义的主从架构进行任务分配。主进程负责任务的组织和调度,从进程则执行实际的计算任务。通信函数如`mpi.send`和`mpi.recv`被用来在进程间交换信息,最终主进程会收集所有从进程的结果,完成并行计算。

在接下来的章节中,我们将详细介绍Rmpi的安装、配置以及如何通过Rmpi实现基础并行应用,并逐步深入了解并行化机器学习算法的理论和实践应用。

# 2. Rmpi环境搭建与基础应用

## 2.1 Rmpi安装与配置

### 2.1.1 Rmpi安装要求

在使用Rmpi之前,我们必须确保我们的系统满足安装Rmpi的基本要求。Rmpi依赖于MPI(消息传递接口)的实现,因此需要在系统中安装一个兼容的MPI库。常见的MPI库有OpenMPI, MPICH, Mvapich等。此外,Rmpi还依赖于R语言的运行环境。因此,安装Rmpi需要在已安装R语言及其开发环境(通常为Rcpp包)的机器上进行。

系统要求:

- Linux操作系统

- 已安装C/C++编译器(如gcc, g++)

- 支持MPI库(推荐OpenMPI)

- 安装有R语言及其开发包(如Rcpp)

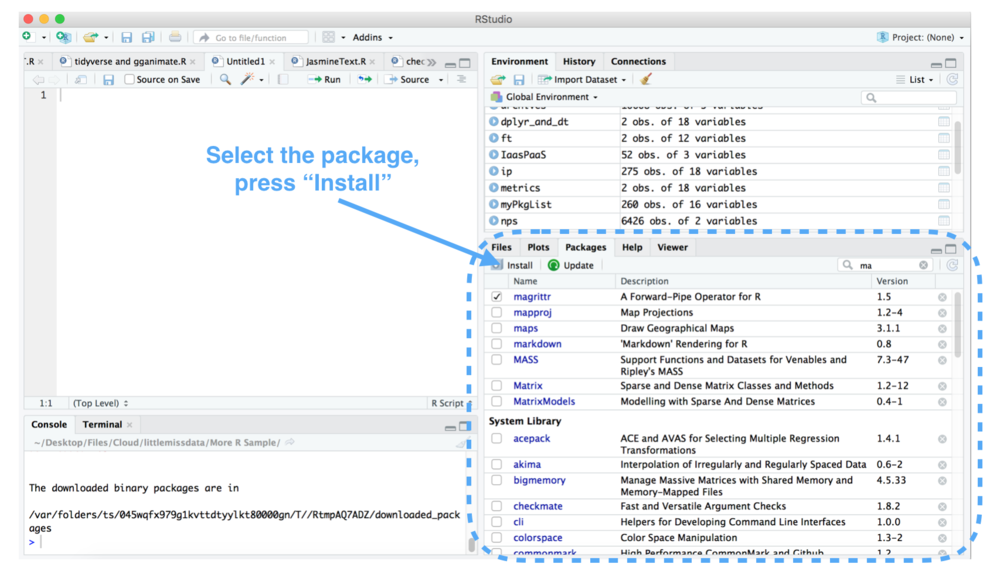

### 2.1.2 Rmpi的安装过程

安装Rmpi通常可以通过R语言的包管理器完成。以下是详细的步骤:

1. 在终端中安装MPI库(以OpenMPI为例):

```sh

sudo apt-get install libopenmpi-dev

```

2. 启动R语言环境:

```sh

R

```

3. 在R控制台安装Rmpi包:

```R

install.packages("Rmpi", repos = "***")

```

4. 载入Rmpi包以确认安装成功:

```R

library(Rmpi)

```

注意:在安装Rmpi时,确保系统中安装的MPI库与Rmpi兼容,否则可能会出现错误。

## 2.2 Rmpi的基础编程

### 2.2.1 Rmpi的基本函数与命令

Rmpi提供了丰富的函数和命令来支持并行计算。以下是一些基础的函数:

- `mpi_initialize()`:初始化MPI环境。

- `mpi_finalize()`:结束MPI环境。

- `mpi_comm_size()`:获取并行任务的数量。

- `mpi_comm_rank()`:获取当前任务的ID。

- `mpi_send()`:发送数据到其他任务。

- `mpi_recv()`:从其他任务接收数据。

- `mpi_bcast()`:广播数据到所有任务。

这些函数是构建并行程序的基础,需要熟练掌握。

### 2.2.2 简单的数据并行示例

这里我们将给出一个简单的并行计算示例,演示如何使用Rmpi进行基础的并行计算。以下是将一组数值并行求和的R代码:

```R

library(Rmpi)

# 初始化MPI环境

mpi_initialize()

# 获取并行任务数

num процесов <***m.size(MPI_COMM_WORLD)

# 获取当前任务ID

my_id <***m.rank(MPI_COMM_WORLD)

# 并行任务分配与执行

if (my_id == 0) {

# 主进程分配任务

nums <- split(1:100, ceiling(seq(1, 100)/10))

for (i in 1:num процесов) {

mpi.send(nums[[i]], dest=i, tag=1)

}

} else {

# 工作进程接收数据并计算

data <- mpi.recv(source=0, tag=1)

sum_data <- sum(data)

# 发送计算结果回主进程

mpi.send(sum_data, dest=0, tag=2)

}

# 接收各工作进程返回的结果

if (my_id == 0) {

results <- numeric(num процесов)

for (i in 1:num процесов) {

results[i] <- mpi.recv(source=i, tag=2)

}

print(paste("The sum is", sum(results)))

}

# 结束MPI环境

mpi_finalize()

```

## 2.3 Rmpi的集群设置

### 2.3.1 集群环境的配置

在搭建Rmpi集群环境时,我们需要对多个计算节点进行配置,使得它们能够协同工作。集群通常由一个主节点和多个工作节点组成。每个节点都需要安装MPI库和Rmpi包。

配置过程如下:

1. 在所有节点上安装MPI库。

2. 在所有节点上安装R语言环境及其开发包。

3. 在每个节点上安装Rmpi包。

4. 配置SSH无密码登录,以便主节点可以远程控制工作节点。

5. 创建启动并行计算的脚本,并在主节点上运行。

### 2.3.2 Rmpi集群的运行与监控

在集群上运行Rmpi程序需要主节点向工作节点发送指令,并监控整个计算过程。使用`mpiexec`或`mpirun`命令可以启动集群上的Rmpi程序。

监控集群的运行状态可以通过以下方式:

- 利用`mpiexec`或`mpirun`的参数来获取并行任务的状态。

- 在每个工作节点上运行日志记录程序。

- 使用系统的监控工具,如htop或nmon来查看CPU和内存使用情况。

下面是一个使用`mpiexec`命令启动Rmpi程序的基本示例:

```sh

mpiexec -n <num процесов> -hostfile <hostfile> Rscript --vanilla my_rmpi_script.R

```

其中`<num процесов>`是要启动的任务数,`<hostfile>`是包含集群节点信息的主机文件。

在实际使用中,设置集群环境和运行并行程序是比较复杂的过程,需要根据具体的网络配置和计算需求进行调整。

# 3. 并行化机器

0

0