编译原理与实践:词法分析器构建与目标代码优化技术(第三版)

发布时间: 2024-12-17 12:00:55 阅读量: 3 订阅数: 3

编译原理实验(一)——词法分析器的设计(C语言版).zip

参考资源链接:[编译原理第三版课后习题解析:词法分析与语法推导](https://wenku.csdn.net/doc/6412b6ebbe7fbd1778d48736?spm=1055.2635.3001.10343)

# 1. 编译原理概述与词法分析的重要性

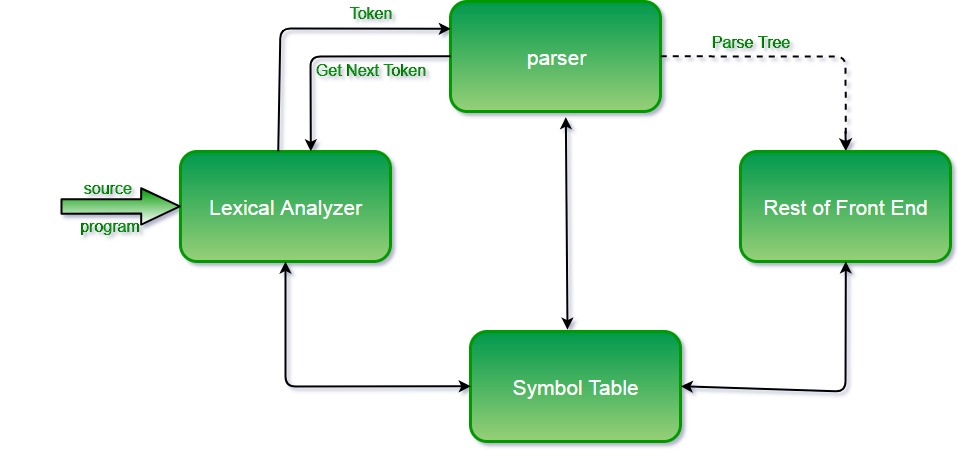

编译是计算机科学的核心部分,它将人类可读的源代码转换成机器代码。编译过程涉及几个阶段,包括词法分析、语法分析、语义分析、中间代码生成、代码优化和目标代码生成。每个阶段都必不可少,但词法分析作为第一阶段,承担了将原始代码文本分解成一个个有意义的单位(词法单元)的任务,为后续分析奠定基础。词法分析的重要性不仅体现在为编译流程提供准确的输入,还在于它能有效地检测和报告源代码中的错误。

在深入词法分析的理论基础之前,理解编译原理的基本概念对于任何一个希望深化其在计算机科学领域理解的人来说都是至关重要的。词法分析器(也被称为扫描器或 lexer)的作用是将源代码字符串转换成一系列的记号(tokens),记号是编译器后续处理的基本单位,比如关键字、标识符、常量和操作符等。

本章节将概述编译原理的各个阶段,并详细探讨词法分析在编译过程中的作用和重要性,为理解后续的编译流程打下坚实的基础。

# 2. 词法分析器的理论基础

## 2.1 编译过程中的词法分析阶段

### 2.1.1 词法分析的角色和任务

词法分析是编译过程中的第一阶段,它负责读取源程序的字符序列,然后将它们组织成有意义的词素(tokens),也就是程序的基本单位。这个词法单元是语法分析阶段的输入。为了完成这一角色,词法分析器必须执行以下任务:

1. **扫描(Scanning)**:从源代码文本中读取输入,并将其拆分为一系列字符。

2. **分类(Classification)**:识别这些字符是标识符、关键字、数字常量、字符串、操作符还是其他符号。

3. **词法单元生成(Token Generation)**:基于这些分类,生成词法单元,每个单元都包含类型和值。

为了实现这些任务,词法分析器必须能够处理各种边缘情况,如注释、空白字符、预处理指令等。理解词法分析器的角色和任务,对于编译器的高效工作至关重要。

### 2.1.2 词法单元和词法结构的定义

在深入理解词法分析器的作用后,我们需要定义一些核心概念:

- **词素(Lexeme)**:源代码中的字符序列,这个词素与某个词法单元类型相关联。

- **词法单元(Token)**:一个词素加上其词法类型,例如,一个标识符可能表示为("Identifier", "user_data")。

- **词法类型(Token Type)**:如关键字、标识符、数字、字符串、运算符等,是编译器后续阶段使用的抽象表示。

这些定义有助于我们理解编译器如何组织和处理源代码。词法分析器通过这些定义,能够正确地将源代码转换成编译器能够进一步处理的结构。

## 2.2 正则表达式和有限自动机

### 2.2.1 正则表达式在词法分析中的应用

正则表达式是描述字符序列模式的一种强大的工具,它在词法分析中扮演着重要的角色。通过正则表达式,开发者可以精确地定义各种词法单元的模式,例如:

- 标识符:`[a-zA-Z_][a-zA-Z_0-9]*`

- 整数:`[0-9]+`

- 单行注释:`//.*`

正则表达式不仅简化了模式的定义,而且可以被自动转换成词法分析器,大大减少了手工编写解析代码的需要。

### 2.2.2 构建确定有限自动机(DFA)和非确定有限自动机(NFA)

有限自动机(FA)是描述词法单元模式匹配的数学模型,主要分为确定有限自动机(DFA)和非确定有限自动机(NFA)。构建FA的步骤包括:

1. **构建NFA**:根据正则表达式,构建一个NFA。每个正则表达式的操作(如连接、选择、闭包)都可以对应到NFA的构造规则。

2. **转换为DFA**:将NFA转换为DFA。这一过程称为子集构造法,它通过合并NFA中等价的状态来最小化DFA。

3. **最小化DFA**:优化DFA以减少状态数量,提高效率。

在本章节中,我们通过表格和流程图深入探讨这些构建FA的过程。

#### 表格:正则表达式、NFA、DFA之间的映射关系

| 正则表达式成分 | NFA构造 | DFA构造 |

|----------------|----------|----------|

| 字符a | 从开始状态到一个新状态的转移,标记为a | 对应NFA状态的合并和转换标记为a |

| 选择(|) | 新的开始状态,两条到原始开始状态和结束状态的路径 | 在DFA中,新的状态包括所有原始NFA在选择路径中的状态 |

| 闭包(*) | 开始和结束状态重叠,闭包转移回开始状态 | 在DFA中,创建新状态来表示所有闭包可能的状态 |

接下来,我们将展示一个正则表达式到DFA转换的mermaid流程图。

```mermaid

flowchart LR

regex((正则表达式)) --> nfa((NFA))

nfa --> dfa((DFA))

dfa --> min_dfa((最小化DFA))

```

## 2.3 词法分析器的生成工具

### 2.3.1 Lex/Flex工具的原理和使用

Lex和Flex是流行的词法分析器生成工具,它们使用正则表达式来定义词法模式。Flex是Lex的一个扩展,其使用C语言接口,被广泛应用于Unix和Unix-like系统。

Flex的使用步骤如下:

1. **定义词法规则**:编写规则,每条规则包括一个正则表达式和当匹配该模式时要执行的C代码。

2. **编译**:使用Flex工具将定义文件(通常是`.l`或`.lex`文件)编译成C源文件。

3. **链接**:将生成的C源文件编译成可执行的词法分析器。

Flex的输入文件结构如下:

```lex

%{

// C语言代码,包括头文件和函数声明等

%}

%% /* 定义词法规则 */

标识符 [a-zA-Z_][a-zA-Z_0-9]* { /* C代码,处理标识符 */ }

数字 [0-9]+ { /* C代码,处理数字 */ }

// C语言代码,包括main函数

```

### 2.3.2 从正则表达式到词法分析器的转换

Flex根据输入文件中的规则,通过内置的解析引擎将正则表达式转换成NFA,然后将NFA转换成DFA。这个DFA被用来实际的词法分析过程,使得每读入一个字符,就沿着DFA的状态转移,直到识别出完整的词法单元。

为了更好地理解这一过程,我们通过一个简单的代码块展示如何将一个正则表达式转换为Flex词法单元。

```c

// 一个简单的Flex规则示例

%%

[0-9]+ { printf("数字: %s\n", yytext); }

[a-zA-Z_][a-zA-Z_0-9]* { printf("标识符: %s\n", yytext); }

```

Flex的源码文件是编译器前端开发中的一个重要组成部分,它极大地简化了词法分析器的构建过程。在本章节,我们讨论了理论基础,并展示了使用Lex/Flex工具构建词法分析器的具体实例。在下一章中,我们将深入实际构建一个词法分析器,了解如何设计和实现它。

# 3. 词法分析器的构建实践

词法分析器是编译器前端的重要组成部分,它将源代码文本转换为标记流,为后续的语法分析阶段打下基础。构建一个有效的词法分析器不仅要求深入理解编译原理,还要求对工具和技术有实际的操作能力。在本章中,我们将详细介绍构建词法分析器的实践过程,包括设计和实现词法分析器、处理复杂词法单元和特殊情况,以及性能优化方法。

## 3.1 设计和实现词法分析器

设计和实现一个词法分析器首先需要清晰地识别和分类词法单元,然后基于此构建出词法分析器的框架代码。

### 3.1.1 识别和分类词法单元

词法单元(Token)是编译过程中最小的语法单位,

0

0