【Go语言性能提升全攻略】:一文精通pprof工具的全方位应用

发布时间: 2024-10-20 05:26:59 阅读量: 25 订阅数: 31

# 1. Go语言性能优化概述

## 1.1 为什么需要性能优化

在软件开发领域,性能优化始终是一个核心议题。随着应用规模的不断扩大和用户需求的日益增长,开发者必须确保系统运行平稳、响应迅速。对于使用Go语言构建的应用而言,性能优化尤为重要。由于Go语言在并发处理和资源管理方面的独特优势,优化可以显著提高程序效率和运行速度,减少硬件成本和运行时间。

## 1.2 Go语言性能优化的挑战

Go语言虽然提供了强大的并发机制和垃圾回收机制,但依然面临着资源竞争、内存泄漏、CPU瓶颈等性能挑战。优化工作不仅仅是提升单一指标,更是涉及到代码质量、系统架构、以及整体用户体验的提升。因此,性能优化是一个复杂而深入的过程,需要开发者具备细致的观察力和扎实的分析能力。

## 1.3 优化流程的三个阶段

一个完整的性能优化流程通常包括三个阶段:性能评估、瓶颈定位、和优化实施。首先,通过性能测试评估应用当前的性能状况;其次,运用各种分析工具如pprof来定位性能瓶颈;最后,基于分析结果实施针对性的优化措施。整个过程是一个反复迭代、持续改进的过程。在后续章节中,我们将详细介绍pprof工具及其在Go语言性能优化中的关键作用。

# 2. pprof工具基础

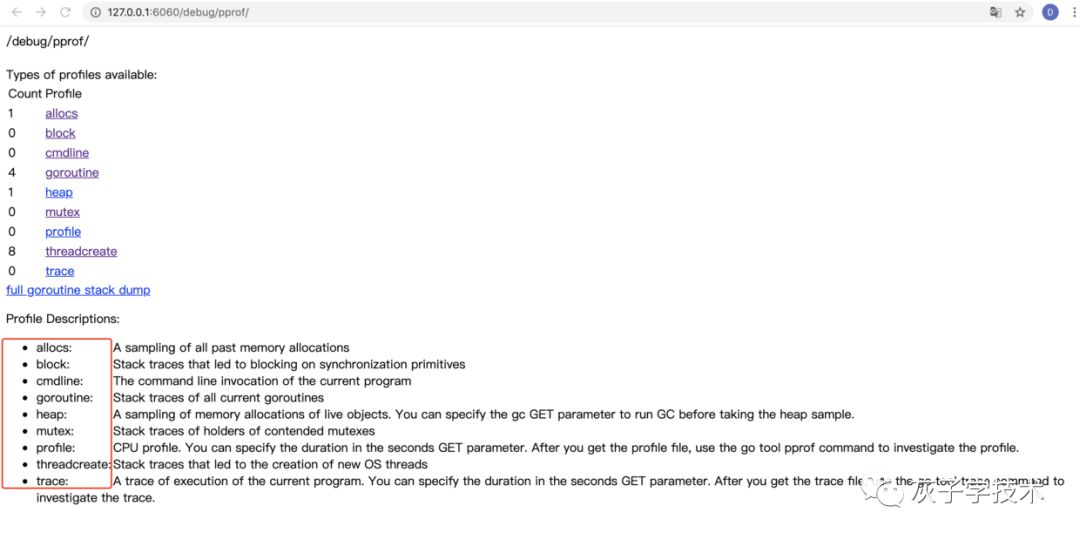

在现代软件开发中,性能优化是提升用户体验和系统稳定性的重要手段。Go语言作为一门高性能的编程语言,其性能优化不仅依赖于代码质量和算法选择,还需要使用专业的性能分析工具来进行深入的性能诊断和调优。pprof是Go语言中一个集成的性能分析工具,能够帮助开发者收集和分析程序的运行时数据。本章将详细介绍pprof工具的基础知识,包括其作用、如何安装、基本使用方法、数据类型解析以及如何将其集成到程序中。

## 2.1 pprof工具简介

### 2.1.1 pprof在Go性能优化中的作用

pprof作为一个性能分析工具,它能够深入到程序运行的各个层面,提供CPU、内存、阻塞和互斥锁等方面的详细性能数据。这些数据可以帮助开发者了解程序的瓶颈,找到优化点,从而对程序进行有针对性的调优。

性能优化的目标通常包括提高CPU利用率、降低内存消耗、优化同步机制等。在Go语言中,pprof能够有效地帮助开发者实现这些目标。例如,pprof能够展示哪些函数消耗了最多的CPU时间,哪些对象分配了最多的内存,哪些互斥锁操作导致了程序的阻塞。了解这些信息后,开发者可以针对性地进行代码优化,提高程序的整体性能。

### 2.1.2 pprof工具的安装与基本使用

要使用pprof,首先需要在Go项目中进行安装。可以通过以下命令安装pprof相关的库:

```**

***/google/pprof

```

安装完成后,在Go程序中引入pprof包,并在需要收集性能数据的地方开启pprof的HTTP服务器。例如:

```go

import _ "net/http/pprof"

go func() {

log.Println(http.ListenAndServe("localhost:6060", nil))

}()

```

上述代码会在本地6060端口启动pprof的HTTP服务。开发者可以使用浏览器或者命令行工具如`curl`来访问pprof提供的数据。使用`go tool pprof`命令行工具可以分析pprof收集到的性能数据,例如:

```sh

go tool pprof ***

```

这将启动一个交互式界面,允许用户分析CPU或者内存的性能瓶颈。

## 2.2 pprof数据类型解读

pprof工具提供了不同类型的性能分析数据,包括CPU Profile、Memory Profile、Block Profile和Mutex Profile。每种类型的数据都有其独特的应用场景和分析方法。

### 2.2.1 CPU Profile数据解析

CPU Profile用于收集程序运行时CPU的使用情况,它通过定期采样堆栈信息来分析哪些函数占用了CPU资源。开发者可以通过CPU Profile数据来识别哪些函数在运行过程中消耗了最多的CPU时间,进而对这些热点函数进行优化。

使用pprof获取CPU Profile数据的典型命令如下:

```sh

go tool pprof ***

```

该命令运行后,pprof会进行一段时间的采样(默认30秒),然后生成一个分析报告。报告中会列出采样期间消耗CPU时间最多的函数列表,以及它们的调用关系。

### 2.2.2 Memory Profile数据解析

Memory Profile用于收集程序在内存分配方面的情况,它能够展示各个函数或方法中创建的对象数量和内存消耗情况。通过分析Memory Profile数据,开发者可以发现内存泄漏和过度分配等问题,对程序进行内存管理优化。

获取Memory Profile数据的命令和CPU Profile类似,只是访问的端点不同:

```sh

go tool pprof ***

```

通过分析结果,开发者可以了解内存分配的热点位置,识别出哪些代码段导致了大量的内存分配,进而进行针对性的优化。

### 2.2.3 Block Profile与Mutex Profile数据解析

Block Profile和Mutex Profile专门用于分析程序中同步机制的性能问题。Block Profile可以检测程序中的goroutine阻塞情况,如由于互斥锁导致的goroutine等待。Mutex Profile则专注于分析互斥锁的使用情况,包括锁定和解锁的操作。

获取Block Profile数据的命令如下:

```sh

go tool pprof ***

```

获取Mutex Profile数据的命令如下:

```sh

go tool pprof ***

```

分析Block Profile和Mutex Profile数据,开发者可以发现由于锁竞争或死锁导致的性能问题,并采取措施进行改进。

## 2.3 pprof工具的集成与配置

为了使pprof能够有效地帮助开发者进行性能优化,必须正确地将pprof集成到Go程序中,并对其访问权限和路由进行合理配置。

### 2.3.1 在程序中集成pprof

在Go程序中集成pprof通常涉及引入pprof包和开启HTTP服务。具体来说,可以在程序初始化时添加HTTP路由和监听端口,以便在需要时收集性能数据。例如:

```go

import _ "net/http/pprof"

func main() {

// 其他初始化代码

go func() {

log.Println(http.ListenAndServe("localhost:6060", nil))

}()

}

```

上述代码会在程序启动时开启一个HTTP服务,监听本地的6060端口,并通过HTTP提供pprof的性能分析数据。

### 2.3.2 配置pprof访问权限和路由

为了保证pprof工具的安全使用,需要对其进行访问权限的配置。一个常见的做法是将pprof服务绑定到localhost地址,这样只有在本机上运行的工具或者有权访问本机的服务才能访问pprof数据:

```go

log.Println(http.ListenAndServe("localhost:6060", nil))

```

此外,也可以使用防火墙规则或者网络认证机制来限制pprof服务的访问权限。

在生产环境中,通常不建议长期暴露pprof服务,因为这可能会带来安全风险。因此,一个更好的做法是在需要分析性能时手动开启pprof服务,在分析完成后关闭服务。

至此,我们已经对pprof工具的基础知识有了初步了解,包括它的作用、安装和基本使用方法,以及数据类型的解读。在下一章中,我们将深入探讨如何应用pprof进行实际的性能分析和优化。

# 3. pprof实践应用分析

## 3.1 CPU瓶颈诊断与优化

### 3.1.1 定位CPU密集型函数

在进行性能优化时,识别出程序中CPU密集型函数是至关重要的一步。这些函数通常占据了执行时间的大部分,而改善这些部分的性能可以显著地提升整个应用的运行效率。

在Go中,我们可以使用pprof工具来定位CPU密集型函数。首先,通过在代码中引入pprof相关的包,并在需要分析的函数中添加相应的代码来启动pprof的CPU分析功能。

```go

import (

"net/http"

_ "net/http/pprof"

)

func main() {

go func() {

log.Println(http.ListenAndServe("localhost:6060", nil))

}()

// Your application's startup logic here...

}

```

这段代码会在本地的6060端口开启pprof的HTTP接口,然后使用`go tool pprof`命令行工具来访问和分析CPU的使用情况。

接下来,我们可以运行程序并等待一段时间以收集足够的性能数据。然后执行以下命令开始分析:

```

go tool pprof ***

```

该命令会从pprof HTTP接口获取30秒的CPU使用数据。在分析界面,我们可以输入`top`命令来查看消耗CPU最多的函数。

### 3.1.2 分析热点调用图和火焰图

通过pprof,我们不仅可以知道哪些函数消耗了最多的CPU资源,还可以查看这些函数之间的调用关系,这就是热点调用图(Call Graph)。它帮助我们了解程序的执行流以及在何处进行优化会更加有效。

我们还可以使用火焰图(Flame Graph)来可视化地展示程序的性能特征。火焰图可以直观地显示出CPU使用热点,帮助开发者理解程序运行时的性能瓶颈。

使用火焰图需要额外的工具,例如`go-torch`或`brendangregg/FlameGraph`。通过这些工具,我们可以将pprof收集到的性能数据转换成火焰图的形式。安装这些工具后,执行类似下面的命令生成火焰图:

```

go-torch -u ***

```

执行完毕后,会在当前目录下生成一个名为`torch.svg`的文件,通过浏览器打开后即可查看火焰图。

## 3.2 内存泄漏检测与优化

### 3.2.1 识别内存分配热点

内存泄漏是影响程序性能和稳定性的重要因素之一。在Go中,内存泄漏通常是由于程序中的对象没有被及时回收造成的。pprof提供的内存分析功能可以帮助我们识别内存分配的热点,从而发现潜在的内存泄漏问题。

要开始分析内存使用情况,我们可以使用以下命令收集内存分配数据:

```

go tool pprof ***

```

这个命令会启动pprof分析器,并在命令行中展示内存分配信息。使用`top`命令可以显示消耗内存最多的函数或方法。

### 3.2.2 分析内存分配和回收行为

在识别出内存分配的热点之后,进一步分析这些函数的内存分配和回收行为是非常必要的。借助pprof的内存分配分析,我们可以更细致地了解内存使用模式。

例如,我们可以使用`list`命令来查看特定函数的源代码和对应的内存分配行为:

```

list YOUR_HIGH_ALLOC_FUNCTION

```

此外,pprof还支持生成内存使用的历史数据,这对于分析内存泄漏的长期趋势非常有帮助。我们可以通过指定时间间隔多次运行内存分析,然后比较不同时间点的数据,来观察内存使用的模式是否有所改变。

## 3.3 同步问题诊断与优化

### 3.3.1 检测死锁和锁竞争

同步问题,如死锁和锁竞争,通常会导致程序性能下降。pprof通过分析运行中的goroutine状态,可以帮助我们检测出程序中存在的死锁和锁竞争问题。

要分析同步问题,可以使用以下命令进行goroutine阻塞分析:

```

go tool pprof ***

```

这个命令会提供阻塞goroutine的信息,其中`goroutine`命令可以列出所有被阻塞的goroutine的堆栈跟踪。

通过分析输出,我们可以定位到引起死锁的代码行,从而找出问题所在,并进行相应的优化。

### 3.3.2 优化同步机制和访问控制

除了诊断,pprof同样可以辅助我们优化同步机制和访问控制。通常,优化涉及减少锁的粒度、使用原子操作、避免不必要的goroutine创建等策略。

通过pprof的数据,我们可以验证优化措施是否有效。我们可以再次收集性能数据,并通过pprof比较优化前后的差异。如果优化措施得当,应该会看到锁竞争的减少和程序性能的提升。

例如,如果发现某个资源竞争激烈,我们可能需要引入更细粒度的锁来降低竞争。pprof可以帮助我们验证这种改变是否真的带来了性能上的改进。

以上章节深入探讨了使用pprof工具在实践中对Go语言程序进行性能瓶颈诊断和优化的方法。通过具体的代码示例和分析命令,我们能够具体到每一步地进行问题定位和性能改进。这些内容对于有经验的IT从业者来说,不仅提供了实用的工具使用方法,还深化了对Go语言性能优化过程的理解。

# 4. pprof进阶技巧

## 4.1 pprof的程序分析模式

### 4.1.1 选择合适的采样频率

在使用pprof进行性能分析时,选择正确的采样频率是非常关键的。采样频率决定了在分析期间每秒对多少个样本进行采样,影响数据的准确性和分析的粒度。

采样频率通常以Hz(赫兹)为单位,表示每秒钟采集样本的次数。对于CPU Profile,由于CPU的执行速度非常快,一般建议使用100Hz以上的频率,以便捕捉足够多的样本信息。对于Memory Profile,因为内存分配的频率通常低于CPU指令的执行速度,所以可以使用更低的频率,如50Hz或更低。

在命令行中,可以使用`-cpuprofile`和`-memprofile`标志来指定采样频率。例如,使用`go tool pprof -cpuprofile freq=100Hz cpu.pprof`可以设置CPU Profile的采样频率为100Hz。

### 4.1.2 多层级采样与性能对比

多层级采样是一个高级技巧,它允许我们从不同层面深入分析程序的性能。这种方法可以同时从宏观和微观层面理解程序性能,帮助发现那些不容易被单一层级分析所揭露的深层次问题。

在进行多层级采样时,首先可以在较高层级(如方法)上进行粗略的采样,确定性能瓶颈的大致范围。然后在具体的功能或代码段进行更细粒度的采样。这种方法可以避免过早地深入细节,而忽略了更大的性能问题。

对比不同时间点或不同运行条件下的性能分析结果,可以发现性能的变化趋势和可能的性能回归。这种对比分析可以在持续集成(CI)流程中自动化,以便及时捕捉到性能退化。

## 4.2 pprof在生产环境中的应用

### 4.2.1 在线分析的挑战与解决方案

在生产环境中直接运行pprof进行性能分析通常会遇到一些挑战。首先,生产环境上的性能分析可能会对服务的性能和可用性造成影响,需要谨慎处理。其次,生产环境上的数据敏感性要求性能分析工具必须安全可靠。

为了解决这些挑战,我们可以采取以下策略:

1. 使用条件采样技术,只在满足特定条件时开启性能分析,比如只在CPU使用率超过阈值时进行。

2. 限制采样时间和采样深度,避免长时间占用大量资源。

3. 使用pprof的远程分析能力,通过HTTP将分析数据传输到开发或测试环境进行分析。

### 4.2.2 结合监控系统进行持续性能优化

将pprof集成到现有的监控系统中,可以实现对应用程序的持续性能优化。许多监控系统,如Prometheus、Grafana等,提供了数据收集和可视化的能力,而pprof可以为这些系统提供深入的性能数据。

一个典型的集成流程可以包括:

1. 在程序中启用pprof的HTTP接口。

2. 使用监控系统定期从pprof HTTP接口抓取性能数据。

3. 对抓取的数据进行分析和可视化,帮助理解性能趋势。

4. 根据分析结果采取优化措施。

这种集成方式不仅可以帮助实时监控性能状况,还可以为后续的性能问题调查提供历史数据支持。

## 4.3 从pprof到性能优化的实战案例

### 4.3.1 实际案例分析:性能优化过程

在这个案例中,我们假设要优化一个Web服务的响应时间。首先,我们使用pprof的CPU Profile功能来分析程序的CPU使用情况。

```go

import _ "net/http/pprof"

go func() {

log.Println(http.ListenAndServe("localhost:6060", nil))

}()

```

然后,在程序运行时,通过访问`***`来启动30秒的CPU性能分析。分析完成后,使用`go tool pprof`命令来查看和分析生成的pprof文件。

```bash

go tool pprof ***

```

通过这种方式,我们可以获取到一个热点调用图,找出消耗最多CPU资源的函数。例如,我们发现`handlerFunc`是CPU使用的大户。经过代码审查和逻辑分析,我们可能发现这个函数中存在不必要的复杂计算,进而通过优化算法或者移除冗余的计算来降低CPU消耗。

### 4.3.2 性能指标提升前后对比与总结

在进行优化后,我们再次执行相同的性能分析流程,以确认性能指标是否有所提升。比较优化前后的火焰图、CPU使用情况等,来衡量优化效果。如果优化措施有效,我们期望看到以下改进:

- 热点调用图中的CPU密集函数调用次数和持续时间减少。

- 程序的总体CPU使用率降低。

- 应用的响应时间缩短。

通过这些指标的变化,我们可以量化地评估性能优化的效果。最终,将这些优化措施整合到生产环境中,并持续监控性能表现,确保优化成果得以保持。这个案例展示了从识别问题、分析原因、实施优化,到验证结果的完整性能优化流程。

# 5. pprof工具与Go性能优化的最佳实践

## 5.1 性能优化的策略与原则

### 5.1.1 定位性能瓶颈的基本步骤

在深入分析和应用pprof工具进行性能优化前,理解性能瓶颈的定位步骤至关重要。以下是几个关键步骤:

1. **性能监控**:在应用部署后,持续监控应用性能指标,如CPU使用率、内存分配情况、延迟时间等。

2. **数据收集**:使用pprof或其他性能分析工具收集性能数据。这通常涉及到定期的CPU和内存profile。

3. **瓶颈定位**:分析收集到的profile数据,识别出应用中的性能瓶颈,如CPU密集型操作、内存分配热点或同步问题。

4. **问题分析**:对疑似瓶颈进行深入分析,理解问题的本质。这可能包括对代码逻辑的审视、算法优化以及系统调用的分析。

5. **性能优化**:根据分析结果进行相应的性能优化,比如优化热点函数、调整内存分配策略或改善锁的使用。

6. **效果验证**:优化后,重新收集性能数据并验证优化效果,确保性能得到改善且没有引入新的问题。

在执行这些步骤时,可能会遇到各种性能优化的常见误区,例如:

- **过早优化**:在没有充分理解性能瓶颈的情况下进行优化,可能会导致资源浪费和代码复杂度增加。

- **忽略全局**:仅优化单一功能而不考虑整个系统性能,可能会造成优化效果有限或新的瓶颈产生。

- **过度优化**:对已经足够优秀的代码进行过度优化,可能会降低代码的可读性和可维护性。

### 5.1.2 Go语言性能优化的常见误区

理解并避开这些误区是成功应用pprof进行性能优化的关键。下面列出一些常见的误区,并提供相应的解决策略:

- **误区**:认为pprof只能用于开发环境而不能在生产环境中使用。

- **策略**:使用pprof的生产友好模式来收集性能数据,如通过`net/http/pprof`包中提供的HTTP接口。

- **误区**:认为性能优化工作需要深厚的系统知识,新手无法参与。

- **策略**:从简单的性能监控和瓶颈识别开始,逐步积累经验,并与经验丰富的开发者合作学习。

- **误区**:对性能问题的根源没有深入理解,只进行表面的代码修改。

- **策略**:在做任何代码修改前,确保通过工具得到了充分的数据支持,对性能瓶颈有一个清晰的认识。

## 5.2 pprof与其他工具的协同使用

### 5.2.1 与Go内置的性能分析工具结合

Go语言内置的性能分析工具,如`runtime/pprof`和`net/http/pprof`,为开发者提供了丰富的性能分析能力。将pprof与这些工具结合使用,可以更好地进行性能优化。

- **`runtime/pprof`**:这个包允许我们在Go程序中直接集成pprof,用于分析CPU和内存使用情况。结合pprof工具可以更加直观地展示分析结果。

- **`net/http/pprof`**:通过在HTTP服务器中集成这个包,可以使得pprof的分析更加便捷。只需要访问特定的URL,就可以获取CPU和内存的profile数据。

- **`go tool pprof`**:这是命令行工具,用于分析pprof生成的profile文件。它可以生成火焰图,直观地展示函数调用关系和耗时情况。

下面是一个代码示例,展示如何在Go程序中集成`net/http/pprof`:

```go

package main

import (

"log"

"net/http"

_ "net/http/pprof" // 导入pprof包

)

func main() {

go func() {

log.Println(http.ListenAndServe("localhost:6060", nil))

}()

// ... 应用的主逻辑 ...

}

```

通过启动上述程序,可以通过访问`***`来获取pprof数据。

### 5.2.2 与其他性能监控工具的整合

为了全面的性能监控和分析,pprof可以与其他监控工具整合,例如Prometheus、Grafana等。这样可以将pprof的数据集成到整体监控系统中,实现统一的性能指标监控。

- **Prometheus**:Prometheus是一个开源的监控解决方案,支持多种数据收集方式。可以使用Prometheus的Go客户端库来收集Go程序的运行时指标,同时也可以通过exporter定期从pprof收集数据。

- **Grafana**:Grafana是一个开源的分析和监控可视化工具,可以与Prometheus结合使用,提供实时的图形化性能展示。

整合的步骤通常包括:

1. **部署Prometheus**:配置Prometheus来收集目标Go程序的指标数据。

2. **配置pprof数据抓取**:使用exporter或编写自定义的抓取逻辑,定期将pprof数据发送到Prometheus。

3. **设置Grafana**:在Grafana中导入Prometheus作为数据源,并创建仪表板来展示性能指标。

4. **性能监控与告警**:在Grafana中设置阈值告警,一旦性能指标达到或超过阈值,自动触发告警。

整合后的系统可以提供持续的性能监控,并且在出现问题时快速响应,提升性能优化的效率。

## 5.3 性能优化工作流程

### 5.3.1 性能优化的项目管理

进行性能优化时,应将其视为一个独立的项目来管理。以下是一个标准的性能优化项目管理流程:

1. **目标设定**:明确优化的目标,如减少延迟、提高吞吐量或降低资源使用。

2. **资源评估**:评估参与性能优化项目的人员、时间和资源。

3. **性能分析**:执行性能分析,定位瓶颈,并收集必要的数据。

4. **优化计划**:制定优化计划,包含优化策略和预期结果。

5. **实施优化**:根据计划执行具体的性能优化措施。

6. **效果评估**:优化完成后,重新进行性能分析,以评估优化效果是否达到预期目标。

7. **文档记录**:记录优化过程中的关键决策、实施步骤和最终效果。

8. **持续迭代**:将性能优化作为持续的过程,定期回顾并调整优化策略。

### 5.3.2 性能优化的持续迭代与维护

性能优化不仅仅是单次的活动,而是一个持续的过程。为了保持软件性能的持续优化,需要建立以下机制:

1. **定期审计**:定期进行性能审计,确保没有新的性能问题出现。

2. **版本控制**:在软件版本控制中记录性能优化的历史,跟踪优化的结果。

3. **性能测试**:在测试阶段加入性能测试,确保每次发布都能满足性能目标。

4. **监控系统**:部署持续的性能监控系统,实时收集性能数据。

5. **反馈循环**:建立开发团队和运维团队的沟通反馈机制,使性能问题能够快速得到响应和处理。

6. **知识共享**:在团队中分享性能优化的最佳实践和成功案例,提高团队整体的性能意识。

通过这些机制,可以确保性能优化的持续迭代和维护,从而保证软件性能长期处于最佳状态。

# 6. 展望Go语言性能优化的未来

随着技术的不断进步,性能优化已经成为了软件开发中不可或缺的一部分。在本章中,我们将探讨Go语言性能优化的最新趋势,以及社区和开源项目如何影响性能优化的发展。此外,我们还将分析性能优化在软件开发中的重要性,并提供一些持续提升性能意识的建议。

## 6.1 Go语言性能优化的最新趋势

Go语言自发布以来,已经在性能优化方面取得了长足的进步。社区不断地贡献新的特性,以及提供各种工具来帮助开发者更高效地进行性能优化。

### 6.1.1 新版本Go语言的性能特性

Go语言的新版本不断带来性能上的改进。例如,在Go 1.11版本中,引入了模块支持,这不仅改进了包管理的复杂性,还可能在一些情况下提高构建速度和性能。而在Go 1.18版本中,引入了泛型,这不仅扩展了语言的表达能力,还有助于开发者编写出更高效和更通用的代码。

未来的Go版本预计会继续在编译器优化、垃圾回收、网络和并发模型等方面提供改进。这包括了对编译器进行更深入的优化以生成更快的机器码,或者引入新的垃圾回收算法来减少暂停时间和提高内存利用率。

### 6.1.2 未来可能的性能优化工具和方法

随着Go语言的成熟,我们可以预见到一些新的性能优化工具和方法将应运而生。例如,AI和机器学习可能被引入到性能分析中,以预测和自动化性能瓶颈的解决。同时,随着硬件技术的发展,如多核处理器、GPU计算和新的存储技术,Go语言的运行时和标准库也可能需要更新以更好地利用这些硬件资源。

在工具方面,性能分析工具可能会集成更复杂的数据分析技术,比如实时性能监控、动态检测、以及与云平台的深入集成等。

## 6.2 社区与生态对性能优化的影响

Go语言的强大之处不仅在于其语言本身,还在于其背后的社区和生态系统。

### 6.2.1 Go社区的性能优化资源

Go社区提供了一个强大的资源库,其中包含了许多性能优化的资源。从官方文档到论坛讨论,再到各种第三方博客和教程,这些资源可以帮助开发者更好地理解性能特性,并学习如何实现和优化性能。

例如,社区中定期举行的Go会议和研讨会,经常有性能优化相关的议题和案例分享。此外,像性能优化相关的邮件列表和Slack频道,也是获取即时信息和反馈的好地方。

### 6.2.2 开源项目对性能优化的贡献

开源项目是推动Go语言性能优化的另一股重要力量。许多高性能的开源项目,比如etcd、Docker、Kubernetes等,不仅推动了Go语言的广泛应用,也在实际应用中对性能提出了更高的要求。

这些项目经常贡献性能改进的代码到Go的主仓库,或者分享他们的性能优化经验,这对整个Go社区都是有益的。例如,通过查看这些项目的代码库和性能分析报告,开发者可以学习到如何处理大规模并发、优化内存使用、以及提升网络通信的性能。

## 6.3 结语:性能优化在软件开发中的重要性

性能优化是软件开发中不可或缺的一环。在快速变化的技术环境中,了解性能优化的最新趋势、利用社区资源,以及参与开源项目,可以帮助开发者不断提升其性能意识。

### 6.3.1 性能优化与软件质量的关联

在软件开发中,性能优化和软件质量之间存在着密切的联系。一个优化良好的软件不仅运行速度快、资源使用少,而且也更稳定、可靠。因此,性能优化不应该被视为一个独立的阶段,而应该贯穿于整个软件开发生命周期。

### 6.3.2 作为开发者如何持续提升性能意识

作为一个开发者,持续提升性能意识是非常重要的。这包括学习和掌握性能优化的理论知识、实际操作技能,以及保持对新技术和工具的好奇心。通过实践、阅读、讨论和反馈,开发者可以不断提升自己的性能优化能力,并最终提高软件质量和开发效率。

0

0