MapReduce Shuffle过程深度剖析:以学生成绩处理为例

发布时间: 2024-12-25 13:51:15 阅读量: 19 订阅数: 16

学生mapreduce成绩分析

# 摘要

本文深入探讨了MapReduce Shuffle过程,这是大数据处理中一个关键步骤,负责数据的排序、分区、传输和聚合。通过对Shuffle过程的理论基础和细节分析,我们解释了其在MapReduce模型中的位置和作用,并详细考察了数据排序、分区策略以及网络通信优化等关键环节。文章还通过学生成绩处理案例,展示了Shuffle在实践中的应用,并提出了性能优化策略。此外,本文审视了Shuffle的高级特性和对大数据处理的影响,为未来的技术发展提供了洞见。

# 关键字

MapReduce Shuffle;数据排序;分区策略;网络通信优化;性能优化;大数据处理

参考资源链接:[MapReduce实战:学生成绩统计与分布分析](https://wenku.csdn.net/doc/4d9t3tos54?spm=1055.2635.3001.10343)

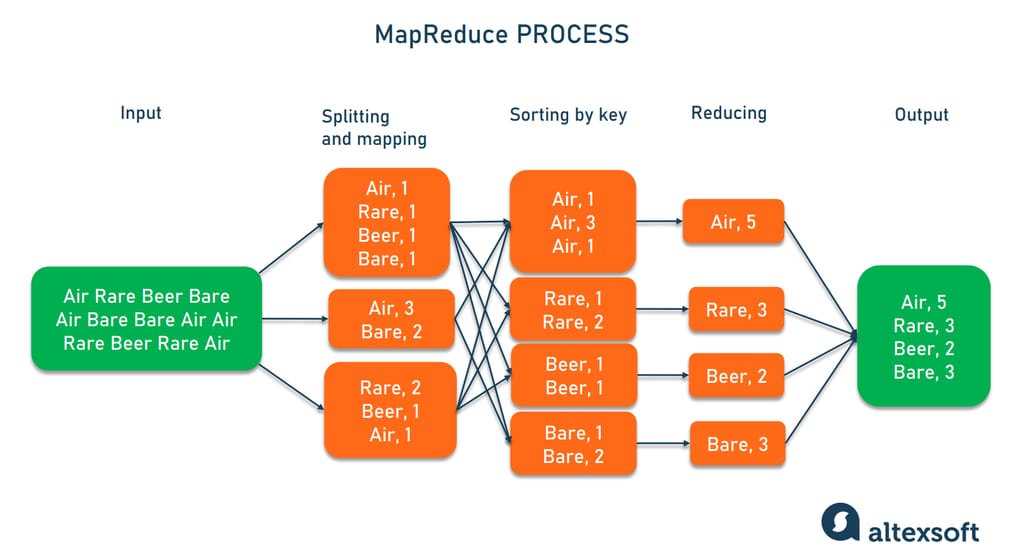

# 1. MapReduce Shuffle概述

MapReduce Shuffle是Hadoop生态系统中一个至关重要的过程,它是Map和Reduce任务之间的桥梁,确保数据从Map任务输出,并最终传递到Reduce任务进行处理。Shuffle过程包括了数据的排序、分区、传输和聚合等多个步骤,这些步骤共同保证了数据能够高效、有序地流转到下一个计算阶段。

理解Shuffle的运作机制对于优化MapReduce作业的性能至关重要。一个良好的Shuffle实现能够显著减少数据传输时间,提高作业处理效率。在深入探讨Shuffle过程之前,先来回顾一下MapReduce模型的基本原理,以及Shuffle过程在其中的位置。

```markdown

- Shuffle是MapReduce中的关键环节。

- 数据排序、分区、传输和聚合是Shuffle的主要步骤。

- 优化Shuffle可以提高MapReduce作业的整体性能。

```

在后续章节中,我们将详细探讨Shuffle过程的每一个环节,并结合案例来加深对这些概念的理解。此外,我们还将讨论Shuffle在实际应用中的性能优化策略,以及进阶技术与未来的发展趋势。

# 2. Shuffle过程的理论基础

### 2.1 MapReduce模型的简介

#### 2.1.1 MapReduce的工作原理

MapReduce 是一种分布式数据处理模型,广泛应用于大数据计算领域。其核心思想是将复杂的、大规模的数据集自动分割成许多独立的小数据块,并并行处理这些小数据块。MapReduce工作流程包括两个主要的阶段:Map阶段和Reduce阶段。

在Map阶段,Map任务会处理输入数据,将数据集中的数据映射成一组中间的键值对(key-value pairs)。这一阶段的主要工作是数据过滤和映射,通过用户自定义的Map函数将原始数据转换为适合排序和进一步处理的形式。

而在Reduce阶段,Reduce任务则会对Map阶段产生的中间数据进行处理,将具有相同键(key)的所有值(value)进行合并操作,最终得到结果数据。在这一阶段,用户需要定义Reduce函数,该函数决定了如何将中间数据进行规约操作,即聚合和汇总。

MapReduce框架负责调度和管理执行过程中的所有任务,包括任务的分配、监控执行状态以及错误处理等,从而实现透明的并行计算和容错处理。

#### 2.1.2 Map和Reduce阶段的作用

Map阶段的主要作用是对数据集进行切分和初步处理。通过Map任务,原始数据被转换成一系列便于处理的键值对,而这些键值对往往按照key进行了局部排序,为后续的Shuffle过程做好准备。

Reduce阶段的核心作用是汇总和聚合中间数据。通过Reduce任务,相同的key所对应的值被组合在一起,用户定义的Reduce函数将这些值合并成最终的结果输出。

在MapReduce框架中,Shuffle过程是连接Map阶段和Reduce阶段的桥梁。Shuffle过程保证了数据能够根据key值正确地从Map端传输到Reduce端,保证了数据处理的逻辑性和完整性。

### 2.2 Shuffle过程在MapReduce中的位置

#### 2.2.1 Shuffle与Map阶段的关系

Shuffle过程与Map阶段紧密相关,其在Map阶段结束后开始工作。Map任务完成数据处理后,输出的中间结果是暂时存储在本地磁盘上的键值对集合。

这些数据需要经过Shuffle过程传输到Reduce任务所在的节点,因此Shuffle是实现Map到Reduce阶段数据流动的关键环节。Map任务结束后,Shuffle负责将这些中间结果按照key值进行排序,并分发到对应key的Reduce任务。

Shuffle过程在Map端主要分为两个阶段:首先将Map输出写入到磁盘并创建索引,然后通过网络通信将数据传输给Reduce任务。

#### 2.2.2 Shuffle与Reduce阶段的连接

Shuffle过程连接了Map阶段和Reduce阶段,是整个MapReduce作业中数据流动和分发的关键步骤。它确保了Map端输出的中间数据能够正确地传输到Reduce端进行后续的处理。

在Reduce阶段,Shuffle过程从Map端接收数据后,首先要进行合并操作,将相同key的数据组合起来。这个过程称为合并Shuffle(merge shuffle),因为它涉及到了磁盘上的数据合并和排序。

随后,经过合并排序的中间数据被传递给Reduce任务,用户定义的Reduce函数开始对这些数据进行汇总。最终,Reduce任务输出处理结果,完成了MapReduce作业的整个计算流程。

Shuffle过程的性能直接影响到整个MapReduce作业的效率,尤其是在处理大规模数据集时,Shuffle的优化和调整对于提升作业执行速度和系统吞吐量至关重要。

在整个章节中,我们将深入探讨Shuffle过程的各个组成部分,揭示其在MapReduce中所扮演的角色,并探讨如何对这一过程进行优化以提升大数据处理的性能。

# 3. Shuffle过程的细节分析

## 3.1 Shuffle前的数据排序和分区

### 3.1.1 Map输出的排序机制

MapReduce在执行Map任务时,每个Mapper处理输入数据的一部分,并将中间结果输出到本地磁盘。这个中间结果首先会进行一个排序的过程,以确保相同键(key)的值(value)聚集在一起。这个过程称为Map端的排序,其排序规则按照key进行。Map端排序是Shuffle过程中的一个关键步骤,因为它直接决定了后续Shuffle传输到Reducer的数据量和排序顺序。

排序机制在Map端的工作流程如下:

1. Mapper在处理输入数据时,会创建一个内存中的环形缓冲区(也被称为排序缓冲区)。

2. 当缓冲区达到一定填充阈值(由mapreduce.jobcontrol buffer的百分比配置决定,默认为0.70)时,会开始对缓冲区中的数据进行排序。

3. 排序是基于key进行的,采用的是快速排序或者归并排序算法。

4. 排序完成之后,数据被溢写到磁盘上,形成若干个已排序的输出文件(spill files)。

当Map任务完成时,所有的溢写文件会被合并成一个最终的排序文件,供Shuffle过程传输到Reducer。

代码块示例:

```java

// 代码逻辑分析:在MapReduce的Mapper类中,通常会重写map方法,并在其中调用Context的write方法输出key-value对。

public void map(Object key, Text value, Context context) throws IOException, InterruptedException {

// 在这里处理数据并输出key-value对

context.write(new Text(key.toString()), new Text(value.toString()));

}

```

### 3.1.2 数据分区策略

数据分区是在Shuffle过程中决定哪些key-value对应该发送给哪个Reducer的机制。分区策略直接影响到后续Reduce任务处理数据的分布情况,因此是保证负载均衡的关键步骤。在MapReduce框架中,默认使用的是哈希分区(HashPar

0

0