【金融行业数据革命】:DataCall应用案例与在金融领域的创新实践

发布时间: 2024-12-25 19:20:24 阅读量: 11 订阅数: 9

免费的防止锁屏小软件,可用于域统一管控下的锁屏机制

# 摘要

随着数据革命的推进,DataCall技术与金融行业的融合产生了深远的影响。本文首先解析了DataCall的基础概念、核心特性和系统架构,突出其在数据采集、处理与分析流程中的优势。随后,通过在风险管理、客户服务优化和合规监管等领域的应用实践案例,展示DataCall如何提升金融服务质量和效率。本文还讨论了DataCall面临的性能优化、扩展性和集成挑战,并展望了其在金融科技创新中的发展趋势。文章旨在为金融行业的数据技术应用提供全面的分析和指导,促进技术与业务的深度融合。

# 关键字

DataCall技术;金融行业;数据处理;风险管理;客户服务;合规监管

参考资源链接:[Android DataCall 深入解析:移动终端数据连接原理](https://wenku.csdn.net/doc/64kq2koedj?spm=1055.2635.3001.10343)

# 1. 数据革命与金融行业的融合

在信息时代,数据的产生和应用方式正在经历一场革命,这场革命正在深刻地影响着金融行业。随着技术的进步,数据分析能力得到极大提升,金融业务流程中的每一个环节都可能通过数据驱动进行优化,从而提高效率和质量。数据革命与金融行业的融合,已经成为推动金融业创新和变革的关键力量。

## 1.1 数据在金融行业中的作用

数据在金融行业中的作用体现在决策支持、风险管理和客户服务等多个方面。准确的数据分析能够帮助金融机构预测市场走势,为用户提供个性化服务,并在风险防范中发挥重要作用。数据的深度挖掘和应用,使金融服务更加智能化、精准化,显著提升了金融行业的整体竞争力。

## 1.2 数据革命带来的挑战

然而,数据革命也给金融行业带来了一系列挑战。如何有效地收集和整合分散在不同渠道和平台上的数据,如何保证数据的安全性和隐私性,以及如何处理数据的合规性问题,都是金融机构必须面对的难题。此外,随着数据量的激增,数据处理的实时性和准确性也成为了技术上的一大挑战。

通过接下来的章节,我们将深入了解DataCall技术如何应对这些挑战,并在金融行业中发挥关键作用。

# 2. DataCall技术架构解析

在金融行业与数据科技日益融合的今天,DataCall技术作为一种革新的数据处理与分析平台,对行业产生了深远的影响。DataCall不仅能够高效地进行数据集成和分析,而且还提供了强大的安全机制来保护敏感信息。接下来,我们将深入解析DataCall的技术架构,从基础概念到系统组成,从安全合规性到应用实践。

## 2.1 DataCall基础概念和核心特性

### 2.1.1 DataCall的定义与诞生背景

DataCall是一种先进的数据集成和分析平台,它使得企业能够快速收集、整合、处理和分析来自不同来源的大量数据。DataCall的核心是其能力,以实时或准实时方式对数据进行处理,使企业能够从中提取洞察力并作出快速反应。

DataCall技术的诞生背景与数据革命密切相关。随着技术的进步和数字化转型的推进,数据量呈爆炸性增长,对数据处理和分析的需求变得越来越迫切。尤其是对于金融行业而言,对于数据的时效性、准确性和安全性要求极高。因此,DataCall作为一种应运而生的技术,其目的在于解决传统数据处理方式所面临的延时、低效和安全风险问题。

### 2.1.2 核心技术与优势分析

DataCall的核心技术主要包括数据实时采集、流式处理、内存计算和分布式存储等。这些技术的结合使得DataCall具有以下几个显著优势:

- 实时性能:DataCall能够实时采集和处理数据流,这对于需要即时反应的金融业务至关重要。

- 扩展性:通过分布式架构设计,DataCall能够轻松扩展以应对大规模数据的处理需求。

- 高可用性:DataCall平台设计为高可用性,确保业务连续性并减少停机时间。

- 安全性:具有多层次的数据保护和加密机制,确保金融数据在处理过程中的安全。

## 2.2 DataCall的系统组成与数据流程

### 2.2.1 主要组件和功能模块

DataCall平台主要由以下组件构成:

- 数据源连接器:负责连接各种数据源,包括数据库、APIs、日志文件等。

- 数据流处理引擎:在内存中处理数据流,执行实时分析和转换。

- 分布式存储层:提供高性能的数据存储解决方案,以支持复杂查询和大数据量。

- API网关:为用户提供RESTful API,用于与DataCall进行交互。

这些组件协同工作,形成一个完整的数据处理管道,支持从数据采集到分析的整个生命周期。

### 2.2.2 数据采集与传输机制

DataCall的数据采集机制针对不同的数据源采取了优化的策略。例如,对于结构化数据源,DataCall提供强大的SQL连接器,允许直接查询数据库并实时收集数据。对于非结构化数据,如日志文件,DataCall可使用文件系统连接器进行实时监控并读取新数据。

传输机制方面,DataCall依赖于消息队列技术,如Apache Kafka,确保数据流在组件间传输的高效性和可靠性。消息队列的引入不仅降低了数据传输的延迟,还提高了系统的可扩展性和容错能力。

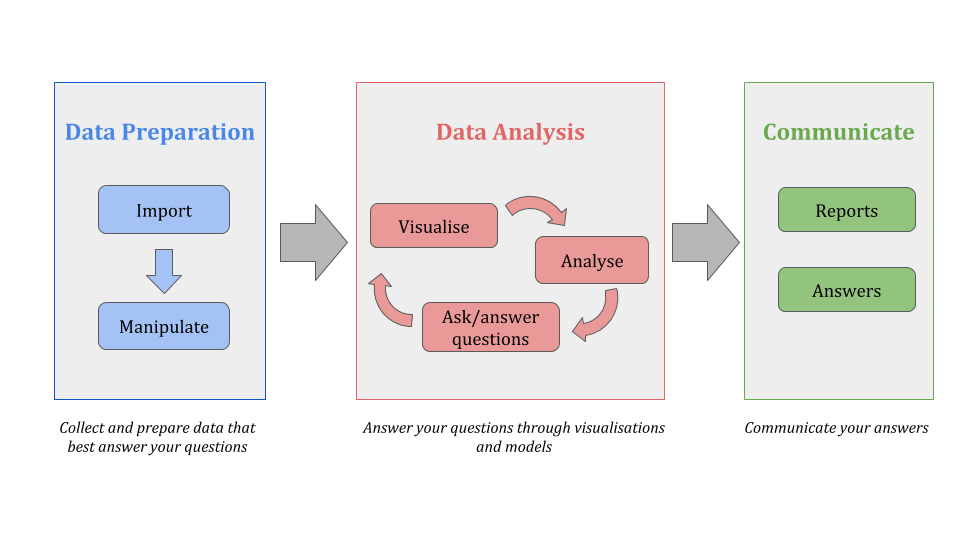

### 2.2.3 数据处理与分析流程

数据处理和分析流程是DataCall的核心功能之一。以下是该流程的简要说明:

1. 数据源连接:DataCall平台首先与多种数据源建立连接,并实时收集数据。

2. 数据清洗与转换:采集到的数据通过一系列转换操作进行清洗,去除异常值,纠正错误,转换格式等。

3. 实时分析与处理:经过清洗的数据会送入流式处理引擎进行实时分析。这包括聚合计算、模式识别、异常检测等。

4. 数据存储与

0

0