提升数据处理效率的Kettle Pentaho高级技巧:实践与案例分析

发布时间: 2024-12-27 05:26:26 阅读量: 7 订阅数: 11

ETL数据整合与处理(Kettle)教案.rar

# 摘要

本文详细介绍了Kettle Pentaho在数据处理领域中的应用,从基础概念到高级技巧,再到数据集成与ETL流程的优化、数据质量管理与监控,以及其在大数据环境中的应用进行了全面探讨。文章首先概述了Kettle Pentaho的基础知识和数据处理的基本原则,然后深入讨论了数据转换技巧、性能优化和调试的最佳实践。接着,文章转向数据集成与ETL流程设计和优化,重点关注了大数据量处理和跨系统整合的实际案例分析。在数据质量管理方面,文中阐述了数据质量检查、清洗和监控的重要性及其实施方法。最后,本文探讨了Kettle Pentaho插件的架构和应用,以及它在处理大数据挑战中的特定应用场景。通过案例分析,本文提供了实用的解决方案和策略,旨在提升数据处理的效率和准确性。

# 关键字

Kettle Pentaho;数据处理;数据转换;ETL流程;数据集成;数据质量监控;大数据处理

参考资源链接:[SH367309锂电池BMS芯片:平衡功能与电压设置](https://wenku.csdn.net/doc/5pco62mbjb?spm=1055.2635.3001.10343)

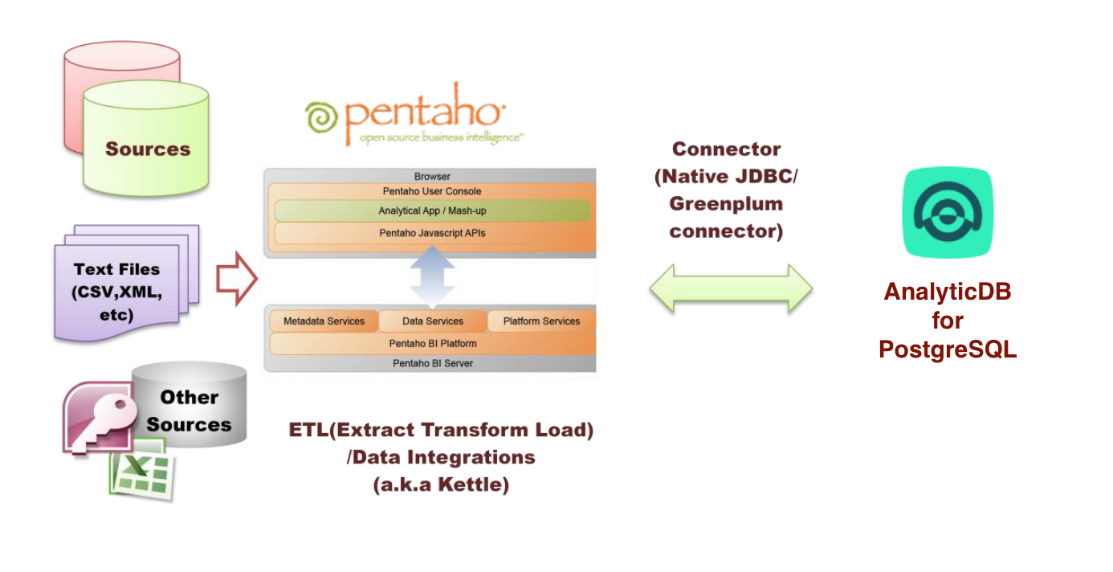

# 1. Kettle Pentaho概述与数据处理基础

## 1.1 Kettle Pentaho简介

Pentaho Data Integration(PDI),也被亲切地称为 Kettle,是一个开源的ETL工具,它允许用户从各种数据源中提取、转换和加载数据,是Pentaho商业智能套件的核心组成部分。Kettle提供了一系列图形化界面工具,以及丰富的转换和步骤,为数据仓库的建设提供了强大支持。

## 1.2 数据处理基础概念

数据处理是指在获取数据后,通过一系列操作使其变得可用、一致和整洁的过程。这包括数据清洗、数据集成、数据转换、数据质量检查、数据加载等步骤。在Kettle中,数据处理的基础是转换(Transformation)和作业(Job)。

- **转换(Transformation)** 是一个独立的数据处理单元,能够实现数据的提取、转换和加载(ETL)操作。

- **作业(Job)** 则是由多个转换和其他作业构成的序列,可以用来实现数据处理的批处理工作。

## 1.3 数据处理流程图

在Kettle中,数据处理流程通常以图形化的方式展现,方便设计和调试。数据处理流程图可以帮助理解数据流在各个步骤中的移动,从源系统流向目标系统。

```mermaid

graph LR

A[开始] --> B[输入/读取数据]

B --> C[数据清洗]

C --> D[数据转换]

D --> E[数据验证]

E --> F[输出/加载数据]

F --> G[结束]

```

在接下来的章节中,我们将深入探讨Kettle在数据转换和集成中的应用,以及如何进行数据质量管理和优化处理流程。

# 2. 数据转换与高级转换技巧

### 2.1 数据转换基础

#### 2.1.1 Kettle基本转换组件

Kettle(Pentaho Data Integration)是一个用于数据转换的开源工具,它提供了一整套丰富的转换组件,这些组件可以被组合成复杂的转换流程,以完成从数据抽取、转换到加载(ETL)的任务。

Kettle的基本组件包括:

- **输入组件**:例如表输入(Table input)、CSV文件输入(CSV file input),用于从不同数据源读取数据。

- **输出组件**:例如表输出(Table output)、文本文件输出(Text file output),用于将数据写入目标系统。

- **转换组件**:例如排序行(Sort rows)、选择/重命名字段(Select/rename values),用于数据清洗和格式转换。

```mermaid

graph LR

A[开始] --> B[输入组件]

B --> C[转换组件]

C --> D[输出组件]

D --> E[结束]

```

对于一个典型的数据转换过程,Kettle允许用户进行字段修改、数据筛选、数据聚合和数据合并等操作。这些操作通过图形化界面拖放组件来实现,大大降低了编写复杂转换逻辑的难度。

#### 2.1.2 转换的数据流设计原则

在设计数据流时,应该遵循一些基本原则来确保转换过程的高效性和可维护性:

- **模块化设计**:将复杂的转换逻辑分解为多个小的、可重用的模块,使整体流程更清晰。

- **错误处理机制**:在流程中包含错误处理步骤,以便于在数据转换中出现问题时可以被追踪和纠正。

- **性能考虑**:在组件使用时考虑性能影响,例如使用缓存组件减少对数据库的重复访问。

在设计转换时,我们需要考虑数据的清洗、格式化、转换以及数据质量的校验。例如,在数据清洗阶段,可以使用过滤器(Filter rows)组件去除重复记录或者不符合标准的数据。

### 2.2 高级数据转换技巧

#### 2.2.1 复杂数据处理流程的构建

在处理复杂数据时,构建稳健的处理流程是关键。这通常涉及到多个组件的组合使用和数据流的合理配置。

以下是一个复杂数据处理流程的构建步骤:

1. **数据源连接**:首先,连接各种数据源,如关系型数据库、CSV文件、Web服务等。

2. **数据预处理**:包括数据清洗(去空格、格式化等)、数据验证(数据类型、范围检查等)。

3. **数据转换**:应用数据转换组件进行数据类型的转换、字段的拆分和合并等操作。

4. **数据聚合**:利用聚合(Aggregation)组件对数据进行分组、汇总。

5. **数据后处理**:最终的数据校验、数据格式的调整和准备输出格式。

```mermaid

graph LR

A[开始] --> B[数据源连接]

B --> C[数据预处理]

C --> D[数据转换]

D --> E[数据聚合]

E --> F[数据后处理]

F --> G[结束]

```

#### 2.2.2 转换性能优化策略

性能优化是数据转换中不可忽视的部分。以下是一些常用的性能优化策略:

- **批处理**:在输入和输出组件中使用批处理模式以减少I/O操作次数。

- **索引优化**:在数据库操作中合理使用索引,以加快查询和更新速度。

- **并发处理**:使用步骤并发执行组件(Concurrent execution)来并行处理数据流。

```mermaid

graph LR

A[开始] --> B[识别瓶颈]

B --> C[批处理调整]

C --> D[索引优化]

D --> E[并发处理配置]

E --> F[结束]

```

#### 2.2.3 调试转换流程的最佳实践

调试转换流程是确保数据转换按预期执行的重要步骤。以下是一些最佳实践:

- **详细日志记录**:开启详细日志记录功能,以便跟踪转换执行过程中的每一步操作。

- **逐步执行**:利用逐步执行功能检查数据流中的单个组件是否正常工作。

- **错误处理**:在可能出错的地方设置错误处理机制,确保异常情况能被捕捉并进行相应处理。

### 2.3 实际案例分析

#### 2.3.1 大数据量转换的优化案例

在处理大数据量时,一个有效的转换优化案例是使用分区和并行处理技术。

以下是一个大数据量转换优化的案例步骤:

1. **输入分区**:将大数据源进行分区,使得每个分区可以在不同的线程中处理。

2. **并行处理**:在转换过程中使用并行处理的组件,例如并行执行步骤(Concurrent executions),以利用多核CPU的优势。

3. **临时存储**:使用临时存储机制(如临时文件或内存中的临时表)来存储中间数据,以减少对主存储的依赖。

#### 2.3.2 错误处理和异常数据转换案例

在实际的数据转换案例中,经常遇到错误处理和异常数据的问题。

以下是一个错误处理和异常数据转换的案例步骤:

1. **错误检查**:在数据预处理阶段,加入错误检查组件来过滤不符合规则的数据。

2. **异常记录**:将错误数据记录到日志文件中或一个单独的错误表中,以便后续分析。

3. **数据补救**:对于能恢复的数据,编写逻辑进行数据补救;对于无法恢复的数据,可以设置人工介入的环节。

通过以上各种案例的分析和实际应用,可以进一步理解Kettle在数据转换中的强大功能和灵活性。这些案例也表明,通过合理设计和优化,Kettle能够有效应对从简单到复杂的各种数据转换需求。

# 3. 数据集成与ETL流程优化

## 3.1 ETL流程设计原理

### 3.1.1 ETL生命周期及其重要性

ETL(Extract, Transform, Load)流程是数据仓库与数据集成的核心,其生命周期涉及数据的抽取、转换和加载。理解ETL生命周期对于设计高效、稳定的数据集成方案至关重要。

在ETL生命周期中,抽取是数据集成的起点,涉及到从源系统中获取数据。这需要对源数据格式、数据质量以及抽取频率等进行充分的考虑。抽取策略可以是周期性的或事件驱动的,这依赖于数据集成的目的和业务需求。

转换是ETL流程的中间环节,转换的目的是将抽取的数据转换为适合加载到目标系统(如数据仓库、数据湖或数据市场)的格式和结构。转换过程中常常需要进行数据清洗、数据标准化、数据聚合和数据合并等操作。有效的转换能极大地提高数据的价值和可靠性。

加载阶段则是将转换后的数据加载到目标数据库中。加载策略应当考虑数据的一致性、完整性和性能。在这一阶段,可以使用不同的加载模式,如全量加载、增量加载或变更数据捕获(CDC)。

ETL生命周期的重要性体现在能够保证数据在不同系统间传输的准确性、一致性和完整性。一个良好的ETL生命周期设计可以大幅提高数据处理效率,降低错误率,同时确保数据的实时性和可靠性。

### 3.1.2 数据抽取策略和方法

数据抽取是ETL流程的第一步,数据抽取策略的选择直接影响到整个ETL流程的效率和效果。以下是几种常见的数据抽取策略和方法:

- **全量抽取**:一次性抽取源系统中所有的数据,适用于数据量不大、变化不频繁的数据源。

- **增量抽取**:只抽取自上一次抽取以来发生变化的数据。通常依赖于记录变化的标记(如时间戳、日志等)。

- **变更数据捕获(CDC)**:利用日志技术,持续跟踪并抽取数据的变更。这种方法可以提供实时的数据更新。

- **触发抽取**:根据特定事件或条件触发数据抽取过程,比如在数据源系统中数据发生特定变化时。

数据抽取方法可以是API调用、数据库连接查询、文件导入导出等。选择抽取方法时需要考虑源数据系统的类型、抽取的数据量大小、实时性要求以及数据抽取的频率。

数据抽取时要特别注意数据的完整性和一致性。在抽取过程中,应尽量减少对源系统的影响,尤其是对生产系统的抽取。例如,通过异步复制和数据归档等技术手段,降低抽取操作对源系统性能的影响。

### 3.1.3 数据转换策略和方法

在ETL流程中,数据转换是一个关键步骤,它涉及到将抽取的数据转换为适合目标系统的格式和结构。数据转换策略和方法的选择,直接影响数据的质量和后续的数据分析效果。

数据转换通常包括以下几个方面:

- **数据清洗**:识别并修正错误或不一致的数据,删除重复记录,处理缺失值。

- **数据转换**:将数据从一种格式转换为另一种格式,比如字符编码的转换、数值单位的转换等。

- **数据映射**:定义源数据到目标数据的映射关系,确保数据的语义在不同系统间保持一致。

- **数据聚合**:按照特定的规则对数据进行合并,以满足分析需要。

- **数据转换逻辑**:实现复杂的转换逻辑,比如计算字段、分组统计等。

数据转换方法有多种,可以使用内置的转换组件,如Pivot、Sort、Join、Lookup等。也可以通过脚本或者自定义的转换逻辑来实现。Kettle提供了丰富的转换组件,可以满足各种复杂的数据转换需求

0

0