YOLOv8模型评估解析:mAP计算与应用全攻略

发布时间: 2024-12-11 17:57:58 阅读量: 11 订阅数: 15

YOLOv8在COCO数据集上的性能指标全解析

# 1. YOLOv8模型评估基础

## 1.1 YOLOv8简介

YOLOv8(You Only Look Once version 8)是目标检测领域内一个革命性的深度学习模型。它以实时性和准确性闻名,使得在处理图像识别任务时,可以在保证高准确度的同时,对新的图像数据进行快速预测。YOLOv8 模型不仅继承了其前几代的特性,还在训练速度、模型复杂性与泛化能力上进行了显著的优化,使它成为目前业界最受欢迎的目标检测模型之一。

## 1.2 模型评估的目的

模型评估是机器学习中的一个重要环节,尤其在目标检测任务中,准确的评估能够帮助研究者和工程师了解模型在实际应用场景中的性能。通过一系列的指标,如精确度、召回率、mAP等,能够全面衡量模型的优劣。YOLOv8模型的评估尤其重要,因为它关系到该模型能否在实际应用中承担关键角色,诸如自动驾驶、安全监控、医疗影像分析等。

## 1.3 模型评估的挑战

模型评估面临的最大挑战之一是评估指标的选择与适用性。对于不同的应用场景和目标检测任务,最适合的评估指标可能会有所不同。例如,在实时性要求极高的场合,快速性可能比准确性更为关键,而在医疗领域,准确性则可能是绝对的优先考量。YOLOv8模型评估需要综合考虑这些因素,以确保评估结果不仅科学、客观,还能为实际应用提供有效的指导。接下来,我们将深入探讨如何通过mAP来评估YOLOv8模型的性能,及其在实际应用中的重要性。

# 2. mAP计算的理论与方法

### 2.1 mAP的定义和重要性

mAP(Mean Average Precision)是衡量目标检测模型性能的常用指标,它将精确度(Precision)和召回率(Recall)结合起来,提供了一个综合的评价标准。

#### 2.1.1 精确度、召回率和mAP的关系

精确度和召回率是分类问题中的两个基本指标。精确度是正确预测正类的数量与所有预测为正类数量的比值。召回率则是正确预测为正类的数量与所有实际为正类的数量的比值。

mAP通过计算每一个类别在不同的召回率水平下的精确度的平均值来汇总模型性能。它将精确度-召回率曲线(PR 曲线)下的面积平均化,得到一个单一的数值指标,从而允许对多个类别或多个模型进行比较。

#### 2.1.2 mAP在目标检测中的作用

在目标检测任务中,我们不仅要对每一个类别进行评估,还可能面临多类别检测、背景干扰以及目标重叠等问题。mAP能够较好地适应这些复杂情况,提供一个整体的性能评估。因此,在比较不同目标检测模型的性能时,mAP常常被作为关键的评价标准之一。

### 2.2 mAP计算的详细步骤

#### 2.2.1 检测结果的整理与格式化

为了计算mAP,首先需要对检测结果进行整理。每个检测结果通常包含以下信息:

- 检测框的坐标位置(x, y, width, height)

- 预测的置信度(confidence score)

- 预测的类别

检测结果通常按照置信度从高到低进行排序。然后,将排序后的结果与真实标签进行比较,从而生成PR曲线。

#### 2.2.2 真实值与预测值的匹配算法

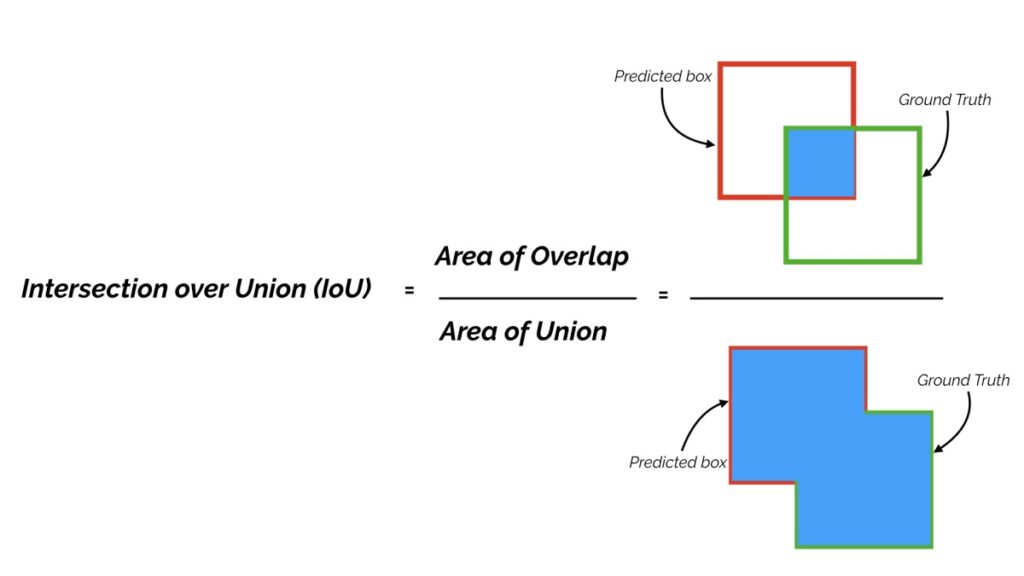

匹配算法用于将检测结果与真实标签进行匹配。在目标检测中,通常设定一个阈值(如0.5)作为匹配标准,即预测框与真实框的交并比(Intersection over Union, IoU)大于这个阈值时,预测框被认为正确匹配到了一个目标。

匹配策略直接影响计算mAP的结果。常见的匹配方法包括:

- 单一阈值方法:固定IoU阈值进行匹配。

- 最佳匹配方法:考虑所有可能的IoU阈值,并选择最佳匹配。

#### 2.2.3 平均精度(AP)的计算

平均精度(AP)是针对单一类别的mAP计算。具体步骤如下:

1. 将所有预测结果按照置信度降序排列。

2. 对每一个预测,根据是否正确匹配计算精确度和召回率。

3. 根据不同的召回率水平,计算出一系列精确度值,形成一个精确度序列。

4. 计算上述精确度序列的平均值即为该类别的AP。

mAP是所有类别AP的平均值,如果数据集中包含多个类别,则需要按照一定的权重计算加权平均值。

### 2.3 mAP在不同数据集上的应用

#### 2.3.1 COCO数据集mAP评估标准

COCO数据集是一个广泛应用在目标检测、分割、关键点检测任务中的数据集。COCO的mAP评估标准采用了多尺度评估和AP@IoU阈值评估。为了得到COCO的mAP指标,通常需要在10个不同的IoU阈值下(从0.5到0.95,步长为0.05)计算AP,并将这些AP值进行平均。

#### 2.3.2 PASCAL VOC数据集的mAP评估差异

PASCAL VOC数据集是早期广泛使用的目标检测数据集,其mAP计算标准相比COCO更为简单,通常设定单一的IoU阈值(0.5)。PASCAL VOC数据集的评估方法在一定程度上简化了评估流程,但这导致其评估结果可能不够全面。

下面我们通过一个实际的例子来演示mAP的计算过程。假设我们有一个简单的数据集和对应的预测结果。

```python

# 模拟一些预测结果和真实标签

import numpy as np

from sklearn.metrics import average_precision_score

# 真实标签和预测结果

true_classes = np.array([1, 1, 2, 2, 3])

pred_scores = np.array([0.9, 0.7, 0.8, 0.6, 0.5])

pred_classes = np.array([1, 1, 2, 3, 3])

# 计算mAP

ap = average_precision_score(true_classes, pred_scores)

mAP = np.mean(ap)

print(f"mAP: {mAP}")

```

代码逻辑分析:

- 首先,我们导入了`numpy`和`sklearn.metrics`中的`average_precision_score`函数来辅助计算。

- 真实标签和预测结果被存储为numpy数组。

- `average_precision_score`函数计算了各个类别的平均精度,然后我们对每个类别的AP求均值得到mAP。

请注意,实际应用中的mAP计算会更加复杂,需要考虑更多的因素,如类别的平衡、匹配策略等。

为了更直观地理解mAP的计算,我们可以绘制精确度-召回率曲线,通过观察曲线下的面积来评估模型性能。

```python

from sklearn.metrics import precision_recall_curve

# 计算精确度和召回率

precision, recall, _ = precision_recall_curve(true_classes, pred_scores)

# 绘制PR曲线

import matplotlib.pyplot as plt

plt.step(recall, precision, where='post')

plt.xlabel('Recall')

plt.ylabel('Precision')

plt.ylim([0.0, 1.05])

plt.xlim([0.0, 1.0])

plt.show()

```

以上代码生成了精确度-召回率曲线。PR曲线下的面积越接近1,表示模型的性能越好。在实际的评估中,需要为每个类别绘制一个PR曲线,并对所有曲线下的面积取平均,得到mAP值。

# 3. YOLOv8模型的mAP实践分析

## 3.1 YOLOv8模型的训练与测试

### 3.1.1 训练数据集的准备和预处理

对于深度学习模型的训练而言,数据集的质量直接影响到模型的性能。YOLOv8作为目标检测算法,也不例外。在准备训练数据集时,需确保数据具有多样性、代表性,并且能够覆盖目标检测中的各种场景。数据预处理包括但不限于以下步骤:

- 数据清洗:移除模糊、曝光过度或欠曝、以及其他质量不佳的图片。

- 标注:使用标注工具(如LabelImg或CVAT)为每个目标添加边界框和对应的类别标签。

- 数据增强:通过对图像进行旋转、缩放、裁剪、颜色调整等增强操作来增加数据集的多样性。

- 归一化:将数据归一化至[0,1]或[-1,1]的范围,以提高训练过程中的收敛速度。

- 数据划分:将数据集划分为训练集、验证集和测试集,以便评估模型性能。

### 3.1.2 模型训练过程和参数设置

训练YOLOv8模型包括初始化模型权重、设置超参数、损失函数以及训练过程中的优化器选择。以下是一些关键的训练设置参数和逻辑:

- 超参数配置:调整学习率、批量大小(batch size)、权重衰减等参数。

- 损失函数:YOLOv8使用的是多任务损失函数,包括边界框回归损失、目标分类损失及置信度损失。

- 优化器:Adam或SGD优化器通常用于训练YOLO模型,可以根据情况调整其参数。

- 学习率调度:使用学习率衰减或周期性调整学习率来提高训练效率。

```python

# 示例代码:设置YOLOv8模型训练参数

model = YOLOv8(num_classes=80) # 假设处理的是COCO数据集

optimizer = torch.optim.Adam(model.parameters(), lr=1e-3, weight_decay=5e-4)

scheduler = torch.optim.lr_scheduler.StepLR(optimizer, step_size=50, gamma=0.1)

# 训练过程逻辑

for epoch in range(num_epochs):

for batch in dataloader:

optimizer.zero_grad()

predictions = model(batch.images)

loss = compute_loss(predictions, batch.labels)

loss.backward()

optimizer.step()

scheduler.step() # 更新学习率

```

### 3.1.3 测试和结果评估

模型训练完成后,需要对模型在测试集上的性能进行评估。使用mAP指标对模型进行定量分析,对比不同模型版本或参数调整前后的性能变化。测试流程如下:

- 测试数据集准备:使用未参与训练的验证集或测试集。

- 结果生成:运行模型对测试图像进行预测,得到预测边界框和置信度。

- 结果评估:计算mAP指标,对模型性能进行评估。

## 3.2 mAP在模型优化中的应用

### 3.2.1 调整模型参数对mAP的影响

mAP作为评估指标,能直观反映模型在不同参数下的性能变化。通过调整模型参数,如锚框尺寸、层数、滤波器数量等,可以观测到这些改变如何影响mAP值。

### 3.2.2 使用mAP进行模型选择和比较

在实验中可能会尝试多种模型结构或训练策略,mAP成为评价这些不同模型表现的关键指标。通过对比不同模型的mAP值,可以直观地选择出最优模型。

## 3.3 mAP在实际应用中的问题与对策

### 3.3.1 mAP评估中常见的问题

mAP评估可能遇到的问题包括但不限于:

- 类别不平衡问题:一些类别样本数量远多于其他类别,可能导致模型偏向这些类别。

- 小目标检测问题:小目标可能因为图像分辨率低而难以检测,导致mAP评分下降。

- 算法评估的不一致性:不同的评估软件或代码实现可能导致mAP值存在差异。

### 3.3.2 提升mAP的策略和实践

为了解决上述问题并提升mAP值,可以采取以下策略:

- 对数据进行重采样,例如使用上采样或下采样技术处理类别不平衡问题。

- 使用图像金字塔技术增强模型对小目标的检测能力。

- 确保使用标准化的评估工具和方法,比如使用官方标准的COCO评估工具,以保证评估结果的准确性。

```python

# 示例代码:使用图像金字塔技术增强小目标检测

def image_pyramid(image, scales):

"""

生成图像金字塔,用于增强模型对小目标的检测能力。

:param image: 输入图像

:param scales: 生成金字塔的尺度列表

:return: 金字塔图像列表

"""

pyramid_images = [image]

for s in scales:

if s < 1.0:

scaled_image = cv2.resize(image, None, fx=s, fy=s, interpolation=cv2.INTER_LINEAR)

pyramid_images.append(scaled_image)

return pyramid_images

# 使用图像金字塔

pyramid = image_pyramid(image, [0.75, 0.5])

```

通过上述措施,可以有效提高模型在实际应用场景中的mAP表现,并更准确地评估模型在目标检测任务中的性能。

# 4. 深度学习评估指标对比

## 4.1 mAP与其他评估指标的对比

### 4.1.1 mAP与IoU的比较

平均精度均值(mAP)和交并比(IoU)是目标检测中常用的两个指标,但它们的侧重点和应用场景有所不同。

#### **交并比(IoU)**

IoU 衡量的是预测框和真实框之间的重叠程度。对于单个预测结果来说,IoU 计算如下:

```python

def IoU(boxA, boxB):

# 计算交集

x1 = max(boxA[0], boxB[0])

y1 = max(boxA[1], boxB[1])

x2 = min(boxA[2], boxB[2])

y2 = min(boxA[3], boxB[3])

intersection = max(0, x2 - x1) * max(0, y2 - y1)

# 计算预测框和真实框的面积

boxAArea = (boxA[2] - boxA[0]) * (boxA[3] - boxA[1])

boxBArea = (boxB[2] - boxB[0]) * (boxB[3] - boxB[1])

# 计算 IoU

IoU = intersection / float(boxAArea + boxBArea - intersection)

return IoU

```

IoU 的优点在于,它是一个直观的量化重叠度的指标,通常用于非极大值抑制(NMS)过程中,以决定是否合并两个高重叠的边界框。

#### **mAP**

mAP 是 IoU 的扩展,它考虑了预测的精度以及召回率。为了计算 mAP,首先需要根据预测置信度对检测结果进行排序,然后计算在不同置信度阈值下的平均精度(AP)。mAP 则是所有类别的 AP 的平均值。

```python

def mAP(ground_truths, detections, IoU_threshold=0.5):

# 准备真实值和预测值

# ...

# 计算所有类别和所有阈值的AP

APs = []

for cls in classes:

# 获取类别 cls 的真实值和预测值

gt_boxes = [gt for gt in ground_truths if gt['class'] == cls]

dt_boxes = [dt for dt in detections if dt['class'] == cls]

# 计算每个检测的正确性

# ...

# 按置信度排序并计算每个检测的累积精度

# ...

# 插值法计算AP

# ...

APs.append(AP)

# 返回所有类别的 mAP

return sum(APs) / len(APs)

```

在比较 mAP 与 IoU 时,一个关键的区别在于 mAP 是在多个类别和多个置信度阈值下对检测性能的全面评价,而 IoU 更多是用于单次预测的重叠度量。

### 4.1.2 mAP与精确度、召回率的关系

精确度和召回率是分类问题中常用的两个概念,它们在目标检测中同样适用。精确度是预测为正的样本中实际为正的比例,召回率是实际为正的样本中预测为正的比例。

```python

def precision_recall(tp, fp, fn):

# 计算精确度和召回率

precision = tp / (tp + fp) if (tp + fp) > 0 else 0

recall = tp / (tp + fn) if (tp + fn) > 0 else 0

return precision, recall

```

mAP 实际上结合了精确度和召回率的概念。在计算 AP 时,需要对每个类别绘制精确度-召回率曲线,并计算该曲线下面积。mAP 是所有类别的 AP 的平均值,它因此同时考虑了精确度和召回率的综合影响。

## 4.2 其他深度学习评估指标

### 4.2.1 Precision-Recall曲线分析

精确度-召回率曲线(PR 曲线)是一个很好的工具,用于可视化不同阈值设置下的精确度和召回率。PR 曲线下的面积(AP)可以用来衡量模型的整体性能。PR 曲线相比于 ROC 曲线更适合于不平衡数据集的情况。

```mermaid

graph TD;

A-->B;

B-->C;

C-->D;

```

在上述流程图中,可以展示一个典型的 PR 曲线的生成过程,通过调整阈值,可以得到一系列精确度和召回率的组合点。这些点连接成线,形成曲线,下面的区域面积就是 AP。

### 4.2.2 F1分数和混淆矩阵的解读

F1 分数是精确度和召回率的调和平均值,其计算公式如下:

```python

def F1_score(precision, recall):

F1 = 2 * (precision * recall) / (precision + recall) if (precision + recall) > 0 else 0

return F1

```

F1 分数提供了一个在精确度和召回率之间平衡的单一指标,非常适合于我们想要同时考虑两个指标的情况。

混淆矩阵是另一种评估模型性能的方式,它显示了分类器对正样本和负样本的预测结果。以下是混淆矩阵的一个例子:

| 真实\预测 | 预测正例 | 预测负例 |

|------------|------------|------------|

| 实际正例 | 真阳性 (TP) | 假阴性 (FN) |

| 实际负例 | 假阳性 (FP) | 真阴性 (TN) |

混淆矩阵提供了详细的分类结果,可以用来计算精确度、召回率等其他评估指标。

## 4.3 指标选择的策略与建议

### 4.3.1 根据任务类型选择合适的评估指标

评估指标的选择应根据具体任务类型和目标来决定。在目标检测任务中,mAP 由于其综合考虑了精确度和召回率,通常是一个非常好的选择。然而,在某些特定情况下,比如当数据极度不平衡时,可能需要考虑诸如 F1 分数、PR 曲线这样的指标。

### 4.3.2 实际案例中的评估指标应用

在实际案例中,评估指标的应用也需要考虑数据的特殊性。例如,在医学图像分析中,可能更关注模型的召回率,因为漏诊(假阴性)可能比误诊(假阳性)的后果更严重。在安全性要求高的应用中,精确度可能更重要,因为假阳性(误报)可能引起额外的成本和资源浪费。

在实际操作中,工程师应该根据应用需求和数据特征,灵活选择和调整评估指标,以确保模型在实际部署中能够达到预期的性能水平。

# 5. YOLOv8模型的未来展望

## 5.1 YOLOv8的发展趋势与挑战

### 5.1.1 新版本的改进和优势

YOLOv8作为YOLO系列的最新成员,在目标检测领域继续推动性能的提升。新版本在结构上做了重大的调整和优化,例如引入了更先进的网络架构,比如增加了注意力机制,以及改进了多尺度特征融合策略。这些改进让YOLOv8在维持高速度的同时,进一步提高了检测精度。

新版本同样在损失函数设计上进行了创新,这包括了对边界框回归和分类损失的改进,使得模型在面对遮挡、小目标等挑战性场景时表现出更好的鲁棒性。同时,YOLOv8还整合了端到端的训练流程,使得模型训练变得更加简单和高效。

代码示例:

```python

import torch

# 假设 model 是一个预训练的YOLOv8模型

# 下面的代码展示了如何使用模型进行一次前向传播的示例

model.eval()

with torch.no_grad():

inputs = torch.randn(1, 3, 640, 640) # 随机生成输入数据

outputs = model(inputs)

```

### 5.1.2 模型面临的挑战和解决方向

尽管YOLOv8取得了显著的成果,它仍然面临一些挑战。例如,模型在面对极端环境条件,如非常低光照或极端天气时,检测准确度会有明显的下降。此外,模型的通用性也是一个挑战,即如何在多个不同的任务和领域中保持一致的高准确度。

解决这些挑战的方向可能包括增强模型的环境适应能力,通过数据增强、模型训练策略和损失函数优化来改善。另外,继续推动模型的小型化和轻量化也是重要方向,使其能够在边缘设备上运行,这将有助于减少计算资源的依赖并扩展其应用场景。

## 5.2 深度学习在目标检测领域的影响

### 5.2.1 深度学习技术的进步对目标检测的影响

深度学习技术的进步深刻地改变了目标检测的面貌。通过使用卷积神经网络(CNN),目标检测模型能够自动提取和学习丰富的特征表示,极大地提升了检测的准确性和鲁棒性。近年来,随着Transformer等新型架构的引入,目标检测技术在提取长距离依赖关系方面取得了突破,能够更好地处理复杂场景和小目标的检测。

### 5.2.2 未来研究方向和潜力领域

未来目标检测领域的研究可能会集中在以下几个方向:

- **跨模态检测**:结合视觉、雷达、激光等不同传感器信息进行目标检测。

- **无监督或半监督学习**:通过减少对大量标注数据的依赖来降低人工成本。

- **实时检测和跟踪**:增强模型的实时性,实现更快速的检测与跟踪。

- **模型泛化能力**:提高模型在不同领域和任务中的泛化能力。

## 5.3 mAP在深度学习评估中的长远角色

### 5.3.1 mAP作为评估标准的持续重要性

mAP作为目标检测领域中一个主流的性能评估指标,其重要性在未来很长一段时间内都不会减弱。mAP提供了一种在多个类别之间进行公平比较的方法,并且能够直观反映模型在不同阈值下的检测性能。即便随着技术的发展,可能会出现新的评估指标,但mAP因其综合性强和易于理解,预计仍会是评估标准的核心组成部分。

### 5.3.2 mAP计算方法的未来发展和优化

随着深度学习技术的不断进步,mAP计算方法本身也可能发生变化。例如,针对极端不平衡数据集,未来可能会提出更加精确的采样和加权方案来优化mAP的计算。同时,随着计算能力的提升,mAP的计算可能会采用更加复杂的算法,以提高评估的准确性,比如在计算召回率时考虑不同IOU阈值下的综合性能。

随着深度学习框架和硬件的发展,mAP的计算效率也可能得到提升,使其能够在更大规模的数据集和更复杂的模型上进行快速计算。这将为研究人员和工程师提供一个更加高效和准确的性能评估工具。

0

0