【OpenCV图像处理秘籍】:从入门到精通,掌握图像处理核心技术

发布时间: 2024-08-05 12:30:48 阅读量: 16 订阅数: 24

# 1. OpenCV图像处理简介**

OpenCV(Open Source Computer Vision Library)是一个开源的计算机视觉库,提供广泛的图像处理和计算机视觉算法。它广泛应用于图像处理、计算机视觉、机器学习和增强现实等领域。

OpenCV由C++编写,具有跨平台兼容性,支持Windows、Linux、macOS和移动操作系统。它提供了一系列易于使用的函数和类,使开发人员能够轻松地构建图像处理和计算机视觉应用程序。

OpenCV图像处理涉及使用算法和技术来增强、分析和修改图像。这些算法包括图像增强、图像分割、目标检测、特征提取和机器学习。通过使用OpenCV,开发人员可以创建强大的图像处理应用程序,用于各种应用,例如医疗成像、工业自动化和无人驾驶汽车。

# 2.1 图像数据结构和操作

### 2.1.1 图像的表示和存储

图像在计算机中表示为一个多维数组,其中每个元素代表图像中一个像素的强度值。最常见的图像表示形式是灰度图像和彩色图像。

**灰度图像**仅包含一个通道,表示像素的亮度值。其范围通常为 0(黑色)到 255(白色)。

**彩色图像**包含三个通道:红色 (R)、绿色 (G) 和蓝色 (B)。每个通道表示像素中相应颜色的强度值。彩色图像通常表示为 RGB 图像或 BGR 图像(BGR 是蓝、绿、红的顺序)。

图像可以存储在各种文件格式中,例如 JPEG、PNG、BMP 和 TIFF。每种格式都有其优点和缺点,例如文件大小、图像质量和支持的特性。

### 2.1.2 图像的读写和转换

OpenCV 提供了广泛的函数来读取和写入图像文件。以下是一些常用的函数:

```python

import cv2

# 读取图像

img = cv2.imread('image.jpg')

# 写入图像

cv2.imwrite('output.jpg', img)

# 转换图像格式

img = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY) # 将彩色图像转换为灰度图像

```

**参数说明:**

* `cv2.imread(filename)`:读取图像文件并返回一个 NumPy 数组。

* `cv2.imwrite(filename, img)`:将图像数组写入文件。

* `cv2.cvtColor(img, code)`:转换图像的色彩空间。`code` 指定转换类型,例如 `cv2.COLOR_BGR2GRAY`。

**代码逻辑分析:**

1. `cv2.imread()` 函数读取图像文件并将其存储在 `img` 变量中。

2. `cv2.cvtColor()` 函数将图像从 BGR 色彩空间转换为灰度色彩空间,并将其存储回 `img` 变量中。

3. `cv2.imwrite()` 函数将转换后的图像写入 `output.jpg` 文件中。

# 3.1 图像分割和目标检测

图像分割是将图像划分为不同区域或对象的过程,目标检测则是识别和定位图像中特定对象的子任务。这两项技术在计算机视觉中至关重要,广泛应用于图像分析、医疗成像和自动驾驶等领域。

#### 3.1.1 图像分割算法

图像分割算法可分为两大类:基于区域的算法和基于边缘的算法。

**基于区域的算法**将图像视为一系列相邻区域,并根据相似性(例如颜色、纹理或强度)将像素分组到这些区域中。常见的基于区域的算法包括:

- **区域生长算法:**从种子点开始,逐步将具有相似特征的像素添加到区域中。

- **分水岭算法:**将图像视为地形,将像素视为水滴,并根据梯度信息将水滴分配到不同的流域中。

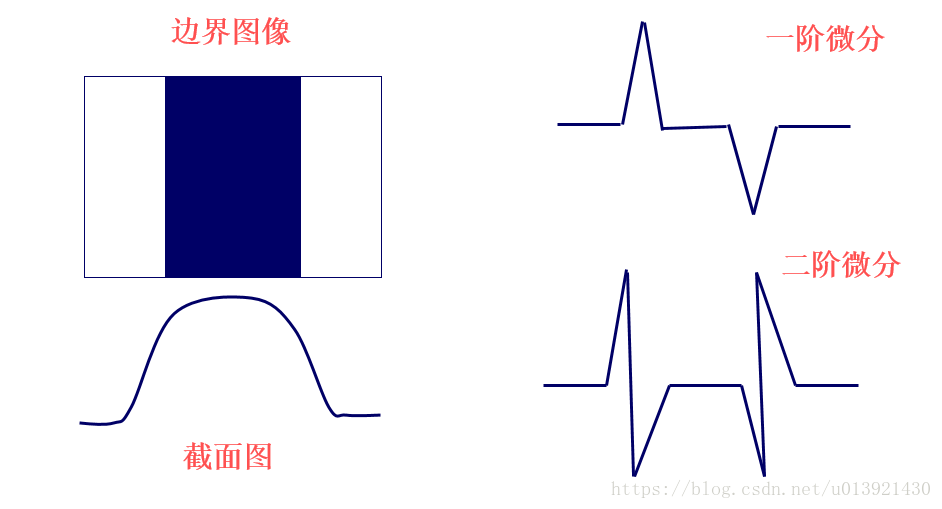

**基于边缘的算法**检测图像中的边缘,然后根据边缘将图像分割成不同的区域。常见的基于边缘的算法包括:

- **Canny边缘检测:**使用高斯滤波器平滑图像,然后使用Sobel算子检测边缘。

- **Hough变换:**通过在参数空间中查找直线或圆等形状的峰值来检测边缘。

#### 3.1.2 目标检测技术

目标检测技术用于识别和定位图像中特定对象的边界框。常见的目标检测技术包括:

**滑动窗口方法:**在图像中滑动一个固定大小的窗口,并使用分类器对窗口中的内容进行分类。

**区域建议网络(R-CNN):**使用预训练的卷积神经网络(CNN)生成候选区域,然后对这些区域进行分类和边界框回归。

**YOLO(You Only Look Once):**使用单次卷积网络同时预测目标的边界框和类别。

**Mask R-CNN:**在R-CNN的基础上增加了分割分支,可以生成目标的像素级掩码。

**代码示例:**

```python

import cv2

# 使用Canny边缘检测算法检测边缘

edges = cv2.Canny(image, 100, 200)

# 使用轮廓查找算法找到边缘上的轮廓

contours, _ = cv2.findContours(edges, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

# 绘制轮廓

cv2.drawContours(image, contours, -1, (0, 255, 0), 2)

# 显示图像

cv2.imshow("Image with Contours", image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

**逻辑分析:**

此代码使用Canny边缘检测算法检测图像中的边缘,然后使用轮廓查找算法找到边缘上的轮廓。最后,将轮廓绘制在图像上并显示图像。

**参数说明:**

- `image`:输入图像。

- `100` 和 `200`:Canny边缘检测算法中的两个阈值。

- `cv2.RETR_EXTERNAL`:轮廓查找算法中的模式,表示只查找外部轮廓。

- `cv2.CHAIN_APPROX_SIMPLE`:轮廓查找算法中的近似方法,表示使用简单近似。

- `(0, 255, 0)`:轮廓绘制的颜色。

- `2`:轮廓绘制的厚度。

# 4.1 图像配准和拼接

### 4.1.1 图像配准算法

图像配准是指将两幅或多幅图像对齐到同一坐标系中的过程,以便进行比较、分析或融合。在计算机视觉中,图像配准是一个基本任务,广泛应用于图像拼接、立体视觉和医疗影像等领域。

图像配准算法通常分为两类:基于特征的算法和基于区域的算法。

**基于特征的算法**通过提取图像中的特征点(如角点、边缘或纹理),然后匹配这些特征点来对齐图像。常用的基于特征的算法包括:

- **尺度不变特征变换 (SIFT)**:SIFT 算法提取图像中的关键点并计算其描述符,然后通过描述符匹配来配准图像。

- **加速稳健特征 (SURF)**:SURF 算法与 SIFT 类似,但计算速度更快,适用于实时应用。

- **二元模式 (ORB)**:ORB 算法提取图像中的二进制模式,并通过汉明距离匹配来配准图像。

**基于区域的算法**通过计算图像区域之间的相似性来配准图像。常用的基于区域的算法包括:

- **互相关 (CC)**:CC 算法计算两幅图像对应区域的互相关值,并通过最大互相关值来确定图像的最佳配准位置。

- **归一化互相关 (NCC)**:NCC 算法对 CC 算法进行归一化,以减少图像亮度变化的影响。

- **相位相关 (PC)**:PC 算法计算两幅图像傅里叶变换之间的相位差,并通过相位差来确定图像的配准位置。

### 4.1.2 图像拼接技术

图像拼接是指将两幅或多幅图像拼接成一幅全景图像的过程。图像拼接技术在计算机视觉、虚拟现实和无人机航拍等领域有着广泛的应用。

图像拼接算法通常分为两步:

1. **图像配准**:首先需要对需要拼接的图像进行配准,以确保它们在同一坐标系中。

2. **图像融合**:将配准后的图像融合成一幅全景图像。

图像融合技术主要有两种:

- **平均融合**:对重叠区域的像素进行平均,以生成融合后的图像。

- **加权平均融合**:根据重叠区域的像素权重进行加权平均,以生成融合后的图像。

### 代码示例

以下代码示例展示了如何使用 OpenCV 中的 SIFT 算法对两幅图像进行配准:

```python

import cv2

# 读入两幅图像

img1 = cv2.imread('image1.jpg')

img2 = cv2.imread('image2.jpg')

# 创建 SIFT 特征检测器和描述符提取器

sift = cv2.SIFT_create()

# 检测和提取特征点

keypoints1, descriptors1 = sift.detectAndCompute(img1, None)

keypoints2, descriptors2 = sift.detectAndCompute(img2, None)

# 匹配特征点

bf = cv2.BFMatcher()

matches = bf.knnMatch(descriptors1, descriptors2, k=2)

# 筛选匹配点

good_matches = []

for m, n in matches:

if m.distance < 0.75 * n.distance:

good_matches.append(m)

# 计算变换矩阵

H, _ = cv2.findHomography(np.array([keypoints1[m.queryIdx].pt for m in good_matches]),

np.array([keypoints2[m.trainIdx].pt for m in good_matches]), cv2.RANSAC, 5.0)

# 透视变换

warped_img = cv2.warpPerspective(img1, H, (img2.shape[1] + img1.shape[1], img2.shape[0]))

# 融合图像

fused_img = cv2.addWeighted(warped_img, 0.5, img2, 0.5, 0)

# 显示结果

cv2.imshow('Fused Image', fused_img)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

### 逻辑分析和参数说明

- `cv2.SIFT_create()`:创建 SIFT 特征检测器和描述符提取器。

- `detectAndCompute()`:检测和提取特征点。

- `knnMatch()`:匹配特征点。

- `findHomography()`:计算变换矩阵。

- `warpPerspective()`:透视变换。

- `addWeighted()`:融合图像。

### 扩展性说明

图像配准和拼接技术在计算机视觉中有着广泛的应用,可以进一步扩展和优化:

- **多幅图像配准**:扩展图像配准算法以处理多幅图像。

- **图像融合优化**:探索新的图像融合技术以提高拼接图像的质量。

- **GPU 加速**:利用 GPU 加速图像配准和拼接算法以提高性能。

# 5.1 图像处理算法的优化

在实际应用中,图像处理算法的性能至关重要。为了满足实时处理和处理大规模图像的需求,需要对算法进行优化。

### 5.1.1 并行化和加速技术

并行化是优化图像处理算法的一种有效方法。通过将算法分解成多个独立的任务,并行执行这些任务,可以显著提高处理速度。OpenCV提供了多种并行化技术,包括:

- **OpenMP:**一种基于共享内存的并行编程模型,允许在多核处理器上并行执行代码。

- **CUDA:**一种基于图形处理单元(GPU)的并行编程模型,可利用GPU的并行计算能力。

- **OpenCL:**一种跨平台的并行编程模型,支持在各种硬件平台上并行执行代码。

### 5.1.2 内存和资源管理

图像处理算法通常需要处理大量数据,因此内存和资源管理至关重要。优化内存和资源管理可以减少内存消耗,提高算法效率。以下是一些优化技巧:

- **使用高效的数据结构:**选择适合图像处理任务的数据结构,例如NumPy数组或OpenCV矩阵,可以减少内存消耗和提高访问速度。

- **避免不必要的内存分配:**在算法中避免频繁的内存分配,可以通过重用变量或使用内存池来减少内存消耗。

- **释放未使用的资源:**在算法完成后,及时释放未使用的内存和资源,防止内存泄漏。

0

0