Python Queue库使用误区:常见问题诊断与解决策略

发布时间: 2024-10-11 06:10:33 阅读量: 47 订阅数: 26

# 1. Python Queue库基础

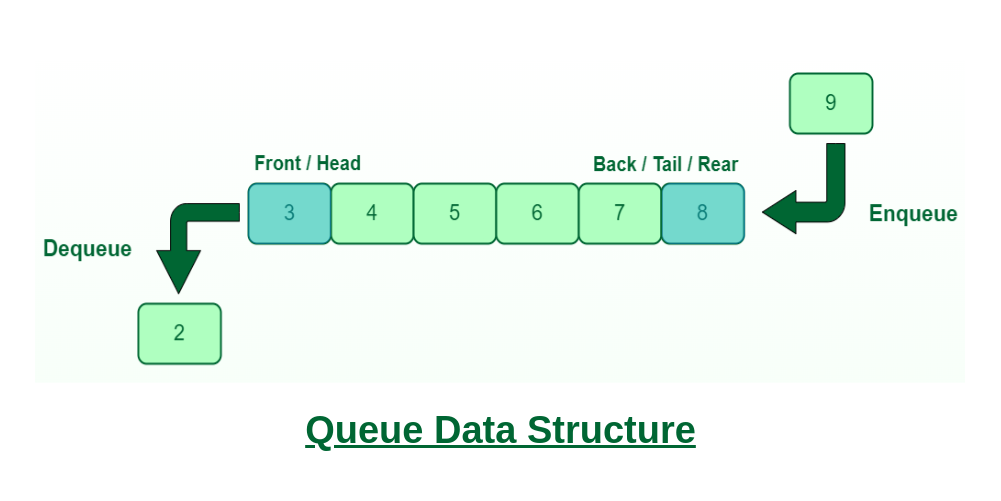

在编程世界中,队列是一种先进先出(FIFO)的数据结构,广泛用于任务调度、缓存和进程间通信等场景。Python的Queue库提供了一个实现线程安全队列的先进平台,支持多进程、多线程间的高效数据交换。在深入探索Queue库的高级应用和常见误区之前,本章将为读者介绍Queue库的基本用法,包括队列的创建、数据项的入队(put)和出队(get)操作,以及如何设置队列的大小限制等。通过本章内容,读者将对Python Queue库有初步的了解,并为进一步探索其高级功能打下坚实的基础。

```python

import queue

# 创建一个FIFO队列

q = queue.Queue(maxsize=0) # maxsize为0代表队列大小无限制

# 入队操作

q.put('item') # 将 'item' 放入队列

# 出队操作

item = q.get() # 从队列中取出 'item'

```

在上述代码中,我们创建了一个默认大小的队列,并演示了如何向队列添加和检索数据项。这仅仅是Queue库提供的众多功能中的一小部分,更多高级特性将在后续章节中详细探讨。

# 2. Queue库使用中的常见误区

在多线程编程中,Queue库是Python标准库提供的一个用于线程间安全通信的工具。虽然Queue库使用起来较为直观,但不少开发者在使用过程中常常会陷入一些常见的误区。本章将逐一解析这些误区,并提供正确的使用方法。

## 2.1 线程安全与队列选择的误区

### 2.1.1 线程安全的误解

在多线程编程中,一个核心的问题就是数据的线程安全。许多开发者认为只要使用了Queue库,所有的线程安全问题就迎刃而解了。但实际上,Queue库所提供的线程安全是指队列内部操作的原子性,并不能保证外部数据的线程安全。

- **误解案例**:例如,在向队列中放入数据的同时对某个外部变量进行修改,外部变量的修改并不是队列操作的一部分,因此不受Queue库保护。

- **正确理解**:应当理解为Queue库对每个独立的队列操作(put, get等)是线程安全的,但在操作队列的同时如果还有其他非原子操作,则需要额外的锁机制来保证线程安全。

### 2.1.2 队列类型的错误选择

Python的Queue库提供了多种类型的队列,包括`Queue`, `LifoQueue`, `PriorityQueue`等。开发者在选择队列类型时,有时会因为对各种队列特性的理解不够深入而导致选择不当。

- **误区**:例如,选择使用`PriorityQueue`来实现简单的FIFO(先进先出)队列,其实完全可以用`Queue`代替,因为`PriorityQueue`会增加不必要的排序开销。

- **正确选择**:应根据实际的应用需求来选择合适的队列类型。如果只是需要FIFO队列,就直接使用`Queue`;如果需要按照特定顺序取出数据,再考虑使用`LifoQueue`或`PriorityQueue`。

## 2.2 队列操作的错误使用

### 2.2.1 队列阻塞机制的误用

`put`和`get`方法默认都会阻塞,直到队列中的操作可以成功执行。一些开发者会误用这个阻塞机制,导致程序在某些情况下长时间停滞。

- **误用案例**:在某些情况下,开发者可能没有考虑到极端情况,比如队列已满或为空,程序就会被无限期地阻塞。

- **正确使用**:应当使用`put`和`get`方法的超时参数,为阻塞操作设置一个时间限制,避免程序长时间等待。

### 2.2.2 队列超时参数的不当设置

队列操作的超时参数是一个重要的设置,但开发者有时会因为对其理解不足而设置不当。

- **不当设置案例**:例如,设置一个过短的超时时间,导致在数据处理速度较快时,队列操作频繁超时,影响性能;或者设置一个过长的超时时间,导致程序响应速度降低。

- **合适设置**:合理设置超时参数,需要根据实际的业务场景和性能需求来定。比如在高吞吐量的场景下,可以适当降低超时时间以保证响应速度。

## 2.3 队列在进程间通信的问题

### 2.3.1 进程间共享队列的风险

使用Queue库进行进程间通信时,一些开发者可能会尝试直接共享队列。然而,这样做可能会带来一些潜在风险。

- **风险点**:共享队列可能会导致竞争条件,尤其是在多个进程同时写入或读取队列时。

- **解决方案**:应当使用`multiprocessing.Queue`,这是专为进程间通信设计的队列类型,可以避免上述问题。

### 2.3.2 多进程队列同步的误操作

在使用多进程队列时,正确的同步机制是确保数据一致性的关键。但开发者有时会忽略或者错误使用同步机制。

- **误操作案例**:一些开发者可能会认为`multiprocessing.Queue`已经处理了所有同步问题,但实际上还需要考虑跨进程的异常处理和状态同步。

- **正确操作**:在使用`multiprocessing.Queue`时,应当使用`task_done()`和`join()`方法来确保所有任务都完成,避免因为进程的提前退出导致队列操作未完成。

以上就是Queue库使用中的一些常见误区,了解并避免这些误区,可以帮助开发者更加高效和安全地使用Python Queue库。接下来的章节将介绍Queue库的高级应用,帮助读者深入理解和运用Queue库。

# 3. Queue库的高级应用

## 3.1 队列的条件变量与事件控制

### 3.1.1 条件变量的使用技巧

在并发编程中,条件变量是一种同步原语,允许线程由于某些条件未满足而被挂起,直到其他线程改变状态并发出通知。Python的`Queue`库提供了一种简单的机制来实现条件变量的同步。`Condition`对象可以用于控制线程的执行,尤其是在多个线程需要等待某个条件为真时。

条件变量的核心是`wait()`和`notify()`方法。`wait()`方法会挂起当前线程直到其他线程调用`notify()`或`notify_all()`方法。这通常与队列中的特定状态一起使用,例如,一个工作线程可能需要等待任务队列中出现新任务。

下面是一个使用条件变量的例子:

```python

from threading import Thread, Condition

from queue import Queue

def worker(task_queue: Queue, cond: Condition):

while True:

# 任务队列中取任务

task = task_queue.get()

if task is None:

break

# 处理任务

print(f"Processing task: {task}")

# 完成任务后通知其他线程

with cond:

cond.notify()

def add_tasks(task_queue: Queue, cond: Condition):

for i in range(5):

task_queue.put(f"Task #{i}")

# 当任务分配完毕后,通知工作者线程

with cond:

cond.notify_all()

# 创建条件变量和任务队列

condition = Condition()

task_queue = Queue()

# 创建并启动工作者线程

worker_thread = Thread(target=worker, args=(task_queue, condition))

worker_thread.start()

# 创建任务添加者线程

add_thread = Thread(target=add_tasks, args=(task_queue, condition))

add_thread.start()

add_thread.join() # 等待任务分配线程结束

task_queue.put(None) # 停止工作者线程

task_queue.join() # 等待工作者线程结束

```

在上面的代码中,我们使用了条件变量来确保任务队列在工作者线程处理任务时能够被正确地通知和同步。

### 3.1.2 事件控制在队列中的应用

事件控制是一种简单线程同步机制,常用于处理线程间的协作。Python的`threading`模块提供了`Event`类来创建事件对象。事件可以处于两种状态:未通知和已通知。`set()`方法将事件设置为已通知状态,而`clear()`方法则将其重置为未通知状态。`wait()`方法则会阻塞当前线程直到事件被设置为已通知状态。

事件在队列中的应用包括控制线程的启动和停止,或者线程间的其他信号传递。例如,我们可以使用事件来告诉工作者线程何时开始工作或何时停止。

```python

from threading import Thread, Event, Lock

from queue import Queue

def worker(task_queue: Queue, stop_event: Event, task_lock: Lock):

while not stop_event.is_set():

task = task_queue.get()

if task is None:

break

# 使用锁来保护任务处理代码

with task_lock:

print(f"Processing task: {task}")

task_queue.task_done

```

0

0