递推最小二乘法的快速实现:专家分享的算法加速秘诀

发布时间: 2025-01-03 12:40:28 阅读量: 8 订阅数: 14

# 摘要

递推最小二乘法是一种重要的参数估计方法,它在工程控制、经济预测与数据分析等领域有广泛应用。本文首先概述了递推最小二乘法的基本概念和理论基础,深入分析了其数学模型、递推公式的推导过程、收敛性和稳定性。然后,本文探讨了算法实现的细节优化,包括代码实现和数值稳定性及误差分析。此外,本文通过具体的应用案例,展示了递推最小二乘法在工程控制系统和经济预测中的实际应用效果。最后,本文探讨了递推最小二乘法的高级技巧,并对其未来发展趋势和面临的主要挑战进行了展望,提出了与机器学习结合以及处理大数据的新思路。

# 关键字

递推最小二乘法;理论基础;数学模型;数值稳定性;误差分析;算法优化;大数据

参考资源链接:[递推最小二乘法(RLS)原理与算法实现](https://wenku.csdn.net/doc/74fvtcsfwj?spm=1055.2635.3001.10343)

# 1. 递推最小二乘法概述

递推最小二乘法(Recursive Least Squares, RLS)是参数估计和系统辨识中一种强大且灵活的算法。它在实时系统建模、信号处理及控制系统中扮演着重要角色。RLS通过不断递推更新参数估计,提供了比传统最小二乘法更快的收敛速度和更好的跟踪性能,尤其适用于模型参数随时间变化的场合。

## 1.1 算法特点

RLS算法的主要特点是其能够快速适应系统动态变化,并且在噪声存在的条件下也能给出较为准确的参数估计。与批处理最小二乘法相比,RLS不需要存储大量的历史数据,减少了计算和存储的负担,特别适合实时或近实时处理。

## 1.2 算法应用

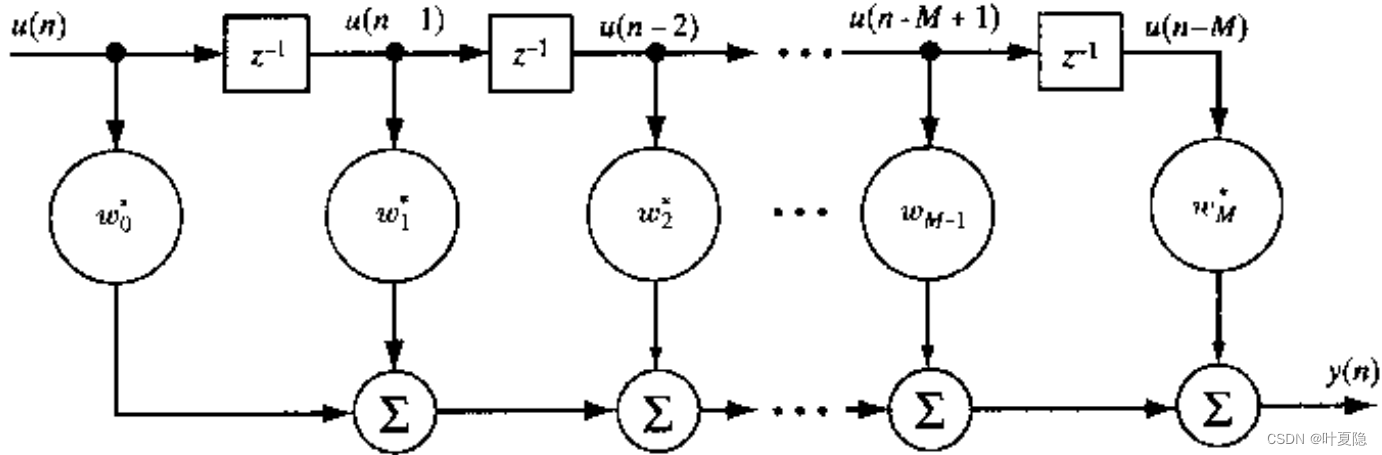

递推最小二乘法广泛应用于通信、信号处理、控制工程等领域。例如,它可以用于自适应滤波器的设计,动态系统参数的在线估计,以及各种形式的时间序列分析中。RLS的灵活性和效率使其成为众多工程师和研究人员在面对迭代数据处理任务时的首选工具。

```mermaid

graph LR

A[系统输入] -->|实时数据流| B[递推最小二乘法]

B -->|参数估计| C[系统输出]

C -->|模型更新| B

```

在下一章节中,我们将深入探讨RLS的理论基础和数学模型,为理解算法的内部工作原理和实现细节打下坚实的基础。

# 2. 理论基础与数学模型

## 2.1 递推最小二乘法的基本原理

### 2.1.1 最小二乘法的概念

最小二乘法是一种数学优化技术,它通过最小化误差的平方和来寻找数据的最佳函数匹配。它广泛应用于统计学、信号处理和工程问题中,用于拟合曲线、估计未知参数以及建立模型。最小化的目标函数通常是误差平方和,这使得它能够减少较大误差对结果的影响,提高模型的稳健性。

### 2.1.2 递推最小二乘法的数学描述

递推最小二乘法(Recursive Least Squares, RLS)是一种动态数据处理的算法,它能够连续地更新模型参数,而不需要重新处理整个数据集。RLS的核心思想是利用先前的估计结果和新的观测数据来递推地计算新的参数估计值。数学上,RLS通过解决如下优化问题:

\[

\min_{\theta}\sum_{i=1}^{n} \lambda^{n-i} \cdot \left( y(i) - \theta \cdot x(i) \right)^2

\]

这里,\(y(i)\) 是第 \(i\) 个观测值,\(x(i)\) 是相应的输入,\(\theta\) 是需要估计的参数,\(\lambda\) 是遗忘因子,用于控制旧数据的重要性。

## 2.2 递推最小二乘法的数学推导

### 2.2.1 递推公式的推导过程

递推最小二乘法的基本思想是利用已有的估计值来递推计算新的估计值,以最小化均方误差。假设系统动态模型可以表示为:

\[

y(k) = \theta^T(k-1)x(k) + e(k)

\]

其中,\(e(k)\) 是误差项,\(\theta(k-1)\) 是上一时刻参数的估计值,\(x(k)\) 是新的输入数据向量,\(y(k)\) 是新的观测输出。RLS算法的目标是找到一组参数 \(\theta\),使得代价函数 \(J(k)\) 最小化:

\[

J(k) = \sum_{i=1}^{k} \lambda^{k-i}e^2(i)

\]

递推公式由两个主要步骤组成:预测步骤和更新步骤。在预测步骤中,使用已知的参数和输入数据预测当前时刻的输出。在更新步骤中,使用新数据来更新参数估计,使其更接近真实参数。

### 2.2.2 收敛性和稳定性分析

递推最小二乘法的收敛性和稳定性是评估算法性能的关键指标。收敛性意味着算法能够随时间接近真实参数值;稳定性则表明算法在面对数值计算误差时仍能保持良好的性能。

对于RLS算法来说,遗忘因子\(\lambda\)的选择至关重要。当\(0 < \lambda \leq 1\)时,算法具有遗忘旧数据的能力,从而能够适应时间变化的系统。理论上,如果输入数据\(x(k)\)是非奇异的,并且遗忘因子选择得当,RLS算法能够保证参数估计的收敛性和稳定性。遗忘因子越接近1,算法越重视旧数据,收敛速度越慢;遗忘因子越小,算法对新数据的响应越快,但可能会导致不稳定的参数估计。

为了达到快速收敛和良好的稳定性,通常需要进行参数的精细调整和适当的初始化。初始化权重通常可以从一个小的正值开始,或者使用一种称为初始化遗忘的方法,从一个较高的\(\lambda\)值开始,并逐渐减少\(\lambda\)至目标值以实现快速收敛。

\[

\begin{aligned}

\mathbf{P}(k) &= \mathbf{P}(k-1) - \mathbf{P}(k-1)x(k)\left[\lambda + x(k)^T\mathbf{P}(k-1)x(k)\right]^{-1}x(k)^T\mathbf{P}(k-1) \\

\theta(k) &= \theta(k-1) + \mathbf{P}(k)x(k)\left[y(k) - x(k)^T\theta(k-1)\right]

\end{aligned}

\]

其中,\(\mathbf{P}(k)\)是协方差矩阵,\(\theta(k)\)是参数估计值。上述的递推公式展示了从\(k-1\)时刻到\(k\)时刻的参数更新过程。

为了加深理解,接下来我们将通过一个简单的例子来展示RLS算法的实现

0

0