安全第一:Hadoop NameNode安全性分析与最佳保护实践

发布时间: 2024-10-30 05:21:13 阅读量: 32 订阅数: 40

Hadoop环境安全加固1

# 1. Hadoop NameNode简介

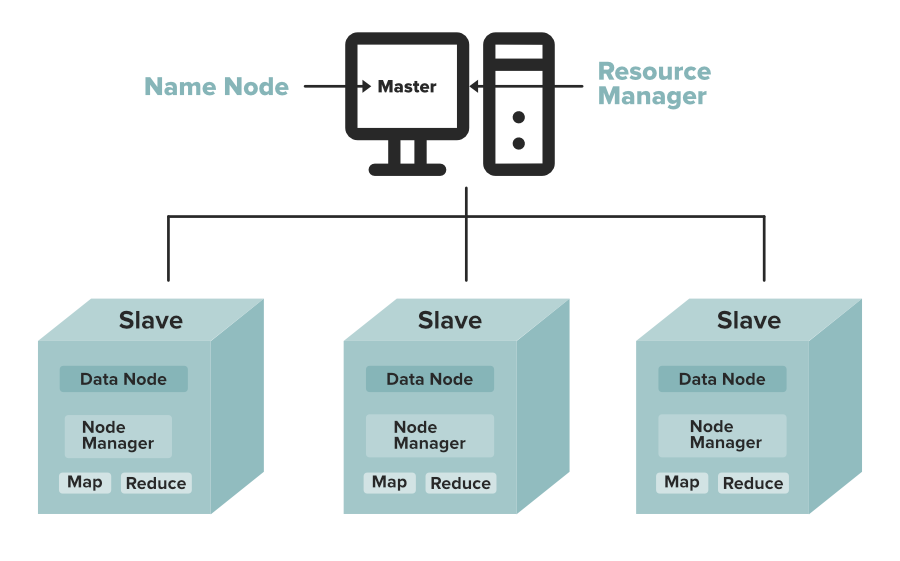

Hadoop NameNode是分布式存储系统HDFS的核心组件,承担着元数据管理和协调的角色。在本章中,我们将探索NameNode的基本工作原理和重要性,为读者深入理解后续章节打下坚实的基础。

## 1.1 NameNode的作用

NameNode作为Hadoop分布式文件系统(HDFS)的主节点,负责存储文件系统的命名空间和客户端访问控制。它记录了每个文件中各个块所在的DataNode节点,并维护了整个文件系统的树状目录结构。

## 1.2 NameNode的架构设计

在架构上,NameNode通过维护一个称为FsImage的数据结构来保存文件系统命名空间的持久性快照。同时,它还有一个日志文件,称为EditLog,用来记录所有的文件系统修改操作。

## 1.3 NameNode的高可用性问题

由于NameNode是HDFS的单点故障所在,高可用性(HA)成为Hadoop设计中必须解决的问题。本章将简要介绍HA的实现方式,包括主备NameNode和ZooKeeper的应用。

## 1.4 NameNode的扩展性挑战

随着数据量的增长,单一NameNode逐渐不能满足大规模集群的需求。因此,本章还将探讨如何通过NameNode Federation等技术来提升系统的扩展性。

本章介绍了NameNode的基本概念和架构,为理解其安全性和配置打下基础。接下来的章节将深入探讨如何增强NameNode的安全性,以及如何进行有效的安全配置。

# 2. NameNode安全性原理

## 2.1 NameNode的关键安全组件

### 2.1.1 安全模式和权限控制

Hadoop NameNode在管理HDFS文件系统中扮演着至关重要的角色,它不仅存储了文件系统的元数据,还负责处理客户端的请求并协调DataNode节点的运行。为了保证HDFS的安全稳定运行,NameNode实施了多层次的安全机制,其中包括安全模式和权限控制。

安全模式指的是NameNode启动或重启后的一段时间内,处于只读状态,不允许对文件系统的元数据进行写操作。这是为了确保在NameNode从多个DataNode获取必要的状态信息,完成对文件系统的一致性检查之前,防止写操作对系统造成潜在的不一致。只有通过一系列自检,并且确认元数据的一致性达到预设的阈值后,NameNode才会退出安全模式,开始正常的服务。

权限控制则是对访问HDFS的用户进行身份验证和授权管理。每个用户和进程对HDFS的访问权限被严格控制,以确保数据的安全性。NameNode根据预设的权限策略,来判断用户是否有权限进行读、写、执行等操作。此外,通过设置ACL(Access Control Lists,访问控制列表)可以对特定的用户或组进行更细致的权限管理。

权限控制的实现依赖于Hadoop的认证机制,这包括对用户身份的验证,以及对客户端请求的授权检查。用户在访问HDFS资源之前,需要通过认证机制证明自己的身份,认证过程可以是简单的用户名和密码,也可以是更安全的Kerberos认证。一旦身份验证成功,NameNode会根据预定义的权限策略授权用户对文件系统的访问。

### 2.1.2 NameNode与DataNode的认证机制

在Hadoop集群中,NameNode与DataNode之间的通信必须是安全的,以防止恶意节点的伪造和攻击。为了实现这一点,Hadoop采用了基于共享密钥的认证机制,确保了只有认证过的DataNode节点才能向NameNode发送信息,并接收来自NameNode的指令。

这个过程涉及到一系列的认证措施,包括对通信双方的身份验证和数据的加密传输。当一个DataNode节点启动并尝试加入Hadoop集群时,它会首先向NameNode发送一个认证请求。NameNode会利用预先设定的密钥对请求进行验证。成功验证后,DataNode和NameNode之间的通信就建立了。

这种认证机制的关键在于密钥的管理和分配。在较新版本的Hadoop中,推荐使用Kerberos认证机制来增强安全性。Kerberos是一种网络认证协议,它允许节点之间在不安全的网络中进行安全的认证与通信。通过Kerberos,Hadoop可以确保即便是数据在传输过程中被截获,攻击者也无法解密或篡改数据。

综上所述,Hadoop NameNode的安全性不仅依赖于单一的机制,而是一个由多个组件构成的综合系统。安全模式和权限控制确保了数据的不可篡改和操作的合法性,而NameNode与DataNode之间的认证机制则确保了集群内部通信的安全。这些组件共同为Hadoop NameNode构建了一个坚固的安全防线。

## 2.2 安全漏洞分析

### 2.2.1 常见的攻击手段

随着Hadoop技术的广泛应用,其安全漏洞也随之成为攻击者的目标。了解常见的攻击手段对于设计和实施有效的安全防护策略至关重要。常见的攻击手段包括:

1. **权限提升攻击**:攻击者利用系统配置不当或系统漏洞,获取更高的权限,执行原本无权执行的操作。例如,通过某个服务漏洞获取了Hadoop集群管理者的权限,从而能够对整个集群进行操作。

2. **数据泄露**:攻击者获取了敏感数据的访问权限,或者在数据传输过程中截获未加密的数据。数据泄露往往会导致严重的隐私和安全问题。

3. **服务拒绝攻击(DoS/DDoS)**:通过向服务发起大量无用的请求,消耗资源使服务不可用。针对Hadoop集群的DoS攻击可能导致NameNode和DataNode节点过载,影响集群服务的正常运行。

4. **中间人攻击(MITM)**:攻击者在客户端和服务端之间截取并修改通信内容。在Hadoop集群中,如果攻击者能够在NameNode和DataNode之间的通信链路上实施MITM攻击,可能获取或篡改数据。

5. **API滥用**:Hadoop集群提供的API如果没有得到适当的限制和监控,可能会被攻击者利用来进行恶意操作。

对于这些攻击手段,Hadoop社区已经开发了多种安全机制来应对。其中,例如集群角色的严格权限管理、网络通信的数据加密、对服务访问的严格控制、定期的安全审计和漏洞扫描等。

### 2.2.2 漏洞发现与评估

漏洞的发现是防止攻击的第一步,也是构建Hadoop集群安全性的关键环节。对于发现的漏洞,进行准确的评估和分类,有助于后续制定相应的修复策略和安全措施。

**漏洞发现** 主要包括以下几种方式:

- **代码审计**:定期对Hadoop源代码进行审计,查找潜在的安全问题。这是最直接且有效的发现漏洞手段,能够捕捉到设计不当或编码错误引起的漏洞。

- **自动化工具扫描**:利用静态和动态的代码分析工具,自动化地扫描潜在的安全漏洞。例如,使用OWASP Top 10安全检查工具进行自动化扫描。

- **渗透测试**:模拟攻击者的视角,对Hadoop集群进行攻击测试,以发现运行中的系统漏洞。这通常需要专业知识,并且在测试过程中要确保不会对生产环境造成实际的损害。

**漏洞评估** 则需要对发现的漏洞进行分类和优先级排序,以确定哪些是最需优先解决的:

- **漏洞严重性**:根据漏洞可能导致的损害程度,可以将其分为高、中、低三个级别。高严重性的漏洞可能会直接导致数据泄露或服务中断,需要立即修复。

- **漏洞普遍性**:考虑到漏洞在不同的Hadoop版本中的存在情况,普遍存在的漏洞需要优先处理,以减少潜在的风险。

- **利用难度**:攻击者利用漏洞的难易程度也是评估的一个维度,那些易于被利用的漏洞需要得到及时的修复。

通过这样的漏洞发现与评估流程,组织可以建立起一套针对Hadoop集群的有效安全防护体系。及时发现并修复漏洞,能够显著降低集群遭受攻击的风险,保护数据和系统的安全稳定运行。

## 2.3 安全性的理论基础

### 2.3.1 加密技术与哈希函数

加密技术是Hadoop安全性的基石之一,它确保了数据的机密性和完整性。Hadoop使用多种加密方法来保护存储在集群中的数据和传输中的数据。

- **对称加密**:在对称加密中,加密和解密使用相同的密钥。这种加密方式速度快,适用于大量数据的加密。但密钥的安全分发和管理成为对称加密的一个主要挑战。

- **非对称加密**:非对称加密使用一对密钥,公钥用于加密数据,私钥用于解密。公钥可以公开,而私钥必须保密。非对称加密解决了密钥分发的问题,但加密和解密速度较慢,因此不适合对大量数据进行加密。

- **哈希函数**:哈希函数是一种单向加密算法,它将任意长度的数据转换为固定长度的哈希值,这个过程是不可逆的。哈希函数在验证数据完整性方面起着重要作用,即使数据内容仅发生微小的变化,其对应的哈希值也会发生显著变化。在Hadoop中,可以使用哈希函数来检测数据的篡改。

在Hadoop中,SSL/TLS协议常用于加密客户端与服务端之间的通信,以及NameNode和DataNode节点之间的数据传输。使用证书和密钥对,可以确保数据在传输过程中不会被窃听或篡改。同时,Hadoop还使用哈希函数来验证数据的完整性和正确性。

### 2.3.2 访问控制模型与策略

访问控制模型和策略是Hadoop安全性的另一个重要组成部分

0

0