人脸识别算法升级秘籍:性能优化,一网打尽

发布时间: 2024-09-06 15:44:49 阅读量: 33 订阅数: 63

【java毕业设计】智慧社区教育服务门户.zip

# 1. 人脸识别技术概述

人脸识别技术在当今世界已经无处不在,从手机解锁到机场安检,再到智能零售和安全监控,它正在逐步改变我们的生活。本章将介绍人脸识别技术的基本概念、发展历程以及其在现代社会中的重要应用。我们将探讨人脸识别如何工作,它所涉及的关键技术,以及它面临的挑战和未来的发展方向。

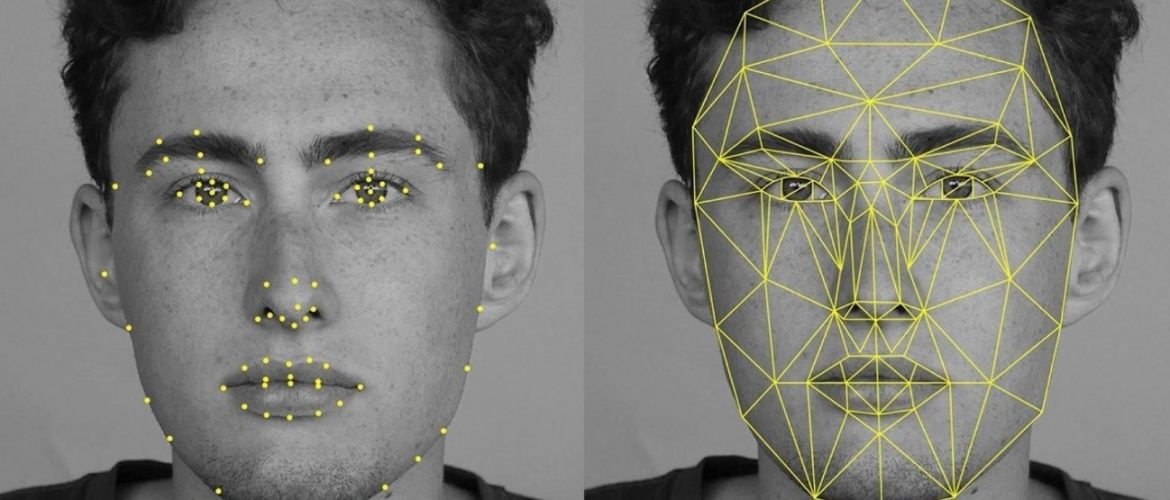

人脸识别技术的基本原理是利用计算机视觉和机器学习算法,自动从图像或视频中检测并识别出人脸。现代的人脸识别系统通常包括三个主要步骤:人脸检测、特征提取和特征匹配。首先,系统会定位图像中的脸;其次,提取人脸的关键特征;最后,将这些特征与数据库中存储的特征进行比较,以实现匹配。

虽然人脸识别技术的准确性和效率已经得到了显著的提升,但隐私保护和抗欺骗攻击等伦理和安全问题仍旧是其发展过程中不可回避的挑战。后续章节将会深入探讨这些问题以及人脸识别的未来趋势。

# 2. 人脸识别算法的基础理论

人脸识别算法是实现人脸识别系统的核心。本章将详细介绍人脸识别算法的基础理论,包括人脸检测、特征提取、特征匹配等关键步骤。

## 2.1 人脸检测算法的原理

### 2.1.1 人脸检测的经典方法

人脸检测作为人脸识别的第一步,主要是确定图像中人脸的位置和大小。经典的人脸检测方法有基于知识的方法、基于模板匹配的方法、以及基于特征的方法。

**基于知识的方法**依赖于人类的面部特征知识,例如眼睛、鼻子、嘴巴等。这类方法通常依赖于启发式规则,例如人脸通常具有一定的形状和比例关系。

```python

# 基于Haar特征的简单级联分类器用于人脸检测

import cv2

# 加载预训练的Haar特征分类器

face_cascade = cv2.CascadeClassifier(cv2.data.haarcascades + 'haarcascade_frontalface_default.xml')

# 读取图像

image = cv2.imread('path_to_image')

# 检测图像中的人脸

faces = face_cascade.detectMultiScale(image, scaleFactor=1.1, minNeighbors=5)

# 在检测到的人脸周围画矩形框

for (x, y, w, h) in faces:

cv2.rectangle(image, (x, y), (x+w, y+h), (255, 0, 0), 2)

# 显示图像

cv2.imshow('Face Detection', image)

cv2.waitKey(0)

```

该段代码使用了OpenCV库中的Haar特征分类器进行人脸检测。参数解释如下:

- `scaleFactor`:用于调整搜索窗口大小的系数。

- `minNeighbors`:在确定一个矩形框为有效人脸之前,所需的最小邻居数。

**基于模板匹配的方法**是通过将图像的每个可能区域与一个预定义的人脸模板进行比较来工作。这个模板可能是简单的灰度图像,也可能是更复杂的结构。

**基于特征的方法**则是在图像中寻找特定的面部特征,例如眼睛、鼻子、嘴巴的位置,然后根据这些特征的相对位置和形状来检测人脸。

### 2.1.2 人脸检测的深度学习方法

近年来,深度学习特别是卷积神经网络(CNN)在人脸检测领域取得了显著成就。深度学习方法可以自动从数据中学习人脸的高级特征,并且具有更高的准确性和鲁棒性。

深度学习模型通常使用大规模人脸数据集进行训练。在训练过程中,网络学习到了如何从图像中区分人脸和其他物体的复杂模式。例如,Faster R-CNN、YOLO和SSD等目标检测框架在人脸检测任务中表现突出。

```python

# 使用预训练的深度学习模型进行人脸检测

from mmdet.apis import init_detector, inference_detector

config_file = 'path_to_config_file'

checkpoint_file = 'path_to_checkpoint_file'

device = 'cuda:0' if torch.cuda.is_available() else 'cpu'

# 初始化检测器

model = init_detector(config_file, checkpoint_file, device=device)

# 进行检测

result = inference_detector(model, 'path_to_image')

# 可视化检测结果

model.show_result('path_to_image', result, out_file='detection_result.jpg')

```

在这段代码中,我们使用了MMDetection库中的`init_detector`和`inference_detector`函数来加载预训练的深度学习模型,并对一张图片进行人脸检测。模型的预测结果随后通过`show_result`函数进行可视化。

## 2.2 人脸特征提取技术

### 2.2.1 主成分分析(PCA)

主成分分析(PCA)是一种统计方法,它通过正交变换将可能相关的一组变量转换成一组线性不相关的变量,这些新变量称为主成分。在人脸特征提取中,PCA可以被用来降维并提取人脸图像的主要特征。

```python

from sklearn.decomposition import PCA

from sklearn.preprocessing import StandardScaler

import numpy as np

# 假设X是一个包含人脸图像的NumPy数组,每张图像都是一个行向量

X = np.array([...])

# 数据标准化

X_std = StandardScaler().fit_transform(X)

# 应用PCA进行特征提取

pca = PCA(n_components=0.95) # 保留95%的信息

X_pca = pca.fit_transform(X_std)

# 输出主成分的数量和降维后的数据

print("主成分数量:", pca.n_components_)

print("降维后的数据维度:", X_pca.shape)

```

在此代码中,首先使用`StandardScaler`对人脸数据进行标准化处理,随后用`PCA`提取了包含原始数据95%信息量的主成分。`n_components`参数决定了保留的主成分数量,`fit_transform`函数结合了拟合(学习)和转换(降维)的步骤。

### 2.2.2 线性判别分析(LDA)

线性判别分析(LDA)是一种监督学习的特征提取技术,用于找到最能区分不同类别的线性组合。LDA试图找到一个特征空间,使得在这个空间内,同类数据的方差最小,而类间数据的方差最大。

```python

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis as LDA

# 假设X是已经标准化过的人脸图像数据,y是对应的人脸类别标签

X = np.array([...])

y = np.array([...])

# 创建LDA模型

lda = LDA(n_components=1) # 假设我们想要降维到1维

# 拟合模型

lda.fit(X, y)

# 将数据投影到新的特征空间

X_lda = lda.transform(X)

# 输出降维后的数据维度和新特征空间的方向

print("降维后的数据维度:", X_lda.shape)

print("新特征空间的方向:", lda.explained_variance_ratio_)

```

在这段代码中,`LinearDiscriminantAnalysis`对象`lda`被用来执行LDA。`n_components`参数决定降维后的维度数。通过`fit`方法,我们使模型学习数据的线性判别特征,并通过`transform`方法将数据投影到新的特征空间。

### 2.2.3 深度学习在特征提取中的应用

随着深度学习技术的不断发展,基于神经网络的特征提取方法已经成为提取人脸特征的主流技术。卷积神经网络(CNN)因其出色的图像特征提取能力,在人脸特征提取方面有着非常优秀的表现。

```python

import torch

from torchvision import models

# 加载预训练的CNN模型,例如ResNet

model = models.resnet50(pretrained=True)

# 冻结所有层的权重以避免在微调时更新它们

for param in model.parameters():

param.requires_grad = False

# 替换最后的全连接层以适配特定的输出大小

model.fc = torch.nn.Linear(model.fc.in_features, num_classes)

# 将模型移动到GPU

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

model = model.to(device)

# 对单张图像进行前向传播以提取特征

input_image = torch.unsqueeze(input_tensor, 0).to(device)

with torch.no_grad():

features = model(input_image)

# 输出提取的特征

print("提取的特征维度:", features.size())

```

在上述代码中,我们使用了PyTorch库中的预训练模型`ResNet50`进行特征提取。通过修改模型的最后层来匹配我们的人脸分类任务,并确保在提取特征时网络的其他层权重保持不变。使用`torch.no_grad()`上下文确保

0

0