【Python高级查找技术】:生成器如何让检索事半功倍

发布时间: 2024-09-19 09:51:09 阅读量: 84 订阅数: 44

Python的高级主题:生成器、装饰器和元编程.docx

# 1. Python生成器的基础与重要性

Python生成器是迭代器的一种,它提供了一种更为高效和优雅的方式来处理数据序列。相较于传统的列表和元组,生成器在处理大数据集时尤其有用,因为它允许在迭代过程中逐个产生数据项,而不是一次性地将所有数据加载到内存中。这一特性极大地节省了内存资源,同时也使程序能够处理无限的序列。

生成器的使用不仅限于数据处理,它在异步编程和并发处理领域也扮演了重要角色。通过`yield`关键字,生成器可以暂停和恢复函数的执行状态,这为协程的实现提供了基础。简而言之,掌握生成器对于任何希望编写高效和可扩展Python代码的开发者而言都是至关重要的。

本文将详细介绍生成器的工作原理,探讨它如何通过节省内存和简化代码来提升开发效率,并且深入分析其在数据处理和并发编程中的高级应用。让我们开始深入了解Python生成器的强大功能与实用技巧。

# 2. 理解生成器的工作原理

## 2.1 生成器表达式与传统表达式的比较

### 2.1.1 代码简洁性分析

生成器表达式是Python中一种简洁的语法结构,允许我们以迭代器的方式生成数据,而不是一次性将数据全部加载到内存中。与传统的列表推导式相比,生成器表达式更加内存高效,因为它延迟计算元素的值,只在迭代时产生下一个元素。

```python

# 列表推导式示例

numbers_list = [x*x for x in range(1000)]

# 生成器表达式示例

numbers_gen = (x*x for x in range(1000))

```

在上面的代码中,列表推导式会立即计算出一个包含1000个元素的列表,而生成器表达式则会创建一个生成器对象,该对象在迭代时才计算每个元素的平方。

### 2.1.2 性能优化的潜力探讨

生成器表达式除了能够减少内存使用之外,在某些情况下还能提供性能优化。当处理大量数据时,这种延迟计算的特性可以显著减少程序的运行时间。

```python

import time

# 使用列表推导式

start_time = time.time()

_ = [x*x for x in range(1000000)]

print(f"列表推导式耗时:{time.time() - start_time}秒")

# 使用生成器表达式

start_time = time.time()

_ = (x*x for x in range(1000000))

print(f"生成器表达式耗时:{time.time() - start_time}秒")

```

上面的代码通过记录执行时间来比较列表推导式和生成器表达式的性能。对于大数据集的处理,生成器表达式通常会显示更快的执行速度,因为它避免了一次性生成整个列表。

## 2.2 生成器背后的技术细节

### 2.2.1 yield关键字的作用机制

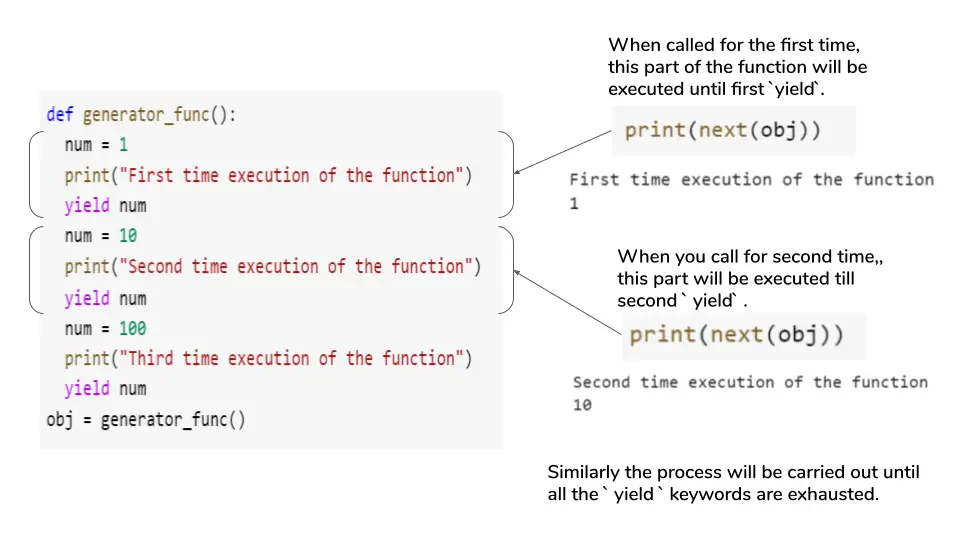

`yield` 是Python中一个特殊的语法,它使得一个函数从普通函数变成一个生成器函数。当 `yield` 在函数体内部被调用时,它暂停函数执行并返回一个值给调用者。之后再次调用生成器的 `.send()` 方法或通过迭代器协议继续时,函数会从上次 `yield` 返回的地方继续执行。

```python

def count_up_to(max_value):

count = 1

while count <= max_value:

yield count

count += 1

counter = count_up_to(5)

print(next(counter)) # 输出 1

print(next(counter)) # 输出 2

```

### 2.2.2 生成器的状态保存与恢复

生成器之所以强大,在于它们能够在每次 `yield` 之后保存函数的状态,包括变量、指令指针和栈帧等。当生成器再次被激活时,它会从上次离开的位置继续执行,所有的局部变量和状态信息都会被恢复。

```python

def print_numbers():

n = 0

while n < 5:

print(n)

n += 1

yield

counter = print_numbers()

for _ in range(3):

next(counter) # 分别打印 0, 1, 2

```

在这个例子中,`print_numbers` 是一个生成器函数,它在打印数字后通过 `yield` 暂停,之后再次被激活时可以从上次 `yield` 之后的代码继续执行。

## 2.3 生成器的高级用法

### 2.3.1 多个yield构成的复杂生成器

生成器可以通过多次使用 `yield` 来产生多个值。这些值可以是不相关的,也可以通过某种算法逻辑相关联。

```python

def fibonacci_numbers(n):

a, b = 0, 1

for _ in range(n):

yield a

a, b = b, a + b

fib = fibonacci_numbers(10)

for number in fib:

print(number)

```

在这个例子中,`fibonacci_numbers` 函数通过 `yield` 产生了斐波那契数列的前10个数字。

### 2.3.2 生成器与其他数据结构的协作

生成器可以与Python中的其他数据结构进行高效协作,例如用于过滤或转换数据。

```python

def count_even_numbers(limit):

for i in range(limit):

if i % 2 == 0:

yield i

even_numbers = count_even_numbers(10)

print(list(even_numbers)) # 输出 [0, 2, 4, 6, 8]

```

在这个例子中,`count_even_numbers` 函数是一个生成器,它过滤出小于一定范围内的偶数并逐一产生。通过使用 `list()` 函数,我们可以将生成器中的所有值收集到一个列表中。

生成器在Python中是一个非常灵活和强大的工具,它允许我们以一种更优雅和高效的方式处理序列数据。下一章,我们将探讨生成器在数据处理中的应用,包括处理大数据集和文件。

# 3. 生成器在数据处理中的应用

在数据处理领域,生成器因其独特的惰性求值特性,提供了一种高效且内存友好的处理方式。在本章节中,我们将深入探讨生成器如何应对大数据集的处理挑战,以及与Python内置函数结合产生的优化效果。此外,我们还将了解生成器如何在文件处理中发挥其特有的优势。

## 3.1 大数据集的惰性处理

### 3.1.1 惰性求值的优势和实例

生成器在处理大数据集时的优势显而易见。惰性求值意味着结果只有在实际需要时才会被计算,这样可以显著减少内存的使用,并提高程序的运行效率。例如,当你需要处理一个具有数百万行的CSV文件时,使用生成器可以避免一次性将所有数据加载到内存中。

```python

def read_large_file(file_name):

with open(file_name, 'r') as ***

***

```

0

0