【Common-Logging实战秘籍】:多线程环境下的高级日志管理技巧

发布时间: 2024-09-27 19:59:22 阅读量: 102 订阅数: 24

java企业门户源码-common-logging:.NET的可移植日志抽象

# 1. 日志管理的理论基础

日志管理作为IT运维的核心组成部分,关乎着系统的健康与安全。在这一章中,我们将探索日志的定义、作用以及为何它对于现代IT环境至关重要。首先,我们会定义日志文件是什么:它们是由计算机系统或应用程序生成的记录,用以追踪各种活动和事件。接着,我们将深入了解日志数据的价值,包括但不限于故障排查、性能监控、安全审计和合规性。最后,本章还将概述几种常见的日志类型,如系统日志、应用日志和安全日志,以及它们如何帮助不同的团队成员——开发者、系统管理员和安全分析师——有效地执行各自的职责。通过这一章的阅读,读者将获得对日志管理重要性的深刻理解,并为深入探讨后续章节中更具体的技术和实践打下坚实的基础。

# 2. 多线程环境下的日志需求分析

多线程编程是现代软件开发中的核心技术之一,尤其在服务器端的业务处理、桌面应用程序以及后台服务中扮演着重要角色。由于其并发的特性,多线程环境对日志系统的挑战主要体现在如何保持日志的清晰、有序,以及如何在不影响性能的前提下记录必要的信息。本章将深入分析在多线程环境下日志管理的需求,并探讨如何设计一个既高效又可靠的日志系统。

### 多线程日志管理的关键需求

在多线程环境下,日志系统需满足以下关键需求:

#### 1. 线程安全的日志记录

为了确保日志信息不出现交错混乱的情况,日志系统必须保证在多线程并发记录时的线程安全性。这意味着需要有一种机制来确保即使多个线程同时写入日志,日志文件中的每一条记录也都是完整且不冲突的。

#### 2. 高效的日志写入

多线程环境下,日志记录操作的性能开销对系统整体性能的影响不容忽视。日志系统应该采用高效的写入机制,减少在日志记录上的时间消耗,从而降低对业务处理的影响。

#### 3. 可定制的日志级别与格式

不同的业务场景对日志的需求也不尽相同,因此一个灵活的日志系统应该允许开发者为不同的线程或日志类别设置不同的日志级别和格式。这可以提升日志信息的可读性和问题排查的便捷性。

#### 4. 异常和错误的即时处理

在多线程环境中,出现异常和错误时需要及时记录下来,以便快速定位问题。此外,异常处理机制还应该考虑到错误回溯,以保证问题的准确识别。

### 设计思路与实现方法

为了满足以上需求,我们将从设计思路和具体实现方法两个方面来进行探讨。

#### 1. 使用线程安全的日志框架

选择合适的日志框架是确保线程安全的前提。目前市面上有多种成熟的线程安全日志框架,如log4j、log4net、SLF4J等。这些框架内部已经处理了多线程并发写入的问题。

以log4j为例,该框架通过使用内部同步机制和锁来保证线程安全。在Java中,每个日志调用都会被包装在一个synchronized块中,这样就能保证在任何时候只有一个线程能写入日志。当然,这种做法的性能开销相对较大,因为每次写入日志都需要获取锁。

```java

private final static Logger logger = LogManager.getLogger(MyClass.class);

public void myMethod() {

***("This is an info log message.");

logger.error("This is an error log message.");

}

```

#### 2. 优化日志写入性能

为了避免性能瓶颈,我们可以采取以下几个措施:

- **异步日志记录**:使用异步日志记录而不是同步记录,可以显著减少I/O操作对线程性能的影响。log4j的AsyncAppender就是这样一个组件。

- **缓冲日志输出**:将日志输出先缓存到内存中,然后批量写入到日志文件中,这样可以减少文件I/O操作的频率。

```xml

<appender name="ASYNC" class="org.apache.log4j.AsyncAppender">

<appender-ref ref="FILE" />

</appender>

```

#### 3. 定制日志级别与格式

日志框架一般都支持对不同类别的日志消息设置不同的日志级别和格式。例如,可以在log4j的配置文件中为不同的logger设置不同的日志级别。

```xml

<logger name="com.example.MyClass" additivity="false">

<level value="DEBUG" />

<appender-ref ref="FILE" />

</logger>

```

#### 4. 异常与错误处理

为了处理异常和错误,需要在代码中加入相应的try-catch块,确保所有的异常都能被记录下来。同时,也可以考虑使用日志框架提供的异常处理功能,它可以让日志框架在记录错误时提供更多的上下文信息,例如堆栈跟踪。

```java

try {

// some business logic

} catch (Exception e) {

logger.error("An exception occurred.", e);

}

```

### 总结

本章介绍了多线程环境下的日志管理需求,并探讨了如何使用线程安全的日志框架来记录线程安全的日志,同时讨论了如何通过异步记录、日志级别定制以及异常处理等手段来优化日志系统。下一章节我们将具体介绍Common-Logging的安装与配置,深入探讨如何在实际项目中应用这些理论知识。

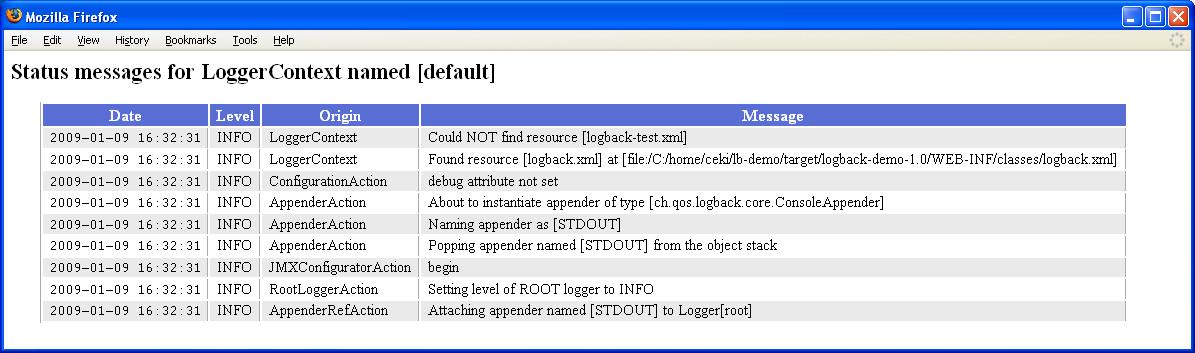

# 3. Common-Logging的安装与配置

在IT系统的日志管理实践中,合理选择和配置日志库是确保日志系统稳定运行和高效处理的关键。Common-Logging,作为Java世界中广泛使用的日志门面(logging facade),为开发者提供了一个统一的日志记录接口。本章节将深入探讨Common-Logging的安装与配置过程,并详细介绍在不同环境下如何优化设置以适应多变的日志需求。

## 安装Common-Logging

在介绍Common-logging的安装流程之前,需要理解它不是一个独立的日志实现,而是一个调用其他日志库(如Log4j、JDK Logging)的门面。因此,安装Common-logging实际上是指安装Common-logging库以及所依赖的日志实现库。

### 1. 添加依赖到项目

对于Maven项目,您需要在`pom.xml`文件中添加以下依赖:

```xml

<dependency>

<groupId>commons-logging</groupId>

<artifactId>commons-logging</artifactId>

<version>1.2</version>

</dependency>

```

如果您使用的是Log4j作为日志实现,还需要添加Log4j的依赖:

```xml

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>1.2.17</version>

</dependency>

```

### 2. 非Maven项目配置

对于非Maven项目,您需要手动下载`commons-logging.jar`和`log4j.jar`(或您选择的日志实现库),然后将其添加到项目的classpath中。确保类路径中包含了Common-logging和日志实现库的jar文件。

### 3. 环境检查

安装完成后,建议进行环境检查,确保Common-logging能够正确加载日志实现。在代码中创建一个简单的日志记录器实例,并尝试记录一条日志信息:

```***

***mons.logging.Log;

***mons.logging.LogFactory;

public class CommonLoggingExample {

private static final Log LOG = LogFactory.getLog(CommonLoggingExample.class);

public static void main(String[] args) {

***("Common-logging is configured and ready.");

}

}

```

如果日志信息能够正常输出,则表明Common-logging安装配置成功。

## 配置Common-Logging

Common-logging的配置通常涉及两个方面:一个是通过配置文件指定日志实现,另一个是配置日志实现本身的属性,比如日志级别、日志格式、输出位置等。

### 1. 指定日志实现

Common-logging通过`commons-logging.properties`文件来指定使用的日志实现。这个文件通常放在类路径的根目录下。例如,如果您想指定使用Log4j作为日志实现,则需要添加以下内容到`commons-logging.properties`文件:

```

***mons.logging.Log=***mons.logging.impl.Log4jLogger

```

通过这种方式,Common-logging在初始化时会根据这个属性文件找到并使用Log4j作为日志记录的具体实现。

### 2. 配置Log4j

对于Log4j的配置,通常需要在类路径下创建一个名为`log4j.properties`或`log4j.xml`的配置文件。下面是一个简单的`log4j.properties`配置文件示例:

```properties

# Set root logger level to DEBUG and its only appender to CONSOLE.

log4j.rootLogger=DEBUG, CONSOLE

# CONSOLE is set to be a ConsoleAppender.

log4j.appender.CONSOLE=org.apache.log4j.ConsoleAppender

# CONSOLE uses PatternLayout.

log4j.appender.CONSOLE.layout=org.apache.log4j.PatternLayout

log4j.appender.CONSOLE.layout.ConversionPattern=%d [%t] %-5p %c - %m%n

```

此配置将日志级别设置为DEBUG,并将日志输出到控制台,采用特定的格式。您可根据实际需求调整日志级别、appender类型、日志格式等。

## 配置文件的加载顺序

Common-logging在启动时会按照一定的顺序加载配置文件,如果找到相应的配置文件,则停止加载。配置文件的加载顺序如下:

1. `commons-logging.properties`文件

2. 系统属性(通过命令行设置的Java系统属性,如`***mons.logging.Log=***mons.logging.impl.Jdk14Logger`)

3. `logging.properties`文件(与JDK日志系统共用)

4. 如果以上都没有找到,则默认使用JDK日志系统作为日志实现

通过了解这个加载顺序,开发者可以根据项目需求和运行环境灵活地配置日志系统。

## 总结

Common-logging的安装与配置是日志管理中的重要环节,通过上述步骤,您可以将Common-logging与Log4j等日志实现库成功整合到项目中。理解并掌握Common-logging的配置流程,对于进一步进行日志管理、日志分析乃至日志系统的性能优化和故障排除有着重要作用。在下一章节中,我们将深入探讨高级日志管理技巧,进一步提升日志系统的管理能力。

# 4. 高级日志管理技巧

日志管理不仅仅局限于基本的日志记录与存储,更涉及到复杂的分析、汇总以及日志数据的安全。本章节将深入探讨高级日志管理技巧,包括日志聚合、实时监控、日志压缩与备份,以及安全性和合规性方面的最佳实践。

## 4.1 日志聚合

日志聚合是将来自不同源的日志数据集中到一个统一的地方进行存储和分析的过程。这有助于简化日志管理并提高效率。

### 4.1.1 日志聚合工具选择

选择一个合适的日志聚合工具对于确保日志数据的完整性和可用性至关重要。市面上有许多工具可供选择,包括开源的如ELK Stack(Elasticsearch, Logstash, Kibana)和商业的如Splunk等。

### 4.1.2 日志聚合架构设计

设计一个高效可扩展的聚合架构通常包括数据采集、传输、处理、存储和分析几个阶段。数据处理阶段可能涉及到数据清洗、格式化以及预处理等操作。

```mermaid

graph TD;

A[数据源] --> B[数据采集]

B --> C[数据传输]

C --> D[数据处理]

D --> E[数据存储]

E --> F[数据分析]

```

### 4.1.3 日志数据的处理和转换

数据处理是聚合流程中的核心部分,涉及到日志数据的解析、转换和丰富。这里使用Logstash配置文件作为示例:

```json

input {

file {

path => "/var/log/*.log"

start_position => "beginning"

}

}

filter {

grok {

match => { "message" => "%{COMBINEDAPACHELOG}" }

}

date {

match => [ "timestamp" , "dd/MMM/yyyy:HH:mm:ss Z" ]

}

}

output {

elasticsearch { hosts => ["localhost:9200"] }

}

```

上述代码中`grok`用于解析不同格式的日志数据,`date`用于转换时间戳格式。

## 4.2 日志实时监控

实时监控日志数据对于快速响应系统异常和安全事件至关重要。

### 4.2.1 实时监控的实现方法

实现日志的实时监控可以使用消息队列(如Kafka、RabbitMQ)进行缓冲,再结合流处理工具(如Apache Flink、Apache Storm)进行实时分析。

### 4.2.2 监控指标和报警机制

监控指标应包括错误率、请求延迟、服务状态等关键性能指标。报警机制需要能够实时通知相关人员。

### 4.2.3 实时监控工具实践

以Kafka配合Kibana进行实践演示:

```mermaid

graph LR;

A[应用服务] -->|日志| B[Kafka]

B -->|数据流| C[Kibana]

C -.->|实时监控| D[监控平台]

```

监控平台将实时分析日志数据流,并在检测到问题时发送报警。

## 4.3 日志压缩与备份

随着日志数据量的持续增长,日志压缩与备份成为管理日志数据时不可避免的需求。

### 4.3.1 日志压缩策略

日志压缩可以通过删除重复的日志条目、限制日志保留周期或者使用专有的压缩算法(如GZIP)来实现。

### 4.3.2 日志备份解决方案

备份策略应保证数据的安全和完整性,常见的备份解决方案包括本地备份、云备份以及冷备份。

### 4.3.3 备份与恢复流程设计

设计一个日志备份与恢复流程应包括定期备份计划、备份验证以及灾难恢复测试。这里是一个备份计划的基本示例:

```markdown

- 每天执行一次完整备份。

- 每小时执行一次增量备份。

- 定期检查备份文件的完整性。

- 每月进行一次恢复测试确保数据可恢复。

```

## 4.4 日志数据安全性和合规性

保护日志数据的安全性与合规性是企业必须面对的问题。

### 4.4.1 日志数据加密

日志数据应当加密存储,以防止未授权访问。加密可以在传输时进行(如TLS),也可以在存储时进行(如AES)。

### 4.4.2 日志访问控制与审计

确保只有授权用户才能访问日志数据,并记录所有的访问行为。使用如RBAC(基于角色的访问控制)和审计日志来维护。

### 4.4.3 合规性要求和标准

合规性要求通常由法律法规所定义。企业需要确保其日志管理策略符合如GDPR、HIPAA等国际或地区的标准。

本章节通过详细的分析和实践案例,为读者呈现了高级日志管理的方方面面,不仅涵盖了技术层面的操作和配置,也包括了管理层面的流程设计和策略规划。随着日志管理在企业中扮演越来越重要的角色,掌握这些高级技巧对于保障企业系统的稳定性、安全性和合规性具有重要意义。

# 5. 实践案例分析

## 日志管理在大型电商平台的实施

### 大型电商平台背景介绍

在现代的电商平台中,日志管理扮演着至关重要的角色。以某知名电商平台为例,该平台每天处理数百万笔交易,拥有数千万注册用户,且其交易量在特定促销活动期间会激增。为了保持系统的稳定运行并快速定位问题,该平台采用了一套复杂的日志管理系统。

### 日志策略的设计与实施

面对如此复杂的系统环境,设计日志策略成为首要任务。该平台的日志策略包括以下几个方面:

1. **日志级别设置**:合理设置日志级别是日志策略的核心。平台为不同的业务模块设置了不同的日志级别。例如,支付模块的安全日志级别设置为最高,以确保所有安全相关的活动都能被详细记录。

2. **日志格式规范**:统一的日志格式使得日志分析和处理变得更加高效。所有日志按照时间戳、日志级别、模块名称、消息内容等固定格式记录。

3. **日志存储与备份**:为了应对数据丢失的风险,所有日志被实时存储到高性能的SSD存储设备上,并进行定期备份。

4. **日志索引与搜索**:建立高效的日志索引系统,配合强大的搜索工具,使得问题定位和日志查询变得迅速准确。

### 日志管理工具的选择与配置

在日志管理工具的选择上,该平台采用了ELK Stack(Elasticsearch, Logstash, Kibana)来实现日志的收集、处理和可视化。以下是配置过程的关键步骤:

#### Elasticsearch的部署与优化

首先,Elasticsearch被部署为集群模式以提供高可用性。集群由多个数据节点和协调节点组成,数据节点负责存储和索引数据,而协调节点负责处理客户端请求并进行负载均衡。

```yml

# elasticsearch.yml 配置示例

cluster.name: "elasticsearch-cluster"

node.name: "es-node1"

node.master: true

node.data: true

```

参数说明:

- `cluster.name`: 指定集群名称,相同集群中的节点会自动组成集群。

- `node.name`: 指定当前节点的名称。

- `node.master` 和 `node.data`: 指明节点是主节点还是数据节点,还是两者兼备。

#### Logstash的日志收集与处理

Logstash被配置为从各个服务节点实时收集日志,并通过定义的过滤器进行处理,最后将处理过的日志数据索引到Elasticsearch中。

```conf

# logstash.conf 配置示例

input {

beats {

port => 5044

}

}

filter {

# 过滤器配置省略

}

output {

elasticsearch {

hosts => ["localhost:9200"]

}

}

```

代码解释:

- `input` 部分定义了从哪里收集日志(如使用Beats协议的文件beat),指定了端口号为5044。

- `filter` 部分省略了具体配置,这里可以定义日志内容的清洗和格式化规则。

- `output` 部分定义了日志输出的目的地,这里配置为本地的Elasticsearch服务。

#### Kibana的可视化展示

Kibana作为日志的可视化工具,提供了一个Web界面,用户可以通过它进行日志查询和监控。在Kibana中,可以创建仪表板,展示实时数据和日志趋势分析结果。

```javascript

// Kibana仪表板配置示例

PUT _template/log_template

{

"template": "logstash-*",

"settings": {

"number_of_shards": 3

},

"mappings": {

"_source": {

"excludes": ["agent", "input", "log", "ecs.version"]

}

}

}

```

代码解释:

- 上面的代码块创建了一个模板,为匹配`logstash-*`模式的索引设置了一些基本的索引配置和映射。这有助于优化存储和检索效率。

### 应用案例与分析

针对具体的应用案例,该平台使用ELK Stack成功地处理了一起支付模块的异常。通过Kibana的实时日志监控功能,运维团队在支付模块出现异常的日志时迅速被触发告警。

#### 日志查询与问题定位

运维人员使用Kibana的搜索功能对异常日志进行了查询,发现了与特定支付交易ID相关的所有日志条目。通过分析这些日志,发现了一个未被捕获的异常代码路径,导致了交易信息没有正确处理。

```json

GET /_search

{

"query": {

"bool": {

"must": {

"match": { "message": "Payment transaction error" }

},

"filter": {

"term": { "transaction_id": "T***" }

}

}

}

}

```

代码解释:

- 上面的查询请求用于在日志中查找包含特定错误信息“Payment transaction error”的条目,并且针对特定的交易ID进行过滤。

#### 问题解决与日志优化

在确认问题后,开发团队迅速响应并修复了代码。同时,运维团队也在Logstash中添加了一个新的过滤器规则,以便在未来能够更快地识别类似错误。

```conf

# 新增Logstash过滤器规则

filter {

if [message] =~ "Payment transaction error" {

mutate {

add_field => { "error_type" => "payment"}

}

}

}

```

代码解释:

- 在过滤器中新增规则,当检测到包含"Payment transaction error"的日志时,自动添加一个名为`error_type`的字段,其值为`payment`。这有助于快速分类和检索此类错误。

### 结语

通过对该电商平台日志管理实践案例的分析,我们可以看到日志管理在系统监控和故障排查中发挥的重要作用。合理设计日志策略、选择合适的日志管理工具、并进行持续的优化,是保障系统稳定运行和快速响应的关键。

# 6. 性能优化与故障排除

性能优化和故障排除是日志管理中极为关键的环节,它直接关系到日志系统的效率和可靠性。随着系统复杂度的提升,对日志性能的优化和对故障的快速响应变得尤为重要。本章将详细探讨性能优化的方法和步骤,以及如何进行有效的故障排除。

## 6.1 性能优化的考量因素

在进行性能优化之前,我们必须理解影响日志性能的关键因素:

- **日志记录频率与量**:日志输出量越大,对存储和处理能力的要求就越高。

- **日志级别与过滤**:正确的日志级别和过滤可以显著减少不必要的日志记录。

- **存储介质与访问速度**:使用SSD而不是传统硬盘可以大幅提高日志读写速度。

- **日志轮转策略**:定时清理旧日志可以避免磁盘空间的浪费。

- **异步日志记录**:异步写入可以减少日志对系统性能的影响。

## 6.2 优化日志级别与过滤

根据不同的开发和生产阶段,合理配置日志级别是提高性能的关键。在开发阶段,可能需要更详细的日志输出以便问题诊断,在生产环境中,则应尽可能减少对性能影响较大的日志级别。

### 示例代码 - Java

```java

// 设置日志级别为INFO,排除DEBUG级别的日志

Logger logger = LoggerFactory.getLogger(MyClass.class);

***("这是INFO级别的日志");

logger.debug("这将是被过滤的DEBUG级别的日志");

```

## 6.3 日志存储和索引优化

在处理大量日志时,合理的存储和索引策略显得尤为重要。这包括:

- **分片存储**:将日志分散到不同的存储介质上,可并行化读写操作。

- **索引优化**:建立有效的索引结构,如倒排索引,加快查询速度。

- **压缩技术**:使用GZIP等压缩技术减少存储空间的需求。

## 6.4 故障排除策略

故障排除通常需要一系列有条理的步骤。首先,应监控日志系统的关键性能指标,如日志写入速度、磁盘空间使用率等。一旦出现异常,应迅速定位问题所在:

1. **检查日志饱和情况**:查看是否由于日志写入速度过快导致存储饱和。

2. **分析系统瓶颈**:利用性能分析工具,如top, iotop(Linux下)等确定瓶颈所在。

3. **审查配置文件**:确保所有的日志配置都是最优的,例如检查日志轮转配置和级别设置。

4. **实时监控与警报**:实施实时监控系统,一旦检测到异常即发出警报。

### 示例代码 - 使用监控脚本进行日志饱和检查

```bash

#!/bin/bash

LOG_DIR="/var/log"

DISK_USAGE=$(df -h | grep "$LOG_DIR" | awk '{ print $5 }' | sed 's/%//')

if [ $DISK_USAGE -gt 90 ]; then

echo "警告: 磁盘使用率大于90%,请检查日志存储空间。"

# 发送邮件通知或触发警报

# mail -s "警告:磁盘使用率过高" *** < /dev/null

fi

```

## 6.5 实践案例

让我们看一个实践案例,如何在实际中应用性能优化和故障排除策略。假设我们有一个运行在线服务的大型分布式系统,系统中包含了多个日志生成器。一段时间后,我们发现系统响应变慢,并在监控日志中发现磁盘I/O使用率接近100%。

我们首先检查了日志存储目录,发现磁盘空间几乎耗尽。接下来,我们对日志文件进行分析,发现有大量的DEBUG级别的日志记录,这些记录在生产环境中是不必要的。我们修改了日志配置文件,将这部分日志级别调整为INFO。

然后,我们设置了日志轮转策略,将超过一周的旧日志自动归档。之后,对日志文件实施GZIP压缩,节省了30%的存储空间。最后,我们实施了一个实时监控脚本,当磁盘使用超过90%时,自动通知系统管理员。

## 6.6 总结

本章节深入探讨了如何优化日志性能和进行故障排除。从调整日志级别到实施监控策略,每一步都对系统的稳定性和效率产生重要影响。合理的设计和策略实施,将确保日志系统能够高效稳定地运行,为系统提供有力的监控和故障诊断支持。

0

0