【R语言Tau包高级技巧】:提升文本挖掘与金融数据分析的效率

发布时间: 2024-11-06 22:31:41 阅读量: 24 订阅数: 21

# 1. Tau包简介与安装配置

## Tau包简介

Tau包是一个功能强大的文本分析工具包,专为R语言设计,它提供了丰富的文本挖掘和自然语言处理功能。Tau包集成了多个预处理、分析和建模的工具,使得从文本中提取信息和洞察变得更加简单高效。

## 安装Tau包

Tau包的安装非常简单,您可以通过R语言的包管理器来安装它。打开R控制台,输入以下命令:

```r

install.packages("Tau")

```

安装完成后,您可以通过加载它来开始使用:

```r

library(Tau)

```

## Tau包的配置

Tau包对环境没有特别的要求,但建议使用最新的R版本以确保所有功能都能正常工作。另外,您可能需要根据实际需要安装一些依赖包,如tm、ggplot2等,来增强Tau包的文本分析能力。

通过以上步骤,您便已经完成Tau包的安装和配置,可以开始探索它在文本挖掘中的强大应用了。

# 2. Tau包在文本挖掘中的应用

Tau包不仅在时间序列分析领域大放异彩,它在文本挖掘领域的应用也十分广泛。本章将深入探讨Tau包在处理文本数据方面提供的基础功能和高级技巧,以及如何与其他R包协同工作以解决复杂的自然语言处理(NLP)任务。

### 2.1 Tau包的基础文本处理功能

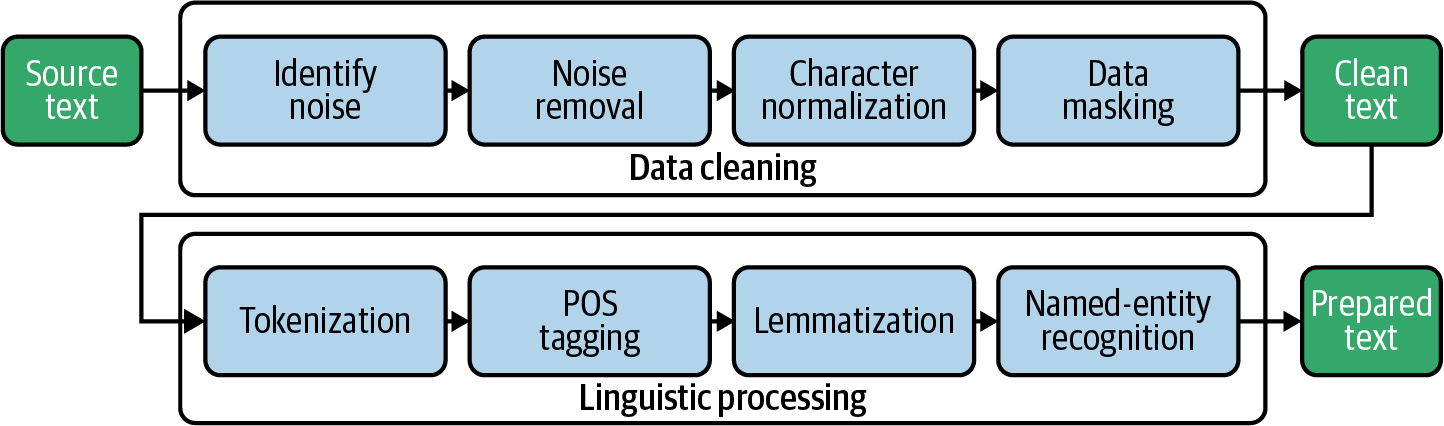

#### 2.1.1 文本的清洗与预处理

在文本挖掘中,数据的质量往往决定着分析结果的准确性。Tau包提供了一系列的函数来帮助用户进行文本清洗与预处理。预处理可能包括去除标点符号、数字、停用词,转化为小写,以及词干提取等步骤。例如,`clean`函数可以移除文本中的特定元素,如URL、HTML标签、特殊字符等,而`stemDocument`函数可以将单词转化为其词根形式。

```r

# 示例代码:文本清洗与预处理

library(tau)

text <- "R is a free software environment for statistical computing and graphics."

cleaned_text <- clean(text, lower = TRUE, html = FALSE, fix.white = TRUE, extra = " ")

stemmed_text <- stemDocument(cleaned_text)

print(stemmed_text)

```

上述代码首先加载了Tau包,然后定义了一段含有特殊字符的文本。使用`clean`函数对文本进行了清洗,包括转换为小写、移除HTML标签,并进行空格处理。最后通过`stemDocument`函数对清洗后的文本进行了词干提取。

#### 2.1.2 文本向量化与词频分析

文本向量化是将文本转换成数值形式的过程,以便进行数学分析。Tau包的`termMatrix`函数可以将文本转换为一个词项-文档矩阵。同时,`findFreqTerms`函数可以帮助用户找出高频或低频的词汇,从而进行词频分析。

```r

# 示例代码:文本向量化与词频分析

term_matrix <- termMatrix(stemmed_text)

freq_terms <- findFreqTerms(term_matrix, lowfreq = 1)

print(freq_terms)

```

在这个示例中,我们将清洗后的文本通过`termMatrix`转换为词项-文档矩阵。然后用`findFreqTerms`找到了至少出现一次的词汇,即高频词汇。

### 2.2 Tau包的高级文本分析技巧

#### 2.2.1 文本相似度和距离度量

在文本挖掘中,比较不同文档或段落的相似度是一个常见的需求。Tau包中的`sim2`和`dist`函数可以分别用于计算两个文本对象的相似度和距离。这些计算通常基于余弦相似度或Jaccard距离。

```r

# 示例代码:文本相似度和距离度量

text2 <- "R is a powerful language for data analysis and graphics."

similarity <- sim2(term_matrix, termMatrix(text2), method = "cosine")

distance <- dist(term_matrix, termMatrix(text2), method = "jaccard")

print(similarity)

print(distance)

```

上述代码计算了两个词项-文档矩阵之间的余弦相似度和Jaccard距离,分别使用`sim2`和`dist`函数。这可以帮助分析文本内容的相似性或者差异性。

#### 2.2.2 主题模型与情感分析

主题模型是一种文本挖掘技术,可以识别大量文档集合中的主题分布。Tau包中的`LDA`函数能够实现隐狄利克雷分布模型,通过它我们可以发现文本数据中的隐藏主题。此外,`SentimentAnalysis`包可以与Tau包集成,用于执行情感分析,确定文本的情感倾向性。

```r

# 示例代码:主题模型与情感分析

set.seed(123)

topics <- LDA(term_matrix, k = 2)

# 假设有一个已训练的情感分析模型

# sentiment <- analyzeSentiment(stemmed_text)

# print(sentiment)

print(topics)

```

在此示例中,我们使用`LDA`函数对词项-文档矩阵进行主题模型分析,这里假设有两个主题。然后调用一个假定的情感分析模型来分析文本的情感倾向性。

### 2.3 Tau包与其他R包的集成应用

#### 2.3.1 Tau与tm包的结合使用

tm包是R中一个非常流行的文本挖掘工具包,它和Tau包有着相似的功能集。通过结合使用这两个包,可以发挥各自的优势,进行更为强大的文本分析。例如,tm包中的`Corpus`结构可以用来存储文本数据,并且可以与Tau包进行数据交换和进一步处理。

```r

# 示例代码:Tau与tm包的结合使用

library(tm)

text_corpus <- Corpus(VectorSource(c(text, text2)))

text_corpus <- tm_map(text_corpus, content_transformer(tolower))

# 将tm包中的corpus转换为Tau包能处理的格式

converted_corpus <- convert(text_corpus, to = "tau")

print(converted_corpus)

```

在上述代码中,我们首先创建了一个tm包的文本语料库,然后将其转换为小写。最后,利用`convert`函数将tm包的语料库转换为Tau包可以处理的格式。

#### 2.3.2 Tau包在NLP任务中的协同工作

在进行自然语言处理任务时,将Tau包与其他专门的NLP包联合使用可以提升任务的完成质量。例如,`openNLP`包可以用于分词、词性标注等任务,而`textcat`包可以用于文本分类。 Tau包中的文本预处理和向量化功能可以作为这些NLP任务的前期步骤。

```r

# 示例代码:Tau包在NLP任务中的协同工作

library(openNLP)

library(textcat)

# 以下代码展示如何使用openNLP包的词性标注器进行词性标注

s <- as.String(stemmed_text)

a <- Maxent词性标注器模型

pos_tags <- annotate(s, a)

# 假设有一个训练好的文本分类器

# textcat_model <- trainTextCat(stemmed_text)

# predicted_category <- textCat(stemmed_text, textcat_model)

print(pos_tags)

```

在这段示例代码中,我们利用`openNLP`包中的Maxent词性标注器模型对清洗后的文本进行词性标注。然后,我们假定有一个通过`textcat`包训练好的文本分类器,并使用它来预测文本的分类。

在下一章,我们将深入探讨Tau包在金融数据分析中的应用,揭示它如何帮助分析师进行时间序列分析和风险评估。

# 3. Tau包在金融数据分析中的应用

金融数据分析是利用现代统计学和数据挖掘技术对金融市场进行分析的过程,目的在于发现数据中的模式、趋势和相关性,为决策提供依据。Tau包作为一个在R语言环境下使用的文本分析工具包,它不仅在文本挖掘领域有着广泛的应用,还扩展到了金融

0

0