【Python终端内存管理】:优化内存使用提升性能

发布时间: 2024-10-15 10:09:07 阅读量: 26 订阅数: 27

开发板基于STM32H750VBT6+12位精度AD9226信号采集快速傅里叶(FFT)变计算对应信号质量,资料包含原理图、调试好的源代码、PCB文件可选

# 1. Python内存管理概述

## 简介

在Python中,内存管理是保证程序高效运行的关键环节。由于Python是一种高级编程语言,它对内存的操作对开发者来说大多是透明的。然而,了解其内存管理机制对于编写高效、稳定的程序至关重要。

## 内存管理的重要性

良好的内存管理不仅可以提升程序的运行效率,还能避免内存泄漏等问题,从而延长程序的生命周期。Python的内存管理主要涉及内存的分配、使用和回收三个阶段,每个阶段都有其特定的技术和策略。

## 内存分配

在Python中,内存分配主要涉及对象的创建。Python使用一种名为“堆”(heap)的内存区域来存储所有的对象数据。每个对象都有一个与之关联的引用计数,用于追踪有多少变量引用了该对象。

## 内存回收

Python的内存回收机制主要依赖于引用计数,但为了处理循环引用问题,Python还引入了垃圾回收算法。这些机制共同工作,确保了内存的高效利用和程序的稳定性。

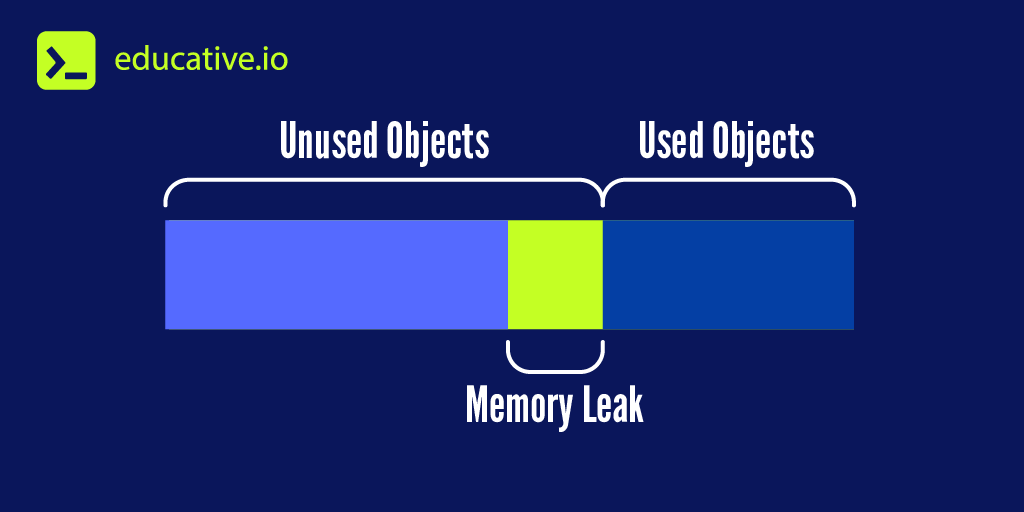

## 内存泄漏

尽管Python有自动的内存管理机制,但不当的编程实践仍可能导致内存泄漏。例如,循环引用、全局变量滥用等都是常见的内存泄漏原因。学会识别和避免这些问题是每个Python程序员的必修课。

通过本章的学习,我们将深入理解Python的内存管理原理,并掌握如何通过编程实践来优化内存使用,提高程序性能。

# 2. Python内存分配与回收机制

Python作为一种高级编程语言,其内存管理机制对程序员来说通常是透明的。然而,理解这些机制对于编写高效和稳定的Python程序至关重要。在本章节中,我们将深入探讨Python的内存分配和回收机制,包括基本对象内存分配、内存池的概念和作用、引用计数机制以及垃圾回收算法。

## 2.1 内存分配机制

### 2.1.1 基本对象内存分配

在Python中,所有对象的内存分配都是动态的,这意味着内存会在对象创建时自动分配,并在对象不再被使用时自动释放。Python使用了一种称为“分配器”的组件来管理内存分配。分配器负责从操作系统获取大块的内存,并将这些内存块分割成更小的部分供Python对象使用。

Python对象分为可变对象和不可变对象。不可变对象(如整数、浮点数、字符串和元组)一旦创建,其内存大小就固定不变。而可变对象(如列表、字典和集合)的内存大小可能会变化。

### 2.1.2 内存池的概念和作用

内存池(Memory Pool)是一种特殊的内存分配机制,用于管理固定大小的内存块。在Python中,内存池主要用于分配固定大小的对象,如整数和字符。通过内存池,Python可以减少频繁的内存分配和回收所造成的开销,提高内存分配的效率。

Python的内存池机制通过预分配一系列的内存块来实现。当程序需要分配小块内存时,内存池会从预分配的内存块中提供,而不是每次都向操作系统请求。这样可以减少内存分配的次数和碎片,提高内存使用的效率。

## 2.2 内存回收机制

### 2.2.1 引用计数机制

Python使用引用计数机制来跟踪对象的引用次数。每个对象都有一个引用计数器,每当一个变量或对象引用该对象时,引用计数器增加;当引用失效时,引用计数器减少。当对象的引用计数降到零时,意味着没有任何变量或对象引用该对象,Python的垃圾回收器会回收该对象所占用的内存。

引用计数机制是一种简单有效的内存回收方法,但它有一个明显的缺陷:无法处理循环引用的情况。如果两个对象相互引用,即使它们不再被程序中的其他部分引用,它们的引用计数也不会降到零,从而导致内存泄漏。

### 2.2.2 垃圾回收算法

为了解决引用计数机制的缺陷,Python引入了垃圾回收算法。垃圾回收器会定期运行,检查并清除那些不再可达的对象所占用的内存。Python使用的是基于标记-清除(Mark-Sweep)算法的垃圾回收机制。

标记-清除算法分为两个阶段:

1. 标记阶段:从一组根对象开始,递归地标记所有可达的对象。

2. 清除阶段:遍历整个内存空间,清除所有未被标记的对象。

垃圾回收器通过这种方式来回收循环引用所占用的内存,从而避免内存泄漏。

## 2.3 内存泄漏诊断

### 2.3.1 内存泄漏的常见原因

内存泄漏是指程序在运行过程中,由于错误的内存管理导致可用内存逐渐减少。Python中的内存泄漏通常有以下几种常见原因:

1. 循环引用:对象之间相互引用,即使它们不再被程序中的其他部分引用,也无法被垃圾回收器回收。

2. 缓存不当:使用全局或静态变量缓存大量数据,导致内存使用量不断增加。

3. 第三方库的内存泄漏:使用的一些第三方库可能存在内存泄漏的问题,而开发者可能并不知情。

### 2.3.2 内存泄漏检测工具和方法

为了诊断和解决内存泄漏问题,Python社区提供了多种工具和方法。一些常用的内存泄漏检测工具包括:

1. `tracemalloc`:Python内置的模块,用于追踪内存分配和跟踪内存块的来源。

2. `objgraph`:第三方库,可以生成对象的引用图,帮助发现循环引用。

3. `memory_profiler`:第三方库,用于监控程序的内存使用情况。

通过这些工具,开发者可以有效地发现和诊断内存泄漏问题。例如,使用`tracemalloc`模块,可以追踪到具体的代码行和文件,找出内存泄漏的源头。

```python

import tracemalloc

tracemalloc.start()

# 你的代码逻辑

# ...

snapshot = tracemalloc.take_snapshot()

top_stats = snapshot.statistics('lineno')

for stat in top_stats[:10]: # 显示前10条最消耗内存的统计信息

print(stat)

```

以上代码展示了如何使用`tracemalloc`模块来追踪内存分配,并打印出消耗内存最多的10条统计信息。通过分析这些信息,开发者可以找到潜在的内存泄漏点。

在本章节中,我们详细介绍了Python的内存分配和回收机制,包括内存池的概念、引用计数机制、垃圾回收算法以及内存泄漏的常见原因和检测方法。通过这些知识,我们可以更好地编写高效和稳定的Python程序。接下来,我们将探讨内存分析工具和实践,帮助开发者进一步优化内存使用。

# 3. 内存分析工具和实践

## 3.1 内存分析工具介绍

### 3.1.1 如何选择合适的内存分析工具

在选择内存分析工具时,首先要明确分析目标和需求。不同的工具可能针对不同的问题场景有不同的优势。例如,如果目标是检测内存泄漏,那么需要一个能够追踪内存分配和释放历史的工具,如Valgrind。如果目的是优化内存使用,减少不必要的内存开销,那么可能需要一个能够提供内存使用详细报告的工具,如Pympler。

选择合适的工具还要考虑以下因素:

- **平台兼容性**:工具是否支持你的操作系统和Python版本。

- **易用性**:工具的使用是否直观,是否容易集成到现有的开发流程中。

- **性能开销**:工具运行时是否对程序性能影响较小,是否适合生产环境。

- **报告详细程度**:工具是否能够提供足够的信息来诊断和解决问题。

### 3.1.2 常用内存分析工具概述

#### Valgrind

Valgrind是一套用于内存调试、内存泄漏检测和性能分析的工具。它通过模拟CPU在一种特殊的模式下运行程序来进行分析,因此运行速度较慢,但提供了非常详尽的信息。

- **优势**:强大的内存泄漏检测能力,提供详细的内存访问错误报告。

- **缺点**:运行速度慢,对程序性能影响较大。

#### Pympler

Pympler是一个Python模块,用于跟踪和监控Python程序的内存使用情况。它提供了一个简单易用的接口,可以直接集成到Python脚本中。

- **优势**:轻量级,无需额外安装,方便集成。

- **缺点**:相比专业的性能分析工具,提供的信息较为基础。

#### objgraph

objgraph是一个用于生成Python对象图的库,它可以显示对象之间的关系,帮助开发者了解内存中的对象结构。

- **优势**:直观地显示对象关系,帮助理解内存使用模式。

- **缺点**:功能较为特殊,不是通用的内存分析工具。

### 代码示例:使用Pympler进行内存分析

下面是一个使用Pympler模块进行内存分析的简单示例:

```python

from pympler import asizeof

# 定义一个简单的类

class MyClass:

def __init__(self, name):

self.name = name

self.data = [0] * 1000

# 创建一个大的对象列表

objects = [MyClass(f"Object {i}") for i in range(100)]

# 使用asizeof模块测量内存使用情况

total_size = asizeof.asizeof(objects)

print(f"Total memory usage: {total_size} bytes")

# 获取每个对象的内存使用情况

for obj in objects:

obj_size = asizeof.asizeof(obj)

print(f"Object {obj.name}: {obj_size} bytes")

```

在这个示例中,我们首先导入了Pympler模块中的`asizeof`函数,然后创建了一个包含100个对象的列表。每个对象都是一个`MyClass`实例,包含一个名字和一个1000元素的列表。我们使用`asizeof`函数来测量整个对象列表的内存使用情况,以及每个单独对象的内存使用情况。

#### 代码逻辑分析

- **导入模块**:`from pympler import asizeof`导入了Pympler模块中的`asizeof`函数。

- **定义类**:定义了一个`MyClass`类,包含一个字符串属性`name`和一个整数列表`data`。

- **创建对象列表**:使用列表推导式创建了一个包含100个`MyClass`实例的列表。

- **测量总内存使用情况**:使用`asizeof.asizeof(objects)`测量整个对象列表的内存使用情况。

- **测量单个对象内存使用情况**:遍历对象列表,使用`asizeof.asizeof(obj)`测量每个对象的内存使用情况。

通过这个示例,我们可以看到Pympler如何简单地帮助我们测量Python对象的内存使用情况,这对于日常的内存分析和优化工作非常有用。

## 3.2 内存分析实践

### 3.2.1 使用内存分析工具进行性能分析

在本章节中,我们将通过一个实际案例,展示如何使用内存分析工具进行性能分析。我们将使用Valgrind的Memcheck工具来检测内存泄漏,并使用Pympler来优化内存

0

0