MapReduce中的高效文件读写技巧

发布时间: 2024-05-02 20:09:30 阅读量: 71 订阅数: 41

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 2.1 分布式文件系统(HDFS)

HDFS(Hadoop分布式文件系统)是MapReduce框架中用于存储和管理数据的分布式文件系统。它为大规模数据处理提供了可靠、可扩展和高吞吐量的存储解决方案。

### 2.1.1 HDFS架构和原理

HDFS采用主从架构,由一个NameNode和多个DataNode组成。NameNode负责管理文件系统元数据,包括文件和目录的位置信息。DataNode负责存储实际的数据块。

HDFS将文件分成固定大小的数据块(默认512MB),并将其复制到多个DataNode上。这种复制机制提供了数据冗余和容错性,确保即使某些DataNode发生故障,数据也不会丢失。

### 2.1.2 HDFS文件读写操作

**读操作:**

当客户端请求读取文件时,NameNode会返回包含文件块位置信息的元数据。客户端直接从DataNode读取数据块,并将其合并为完整的文件。

**写操作:**

当客户端写入文件时,NameNode会分配一个新的数据块,并指示客户端将数据块写入到多个DataNode上。DataNode会将数据块复制到其他DataNode上,以确保冗余。

# 2. MapReduce文件读写理论基础

### 2.1 分布式文件系统(HDFS)

#### 2.1.1 HDFS架构和原理

HDFS(Hadoop分布式文件系统)是一个专为大数据处理而设计的分布式文件系统。其架构基于主从模式,包括一个NameNode和多个DataNode。NameNode负责管理文件系统元数据,而DataNode负责存储和管理数据块。

HDFS采用块存储机制,将文件分割成固定大小(默认64MB)的块,并存储在不同的DataNode上。这种机制提高了数据冗余性和可用性,因为即使某个DataNode发生故障,数据也不会丢失。

#### 2.1.2 HDFS文件读写操作

HDFS提供了两种基本的文件读写操作:

- **读操作:**客户端向NameNode请求文件元数据,获取数据块的位置信息。然后,客户端直接从DataNode读取数据块,并组装成完整的文件。

- **写操作:**客户端向NameNode请求文件创建或追加权限。NameNode分配数据块并返回DataNode位置。客户端将数据块写入DataNode,并由NameNode更新文件元数据。

### 2.2 MapReduce数据模型

#### 2.2.1 Map和Reduce阶段

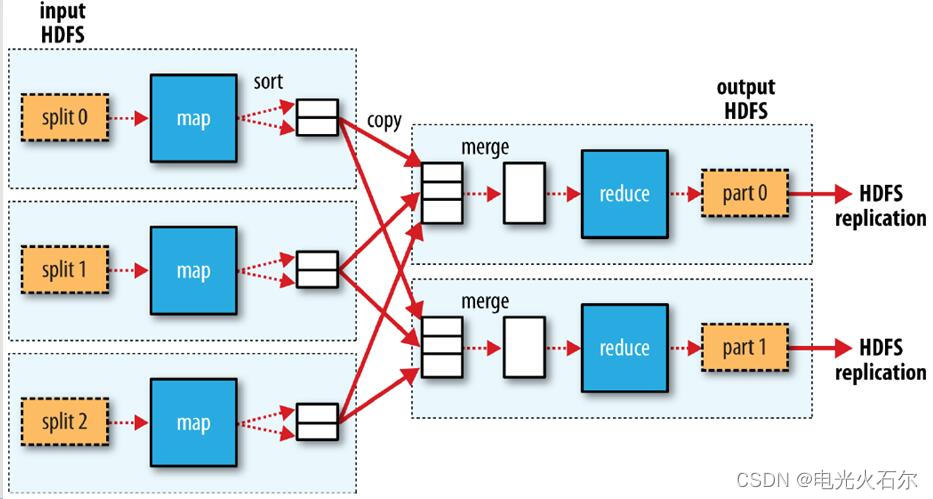

MapReduce是一种分布式编程模型,用于处理大规模数据集。它由两个主要阶段组成:

- **Map阶段:**将输入数据分片成较小的块,并应用Map函数对每个块进行处理。Map函数输出键值对。

- **Reduce阶段:**将Map阶段输出的键值对分组,并应用Reduce函数对每个组进行聚合或处理。Reduce函数输出最终结果。

#### 2.2.2 数据分片和局部性

数据分片是将输入数据划分为较小的块的过程。HDFS中的数据块大小通常为64MB。分片可以提高并行性,因为不同的Map任务可以同时处理不同的数据块。

局部性是指数据块和处理它的任务位于同一节点上的情况。局部性可以减少网络开销,提高处理效率。MapReduce框架会尽量安排任务在数据块所在的节点上运行,以优化局部性。

```

代码块:

```

```

// MapReduce数据分片示例

// 输入数据

List<String> inputData = List.of("a", "b", "c", "d", "e");

// 分片大小

int splitSize = 2;

// 分片数据

List<List<String>> splits = new ArrayList<>();

for (int i = 0; i < inputData.size(); i += splitSize) {

splits.add(inputData.subList(i, Math.min(i + splitSize, inputData.size())));

}

// 打印分片结果

System.out.println("分片结果:");

for (List<String> split : splits) {

System.out.println(split);

}

```

```

**逻辑分析:**

该代码示例演示了如何将输入数据分片成较小的块。它使用了一个列表来存储输入数据,并指定了一个分片大小。然后,它遍历输入数据,并将数据分成指定大小的块。最后,它打印分片结果。

**参数说明:**

- `inputData`:输入数据列表

- `splitSize`:分片大小

- `splits`:分片结果列表

# 3. MapReduce文件读写实践技巧

### 3.1 优化数据分片策略

**3.1.1 考虑数据大小和分布**

数据分片策略直接影响MapReduce作业的性能。理想情况下,每个分片应包含相同数量的数据,以便在Map任务之间均匀分配工作负载。

* **评估数据大小:**确定输入文件的大小并估计每个分片的大小。

* **考虑数据分布:**分析输入数据是否均匀分布或存在倾斜。倾斜的数据可能导致某些Map任务过载,而其他Map任务空闲。

**3.1.2 使用自定义分区器**

Hadoop提供了一个默认的分区器,将输入数据均匀地分配到分片中。但是,在某些情况下,自定义分区器可以进一步优化分片策略。

* **创建自定义分区器:**实现`Partitioner`接口并覆盖`getPartition`方法。

* **自定义分区逻辑:**根据数据特征自定义分区逻辑,例如根据键的范围或值将数据分配到特定的分片。

### 3.2 提高数据读取效率

**3.2.1 使用SequenceFile格式**

SequenceFile是一种二进制格式,专门用于存储Hadoop数据。它比文本文件更紧凑、高效,并且支持按键排序。

* **使用SequenceFileWriter:**使用`SequenceFile.Writer`类将数据写入SequenceFile。

* **指定键和值类型:**指定SequenceFile中键和值的数据类型。

* **优点:**SequenceFile提供更快的读取速度、更小的文件大小和按键排序。

**3.2.2 启用压缩和缓存**

压缩和缓存技术可以提高数据读取效率。

* **启用

```

0

0