【分布式爬虫】:构建cnki分布式爬取系统的7大要点

摘要

分布式爬虫作为一种自动化抓取互联网数据的技术,在学术研究与信息分析中扮演着重要角色。本文首先介绍了分布式爬虫的基本理论、架构设计以及与传统爬虫的区别。针对CNKI平台的特性,本文详细阐述了数据抓取策略、反爬虫机制应对和数据存储管理的实战技巧。进一步,本文探讨了分布式爬虫的性能优化、运维监控以及未来发展,特别分析了其在大数据背景下和面临法律合规与伦理问题时的挑战与机遇。通过对CNKI分布式爬取系统的案例分析,本文总结了爬虫设计的实践经验和反思,并就法律约束和网络伦理进行了探讨,旨在提倡构建负责任的爬虫文化。

关键字

分布式爬虫;CNKI平台;架构设计;性能优化;法律合规;网络伦理

参考资源链接:Python爬虫实战:中国知网数据抓取与可视化分析

1. 分布式爬虫概述及CNKI平台介绍

1.1 分布式爬虫的概念与发展

分布式爬虫是网络爬虫技术发展的高级阶段,主要通过分布式计算系统来提升爬虫的效率和规模。与传统的单机爬虫相比,分布式爬虫能够更好地应对大规模的数据采集任务,并通过多服务器协作来避免单点故障,保证系统的稳定运行。随着互联网数据的爆炸式增长,分布式爬虫已成为获取大量网络数据不可或缺的技术工具。

1.2 CNKI平台的价值与挑战

中国知网(CNKI)是全球最大的中文文献数据库之一,涵盖了学术论文、会议、报告等丰富的学术资源。对于研究人员、学者以及专业技术人员来说,CNKI是获取最新学术信息的重要平台。然而,CNKI对于爬虫的反爬虫措施较为严格,因此通过分布式爬虫抓取CNKI数据是一项既具挑战性又具价值的任务。它不仅可以提高信息获取的效率,还可以为数据驱动的研究提供便利。

1.3 分布式爬虫在CNKI的应用前景

随着机器学习和大数据分析的广泛应用,对大量高质量数据的需求不断增加。分布式爬虫在CNKI的应用前景广阔,不仅可以用于学术研究数据的收集,还可以拓展到市场分析、舆情监控等多个领域。通过合理设计和优化,分布式爬虫技术有望帮助用户在遵守法律法规和平台规则的前提下,高效地挖掘出CNKI中的宝贵信息资源。

2. 分布式爬虫基础理论与架构设计

2.1 分布式爬虫的工作原理

分布式爬虫作为一种高级的网络数据采集技术,它与传统的单机爬虫最本质的区别在于其并行处理能力和对大规模数据的处理能力。在深入讨论分布式爬虫的工作原理之前,有必要先了解爬虫的基本流程与数据流向。

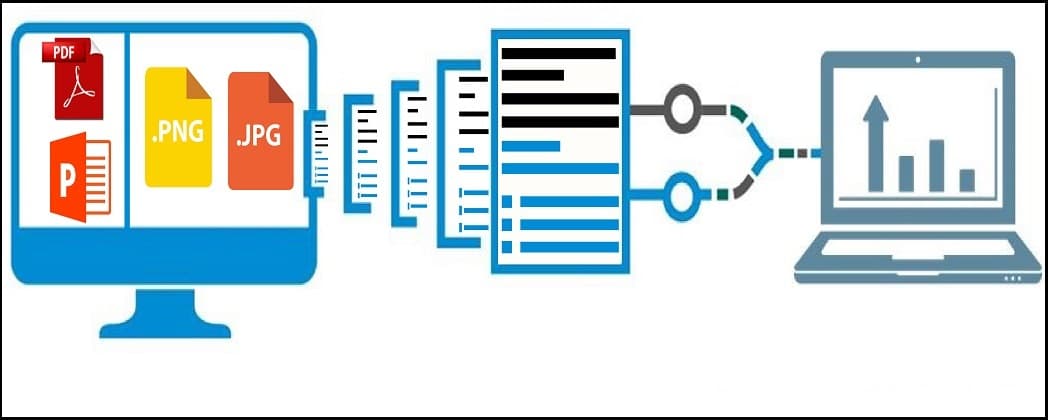

2.1.1 爬虫的基本流程与数据流向

一个基本的爬虫包括以下步骤:种子URL的初始化、页面下载、内容解析、URL提取、URL去重、再下载…如此循环,直到满足停止条件。这个过程,就好比是网络世界的矿工,在广袤的互联网中,根据规则寻找并“挖掘”数据。数据流向则从网页下载开始,经过解析器的处理,将结构化的数据存储起来,用于后续的分析与应用。

2.1.2 分布式爬虫与单机爬虫的区别

分布式爬虫通过多台机器协作完成任务,每个机器都相当于一个单机爬虫,但它们之间通过网络相互配合,共同完成对大规模数据的爬取。分布式爬虫的优势在于:

- 高并发性:多个爬虫实例可以并行工作,加快爬取速度。

- 负载均衡:通过合理调度,确保系统负载均衡,防止单点过载。

- 容错性:单个爬虫实例的失败不会影响整体爬取任务的执行。

- 易于扩展:根据任务的需要,可以动态地增加或减少爬虫实例的数量。

2.2 分布式爬虫的架构设计

2.2.1 分布式系统的基本组件

分布式爬虫系统主要包含以下几个基本组件:

- 调度器:负责管理和调度整个爬虫系统的运行,是爬虫系统的大脑。

- 下载器:负责网页内容的下载,可以有多个,以实现并行下载。

- 解析器:负责解析下载的网页内容,并从中提取出新的URL加入到待下载队列中。

- 存储器:负责存储爬取到的数据,可以是数据库、文件系统等。

2.2.2 数据分片与负载均衡策略

数据分片是将任务均匀分配给每个爬虫节点的过程,它与负载均衡策略密切相关。一个好的负载均衡策略能够确保每个爬虫节点工作量大致相同,提高整个系统的运行效率。

2.2.3 高可用性与故障转移机制

在分布式爬虫系统中,高可用性意味着系统能够持续运行,即使某一个节点发生故障。通过设置故障检测机制和自动故障转移,可以确保爬虫任务不因单点故障而中断。

2.3 分布式爬虫的请求调度策略

2.3.1 请求调度的算法与实现

请求调度算法是分布式爬虫高效运行的关键。常见的请求调度算法包括轮询调度、优先级调度、加权轮询调度等。通过合理的选择调度策略,可以提高爬虫的整体效率。

2.3.2 IP代理池的管理和使用

在爬取过程中,为了避免被目标网站识别并封锁,分布式爬虫需要使用代理IP池。代理IP池的管理包括代理的获取、有效性检测、使用轮询或随机等策略选择代理IP。

- // 示例代码块:IP代理池获取代理IP逻辑

- def get_proxy_from_pool(proxy_pool):

- proxy_list = []

- for proxy in proxy_pool:

- try:

- response = requests.get("http://ip-api.com/json/", proxies={"http": proxy, "https": proxy}, timeout=5)

- ip_info = response.json()

- if ip_info['status'] == 'success' and ip_info['query'] != ip_info['country']:

- proxy_list.append(proxy)

- except:

- pass

- return proxy_list

- proxy_pool = [...]

- available_proxies = get_proxy_from_pool(proxy_pool)

- selected_proxy = random.choice(available_proxies)

以上代码展示了如何从一个代理IP池中选择可用的代理IP。通过这种方式,可以保证爬虫在不断变化的IP环境中稳定工作。

接下来,将深入探讨分布式爬虫的实现细节,以及如何在实际操作中处理各种复杂情况。我们将聚焦于数据的高效抓取、大规模任务的调度,以及应对各种反爬虫机制的策略。

3. CNKI分布式爬取系统实战技巧

在深入探讨CNKI(中国知网)分布式爬取系统的实战技巧之前,我们需要明确CNKI数据的重要学术价值和商业应用前景。作为国内最全面的学术文献数据库之一,CNKI拥有大量珍贵的学术资源,包括期刊、论文、会议记录等。掌握如何从CNKI有效抓取数据,不仅对科研人员具有重要意义,对于数据分析师、市场研究者和其他专业人士也极具价值。

3.1 CNKI数据抓取策略

3.1.1 模拟登录与会话维持

CNKI数据抓取的第一步往往是模拟登录,以便能够访问那些受限于版权保护或付费的资源。模拟登录通常涉及发送带有用户认证信息的HTTP请求。我们可以使用Python语言中的requests库来实现这一过程。

- import requests

- from requests.cookies import RequestsCookieJar

- # 创建一个会话对象

- session = requests.Session()

- # 设置登录时的表单数据

- login_data = {

- 'username': 'your_username',

- 'password': 'your_password'

- }

- # 设置登录URL

- login_url = 'https://www.cnki.net/login.aspx'

- # 发送POST请求进行登录

- response = session.post(login_url, data=login_data)

- # 登录后的状态码应为200,表示登录成功

- if response.status_code == 200:

- print('登录成功')

- else:

- print('登录失败')

- # 持