R语言its包文本挖掘速成课:信息提取的科学方法

发布时间: 2024-11-04 19:18:11 阅读量: 34 订阅数: 29

OpenAir环境分析R语言包使用手册

# 1. R语言its包文本挖掘概述

## 1.1 文本挖掘的重要性与应用前景

文本挖掘是将非结构化的文本数据转化为有价值的知识和洞见的过程。随着信息技术的发展,大数据环境下产生了海量的文本数据,这促使文本挖掘技术变得日益重要。文本挖掘不仅能够帮助企业从大量的文本信息中提取关键信息,从而更好地理解市场趋势、客户意见、产品反馈,还可以为学术研究提供新的视角和方法。文本挖掘的应用领域广泛,包括但不限于市场分析、社交网络监控、情报收集、生物信息学等。

## 1.2 R语言its包的定位与功能概述

在众多文本挖掘工具中,R语言是一个开源的、功能强大的统计计算和图形工具,而its包(Information Tagging and Screening)是R语言的一个扩展包,专门用于文本数据的处理与分析。its包提供了一系列文本处理的函数和工具,它使得用户可以方便地执行文本清洗、分词、统计分析等操作。其易用性和可扩展性使其成为文本挖掘领域中不可或缺的工具之一,特别是在数据预处理和统计分析方面。

## 1.3 R语言its包与其他文本挖掘工具的比较

相较于其他流行的文本挖掘工具,如Python的NLTK或spaCy库,R语言的its包在统计分析方面有着独特的优势。它与R语言丰富的统计包和机器学习库无缝集成,能够支持从数据预处理到模型构建的整个工作流程。此外,R语言及其its包在数据科学社区中拥有良好的支持和广泛的应用基础,这为文本挖掘实践者提供了坚实的社区资源和学习平台。

# 2. 文本数据的获取与预处理

### 2.1 文本数据的来源和收集

在文本挖掘项目中,获取高质量的数据是至关重要的。数据来源广泛,包括网络爬虫技术、API接口以及公开数据集等。在这一部分,我们先来讨论这些数据获取方式的基础知识。

#### 2.1.1 网络爬虫技术基础

网络爬虫(Web Crawler),也被称为网络蜘蛛或网络机器人,是一种自动获取网页内容的程序或脚本。通过访问网站的URL,爬虫可以抓取网页内容并提取有用信息。在Python中,Scrapy和BeautifulSoup是常用的网络爬虫框架。

在使用网络爬虫时,应确保遵守网站的robots.txt规则以及相关法律法规,避免对网站造成不必要的负担。

```python

# 示例代码:使用requests和BeautifulSoup进行简单的网页内容抓取

import requests

from bs4 import BeautifulSoup

# 发送HTTP请求获取网页内容

response = requests.get('***')

response.raise_for_status() # 确保请求成功

# 解析网页内容

soup = BeautifulSoup(response.text, 'html.parser')

# 提取网页中的段落文本

paragraphs = soup.find_all('p')

for p in paragraphs:

print(p.get_text())

```

#### 2.1.2 使用API获取文本数据

应用程序接口(API)是提供数据访问的一种更为直接和结构化的方式。相较于网络爬虫,使用API可以更高效地获取结构化的数据,并且通常情况下对网站的影响更小。

许多公司和组织都提供了可供开发者使用的API,如Twitter API、Google Maps API等。API调用通常需要注册、申请密钥,并遵循调用限制。

```python

# 示例代码:使用requests库调用Twitter API获取数据

import requests

# Twitter API的URL和你的API密钥

url = '***'

params = {

'q': 'R语言 its包', # 查询关键词

'count': 10, # 返回的推文数量

'oauth_token': 'YOUR_OAUTH_TOKEN'

}

# 发送API请求

response = requests.get(url, params=params)

response.raise_for_status()

# 打印API返回的数据

print(response.json())

```

### 2.2 文本数据的预处理技巧

数据预处理是文本挖掘过程中的关键步骤,它包括清洗、分词、词干提取、停用词处理和处理文本稀疏性等多个方面。预处理质量直接关系到后续分析的准确性。

#### 2.2.1 文本清洗的基本步骤

文本清洗旨在去除无关信息,提高数据质量。通常的步骤包括去除HTML标签、标点符号、数字,转换大小写等。

```python

import re

# 示例文本

text = "<p>Hello World! This is a test.</p>"

# 移除HTML标签

text = re.sub(r'<[^<>]*>', '', text)

# 移除标点符号和数字

text = re.sub(r'[^A-Za-z\s]', '', text)

# 转换为小写

text = text.lower()

print(text)

```

#### 2.2.2 分词和词干提取的方法

分词是将句子分解为单独的词语,而词干提取是将词语还原为其基本形态。在R语言中,我们通常使用`tm`包来进行文本预处理。

```r

# 示例R代码:使用tm包进行分词和词干提取

library(tm)

# 创建文本源

docs <- VectorSource(c("I am walking", "I walk"))

# 创建文档-术语矩阵

dtm <- DocumentTermMatrix(docs)

# 应用词干提取

dtm <- tm_map(dtm, stemDocument)

```

#### 2.2.3 停用词和文本稀疏性处理

在文本分析中,停用词(如“的”,“是”,“在”等)通常不携带有效信息,需要被移除。文本稀疏性指的是数据矩阵中有很多零值的现象,这在文本挖掘中很常见。

处理方法包括使用停用词列表进行过滤,使用TF-IDF(词频-逆文档频率)等方法减少稀疏性。

```r

# R语言中移除停用词的示例

data("stopwords")

dtm <- removeWords(dtm, stopwords("english"))

```

### 2.3 its包在数据预处理中的应用

its包是R语言中的一个文本挖掘包,提供了丰富的函数和工具来帮助用户完成文本数据的预处理和转换。

#### 2.3.1 its包的数据导入和导出功能

使用its包,可以轻松地导入常见的文本数据格式,如TXT、PDF、HTML等,并将处理后的数据导出。

```r

# 示例R代码:导入文本数据

library(its)

# 从本地文件导入数据

data <- importText("example.txt")

# 导出数据到CSV文件

exportCSV(data, "processed_example.csv")

```

#### 2.3.2 its包的文本转换工具

its包提供了一系列文本转换工具,包括但不限于文本规范化、同义词处理、词性标注等。

```r

# 示例R代码:使用its包进行文本规范化

data <- importText("example.txt")

normalized_data <- normalizeText(data)

```

本章详细介绍了文本数据的获取方法和预处理技巧,包括爬虫技术、API的使用,以及如何清洗和处理文本数据以提高其质量。同时,本章也重点介绍了R语言its包在文本数据预处理中的应用,使读者能够掌握如何使用its包导入、清洗和转换文本数据。接下来,我们将深入探讨文本挖掘的统计分析方法,进一步了解如何通过分析文本数据来提取有用的信息和模式。

# 3. 文本挖掘中的统计分析方法

## 3.1 词频分析与词云生成

### 3.1.1 词频统计的实现与解读

词频分析(Term Frequency Analysis)是文本挖掘中最基础也是最常用的统计方法之一。它通过计算单个词语出现的频率,来确定文档集中最具代表性的词语,进而分析文本数据集的主题和内容。在R语言中,可以利用`its`包或其他文本处理相关包来实现词频统计。

```r

# 加载its包

library(its)

# 假设我们已经获取到一个文本数据集,命名为text_data

# 首先,我们需要将文本数据集转换为一个词频表(Term Frequency Table)

word_count <- term_frequency(text_data, lower.case = TRUE)

# 查看词频表

print(word_count)

# 基于词频表,我们可以进一步进行分析和解读

```

在上述代码中,`term_frequency`函数默认将所有文本转换为小写,并统计每个词语的出现频率。输出的词频表可以帮助我们快速了解哪些词语在文本数据集中出现的次数最多,从而对文本的主题内容有初步的把握。比如,若某一特定主题的文本数据集频繁出现“健康”、“治疗”等词,我们可以推测这些文本很可能与医疗健康领域相关。

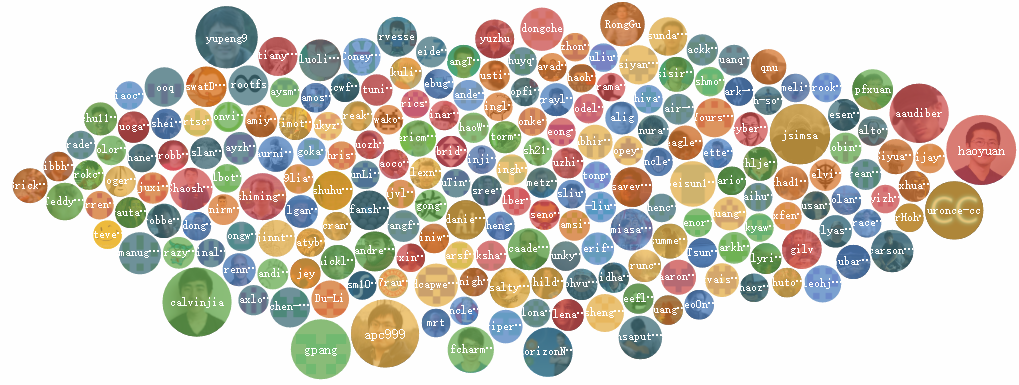

### 3.1.2 词云图的生成与定制

词云图(Word Cloud)是一种数据可视化技术,它通过词的大小来直观展示词语的频率或重要性。在文本挖掘中,词云图能够提供一种视觉上的快速理解,有助于识别

0

0