R语言XML包文本挖掘进阶技巧:解锁数据背后的秘密

发布时间: 2024-11-11 09:10:52 阅读量: 16 订阅数: 26

R语言环境下的文本挖掘.pdf

# 1. R语言与XML包的基础介绍

在数据科学和信息技术的领域中,R语言作为一款专门用于统计分析和图形表示的编程语言,已成为处理和分析数据的强大工具。特别是在文本挖掘领域,R语言通过其丰富的包支持,为数据分析师和研究人员提供了灵活多变的解决方案。本章将介绍R语言的基本概念,并着重讲解XML包在数据处理中的重要性以及其基础使用方法。

XML(eXtensible Markup Language)作为一种标记语言,广泛应用于各种数据存储和交换场景中。R语言中的XML包允许用户方便地读取、解析和操作XML数据。在接下来的内容中,我们会逐步介绍如何使用R语言中的XML包来处理XML格式的数据,从而为文本挖掘的深入分析打下坚实的基础。

```R

# 安装XML包

install.packages("XML")

library(XML)

# 读取XML数据的基本方法

xml_data <- xmlParse("path_to_your_xml_file.xml")

root <- xmlRoot(xml_data)

xml_name <- xmlName(root)

print(xml_name) # 打印根节点名称

```

通过上述基础代码示例,我们可以开始探索如何将XML数据读取到R语言环境中,这为后续的文本挖掘工作提供了数据输入的第一步。

# 2. R语言中的文本挖掘技术

### 2.1 文本数据的获取与预处理

#### 2.1.1 使用R语言获取XML数据

在文本挖掘项目中,从各种数据源获取文本信息是第一步。XML(Extensible Markup Language)因其结构化特性和普遍性,在网络上广泛分布,是数据获取的重要来源之一。R语言通过XML包提供了一套完善的函数库,使得处理XML数据变得简单直接。

```R

library(XML)

# 读取XML文件

doc <- xmlParse("example.xml")

# 解析XML文档,并提取特定节点

nodes <- getNodeSet(doc, "//path/to/node")

# 将节点内容转换为文本

text <- sapply(nodes, xmlValue)

```

以上代码段首先加载XML包,然后解析名为"example.xml"的文件,并获取指定路径的节点。节点内容使用`xmlValue`函数提取出来。通过这种方式,我们可以轻松地从复杂的XML结构中抽取所需的文本数据。

#### 2.1.2 文本数据清洗与标准化

获取原始文本数据后,接下来通常需要进行数据清洗和预处理。这是确保文本挖掘结果准确性的关键步骤。文本清洗可能包括去除空白字符、标点符号,转换为统一的字符编码,以及处理大小写不一致等问题。R语言中提供了多种字符串处理函数来实现这一目标。

```R

# 移除字符串中的标点符号

text <- gsub("[[:punct:]]", "", text)

# 将所有文本转换为小写

text <- tolower(text)

# 移除数字和特殊字符

text <- gsub("[^[:alpha:][:space:]]", "", text)

```

以上代码使用`gsub`函数实现文本的清洗,正则表达式用于匹配和替换特定模式的字符串。此外,文本标准化可能还需要去除停用词(如“的”,“是”,“在”等),这在文本挖掘中也很常见。

### 2.2 文本挖掘的理论基础

#### 2.2.1 文本挖掘的主要技术和方法

文本挖掘涉及到的技术和方法很多,但大体上可以分为以下几类:

1. **分类与回归分析**:利用文本特征建立预测模型,如垃圾邮件检测、情感分析等。

2. **聚类分析**:发现数据中的自然分组,如市场细分。

3. **关联规则学习**:发现变量间的有趣关联,如购物篮分析。

4. **主题模型**:发现文本集合中的隐含主题。

每种方法背后都有其数学模型和算法支撑,例如朴素贝叶斯算法用于分类,K-means算法用于聚类,Apriori算法用于关联规则学习,而LDA(Latent Dirichlet Allocation)用于主题模型。

#### 2.2.2 文本挖掘在数据分析中的作用

文本挖掘不仅限于处理文本本身,它在数据分析中的作用体现在多个层面上:

- **情感分析**:了解消费者对品牌、产品或服务的情感倾向。

- **趋势分析**:通过时间序列的文本挖掘发现数据中的模式和趋势。

- **信息抽取**:从非结构化文本中提取关键信息,如人名、地名、组织名等。

文本挖掘提供了从大量非结构化数据中提取有价值信息的能力,这对于数据分析和决策过程至关重要。

### 2.3 R语言进行文本挖掘的实践

#### 2.3.1 文本分词与词频分析

分词是将连续的文本切分成有意义的词语,是文本挖掘的前置步骤。R语言的tm(Text Mining)包为分词提供了丰富的工具。词频分析则是统计每个词语出现的次数,以了解文本数据中的主要内容。

```R

library(tm)

# 创建文本语料库

corpus <- Corpus(VectorSource(text))

# 分词和标准化处理

corpus <- tm_map(corpus, content_transformer(tolower))

corpus <- tm_map(corpus, removePunctuation)

corpus <- tm_map(corpus, removeNumbers)

corpus <- tm_map(corpus, removeWords, stopwords("en"))

corpus <- tm_map(corpus, stripWhitespace)

# 创建文档-词项矩阵(Term-Document Matrix, TDM)

tdm <- TermDocumentMatrix(corpus)

# 提取词频

word_freqs <- rowSums(as.matrix(tdm))

```

在这段代码中,我们首先使用`Corpus`函数创建一个语料库对象,然后对语料进行分词和标准化处理。最后,创建一个文档-词项矩阵,并计算每个词的频率。

#### 2.3.2 主题模型与文档聚类

主题模型和文档聚类是文本挖掘中的高级技术。主题模型可以帮助我们理解数据集中的主题分布,而文档聚类则可以将相似的文档聚集在一起。

```R

# 使用LDA模型进行主题建模

lda_model <- LDA(tdm, k = 5)

# 提取主题

topics <- terms(lda_model, topn = 10)

# 进行文档聚类

dcluster <- kmeans(as.matrix(tdm), centers = 5)

# 聚类结果可视化

clusplot(as.matrix(tdm), dcluster$cluster, color=TRUE, shade=TRUE, labels=2, lines=0)

```

在这段代码中,我们使用LDA算法来发现数据集中的主题,并通过`terms`函数提取每个主题的关键词。随后,使用`kmeans`函数对文档进行聚类,并使用`clusplot`函数对聚类结果进行可视化。

以上章节内容展示了如何使用R语言进行文本数据的获取、预处理、分词、词频分析、主题模型以及文档聚类。这些技术在文本挖掘项目中扮演着重要的角色,能够帮助数据科学家从大量的非结构化文本数据中提取有意义的见解。下一章节将详细介绍XML包在文本挖掘中的应用。

# 3. XML包在文本挖掘中的应用

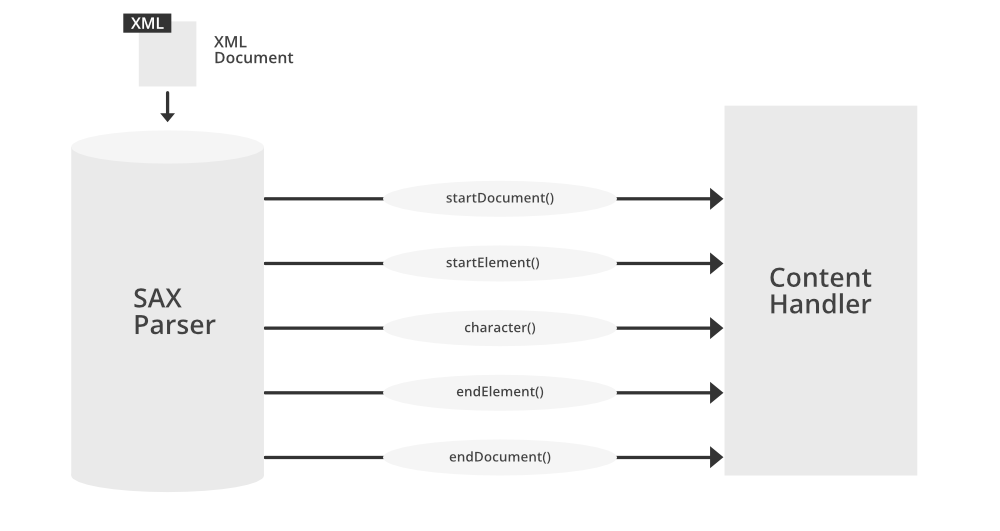

## 3.1 XML数据结构与R语言解析

### 3.1.1 XML文档的结构解析

XML(可扩展标记语言)是一种用于存储和传输数据的标记语言和文件格式。XML文档具有良好的层次结构,它以标签的形式组织数据,这些标签定义了数据的含义。理解XML文档的结构是有效解析和使用XML数据的第一步。

XML文档通常以一个声明标签开始,表明该文档是XML文档,并且可能包含版本和编码信息。紧接着声明的是根元素,所有其他元素都包含在根元素之内。在根元素内部,数据元素可以任意嵌套,形成一个树状结构。每个元素可以包含文本、属性或其他元素。

一个典型的XML文档结构如下所示:

```xml

<?xml version="1.0" encoding="UTF-8"?>

<root>

<element attribute="value">

Some text

<childElem

```

0

0