【MySQL大数据集成:融入大数据生态】

发布时间: 2024-11-14 22:59:35 阅读量: 8 订阅数: 17

# 1. MySQL在大数据生态系统中的地位

在当今的大数据生态系统中,**MySQL** 作为一个历史悠久且广泛使用的关系型数据库管理系统,扮演着不可或缺的角色。随着数据量的爆炸式增长,MySQL 的地位不仅在于其稳定性和可靠性,更在于其在大数据技术栈中扮演的桥梁作用。它作为数据存储的基石,对于数据的查询、分析和处理起到了至关重要的作用。

## 2.1 数据集成的概念和重要性

数据集成是一个将不同来源、格式、特性的数据在逻辑上或物理上合并在一起的过程,它对于企业的数据分析、决策制定以及业务流程的优化至关重要。

### 2.1.1 数据集成定义

数据集成确保了数据在多个系统或数据库之间能够无缝流动,这对于维持业务连续性和提高运营效率是必不可少的。通过数据集成,组织能够整合分散的数据源,提供一个统一的视图以供查询和分析。

### 2.1.2 数据集成的目标与挑战

数据集成的目标包括数据的一致性、完整性和准确性。然而,在实施过程中,数据质量控制、数据格式不一致、数据安全和隐私保护等问题会成为挑战。这些挑战需要通过精心设计的策略和工具来克服。

在下一章节中,我们将深入探讨MySQL在数据集成中的架构和数据处理能力,并探索数据集成的常用技术与策略。

# 2. MySQL数据集成的基础理论

## 2.1 数据集成的概念和重要性

### 2.1.1 数据集成定义

数据集成(Data Integration)是将多个异构数据源的信息抽取、转换,并统一加载到一个目标系统的过程。这个目标系统可以是一个数据仓库、数据湖或者其他形式的数据集合。数据集成的关键在于确保不同来源的数据能够无缝地合并,为最终用户提供一致、可靠的数据服务。

在数据集成的场景中,通常需要处理结构化数据和非结构化数据。结构化数据,比如存储在MySQL数据库中的表格数据,和非结构化数据(如文本、图像和视频)之间的转换和融合是数据集成面临的常见挑战之一。

### 2.1.2 数据集成的目标与挑战

数据集成的目标主要体现在以下几个方面:

- **统一视图**:为用户提供统一的数据视图,屏蔽数据来源的差异。

- **数据质量保证**:提高数据的准确性和一致性,消除数据冗余。

- **实时数据访问**:实现数据的实时或近实时集成,快速响应用户查询。

- **扩展性**:支持数据源和数据量的扩展,以适应业务增长。

在实现数据集成的过程中,会遇到各种挑战:

- **数据格式不统一**:不同数据源可能采用不同的数据格式和标准。

- **数据清洗和转换**:需要对数据进行预处理,以确保数据质量。

- **性能优化**:大量的数据集成可能会对系统性能造成压力。

- **数据安全和隐私**:在数据传输和存储过程中,确保数据安全和遵守隐私法规。

## 2.2 MySQL的架构与数据处理能力

### 2.2.1 MySQL架构简述

MySQL是一个多线程、多用户的关系型数据库管理系统,采用客户端-服务器架构。其核心组件包括:

- **连接管理器**:负责处理客户端连接、授权认证等。

- **SQL接口**:接收用户的SQL命令,并返回结果。

- **查询解析器**:分析SQL语句的语法和结构。

- **优化器**:选择最高效的查询路径。

- **缓存和缓冲**:提高数据检索性能,减少磁盘I/O操作。

- **存储引擎**:负责MySQL中数据的存储和提取,支持多种存储引擎如InnoDB、MyISAM等。

### 2.2.2 MySQL的数据处理和优化

MySQL提供了多种机制来优化数据处理能力:

- **索引**:通过索引提高查询效率。

- **查询缓存**:缓存查询结果,减少对磁盘的访问。

- **存储过程和触发器**:在服务器端执行复杂的业务逻辑。

- **分区表**:将大表分割为多个小表,提高管理效率和查询性能。

在数据集成场景中,MySQL的存储过程可以用于数据清洗、转换等复杂的预处理工作。此外,触发器可以用于同步更新数据,保证数据的一致性。

## 2.3 数据集成的常用技术与策略

### 2.3.1 ETL流程解析

ETL(Extract, Transform, Load)是数据集成中常见的技术流程。它包括三个主要步骤:

- **提取(Extract)**:从源系统抽取数据,支持多种数据格式和接口。

- **转换(Transform)**:对数据进行清洗、转换和格式化,以便在目标系统中使用。

- **加载(Load)**:将处理后的数据加载到目标数据存储中,如数据仓库或数据湖。

MySQL通过多种工具和技术实现ETL流程,例如使用自定义函数和存储过程来实现数据转换,以及利用外部工具(如Apache NiFi、Talend等)来进行数据抽取和加载。

### 2.3.2 数据集成策略与模型

数据集成策略是为解决特定业务问题而设计的数据集成方法。常见的数据集成模型包括:

- **星型模式和雪花模式**:数据仓库中用于组织数据的两种模式。

- **总线架构**:使用共享维度模型,维护企业数据的一致性。

- **数据湖**:存储大量结构化和非结构化数据,便于进行大数据分析。

选择合适的数据集成策略和模型,可以更好地满足业务需求和适应数据集成的挑战。

**请注意**:为确保内容丰富性和连贯性,本章节的展示内容在实际应用时可能需要根据具体需求进行扩展和调整。在实际操作中,对于每个技术点或概念,应结合具体的业务案例和数据集成方案进行深入探讨。

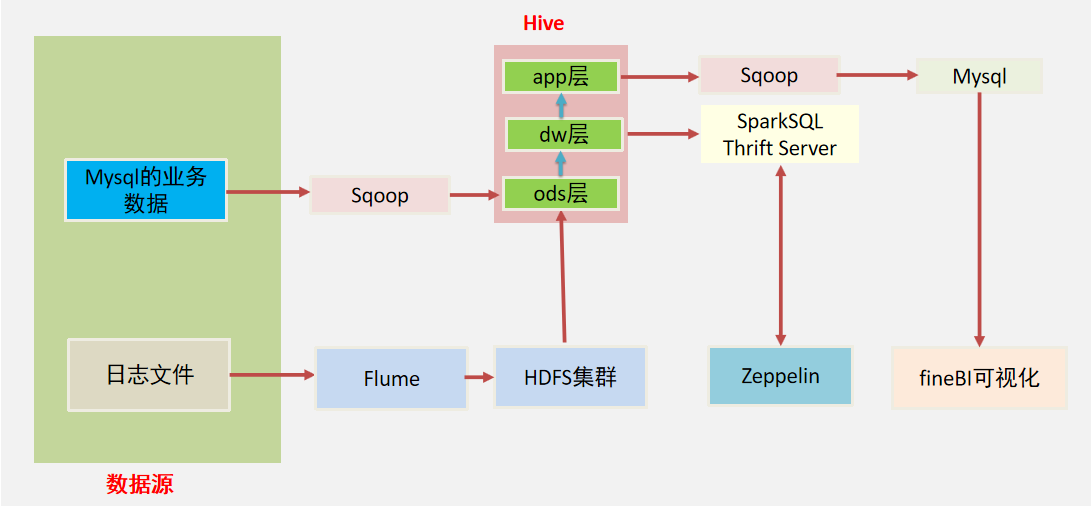

# 3. MySQL到大数据平台的数据迁移实践

## 3.1 数据迁移的理论基础

### 3.1.1 数据迁移的必要性

在大数据时代,数据的体量和价值日益增长,企业开始寻求更高效的存储和分析解决方案。原有的数据存储架构,如MySQL,虽在OLTP(在线事务处理)方面表现出色,但在处理大规模数据集的OLAP(在线分析处理)任务时,可能会遇到性能瓶颈。因此,数据迁移成为企业实现数据生命周期管理、提高数据处理能力和扩展性的必要步骤。数据迁移不仅意味着将数据从一个系统转移到另一个系统,更涉及到数据整合、数据同步和数据可用性等多个层面。

### 3.1.2 数据迁移的技术选择

数据迁移的技术选择至关重要,它决定了迁移的成功与否。一般来说,数据迁移的方法包括:

1. 编写自定义脚本:适用于小规模数据迁移,灵活性高,但工作量大,容易出错。

2. 使用专业数据迁移工具:市面上存在许多商业和开源的数据迁移工具,如Apache NiFi、Talend等。

3. 利用ETL工具:这类工具如Informatica、DataStage等,擅长处理复杂的数据转换和清洗工作。

选择合适的技术时,需考虑源数据和目标数据的格式兼容性、数据量大小、迁移频率、数据转换需求、预算和团队技能等因素。

## 3.2 实操:MySQL到Hadoop的数据迁移

### 3.2.1 使用Sqoop进行数据导入导出

Sqoop是一个开源工具,

0

0