【Moloch+ELK集成方案】:打造一体化网络取证与日志分析平台

发布时间: 2024-12-13 19:17:12 阅读量: 9 订阅数: 8

CDMCS:网络防御监控课程套件:: TICK,Suricata,Moloch

参考资源链接:[moloc教程:多性状遗传共定位分析](https://wenku.csdn.net/doc/opgzddj2jt?spm=1055.2635.3001.10343)

# 1. Moloch+ELK集成方案概述

## 1.1 系统集成的背景和必要性

在当前网络安全领域中,威胁检测与响应是IT团队面临的一项持续挑战。传统的安全监控系统存在一定的局限性,而通过将Moloch与ELK (Elasticsearch, Logstash, Kibana) Stack集成,可以构建一个高性能的网络取证和日志分析平台。Moloch提供了大规模网络流量捕获的功能,而ELK Stack则在日志数据处理和可视化方面表现出色。这种组合不仅可以帮助安全分析师快速检索和分析数据,还能够提升整个监控系统的效率和准确性。

## 1.2 Moloch+ELK集成的优势

集成Moloch和ELK Stack的优势在于能够结合两者的优势,提供一套完整的解决方案。Moloch以其强大的数据捕获能力,保证了网络流量的完整性,而ELK Stack则能够对Moloch捕获的数据进行有效的索引、存储、搜索和可视化。此外,这种集成方案还有助于实现日志数据与网络流量数据的关联分析,进一步增强了安全分析的深度和广度。最终,系统管理员和安全分析师可以通过这样的集成方案,更快捷地识别和响应安全事件。

## 1.3 预期目标与应用场景

目标在于创建一个能够实时处理和分析大规模数据的系统,该系统应当能够高效地支持安全事件的取证分析。集成的Moloch+ELK平台预期将应用于以下几个核心场景:

- 网络安全监测:持续监控网络流量,快速发现异常行为。

- 日志分析:对服务器、应用和网络设备的日志进行深入分析。

- 安全事件调查:通过高效的搜索和可视化技术,帮助安全专家对历史数据进行回溯分析。

- 法规遵从:记录、索引和分析数据以满足合规性和审计的需求。

通过这些应用场景的实践,Moloch+ELK集成方案将有效地提升组织对网络威胁的响应能力和整体安全态势的掌控力。

# 2. Moloch的安装与配置

## 2.1 Moloch的系统要求和安装步骤

### 2.1.1 硬件和软件环境准备

在安装Moloch之前,首先需要确保你的系统满足Moloch的最低要求。Moloch是一款开源的网络流量记录和索引工具,适用于需要对网络流量进行深入分析的场合。硬件方面,Moloch对处理器和内存的要求并不高,但为了处理高速网络流量,一块高性能的网络接口卡(NIC)是必须的。软件方面,Moloch可以在多种Linux发行版上运行,包括Ubuntu、CentOS等。

### 2.1.2 安装Moloch的详细流程

安装Moloch的步骤可以分为以下几个关键步骤:

1. **安装依赖包**

在基于Debian的系统上,使用以下命令安装所需的依赖包:

```bash

sudo apt update

sudo apt install -y nginx git nodejs npm redis-server

```

2. **安装MongoDB**

Moloch使用MongoDB作为其后端存储数据库,可以使用以下命令进行安装:

```bash

wget -qO - https://www.mongodb.org/static/pgp/server-4.4.asc | sudo apt-key add -

echo "deb [ arch=amd64,arm64 ] https://repo.mongodb.org/apt/ubuntu $(lsb_release -cs)/mongodb-org/4.4 multiverse" | sudo tee /etc/apt/sources.list.d/mongodb-org-4.4.list

sudo apt update

sudo apt install -y mongodb-org

```

3. **安装Moloch**

下载Moloch源代码,并安装:

```bash

git clone https://github.com/aol/moloch.git

cd moloch

npm install

npm run setup

npm run start

```

通过上述步骤,Moloch应该已经在你的服务器上运行了。接下来,你需要进行相应的配置,以确保Moloch可以正确地捕获和索引网络流量。

## 2.2 Moloch的数据捕获与索引机制

### 2.2.1 数据捕获的原理与设置

Moloch使用pcap(Packet Capture)工具来捕获网络流量。pcap可以捕获经过指定网络接口的所有数据包。Moloch提供了自己的pcap服务,可以被配置为后台运行,定期轮换pcap文件,以避免单个文件过大导致索引问题。

要启动pcap服务,可以使用以下命令:

```bash

cd /path/to/moloch/bin

sudo ./pcap-service -i eth0

```

上述命令会在名为eth0的网络接口上捕获数据包。你可以根据实际需要更改网络接口名称。此服务会在后台运行,并将捕获的pcap文件存储在`/data/pcap`目录下。

### 2.2.2 索引创建与管理策略

Moloch使用Elasticsearch作为其索引后端。安装Elasticsearch时,你应该选择与Moloch兼容的版本。安装和配置Elasticsearch之后,需要修改Moloch的配置文件,以连接到Elasticsearch实例。这通常在`/etc/moloch.cnf`文件中完成,需要指定Elasticsearch服务器的地址和端口:

```ini

elasticsearchNodes=http://localhost:9200

```

此外,Moloch支持创建多个索引,用于管理不同时间范围内的数据。这可以通过设置`rotateIndexAt`参数来实现,该参数允许你指定索引达到一定大小或者在特定时间后进行轮换。例如,如果你希望每天创建一个新的索引,可以在配置文件中设置:

```ini

rotateIndexAt=midnight

```

## 2.3 Moloch的高级配置

### 2.3.1 存储与备份策略

Moloch提供了多种存储和备份选项,以便于管理pcap文件和索引数据。例如,你可以配置pcap文件在经过一段时间后自动删除,以节省存储空间:

```ini

pcapTtlDays=30

```

此外,Moloch支持多种备份机制,例如快照备份。可以通过Elasticsearch的快照功能,定期对索引进行备份,以防数据丢失。

### 2.3.2 安全与访问控制配置

为了保护Moloch的安全,你可以设置用户名和密码进行访问控制,限制谁可以查看pcap文件和数据。这些设置可以在Moloch配置文件中完成:

```ini

user=your_username

password=your_password

```

同时,Moloch还支持SSL加密连接,确保数据在传输过程中的安全。安装证书后,确保配置文件中指向正确的证书路径:

```ini

useSSL=1

key=/path/to/your/ssl/key.key

cert=/path/to/your/ssl/cert.crt

```

通过这些高级配置,你可以确保Moloch不仅功能强大,同时也具备了必要的安全特性,以适应各种不同的环境需求。

以上是Moloch安装与配置的详细内容。接下来的章节将探讨ELK Stack的安装与配置,以及如何将Moloch与ELK集成,从而构建一个强大的日志分析和可视化平台。

# 3. ELK Stack的安装与配置

## 3.1 ELK Stack的组件介绍与安装

### 3.1.1 Elasticsearch、Logstash、Kibana的介绍

在日志管理和分析领域,ELK Stack是由Elasticsearch、Logstash和Kibana三个核心组件构成的解决方案,它们共同工作以实现高效且强大的数据处理能力。

- **Elasticsearch** 是一个实时的分布式搜索和分析引擎。它能够快速存储、搜索和分析大量数据。Elasticsearch 是一个基于 Apache Lucene 的开源搜索引擎,它提供了简单易用的REST API,因此它常被用作应用的全文搜索引擎。此外,它还具备强大的数据聚合和可视化能力,使得它在日志分析领域尤为突出。

- **Logstash** 是一个数据处理管道,能够一次进行多种类型的数据处理,包括从不同源收集数据、数据过滤和解析以及将数据输出到不同的目的地。Logstash 通过各种插件支持广泛的数据源输入和数据格式,如文件、syslog、数据库,以及JSON、CSV等格式。

- **Kibana** 是一个数据可视化平台,它依赖于Elasticsearch存储的数据来提供实时的数据分析和可视化界面。Kibana 允许用户创建图表、仪表板和数据视图,帮助用户从日志数据中提取洞察和趋势。它提供丰富的图表类型和交互式探索功能。

### 3.1.2 安装ELK Stack的步骤和注意事项

安装ELK Stack涉及几个关键步骤,确保了组件间的兼容性和稳定性。下面是安装ELK Stack的基本步骤:

1. **设置Java环境**:因为Elasticsearch需要Java运行环境,所以首先需要确保系统中安装了正确版本的Java(推荐使用OpenJDK 1.8)。

2. **下载安装包**:从Elasticsearch官网下载与操作系统相匹配的Elasticsearch和Kibana安装包。

3. **安装Elasticsearch**:解压下载的文件,并进行相应的配置。主要需要调整`elasticsearch.yml`配置文件,设置集群名称、节点名称等。

4. **启动Elasticsearch**:运行`bin/elasticsearch`来启动服务,并检查服务是否正常运行。

5. **安装Logstash**:同上,解压Logstash安装包并根据需求配置`logstash.conf`文件,该文件定义了数据输入、过滤和输出的管道。

6. **启动Logstash**:通过命令`bin/logstash -f logstash.conf`启动Logstash,并确保数据可以被正确处理和输出。

7. **安装Kibana**:与Elasticsearch类似,解压并配置Kibana的`kibana.yml`文件。

8. **启动Kibana**:运行`bin/kibana`启动服务,并通过浏览器访问Kibana的Web界面进行数据的可视化。

**注意事项**:

- **版本兼容性**:安装ELK Stack时,确保各个组件的版本兼容。在Elasticsearch官网提供的文档中,可以找到各个版本的ELK Stack的兼容性说明。

- **系统资源**:Elasticsearch是一个资源消耗大户,根据数据量和查询负载的预期,合理分配内存和CPU资源。

- **网络配置**:对于生产环境,建议对Elasticsearch和Logstash进行网络安全配置,确保数据的安全性和服务的稳定性。

- **数据持久化**:Elasticsearch依赖于文件系统,确保使用高性能的存储系统,并对数据进行定期备份。

- **监控和日志**:在部署期间,应该设置好监控工具和日志记录,以便于问题追踪和性能调优。

下面的表格展示了针对不同操作系统推荐的安装命令:

| 操作系统 | Elasticsearch安装命令 | Logstash安装命令 | Kibana安装命令 |

|-----------|------------------------|-------------------|----------------|

| Debian/Ubuntu | `dpkg -i elasticsearch-7.10.0-amd64.deb` | `dpkg -i logstash-7.10.0-amd64.deb` | `dpkg -i kibana-7.10.0-amd64.deb` |

| Red Hat/CentOS | `rpm -ivh elasticsearch-7.10.0-x86_64.rpm` | `rpm -ivh logstash-7.10.0-x86_64.rpm` | `rpm -ivh kibana-7.10.0-x86_64.rpm` |

接下来,我们详细介绍ELK的数据处理流程。

# 4. ```

# 第四章:Moloch与ELK的集成实践

## 4.1 集成方案架构设计

### 4.1.1 系统整体架构概述

在本集成方案中,Moloch与ELK Stack的结合构成了一个强大的日志分析和网络取证平台。架构设计旨在实现高效的数据捕获、存储、分析和可视化。在设计过程中,我们着重考虑了系统的可扩展性、安全性和弹性。

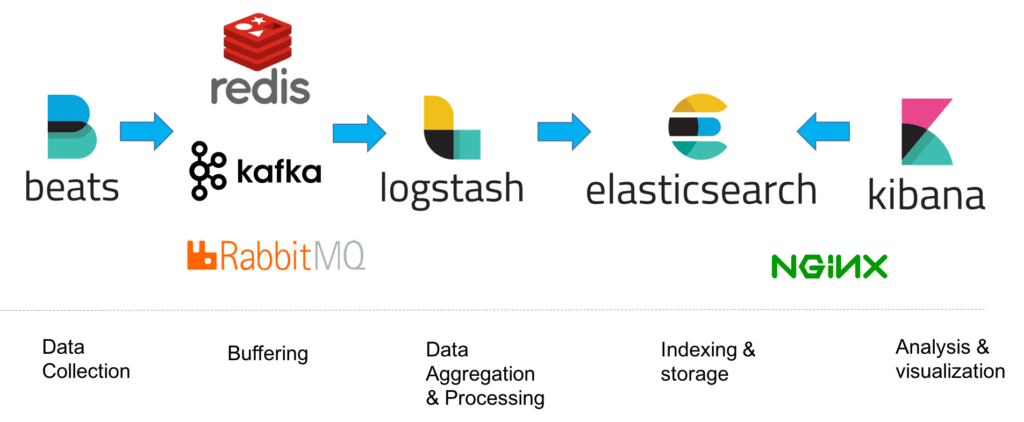

系统核心由两个主要组件构成:Moloch和ELK Stack。Moloch负责原始数据的捕获和索引,它能够处理大规模的网络流量数据,为后续分析提供基础数据。而ELK Stack则负责对这些数据进行处理、索引和可视化。Logstash作为数据处理管道,负责接收Moloch转储的数据并对其进行清洗、转换等操作。Elasticsearch作为后端搜索引擎,对清洗后的数据进行索引,并为Kibana提供数据支持。Kibana则作为用户界面,提供强大的交互式数据可视化功能。

架构设计采用了模块化和分层的方法。数据捕获层由Moloch组成,数据处理层由Logstash构成,数据存储与搜索层由Elasticsearch构成,数据可视化与交互层由Kibana构成。这种设计不仅有利于各个组件的独立优化,也便于将来对系统的扩展和维护。

### 4.1.2 数据流向与处理流程

数据流向清晰是集成架构设计的关键。Moloch捕获网络流量数据,并将这些数据以PCAP格式存储和索引。数据捕获后,ELK Stack介入数据处理流程。Logstash读取Moloch生成的索引文件,将其中的数据提取出来,并根据配置对数据进行必要的转换和过滤。处理后的数据被推送到Elasticsearch中存储并建立索引,以备后续分析使用。Kibana通过与Elasticsearch的交互,为用户提供实时数据分析和可视化的操作界面。

为了确保数据处理流程的高效和准确,集成方案中还加入了中间件和缓存机制。例如,使用消息队列(如RabbitMQ)作为Logstash和Elasticsearch之间的缓冲,以处理数据量大时可能出现的瓶颈。此外,还可能采用缓存策略(如Redis)来加速数据查询响应。

## 4.2 集成配置与优化

### 4.2.1 Moloch与Logstash的对接

将Moloch与Logstash对接的配置是集成实践中的关键步骤。Moloch将PCAP文件存储在本地或共享存储系统上,Logstash需要被配置为能够读取这些文件,并对其中的数据进行处理。

首先,需要在Logstash配置文件中定义一个输入插件,指向Moloch存储PCAP文件的位置。Logstash通过file插件来监控指定目录下的文件变动,并且设置为逐行读取模式,以处理PCAP文件中的每一行数据。

```conf

input {

file {

path => "/path/to/moloch/captured/data/*.pcap"

start_position => "beginning"

sincedb_path => "/dev/null"

codec => multiline {

pattern => "^(?:\\d{2}[:-]){5}"

negate => true

what => "previous"

}

}

}

```

此代码块定义了Logstash的输入部分,`path` 指定了Moloch存储PCAP文件的目录,`codec` 则配置了多行模式以处理多行事件。请注意,此配置片段仅为示例,实际部署时需要根据具体情况调整。

接下来,定义过滤器和输出插件。过滤器部分用于数据的清洗、转换,将PCAP文件中的二进制数据解析为可读格式。输出插件则是将处理后的数据发送到Elasticsearch。

### 4.2.2 Elasticsearch与Kibana的整合

为了优化数据检索和分析的速度,需要在Elasticsearch中预先定义好相关的索引模式和映射。这可以通过创建索引模板来实现,索引模板可以包含映射定义、设置以及别名等。

```json

PUT _template/moloch_data_template

{

"template": "moloch-*",

"settings": {

"number_of_shards": 1,

"number_of_replicas": 1

},

"mappings": {

"properties": {

"ts": {

"type": "date"

},

"pcap_cnt": {

"type": "integer"

}

// 其他字段映射定义...

}

}

}

```

此JSON代码块展示了如何创建一个Elasticsearch索引模板,其中包括了索引的模式匹配、索引设置和字段映射。

在Kibana中,通过定义可视化和仪表板来展示分析结果。Kibana仪表板由多种可视化组件构成,包括各种图表、地图、表格等。Kibana允许用户通过拖放的方式来自定义仪表板的布局,这大大降低了可视化设计的复杂性。对于数据分析,可以配置警报和通知规则,及时响应关键指标的变化。

## 4.3 实战演练:构建取证与分析场景

### 4.3.1 网络流量的捕获与分析

为了模拟网络取证分析场景,需要构建一个能够捕获网络流量的环境。在本例中,我们将使用Moloch来捕获网络流量数据,并通过ELK Stack对这些数据进行深入分析。

首先,确保Moloch已经正确安装并配置。在Moloch界面中设定网络捕获的参数,如捕获接口、过滤规则等。一旦配置完成,Moloch将开始实时捕获网络流量,并将捕获的数据转换为PCAP文件存储在本地。

接下来,通过Logstash读取Moloch生成的PCAP文件,并提取其中的数据进行分析。Logstash配置文件中的过滤器部分可以定义解析规则,例如使用`pcap`插件来解析网络流量数据:

```conf

filter {

pcap {

# ...配置参数

}

}

```

数据清洗和转换完成后,将数据推送到Elasticsearch中进行索引。在Elasticsearch中,可以预设相关的索引模板以优化索引的创建和管理。

### 4.3.2 日志数据的索引与可视化

在本场景中,我们关注于如何通过ELK Stack对日志数据进行索引和可视化。ELK Stack通过Logstash对日志数据进行处理,并使用Elasticsearch存储和索引数据。最后,Kibana用于展示数据的可视化分析结果。

首先,配置Logstash从指定的日志源中读取数据。可以在Logstash配置文件中定义多个input插件,用于读取不同格式和类型的日志文件:

```conf

input {

file {

path => "/var/log/syslog"

start_position => "beginning"

}

# 其他日志文件输入配置...

}

```

在过滤器部分,根据需要对日志数据进行清洗和转换。例如,使用`grok`插件可以将非结构化的日志数据转换为结构化数据,便于后续的分析和索引。

```conf

filter {

grok {

match => { "message" => "%{SYSLOGLINE}" }

}

}

```

经过处理的数据随后被推送到Elasticsearch中索引。在Elasticsearch中,同样需要根据数据的特点来调整索引模式和映射。一旦数据被索引后,就可以通过Kibana创建可视化仪表板。用户可以根据需要定义各种可视化组件,如条形图、折线图、饼图等,来展示日志数据分析的结果。

通过本节的实战演练,我们成功构建了一个网络取证与日志分析的集成环境,展示了如何捕获、存储、分析和可视化数据。这样的集成实践,对于IT安全和运维人员来说,具有很高的实用价值和参考意义。

```

# 5. Moloch+ELK平台的安全与性能优化

## 5.1 安全性提升策略

### 5.1.1 权限控制与认证机制

为了确保数据的安全性,Moloch和ELK平台都提供了复杂的权限控制和认证机制。在Moloch中,管理员可以根据用户角色和权限对访问进行精细控制。例如,使用预定义的角色如“只读”、“编辑”或“管理员”,或者创建自定义角色,以满足特定的安全需求。在ELK中,使用基于角色的访问控制(RBAC)来限制对Kibana和Elasticsearch的访问。X-Pack插件增加了额外的安全层,支持SSL/TLS加密通信、Kerberos、Active Directory和LDAP集成。

### 5.1.2 数据加密与安全审计

数据在传输和存储时都应当加密。在Moloch中,可以配置SSL/TLS来加密传输过程中的数据,并对存储在磁盘上的数据进行加密。在ELK中,同样可以通过配置X-Pack插件来加密节点间的数据传输,以及对Elasticsearch的快照进行加密。此外,审计日志是任何安全策略的关键组成部分,能够提供关于用户活动的详细信息。Moloch和ELK都能够记录详细的访问和操作日志,用于后续的安全审计和合规性检查。

## 5.2 性能优化技术

### 5.2.1 系统性能监控与分析

性能监控是优化的关键步骤。使用工具如Elasticsearch的Marvel插件或Kibana中的ElastAlert可以实时监控ELK集群的健康状态和性能指标。对于Moloch,可以检查捕获进程的性能和存储资源的使用情况。当系统出现性能瓶颈时,通常首先分析CPU、内存、磁盘I/O和网络带宽的使用情况,然后根据监控结果进行相应调整。

### 5.2.2 调优实践与案例分享

调优实践应根据具体的使用场景和负载来定制。例如,调整Elasticsearch的堆内存大小,优化Logstash的管道配置,或者更改Moloch的索引大小限制。调优时需要注意系统的整体平衡,避免过度优化某一组件导致其他组件成为瓶颈。在实际案例中,一家大型企业的IT团队分享了他们通过增加节点数、扩展硬件资源并适当配置索引生命周期管理来提高查询响应速度的成功经验。

## 5.3 持续扩展与维护

### 5.3.1 平台升级与兼容性处理

随着技术的发展,Moloch和ELK都需要定期升级以获得最新的安全补丁和性能改进。升级过程中,应确保新旧版本之间具有良好的兼容性。升级前,要充分测试升级流程和新版本的功能,确保数据迁移的安全性和完整性。升级时,建议先在测试环境中执行,然后再在生产环境中进行。在升级过程中,采取回滚计划以应对可能的问题。

### 5.3.2 日志管理与法规遵循

法规遵循对于维护企业和组织的合法性至关重要。日志管理应该遵守相关法规和政策,比如GDPR或HIPAA。Moloch和ELK都应配置合规的保留策略,保证日志数据的完整性,防止未经授权的访问,并提供必要的日志报告功能。在记录和管理日志时,应考虑数据的匿名化处理,以保护用户隐私。

通过上述分析,我们可以看出Moloch+ELK平台的优化不仅需要关注单个组件,还需要从整体架构出发,深入挖掘并解决系统性能和安全性问题。持续的监控、维护与优化工作是确保平台稳定运行的基石。

0

0