Spark大数据分析引擎:快速处理海量数据,挖掘数据价值

发布时间: 2024-08-26 16:20:25 阅读量: 24 订阅数: 31

# 1. Spark大数据分析引擎概述**

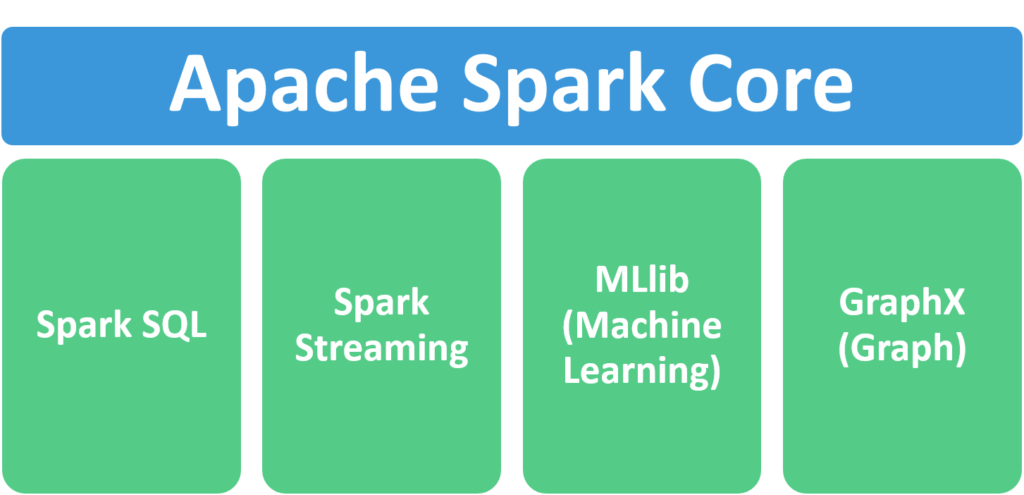

Apache Spark是一个用于大规模数据处理的统一分析引擎。它提供了分布式计算、数据查询、机器学习和流处理等多种功能,可以高效处理海量数据。Spark基于弹性分布式数据集(RDD)的概念,允许在分布式集群上并行处理数据,从而实现高性能和可扩展性。

Spark的架构包括一个主节点(Driver)和多个工作节点(Worker)。主节点负责任务调度和资源管理,而工作节点负责实际的数据处理。RDD是Spark中的一种核心数据结构,它表示分布在集群中的数据集,可以被弹性地分区和重新分区,以优化数据处理过程。

# 2. Spark核心组件和原理

### 2.1 Spark架构和分布式计算模型

#### 2.1.1 Spark集群架构

Spark集群由一个称为Driver的中央协调器和多个称为Executor的分布式工作节点组成。Driver负责将应用程序分解为较小的任务,并将其分配给Executor执行。Executor在集群中的不同节点上运行,并负责处理数据和执行计算。

#### 2.1.2 RDD(弹性分布式数据集)

RDD(弹性分布式数据集)是Spark的核心数据结构,它表示分布在集群中的不可变数据集。RDD可以并行处理,并且可以容忍节点故障。RDD支持两种操作:转换和操作。转换创建一个新的RDD,而操作返回一个值。

### 2.2 Spark核心组件

#### 2.2.1 SparkContext

SparkContext是Spark应用程序的入口点。它负责创建RDD,管理集群资源,并协调Executor之间的通信。

```scala

// 创建一个SparkContext

val sc = new SparkContext("local[*]", "My Spark App")

```

#### 2.2.2 Spark SQL

Spark SQL是一个用于结构化数据处理的模块。它提供了一个类似于SQL的查询语言,允许用户查询和操作RDD中的数据。

```scala

// 创建一个DataFrame

val df = sc.read.json("data.json")

// 使用SQL查询DataFrame

df.createOrReplaceTempView("my_table")

val result = sc.sql("SELECT * FROM my_table")

```

#### 2.2.3 MLlib(机器学习库)

MLlib是Spark的一个机器学习库,它提供了一系列机器学习算法和实用程序。这些算法可以用于分类、回归、聚类和降维等任务。

```scala

// 导入MLlib库

import org.apache.spark.ml.classification.LogisticRegression

// 创建一个LogisticRegression模型

val lr = new LogisticRegression()

// 训练模型

val model = lr.fit(trainingData)

```

### 2.3 Spark数据处理流程

Spark数据处理流程包括以下步骤:

1. **加载数据:**使用SparkContext的`read`方法从各种数据源加载数据。

2. **转换数据:**使用RDD的转换操作(如`map`、`filter`和`

0

0