PyTorch数据集划分的性能考量

发布时间: 2024-12-12 03:15:12 阅读量: 12 订阅数: 10

pytorch练手数据集

# 1. PyTorch数据集划分基础

在机器学习和深度学习领域,合理划分数据集是构建有效模型的关键步骤。本章将介绍PyTorch中数据集划分的基本方法,为后续更深入的理论与实践打下基础。我们会从数据集划分的基本概念讲起,讨论其在模型开发中的重要性,为读者提供一个清晰的起点。

首先,数据集划分是将整体数据集分割为训练集、验证集和测试集三个子集的过程。训练集用来训练模型,验证集用于模型调优,测试集则是最终评估模型性能的基准。这三个部分各有其独特的作用,不可混用,也不可忽视。

随着我们深入了解PyTorch中的数据集划分实现,我们会逐步探索数据集划分对于模型性能的影响,并介绍实现数据集划分的策略与方法。这包括随机划分方法,分层划分方法,以及K折交叉验证等高级技术。掌握这些方法,可以帮助我们更好地控制模型训练过程,并提升最终模型的泛化能力。

```python

# 示例代码:划分一个简单的数据集

from sklearn.model_selection import train_test_split

# 假设X是特征数据,y是标签数据

X = [[1, 2], [3, 4], [5, 6]]

y = [0, 1, 0]

# 将数据集划分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

```

在本章的结尾,我们将通过实际代码示例,展示如何使用Python中的`sklearn.model_selection`模块来进行简单的数据集划分,为进一步的学习和实践奠定基础。

# 2. 数据集划分的理论基础

数据集划分是机器学习和深度学习研究中的关键步骤,它关系到模型的泛化能力和最终性能。本章将详细介绍数据集划分的重要性和不同划分策略,同时涉及数据集划分的统计考量。这将为后续章节中使用PyTorch进行数据集划分的实现与优化打下坚实的理论基础。

## 2.1 数据集划分的重要性

### 2.1.1 训练集、验证集和测试集的作用

在机器学习模型的开发过程中,通常会将数据集分为三个部分:训练集、验证集和测试集。这样的划分有助于避免模型过拟合,并对模型进行有效评估。

- **训练集**:用于模型的学习过程。模型通过训练集中的数据学习到数据的分布特征和规律,最小化模型的预测误差。

- **验证集**:用于模型调整和超参数的选择。验证集帮助研究者在模型训练过程中进行监控,并用以选择最佳的模型版本。

- **测试集**:用于模型的最终评估。测试集是独立于训练集和验证集的数据集合,用来评估模型的泛化能力,即在未知数据上的表现。

### 2.1.2 数据集划分对模型性能的影响

数据集划分的方式直接影响模型的学习效果和泛化能力。不恰当的划分可能会导致模型在训练集上表现良好,但对测试集却泛化性差,即过拟合。

- **过拟合**:当模型在训练集上学习得太好,以至于捕捉到数据中的噪声和不具代表性的特征,导致它在新的、未见过的数据上表现不佳。

- **欠拟合**:模型未能充分学习训练数据的特征和规律,因此在训练集和测试集上的表现都不佳。

为了防止这些问题,需要合理划分数据集,并采用适当的策略,如交叉验证,来确保模型的稳定性和可预测性。

## 2.2 数据集划分的策略

### 2.2.1 随机划分方法

随机划分是最简单的数据集划分策略,每个样本都有相等的机会被分配到训练集、验证集或测试集中。

- **基本思想**:将所有数据随机打乱,然后按照预先设定的比例进行划分。

- **实现方式**:通常使用如`numpy.random.shuffle`或者Python内置的`random`模块进行数据的随机排列。

```python

import numpy as np

data = np.array([...]) # 数据集

np.random.shuffle(data) # 打乱数据

split_index = int(len(data) * train_ratio)

train_data = data[:split_index]

test_data = data[split_index:]

```

### 2.2.2 分层划分方法

分层划分方法适用于数据集中具有多种类别标签的情况,它确保了每个子集中各类别的比例与整体数据集的比例相同。

- **目的**:保证训练集、验证集和测试集在类别上的分布一致。

- **步骤**:首先计算每个类别的比例,然后根据这些比例对每个类别内的数据进行随机划分。

### 2.2.3 K折交叉验证

K折交叉验证是一种评估模型性能的统计方法,它将数据集分成K个大小相同的子集。在K次迭代中,每次使用K-1个子集作为训练集,剩下的一个子集作为验证集。

- **优点**:相比单一的训练/验证集划分,K折交叉验证能够更全面地使用数据集,并减少因数据划分不同而导致的性能评估波动。

- **缺点**:计算代价相对较高,尤其是K值较大时。

## 2.3 数据集划分的统计考量

### 2.3.1 数据分布的均衡性

数据分布的均衡性是数据集划分的重要考量因素。如果数据集中的类别分布不均,则可能导致模型对某些类别识别率低。

- **平衡数据集**:通过过采样少数类或者欠采样多数类,使得训练集中的各类别样本数量接近均衡。

- **不平衡数据集**:模型可能会偏向于出现频率高的类别。使用特定算法或权重调整策略来处理类别不平衡。

### 2.3.2 类别不平衡问题的处理

对于类别不平衡的数据集,需要采取特定的策略来处理,以防止模型性能下降。

- **重采样技术**:通过减少多数类样本数量或增加少数类样本数量,来平衡各类别的数据量。

- **修改分类阈值**:通过调整分类阈值来提高对少数类别的敏感度。

通过这些策略,我们可以提高模型对于不平衡数据的适应能力,从而在实际应用中取得更好的效果。

# 3. PyTorch中的数据集划分实现

数据集划分是机器学习和深度学习工作中非常关键的一步,良好的数据集划分能够帮助模型更好地进行训练和评估,避免过拟合现象,提高泛化能力。PyTorch作为Python中流行的深度学习框架,提供了方便的数据集划分工具和接口。本章节将详细解析如何在PyTorch中实现数据集划分。

## 3.1 PyTorch数据加载和预处理

### 3.1.1 Dataset类的使用

在PyTorch中,所有数据集均通过`torch.utils.data.Dataset`类进行封装。Dataset类是一个抽象类,为了使它适用于你的数据集,需要继承并实现三个方法:`__init__`, `__getitem__`和`__len__`。以下是简单的用法说明:

```python

from torch.utils.data import Dataset

class MyDataset(Dataset):

def __init__(self, data, labels):

self.data = data

self.labels = labels

def __getitem__(self, index):

# 这里定义如何获取数据和对应的标签

return self.data[index], self.labels[index]

def __len__(self):

# 返回数据集的总大小

return len(self.data)

```

通过继承Dataset类,开发者能够定义适用于特定数据集的加载方式。

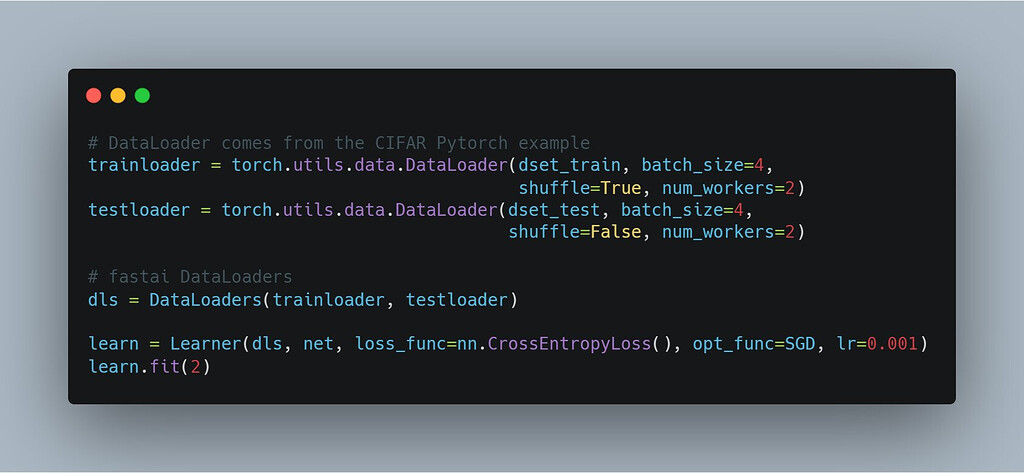

### 3.1.2 DataLoader类的理解与应用

在定义了Dataset之后,就可以使用`DataLoader`来加载数据。DataLoader允许批量加载数据,同时支持多线程加速,能够极大地提升数据处理效率。一个典型的DataLoader使用例子如下:

```python

from torch.utils.data import DataLoader

my_dataset = MyDataset(data, labels)

my_dataloader = DataLoader(dataset=my_dataset, batch_size=32, shuffle=True)

for data, target in my_dataloader:

# 在此处进行数据处理,例如喂给模型等操作

pass

```

通过设置`batch_size`参数可以指定每次加载数据的样本数量,而`shuffle`参数则决定在每个epoch开始时数据是否需要打乱,这对于模型训练过程中的随机性是有益的。

## 3.2 自定义数据集划分方法

### 3.2.1 实现随机划分

随机划分是将数据集随机分配到训练集、验证集和测试集中的方法。它是最常用的划分策略。以下是一个简单的随机划分方法实现:

```python

import random

def random_split(dataset, ratios=[0.7, 0.2, 0.1]):

n = len(dataset)

indices = list(range(n))

random.shuffle(indices)

train_size = int(ratios[0] * n)

valid_size = int(ratios[1] * n)

train_indices = indices[:train_size]

valid_indices = indices[train_size:train_size + valid_size]

test_indices = indices[train_size + valid_size:]

return [torch.utils.data.Subset(dataset, train_indices),

torch.utils.data.Subset(dataset, valid_indices),

torch.utils.data.Subset(dataset, test_indices)]

train_dataset, valid_dataset, test_dataset = random_split(my_dataset)

```

### 3.2.2 实现分层划分

当数据集中包含类别时,分层划分可以保证每个类别在划分后的子集中比例一致,这在处理具有类别不平衡的数据时特别有用。以下是一个分层划分的实现方法:

```python

from sklearn.model_selection import StratifiedSh

```

0

0