构建高效深度学习模型:NVIDIA DLI算法优化实战指南

NVIDIA DLI 深度学习基础 答案(领取证书用)

摘要

本文全面介绍了深度学习模型的基础架构、NVIDIA DLI课程资源、理论基础以及深度学习算法。通过NVIDIA DLI平台,详细阐述了深度学习实验的开展、优化技术、并行计算和模型量化策略。文章深入解读了优化工具如cuDNN和cuBLAS库的应用,以及并行计算和分布式训练的实施。进一步,通过图像识别、自然语言处理和自动驾驶等领域的实战案例,展示了深度学习技术的应用效果和优化方法。本文为深度学习研究者和实践者提供了宝贵的资源和深入理解,以期推动深度学习技术的发展和应用。

关键字

深度学习模型;NVIDIA DLI;理论基础;算法优化;并行计算;模型量化;图像识别;自然语言处理;自动驾驶

参考资源链接:NVIDIA DLI 深度学习基础实践:VGG16模型与数据增强

1. 深度学习模型的基础与架构

简介

深度学习是目前人工智能领域的热点技术之一,其核心在于使用神经网络模型模拟人脑的认知过程。深度学习模型因其出色的特征提取能力和广泛的应用范围而备受关注。理解深度学习模型的基础与架构对于构建有效的深度学习系统至关重要。

神经网络的基础

神经网络是一种模仿生物神经元结构的计算模型,它由输入层、隐藏层和输出层组成。每一层中包含若干神经元,这些神经元通过加权连接彼此相连。深度学习模型相较于传统的机器学习模型,拥有更多的隐藏层,这使得它们能够学习到数据的层次化特征表示。

深度学习模型的类型

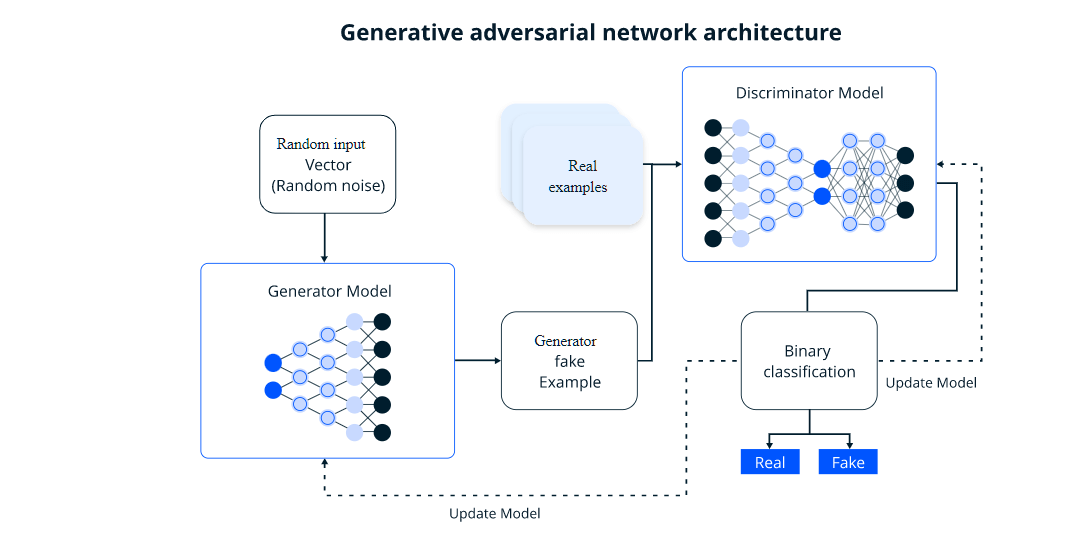

深度学习模型的类型繁多,包括但不限于卷积神经网络(CNN)、循环神经网络(RNN)、长短期记忆网络(LSTM)和生成对抗网络(GAN)。CNN在图像和视频处理方面表现出色,而RNN和LSTM擅长处理序列数据,如语音识别和自然语言处理。GAN在图像生成和数据增强方面展现了潜力。

通过本章的学习,读者应能够掌握深度学习模型的基本概念,并理解不同类型的模型是如何通过其架构特点来解决不同领域的实际问题。下一章将深入探讨NVIDIA DLI课程,为读者提供实际操作深度学习模型的机会。

2. NVIDIA DLI课程概览与资源

2.1 DLI课程的课程结构和目标

NVIDIA Deep Learning Institute (DLI) 提供了针对深度学习和加速计算的实践课程,旨在帮助开发者、数据科学家和研究人员掌握应用深度学习解决实际问题的技能。课程内容覆盖从基础理论到行业特定应用的各个方面,包括计算机视觉、自然语言处理、推荐系统和强化学习等。

2.2 DLI课程的目标人群

DLI课程适合不同背景和经验水平的学习者。无论是初学者还是有经验的从业者,都能在这些课程中找到适合自己的内容。初学者可以通过基础课程学习深度学习的基本概念,而有经验的学习者则可以通过进阶课程和行业特定课程进一步提升技能。

2.3 DLI课程资源获取方式

获取DLI课程资源的方式多种多样,学习者可以通过以下途径访问这些资源:

- 在线学习平台:NVIDIA官方网站提供了DLI的在线学习平台,支持个人注册和学习。

- 官方合作伙伴:DLI与多个教育机构和企业合作,提供线下研讨会、工作坊等。

- 在线培训:通过网络直播的方式参与实时培训课程。

- 自学材料:下载相关的教材、实验指南和视频教程进行自学。

2.4 DLI课程评估方式

课程的评估方式一般包括:

- 实验操作评估:通过完成实验来评估学习者对课程内容的掌握程度。

- 在线测验:在每个模块学习结束后,通常会有一个或多个在线测验。

- 项目作业:学习者需要完成一个或多个实际项目,以展示他们将学到的知识应用到真实世界问题中的能力。

2.5 DLI课程的成功案例分享

DLI的课程吸引了来自世界各地的学习者,并且已经帮助许多人实现了个人和职业上的成长。在这一部分中,我们可以分享一些成功案例,介绍学习者如何通过参加DLI课程,在职业生涯中取得了哪些进步,以及他们是如何将所学知识应用于实际项目中的。

2.6 DLI课程的发展与未来趋势

本节将探讨DLI课程的发展方向和未来趋势。随着深度学习技术的不断进步和行业需求的变化,DLI课程也在不断地更新和升级。我们预期看到课程内容将更加侧重于实用性和先进性,例如增强现实和虚拟现实(AR/VR)、自主机器和边缘计算等前沿技术的覆盖。此外,随着量子计算、生物信息学等新兴领域的兴起,相关课程也可能会出现。

3. 深度学习算法的理论基础

3.1 神经网络的基本概念

3.1.1 神经网络的历史和发展

神经网络的概念源于对生物大脑结构的模仿,其历史可以追溯到20世纪40年代。最初的神经网络是极其简单的,例如1943年提出的McCulloch-Pitts神经元模型,它是基于数学逻辑的一种抽象。到了1957年,F.Rosenblatt发明了感知机(Perceptron),它是一种线性二分类器,可以看作是单层的神经网络。感知机的提出推动了神经网络研究的第一个小高潮。

在随后的几十年中,由于缺乏有效的训练算法和硬件限制,神经网络的研究经历了停滞期,但到了1980年代,随着反向传播算法(Backpropagation)的提出,多层神经网络的训练成为了可能,神经网络研究进入了新的发展期。反向传播算法使得多层神经网络可以有效地学习数据中的复杂模式,开启了深度学习的时代。

进入21世纪,随着计算能力的大幅提升和大数据的出现,深度神经网络开始展现出在许多领域,包括图像识别、语音识别和自然语言处理等方面的巨大潜力。尤其是卷积神经网络(CNN)和循环神经网络(RNN)的提出,让深度学习在解决各类问题上取得了显著进展。

现在,深度学习已经成为人工智能领域最重要的研究方向之一。新的网络架构和训练技巧不断涌现,使得深度学习模型在解决各种实际问题时更加高效和精准。

3.1.2 常用的激活函数与损失函数

激活函数是神经网络中的一个关键组件,它的作用是在神经元之间引入非线性因素,使得神经网络能够学习和表示复杂的函数映射关系。

Sigmoid函数是最早使用的激活函数之一,其数学表达式为:

- def sigmoid(x):

- return 1 / (1 + np.exp(-x))

尽管Sigmoid函数曾经流行,但它存在一些缺点,如梯度消失问题和输出不是零中心化。因此,ReLU(Rectified Linear Unit)函数逐渐成为主流,特别是在深层网络中,其数学表达式为:

- def relu(x):

- return np.maximum(0, x)

ReLU函数简单且计算效率高,但它也存在一些问题,比如死区问题,即一部分神经元可能永远不会被激活,导致梯度无法流向这些神经元。为了缓解这个问题,人们提出了Leaky ReLU和Parametric ReLU等变种。

损失函数用于衡量模型的预测值与真实值之间的差异,它是训练过程中优化的核心目标。**均方误差(MSE)和交叉熵误差(Cross-Entropy)**是最常用的损失函数。

均方误差的数学表达式为:

- def mse_loss(y_true, y_pred):

- return ((y_true - y_pred) ** 2).mean()

交叉熵误差的数学表达式为:

- def cross_entropy_loss(y_true, y_pred):

- return -np.sum(y_true * np.log(y_pred))

交叉熵损失函数在多分类问题中特别流行,因为其能够更好地反映分类结果的概率分布。

3.2 模型训练与优化

3.2.1 梯度下降算法及其变种

梯度下降算法是训练深度学习模型中最基本的优化算法。它的核心思想是:通过迭代的方式,按照损失函数关于模型参数的梯度下降方向更新参数,以达到最小化损失函数的目的。

标准的梯度下降法在每次更新中使用全部数据(Batch Gradient Descent),但这种方法的缺点是效率低下,尤其是在数据量大的情况下。因此,人们提出了以下几种变体:

- 随机梯度下降法(SGD):在每次迭代中只使用单个样本来更新参数,因此速度快,但可能会在最小值附近震荡。

- 小批量梯度下降法(Mini-batch GD):介于SGD和Batch GD之间,每次更新使用一小批样本来计算梯度。

为了克服标准梯度下降算法的缺点,出现了带动量(Momentum)的梯度下降、RMSprop和Adam等自适应学习率优化算法。

带动量的梯度下降利用了动量的概念来加速学习过程,减少震荡,提高收敛速度。其更新规则如下:

- def update_with_momentum(v, w, w_prev, learning_rate, momentum):

- v = momentum * v - learning_rate * np∇f(w_prev)

- w = w_prev + v

- return v, w

其中,v是梯度累积项,w_prev是上一次的参数值,w是更新后的参数值,np∇f(w_prev)表示参数w_prev处的梯度,learning_rate是学习率,momentum是动量系数。

3.2.2 权重初始化与正则化技术

权重初始化是神经网络训练中的一个关键步骤。如果初始化不当,可能会导致梯度爆炸或梯度消失等问题。常用的初始化方法有:

- 零初始化:将所有权重初始化为零,这会导致所有神经元学习到相同的功能,因此在实际中很少使用。

- 随机初始化:通常使用一个小的随机数或特定分布(如高斯分布或均匀分布)来初始化权重。

- Xavier初始化(Glorot初始化):根据前一层的神经元数量来调整权重的初始化范围,使得前一层的输出和梯度具有相似的方差,有助于缓解梯度消失或爆炸问题。

正则化技术用于防止模型过拟合,提高模型的泛化能力。常见的正则化方法有:

- L1正则化:在损失函数中加入权重的绝对值之和,促使模型学习到更稀疏的权重。

- L2正则化:在损失函数中加入权重的平方和,使得权重倾向于较小的值,从而限制了模型的复杂度。

在实践中,L2正则化通常比L1正则化更受欢迎,因为它能更好地防止过拟合,并且计算上更简单。

3.3 模型评估与选择

3.3.1 交叉验证与超参数调优

交叉验证是一种评估模型泛化能力的方法。最常见的是k折交叉验证,它将数据集分成k个子集,然后依次使用其中的一个子集作为测试集,其余作为训练集,重复k次,每次选择不同的测试集,最终计算k次测试结果的平均值作为模型性能的评估。

- from sklearn.model_selection import cross_val_score

- # 假设X为特征集,y为目标向量,model为训练模型

- scores = cross_val_score(model, X, y, cv=5)

- print(f"Cross-validation scores: {scores}")

超参数调优是指调整模型的超参数以获得最佳性能的过程。常见的超参数调优方法有:

- 网格搜索(Grid Search):它尝试所有可能的超参数组合,并评估每种组合的性能。

- 随机搜索(Random Search):它随机选择超参数值进行评估,适用于参数空间较大且计算资源有限的情况。

- 贝叶斯优化(Bayesian Optimization):使用贝叶斯统计原理来预测和选择超参数,往往能找到性能更优的参数组合。

3.3.2 模型性能指标评估

性能指标是评估模型好坏的重要依据。不同的任务,评价模型的指标也不尽相同。例如:

- 分类任务常用的评价指标包括准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1分数(F1 Score)等。

- 回归任务常用的评价指标包括均方误差(MSE)、平均绝对误差(MAE)和R平方(R^2)等。

准确率是最直观的评价指标,定义为:

`