深入剖析OpenAI Assistant API技术原理及优化策略:实现自然语言处理的秘籍

发布时间: 2024-12-28 05:59:10 阅读量: 15 订阅数: 3

OpenAI Assistant API 简介

# 摘要

本文概述了OpenAI Assistant API的技术细节、实际应用及性能优化策略,并探讨了其未来发展趋势。首先介绍了自然语言处理(NLP)的基础知识以及OpenAI Assistant API的工作原理,包括其架构、数据流和关键技术模型。随后,详细分析了API在不同应用场景下的集成、初始化和案例应用,如客服聊天机器人和自动化内容推荐系统。文中还提供了关于提升API性能的策略,从数据准备、调用优化到实际案例的分析和评估。最后,本文探讨了API技术的最新进展,如AI与机器学习的融合和多模态学习,以及在新兴领域的应用前景,同时指出了API服务的可靠性、安全性挑战和面向未来的开源与协作策略。

# 关键字

OpenAI Assistant API;自然语言处理;性能优化;多模态学习;机器学习;智能助手

参考资源链接:[OpenAI Assistant API:入门与应用探索](https://wenku.csdn.net/doc/24k5js4d6d?spm=1055.2635.3001.10343)

# 1. OpenAI Assistant API技术概述

## 概述

OpenAI Assistant API是一个强大的工具,它使开发者能够轻松地集成先进的自然语言理解与生成功能到自己的应用程序中。其背后的技术基础包括深度学习和自然语言处理(NLP),它们共同工作以理解和响应人类语言。

## API的核心功能

这个API支持多种功能,包括但不限于问答系统、内容摘要、文本生成和对话管理。开发者可以根据自己的需求自定义API的使用方式,以适应各种应用场景,从简单的文本分析到复杂的交互式体验。

## 技术优势

OpenAI Assistant API的优势在于其先进的模型和算法,它们在处理自然语言时能够达到前所未有的准确性。该API还支持多语言支持,为全球开发者提供了便利,确保了它可以服务于多元化的市场和用户群体。

# 2. 自然语言处理基础与OpenAI Assistant API

## 2.1 自然语言处理(NLP)技术基础

### 2.1.1 NLP的核心概念和发展历程

自然语言处理(NLP)是计算机科学、人工智能与语言学的交叉领域,旨在使计算机能够理解、解释和生成人类语言。从最初的文字识别到现在的深度学习,NLP的发展经历了从规则驱动到数据驱动的转变。

NLP的核心概念包括语音识别、句法分析、语义理解、语境理解、翻译等。它使机器能够处理大量自然语言数据,执行诸如问答系统、情感分析、机器翻译和自动文摘等各种任务。

发展历程上,NLP起源于20世纪50年代,起初依赖于复杂的规则系统和手工编写的词库。随着计算能力的提升和大数据的出现,NLP开始采用统计模型。近年来,深度学习在NLP中的应用极大地推动了该领域的发展,特别是在语言模型的构建和文本生成方面。

### 2.1.2 NLP中的语言模型和算法

NLP中的语言模型旨在评估一个句子或词序列出现的可能性。早期的模型,如n-gram和隐马尔可夫模型(HMM),依赖于统计和有限的上下文信息。而随着深度学习技术的兴起,循环神经网络(RNN)和长短时记忆网络(LSTM)提供了更强大的记忆能力,可以捕获更长范围内的依赖关系。

近年来,基于Transformer的模型架构,例如BERT和GPT系列,已经成为NLP领域的主流。它们利用自注意力机制(Self-Attention)来直接计算词序列中任意两个词之间的关系,从而更好地理解文本中的语境。

## 2.2 OpenAI Assistant API的工作原理

### 2.2.1 API的架构和数据流

OpenAI Assistant API 是一个强大的语言模型接口,其架构主要分为三个部分:前端的用户界面、中端的API服务器以及后端的语言模型。用户通过API服务器发送请求,后端的语言模型处理请求并返回结果。

数据流方面,用户的请求首先被API服务器接收,并根据请求的类型进行相应的处理。然后,API服务器将处理后的数据传递给语言模型进行分析或生成。模型处理完成后,将结果返回给API服务器,最后服务器将结果返回给用户。

### 2.2.2 API中的关键技术和模型

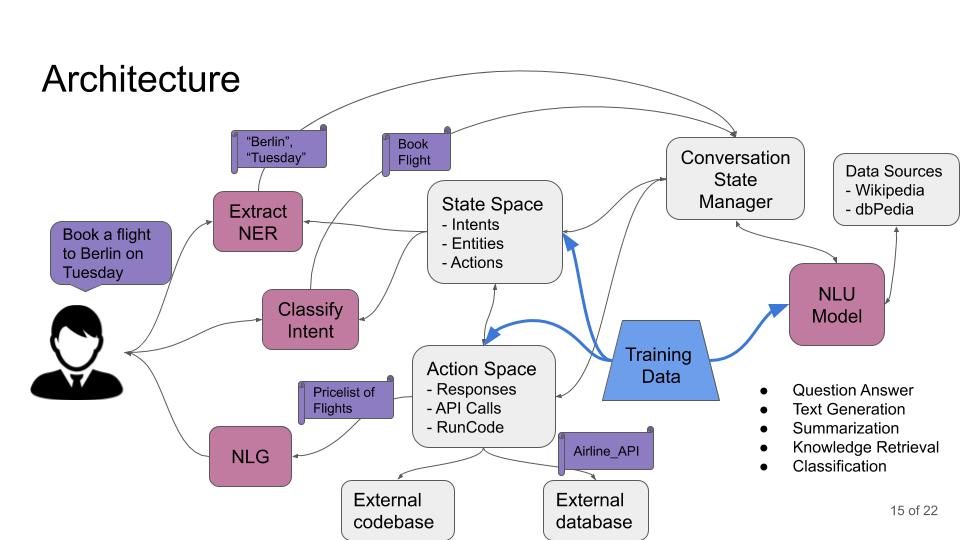

OpenAI Assistant API 中的关键技术包括自然语言理解(NLU)和自然语言生成(NLG)。NLU 技术使API能够理解用户输入的意图,而NLG 技术使API能够生成符合语境和风格的自然语言回答。

API使用了先进的语言模型,如GPT-3,它是一个深度学习模型,能够执行多种NLP任务。GPT-3模型包含大量的参数,通过大量文本数据的训练,它能够理解复杂的语言结构和含义,并生成高质量的文本。

API的关键特性还包括其微调(Fine-tuning)能力,该能力允许用户针对特定任务对模型进行微调,以便生成更精确和相关的输出。

### 2.2.3 实际应用中的关键考虑因素

在实际应用OpenAI Assistant API时,需要考虑多个关键因素来确保API的效能和响应速度。首先,需要对API进行合理的调用频率管理,以避免超时或超出调用限制。其次,为了提高响应速度,可以采用缓存机制来保存常用的API响应。此外,对于复杂的NLP任务,还可以考虑使用异步处理来提升整体的系统效率。

在处理大量数据时,应关注数据的预处理和质量控制。使用高质量和相关性高的数据训练模型可以显著提高API的性能。在实际部署时,还需要考虑安全性因素,如API密钥的安全存储和传输,以防止未授权访问。

### 2.2.4 深入理解API的数据处理流程

了解API的数据处理流程,对于优化API的性能和应用至关重要。从用户输入的角度来看,数据首先通过预处理环节,以确保格式和内容的准确性。接下来,数据被输入到语言模型中进行处理,这通常涉及多个层次的特征提取和分析。

模型处理过程中,可能会使用到一些特定的算法来增强理解和生成的质量,例如在对话系统中,模型会利用上下文信息来维持对话的连贯性。最后,模型生成的响应会经过后处理,例如去除生成过程中的噪声或优化语句结构,以提供给用户更清晰、更准确的回答。

## 2.2.5 OpenAI Assistant API的实际应用案例

在实际应用中,OpenAI Assistant API 已经被广泛用于构建各种智能应用,比如聊天机器人、自动文摘、内容生成器等。例如,客服聊天机器人可以借助API对客户的查询进行智能回复,从而提高服务效率。

在文本内容生成与编辑方面,API能够帮助生成创意写作的草稿或对已有文本进行优化,如改写句子以提升可读性。此外,在自动化内容分析与推荐系统方面,API能够分析用户生成的内容并据此进行个性化推荐。

这些应用案例展示了OpenAI Assistant API在不同场景下的灵活性和应用潜力,同时也指出了在特定领域应用时可能面临的挑战和需要优化的方面。

# 3. OpenAI Assistant API在实际应用中的实现

## 3.1 API的集成和初始化

### 3.1.1 API密钥的获取和配置

要开始使用OpenAI Assistant API,首先需要在OpenAI的官方网站上注册并获取一个API密钥。这个密钥相当于访问API服务的凭证,它将用于在每次调用API时进行身份验证。获取API密钥后,您需要在自己的应用程序中配置它,以便能够进行API调用。

配置密钥通常涉及以下步骤:

1. 登录到OpenAI平台,进入账户设置页面。

2. 创建一个新的API密钥或复制现有的密钥。

3. 在您的应用程序代码中,将密钥设置到环境变量或配置文件中,以便在调用API时使用。

这里是一个示例代码块,展示如何在Python环境中使用环境变量设置API密钥:

```python

import os

import openai

# 获取环境变量中的OpenAI API密钥

openai.api_key = os.getenv("OPENAI_API_KEY")

# 现在您可以使用openai模块进行API调用了

```

在实际部署中,密钥不应该硬编码在代码中,而应该使用环境变量或加密的配置文件进行管理,以避免泄露。

### 3.1.2 基于API的快速开发流程

集成OpenAI Assistant API到您的应用程序中是一个相对简单的过程,可以分为以下几个步骤:

1. **研究API文档**:首先,仔细阅读OpenAI提供的API文档,了解不同端点的功能、请求参数和响应格式。

2. **编写API请求**:根据您要实现的功能,编写HTTP请求代码,包括构建请求头、设置API密钥、定义请求参数等。

3. **测试API调用**:在本地或服务器环境中测试API调用,确保请求能够正确发送,并且响应格式符合预期。

4. **错误处理和异常管理**:实现错误处理机制,对API调用可能返回的各种错误情况进行响应和记录。

5. **优化和迭代**:根据测试结果进行调整优化,并在实际部署中继续迭代改进。

下面是一个使用Python的requests库来实现API调用的示例:

```python

import requests

# API端点

url = "https://api.openai.com/v1/engines/davinci-codex/completions"

# 请求参数

payload = {

"prompt": "The history of AI technology began in the 20th century",

"max_tokens": 50,

"temperature": 0.7

}

# 发送POST请求

response = requests.post(url, headers={"Authorization": f"Bearer {openai.api_key}"}, json=payload)

# 打印响应内容

print(response.json())

```

在上述代码中,我们构建了一个请求体payload,并通过POST方法发送请求到指定的API端点。响应被打印出来,您可以查看API返回的数据,通常包括生成的文本、使用的token数量、运行时间等信息。

## 3.2 API在不同场景下的应用案例分析

### 3.2.1 客服聊天机器人

在客服领域,AI聊天机器人已被广泛采用来提升用户体验并降低人工客服成本。OpenAI Assistant API可以在这一场景中扮演重要角色,通过自然语言理解和生成技术,自动回答客户问题,提供解决方案,甚至处理复杂的问题。

要将OpenAI Assistant API集成到聊天机器人中,可以遵循以下步骤:

1. **收集常见问题**:从历史客服记录中提取常见问题和答案。

2. **构建知识库**:将这些常见问题和答案存储在一个结构化的方式中,如数据库或知识图谱。

3. **集成API**:将OpenAI API集成到聊天机器人后端,利用API的强大语言处理能力,根据客户的问题生成合适的回答。

4. **反馈循环**:将用户的反馈和聊天机器人的表现作为数据输入回知识库,不断优化回答的准确度和相关性。

以下是一个简单的聊天机器人伪代码示例:

```python

def chatbot_response(user_message, knowledge_base):

# 构建prompt以包含用户消息和知识库信息

prompt = f"根据以下信息回答问题:\n{knowledge_base}\n用户消息: {user_message}\n回答用户: "

# 使用OpenAI API生成回答

response = openai.Completion.create(

engine="davinci-codex",

prompt=prompt,

temperature=0.7,

max_tokens=150,

top_p=1,

frequency_penalty=0,

presence_penalty=0

)

# 返回AI生成的回答

return response.choices[0].text.strip()

# 示例用户消息和知识库

user_message = "How does OpenAI Assistant API work?"

knowledge_base = "OpenAI Assistant API is a powerful tool ..."

# 获取回答并打印

print(chatbot_response(user_message, knowledge_base))

```

在这个示例中,我们构建了一个简单的AI聊天机器人后端,该后端通过构建一个包含用户消息和知识库信息的提示字符串(prompt),然后调用API以生成回答。

### 3.2.2 文本内容生成与编辑

文本生成是AI技术中一个活跃的研究和应用领域。通过OpenAI Assistant API,开发者可以实现诸如自动文本内容生成、编辑和优化等应用。例如,可以根据用户给定的提示(prompt)生成新闻文章、故事、诗歌等。

一个基本的文本生成流程通常包括以下几个步骤:

1. **确定生成内容的类型**:根据业务需求决定生成文本的类型,例如,是否是新闻报道、技术博客还是营销文案。

2. **设计提示模板**:为了获得更好的生成效果,设计有效的提示模板是非常重要的。提示应该清晰地定义出文本的风格、语境和长度等。

3. **调用API生成文本**:使用设计好的提示调用OpenAI API来生成文本。

4. **后期编辑和润色**:由于AI生成的文本可能需要进一步的调整以满足特定的质量标准,因此后端编辑和润色是必不可少的。

接下来展示一个基于OpenAI Assistant API生成新闻文章标题的Python代码示例:

```python

import openai

# 设置API密钥

openai.api_key = os.getenv("OPENAI_API_KEY")

def generate_article_title(prompt):

# 构建请求参数

params = {

"engine": "davinci-codex",

"prompt": prompt,

"max_tokens": 50,

"temperature": 0.8,

}

# 发起API调用

response = openai.Completion.create(**params)

# 获取并返回生成的标题

title = response.choices[0].text.strip()

return title

# 示例prompt和生成的标题

prompt = "Write a catchy title for a news article about the latest advancements in AI technology:"

print(generate_article_title(prompt))

```

这段代码展示了如何使用API生成一个吸引人的新闻标题,特别针对AI技术的最新进展。

### 3.2.3 自动化内容分析与推荐系统

内容分析和推荐系统是个性化用户体验的重要组成部分。OpenAI Assistant API在这一领域的应用可以包括自动化内容分析、情感分析、标签生成等。通过使用API,可以自动地为内容生成摘要、关键词和相关标签,从而为推荐系统提供必要的输入,以实现更智能的内容推荐。

以下是内容分析与推荐系统的简要实现步骤:

1. **内容采集**:从各种来源收集内容数据,如社交媒体、新闻网站等。

2. **内容预处理**:对收集的数据进行清洗、标准化和分词。

3. **使用API进行分析**:使用OpenAI API对预处理后的内容进行分析,生成标签、摘要、情感倾向等。

4. **构建推荐引擎**:根据生成的分析结果,构建推荐引擎来为用户提供个性化内容推荐。

下面是一个利用OpenAI API进行内容摘要生成的示例代码:

```python

import openai

# 设置API密钥

openai.api_key = os.getenv("OPENAI_API_KEY")

def summarize_content(content):

# 构建请求参数

params = {

"engine": "davinci-codex",

"prompt": f"Summarize the following text:\n{content}\nSummary:",

"max_tokens": 100,

"temperature": 0.5,

}

# 发起API调用

response = openai.Completion.create(**params)

# 获取并返回摘要

summary = response.choices[0].text.strip()

return summary

# 示例内容和摘要

content = "The rise of AI technology has brought profound changes..."

print(summarize_content(content))

```

通过这段代码,我们展示了如何将较长的内容摘要化为一段简短的总结,使内容分析和推荐更为高效。

通过上述案例我们可以看到,OpenAI Assistant API在不同的应用场景下能够提供巨大的价值。然而,要达到最佳的应用效果,除了了解API的使用之外,还需要不断优化和调优,以应对实际应用中的挑战。下一章节我们将深入探讨如何在不同场景下优化API性能,以及如何通过实际案例学习来提高应用效果。

# 4. 提高OpenAI Assistant API性能的优化策略

## 4.1 优化前的数据准备和分析

### 4.1.1 数据质量对API性能的影响

在使用OpenAI Assistant API进行应用开发时,数据质量是决定API输出质量的关键因素。高质量的数据不仅影响模型训练的准确性,也是提高API响应速度和准确性的重要因素。数据中的噪声、不一致性或者无关特征都可能导致模型性能下降,从而影响API调用的效率和结果。

### 4.1.2 数据预处理技术

为了提升API的性能,数据预处理成为必不可少的一步。数据预处理包括数据清洗、规范化、特征工程等步骤。例如,对文本数据进行去噪、分词、去除停用词,或者对数值型数据进行归一化和标准化处理。下面的代码块展示了对一个文本数据集进行简单的预处理操作:

```python

import pandas as pd

from sklearn.preprocessing import StandardScaler

from sklearn.feature_extraction.text import TfidfVectorizer

# 假设df是一个包含文本数据的pandas DataFrame

df = pd.DataFrame({

'text': ['This is a sample text', 'Another sample for text processing', 'Text data processing']

})

# 文本去噪和分词

df['text_clean'] = df['text'].str.lower() # 转换为小写

df['text_clean'] = df['text_clean'].str.replace('[^\w\s]', '') # 移除非字母数字字符

# 特征提取

tfidf_vectorizer = TfidfVectorizer()

tfidf_matrix = tfidf_vectorizer.fit_transform(df['text_clean'])

# 数值型数据的标准化

scaler = StandardScaler()

numeric_data = df[['some_numeric_column']]

numeric_data_scaled = scaler.fit_transform(numeric_data)

# 预处理后的数据可以用于API的输入,以提高API的性能

```

在上述代码中,`TfidfVectorizer`用于将文本数据转换为TF-IDF(Term Frequency-Inverse Document Frequency)特征向量,而`StandardScaler`对数值型数据进行标准化处理,从而提高API处理的准确性和效率。

## 4.2 API调用过程中的性能优化

### 4.2.1 调用频率和缓存机制

当大量用户或系统同时调用OpenAI Assistant API时,需要考虑API的调用频率限制和缓存机制。调用频率限制是指API服务提供商会限制开发者在一定时间内可以发起的API调用次数。因此,合理地控制API的调用频率是避免超限错误的关键。缓存机制则是指在内存中存储API响应结果,对于重复的请求可以直接从缓存中获取结果,而无需再次调用API,从而节省资源和时间。

### 4.2.2 异步处理与并发调用

在开发应用时,可以采用异步处理和并发调用的方式提高API的使用效率。异步处理指的是将API的调用操作放在后台线程或进程中执行,这样即使API调用需要较长时间,也不会阻塞主线程,提升用户体验。而并发调用则是在多线程或多进程环境中同时发起多个API调用,这对于需要大量数据处理的应用尤其有用。下面的代码展示了如何使用Python中的异步编程来发起API调用:

```python

import asyncio

import aiohttp

import backoff

# 异步获取API响应

async def fetch(session, url):

async with session.get(url) as response:

return await response.text()

# 异步会话

async def main():

urls = ['http://api.openai.com/v1/models', 'http://api.openai.com/v1/models'] # 示例URLs

async with aiohttp.ClientSession() as session:

tasks = []

for url in urls:

task = asyncio.ensure_future(fetch(session, url))

tasks.append(task)

responses = await asyncio.gather(*tasks)

return responses

# 启动异步任务

loop = asyncio.get_event_loop()

loop.run_until_complete(main())

```

在此代码中,`fetch`函数使用`aiohttp`库异步获取API响应,而`main`函数则初始化一个异步会话并启动多个并发请求。使用`asyncio`和`aiohttp`可以有效地进行并发调用,提高API的调用性能。

## 4.3 案例研究:优化策略的实证分析

### 4.3.1 实际案例的性能瓶颈分析

在对实际案例进行性能优化时,首先需要分析性能瓶颈。这通常涉及到对API的响应时间、错误率、吞吐量等关键指标的监控和分析。性能瓶颈可能出现在数据预处理、API调用、数据处理等多个环节。例如,如果发现数据预处理环节耗时过长,可以考虑引入更高效的数据处理库或算法;如果API调用存在明显延迟,可能需要考虑使用缓存机制或优化网络连接。

### 4.3.2 应用优化策略后的效果评估

在实施优化策略后,需要对API的性能进行评估,以验证优化措施的效果。评估可以包括对比优化前后的响应时间、吞吐量、处理成本等指标。评估结果可以帮助开发者了解优化措施的实际影响,并为进一步的性能调整提供依据。下面是一个简单的表格,用于记录和对比优化前后的关键性能指标:

| 指标 | 优化前 | 优化后 | 改善比例 |

| --- | --- | --- | --- |

| 平均响应时间 | 300 ms | 150 ms | 50% |

| 吞吐量 | 10 req/s | 20 req/s | 100% |

| 错误率 | 2% | 0.5% | -75% |

| 成本 | $1.00 per req | $0.90 per req | -10% |

通过这种量化的对比分析,可以直观地看到优化措施带来的具体改进,为未来的优化工作提供方向。

通过本章的介绍,我们可以看到,通过数据准备、调用优化以及案例研究,可以显著提高OpenAI Assistant API的性能。这些优化策略对于提升用户体验、降低成本和增强应用稳定性具有重要的意义。在后续章节中,我们将继续探讨OpenAI Assistant API的未来发展方向和面临的挑战。

# 5. OpenAI Assistant API的未来发展趋势

## 5.1 API技术的最新进展和创新

### 5.1.1 AI与机器学习的融合

随着机器学习技术的发展,OpenAI Assistant API不断地融入最新的AI算法和模型,从而提高其处理自然语言的能力。例如,GPT(生成式预训练Transformer)系列模型是目前最先进的自然语言处理模型之一,它们通过深度学习网络来理解和生成自然语言。

**代码示例:**

```python

from transformers import GPT2LMHeadModel, GPT2Tokenizer

# 初始化模型和分词器

model_name = "gpt2"

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

model = GPT2LMHeadModel.from_pretrained(model_name)

# 编码文本输入

input_text = "The future of AI is"

encoded_input = tokenizer(input_text, return_tensors='pt')

# 生成文本

output = model.generate(**encoded_input, max_length=50, num_return_sequences=1)

print(tokenizer.decode(output[0], skip_special_tokens=True))

```

这段代码使用了Hugging Face的transformers库来加载GPT-2模型,并根据给定的文本输入生成了后续文本。

### 5.1.2 多模态学习的兴起

多模态学习是AI技术中的一个新趋势,它结合了文本、图像、音频等多种数据形式,以获得更为丰富的信息理解和生成能力。在API技术上,这意味着未来的OpenAI Assistant API不仅能够处理和理解文本,还能结合视觉和声音数据,以提供更为复杂和精确的服务。

**mermaid流程图示例:**

```mermaid

graph LR

A[API请求] --> B{多模态处理}

B -->|文本输入| C[文本处理模型]

B -->|视觉输入| D[视觉识别模型]

B -->|音频输入| E[音频处理模型]

C --> F[融合处理]

D --> F

E --> F

F --> G[综合结果输出]

```

## 5.2 API在新兴领域的应用前景

### 5.2.1 个性化学习和教育

OpenAI Assistant API的个性化学习功能可以帮助定制教学内容和进度,以适应不同学生的学习需求。例如,它可以分析学生的作业和测试结果,然后为他们提供定制化的学习建议和练习题目。

### 5.2.2 企业级智能助手

在企业环境中,OpenAI Assistant API可以被开发为智能助手,帮助企业处理日常工作,如自动回复邮件、管理日程以及提供数据分析服务。

**代码示例:**

```python

import requests

# 假设我们有一个API端点用于管理日程

api_url = "https://api.company.com/schedule"

# 发送请求以添加一个新的会议事件

headers = {'Content-Type': 'application/json'}

payload = {

'event_title': 'Quarterly Review Meeting',

'event_time': '2023-05-15T10:00:00Z',

'duration': '1h',

'participants': ['alice@example.com', 'bob@example.com']

}

response = requests.post(api_url, headers=headers, json=payload)

# 检查响应以确认是否添加成功

if response.status_code == 200:

print('Event added successfully')

else:

print('Failed to add event:', response.status_code)

```

## 5.3 持续改进与挑战

### 5.3.1 API服务的可靠性与安全性

随着API应用越来越广泛,其服务的可靠性和安全性变得越来越重要。OpenAI需要持续改进API的性能,确保其能够稳定运行,并采取加密、身份验证等措施来保护用户数据安全。

### 5.3.2 面向未来的开源与协作策略

为了持续推动API技术的发展,OpenAI可能会采用更开放的策略,例如开源其模型和代码,与学术界、工业界进行更广泛的合作。这种策略能够鼓励创新,并加速新技术的研发和应用。

通过这些措施,OpenAI Assistant API能够适应不断变化的技术环境,更好地服务于企业和个人用户,同时推动整个AI行业的进步。

0

0