索引挑战赛:Python高效数据访问策略速成指南

发布时间: 2024-09-19 07:21:05 阅读量: 326 订阅数: 51

# 1. Python高效数据访问概论

## 1.1 Python数据访问的重要性

在数据密集型的应用中,如何高效地访问和处理数据是提高程序性能的关键。Python作为一种解释型语言,其简洁的语法和丰富的库支持使得数据访问更加便捷。随着数据量的不断增长,高效的数据访问机制变得尤为重要,它不仅影响程序的执行速度,还涉及到内存使用、CPU资源和磁盘I/O等多方面的性能问题。

## 1.2 高效数据访问的技术路线

为了实现高效的数据访问,Python开发者需要掌握一系列的技术和策略。这包括但不限于:了解Python基础数据结构的优化方法,掌握数据库访问的最佳实践,学会处理各种数据格式,并能够应用并行与并发技术来提升数据处理能力。此外,对内存管理有深刻理解也是优化性能的关键一环。

## 1.3 本章内容概览

本章将概览高效数据访问的概念和重要性,并介绍后续各章节中将深入探讨的关键点。通过理论与实践相结合的方式,逐步引导读者深入理解如何在Python项目中实现高效的数据访问与处理。这不仅包括数据结构的优化,也涵盖了数据库、文件处理、并行与并发数据处理以及内存管理等方面。

# 2. Python基础数据结构优化

## 2.1 标准数据类型的使用技巧

### 2.1.1 列表和字典的高级用法

在Python编程中,列表(list)和字典(dict)是最常使用的标准数据类型。正确地利用它们的高级特性,可以使代码更加高效和优雅。

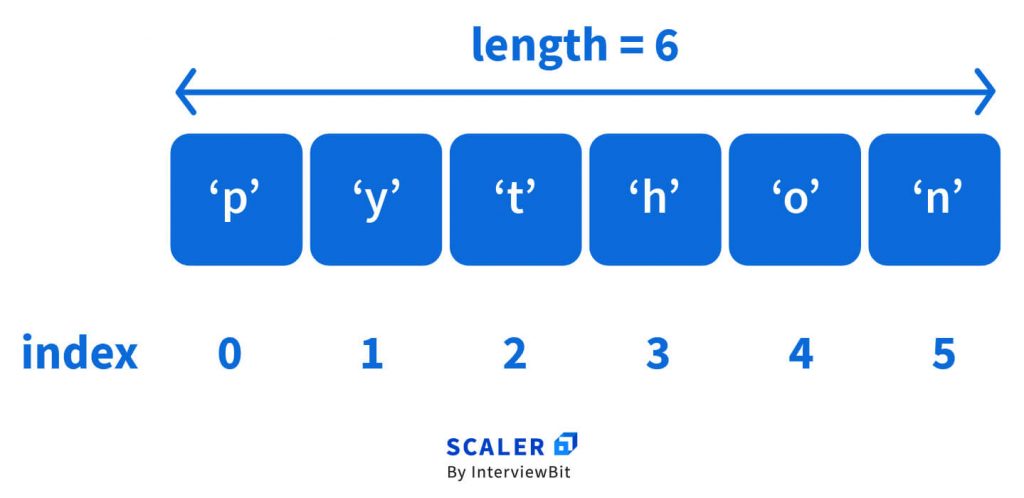

在列表方面,我们可以利用切片操作(slicing)快速访问列表的部分内容,而不需要复制整个列表,这样在处理大型数据集时尤其有用。例如:

```python

# 切片操作示例

my_list = list(range(1000000))

# 取前100个元素,不会创建新列表,而是创建一个视图

my_sublist = my_list[:100]

```

使用`in`关键字在列表中查找元素时,Python内部通过顺序搜索进行,这在列表无序或者元素较多时效率并不高。我们可以使用`bisect`模块来维护有序列表,从而实现高效的查找。

```python

import bisect

# 创建有序列表

sorted_list = sorted([2, 4, 1, 5, 3])

# 插入元素,同时保持列表有序

bisect.insort(sorted_list, 4)

print(sorted_list)

```

对于字典,其通过哈希表实现,因此它提供了非常快速的键值对存取能力。当需要将多个键值对同时添加到字典中时,推荐使用`update()`方法或者`**`运算符来合并字典,而不是逐一添加。

```python

# 合并字典

dict1 = {'a': 1, 'b': 2}

dict2 = {'b': 3, 'c': 4}

dict1.update(dict2)

# 或者使用关键字参数形式

dict1 = {**dict1, **dict2}

print(dict1) # 输出: {'a': 1, 'b': 3, 'c': 4}

```

字典推导式(dictionary comprehension)是Python中对字典进行高级操作的简洁方式。它允许我们以一种非常简洁的形式创建新的字典。

```python

# 字典推导式示例

squares = {x: x*x for x in range(6)}

print(squares) # 输出: {0: 0, 1: 1, 2: 4, 3: 9, 4: 16, 5: 25}

```

### 2.1.2 集合的性能优化策略

集合(set)是无序且元素唯一的容器,其内部实现为一个哈希表,提供了非常快的成员检查能力。利用集合的这些特性,我们可以优化很多操作。

例如,在数据去重任务中,我们通常利用集合来去除列表中的重复项:

```python

original_list = [1, 2, 2, 3, 4, 4]

unique_list = list(set(original_list))

print(unique_list) # 输出可能是无序的:[1, 2, 3, 4]

```

注意,由于集合是无序的,上述例子中,去除重复元素后得到的列表的顺序可能与原始列表不同。如果我们需要保持原始顺序,则可以使用如下策略:

```python

seen = set()

unique_list_ordered = []

for item in original_list:

if item not in seen:

unique_list_ordered.append(item)

seen.add(item)

print(unique_list_ordered) # 输出: [1, 2, 3, 4]

```

集合的交集、并集、差集操作也是常见且高效的。例如,我们可以使用集合来找出两个列表的共有元素:

```python

list_a = [1, 2, 3, 4]

list_b = [3, 4, 5, 6]

common_elements = set(list_a).intersection(list_b)

print(common_elements) # 输出: {3, 4}

```

集合的性能优化策略还体现在其快速的成员检查能力上,比如在处理大数据集时,判断一个元素是否存在于某个集合比存在于列表或元组要高效得多。

## 2.2 迭代器与生成器的高效循环

### 2.2.1 迭代器的优势和应用场景

迭代器是支持迭代协议的对象,它能够记住遍历的位置,使得在遍历过程中,每次返回一个元素,而不需要将所有元素存储在内存中。这在处理大量数据时尤其有用。

迭代器的优势在于:

1. 节省内存:不需要一次性将所有数据加载到内存,特别适合读取大文件或操作大集合。

2. 清晰和安全:提供了一种安全的方式来处理数据流,因为迭代器对象不能被随意修改,这降低了出错的可能性。

迭代器的常见应用场景包括逐行读取文件、遍历复杂数据结构中的元素、使用iter()函数和生成器表达式等。

```python

# 使用iter()函数

with open('large_file.txt', 'r') as ***

*** ''):

print(line, end='')

# 使用生成器表达式

data = [1, 2, 3, 4, 5]

squared = (x*x for x in data)

for num in squared:

print(num)

```

### 2.2.2 生成器的内存效率分析

生成器(generator)是特殊的迭代器,它使用了Python的协程来按需计算值。生成器在Python中的主要特性是它们使用懒惰求值(lazy evaluation),即只有在需要的时候才会计算值。这一特性使得生成器特别适合于大数据集合的处理。

以下是生成器的一个简单示例:

```python

def count_up_to(max_value):

count = 1

while count <= max_value:

yield count

count += 1

# 使用生成器

for number in count_up_to(10):

print(number)

```

生成器的内存效率分析在于:

- **懒惰计算**:只有在迭代过程中才计算下一个值,使得它在生成大量数据时不会占用过多内存。

- **延迟执行**:可以创建一个潜在的无限数据流,且不会执行任何计算,直到数据被请求。

这种方式在需要处理无限数据流或大数据集时尤其有用,例如,我们可以用生成器来处理每秒涌入的大量日志信息。

## 2.3 数据结构的综合应用案例

### 2.3.1 字符串处理和模式匹配

在文本处理或数据清洗中,字符串处理和模式匹配是常见的任务之一。Python提供了强大的字符串处理功能和丰富的正则表达式库。

例如,假设我们有一个文本文件,需要从中提取所有的电子邮件地址:

```python

import re

# 正则表达式匹配电子邮件

text = """Contact us at: ***, ***"""

pattern = ***pile(r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b')

matches = pattern.findall(text)

print(matches) # 输出: ['***', '***']

```

字符串的高级处理还包括了编码和解码,这对于处理国际化数据或文件至关重要。在Python中,我们可以使用字符串的`encode()`和`decode()`方法轻松实现这一点。

### 2.3.2 时间序列数据的高效管理

时间序列数据是金融分析、环境监测、IT监控等多个领域中常见的数据类型。Python提供了多种方式来存储和处理时间序列数据,例如使用`datetime`模块和`pandas`库。

例如,我们可以使用`pandas`库创建一个时间序列,并进行高效的数据分析:

```python

import pandas as pd

# 创建时间序列数据

dates = pd.date_range('***', periods=6)

data = pd.DataFrame({'value': [10, 20, 30, 40, 50, 60]}, index=dates)

print(data)

# 时间序列的高效查询和分析

print(data['***':'***'])

```

`pandas`库的时间序列功能不仅包括高效的数据存储,还包括强大的时间序列分析能力,例如时间频率转换、日期偏移以及时间窗口滚动统计等。

通过本章节的介绍,我们可以看到Python基础数据结构优化的重要性以及实际应用方法。在接下来的章节中,我们将进一步探索Python数据库访问策略和性能优化,深入挖掘Python处理数据的潜力。

# 3. Python数据库访问策略

数据库是存储和管理数据的重要系统,Python作为一种广泛使用的编程语言,拥有丰富的数据库访问库。在本章节中,我们将深入探讨如何利用Python高效地访问和操作数据库,包括数据库连接池的配置、SQL语句的优化、以及ORM框架的使用和性能优化。

## 3.1 数据库连接池的配置和优化

### 3.1.1 不同数据库连接池的选择

数据库连接池是维护一组数据库连接的缓冲池,可以显著提高程序与数据库交互的性能。Python中常见的数据库连接池有`psycopg2`、`PyMySQL`、`cx_Oracle`等,每个库都针对特定类型的数据库进行了优化。

在选择连接池时,需要考虑以下因素:

- **数据库类型**:不同的数据库类型(如MySQL, PostgreSQL, Oracle)都有各自的官方支持库。

- **性能**:连接池的性能往往与数据库类型和负载情况紧密相关。

- **资源消耗**:不同的连接池管理连接的方式不同,对系统资源的占用也会有差异。

- **安全性**:选择支持SSL连接、能够处理事务和具备错误处理机制的连接池更为安全。

举例来说,使用`psycopg2`连接池对于PostgreSQL数据库是一个不错的选择,它提供了高效的连接处理机制,支持连接池的参数配置。

### 3.1.2 连接池参数的调整和监控

连接池的参数配置是优化数据库性能的关键。主

0

0