PyTorch内存池技术深度解析:大模型训练效率提升秘诀

发布时间: 2024-12-23 18:51:20 阅读量: 28 订阅数: 22

PyTorch深度学习模型训练与部署实战指南

# 摘要

随着深度学习的发展,PyTorch等框架的高效使用变得尤为重要。内存池技术作为其核心组成部分,有效地解决了大规模数据处理中的内存消耗和碎片问题。本文首先概述了PyTorch中内存池技术的概念和优势,随后探讨了其理论基础,并分析了在PyTorch中的具体实践应用,包括内存分配优化、大模型训练的内存管理及并行计算中的内存策略。接着,文章深入分析了内存池技术对训练效率的影响,并探讨了其扩展性及未来趋势。最后,提出了除内存池技术之外的其他提升训练效率的策略,如模型并行、数据并行、混合精度训练和异构计算优化。通过这些分析和讨论,本文旨在为PyTorch用户以及深度学习研究者提供优化训练效率的全面指导和展望。

# 关键字

PyTorch;内存池技术;内存管理;训练效率;并行计算;异构计算

参考资源链接:[pytorch模型提示超出内存RuntimeError: CUDA out of memory.](https://wenku.csdn.net/doc/6401ad36cce7214c316eeb59?spm=1055.2635.3001.10343)

# 1. PyTorch内存池技术概述

PyTorch内存池技术是深度学习框架中用于管理GPU内存的一种高效方式。它通过预分配和复用内存块来提高内存使用效率,减少因内存碎片和频繁分配释放带来的性能损耗。本文将概述内存池技术的基本概念及其在PyTorch框架中的实现方式,为读者揭示这一技术如何为模型训练提供稳定而高效的内存支持。

## 1.1 内存管理的重要性

在深度学习模型的训练过程中,高效的内存管理是保持训练速度和稳定性的重要因素。特别是对于大规模模型而言,内存的合理使用可以显著减少训练时间和硬件资源的消耗。内存池技术应运而生,旨在解决这一问题。

## 1.2 PyTorch内存池的实现

PyTorch通过其内部的`torch.cuda`模块实现内存池。该模块隐藏了内存分配和释放的复杂性,提供了一套简单的API接口供用户使用。借助于内存池,PyTorch能够重复使用已分配的内存块,从而提升处理速度并减少内存碎片的影响。接下来的章节将深入探讨内存池技术背后的理论基础及在PyTorch中的具体应用。

# 2. 内存池技术的理论基础

### 2.1 内存管理的挑战

内存管理是现代计算机系统中一项至关重要的任务,尤其对于深度学习框架来说,高性能的内存管理机制能够显著提升计算效率。大规模数据处理和深度学习模型训练涉及的数据量巨大,如何高效地管理内存资源,减少不必要的内存分配和回收操作,避免内存碎片,成为了一项挑战。

#### 2.1.1 大规模数据处理的内存消耗

在大规模数据处理过程中,内存消耗主要表现在以下几个方面:

- **数据加载与缓存**:大规模数据往往需要预先加载到内存中,以便快速访问。然而,数据量的增加会导致内存占用急剧上升,甚至可能超过硬件的内存容量。

- **中间结果存储**:深度学习训练中,每批次数据的处理通常会生成中间结果,这些临时数据也会占用大量的内存资源。

- **模型状态保存**:训练过程中的模型参数需要存储在内存中以供后续使用,模型参数的数量与模型复杂度成正比。

#### 2.1.2 内存碎片问题及其影响

内存碎片问题是内存管理中不可避免的一个问题,它指的是内存空间中存在许多未被利用的小块空闲空间。由于分配和释放内存操作是随机发生的,随着时间的推移,这些小块空闲空间可能会变得零散,使得系统无法找到足够大的连续空间来分配给大块内存请求,从而导致内存不足的问题。

内存碎片对内存池技术提出了一个要求:如何在保证内存高效使用的前提下,减少碎片的产生并管理好碎片的空间。针对这一问题,内存池技术提供了一种有效的解决方案。

### 2.2 内存池技术的工作原理

#### 2.2.1 内存池的概念和优势

内存池是一块预先分配的、固定大小的内存块集合。与普通的内存分配方式不同,内存池在初始化时即从系统中申请一大块内存,并将其划分为多个固定大小或可变大小的内存块。当程序需要内存时,通过内存池而非直接向操作系统申请,这样可以减少内存分配和回收的开销,提高内存使用效率。

内存池技术的主要优势包括:

- **减少内存分配和释放次数**:通过重用预先分配的内存块,避免了频繁的系统调用,降低了内存管理的开销。

- **降低内存碎片**:预先分配的内存块可以按需重新组合,从而减少内存碎片的产生。

- **提高内存访问速度**:由于内存块通常比系统级别的内存管理要小,访问速度可以得到提升。

#### 2.2.2 常见内存池算法解析

在内存池技术中,有许多不同的算法用于管理内存块的分配和回收。其中一些主流的算法包括:

- **固定大小内存块分配**:内存池中所有内存块大小相同,管理起来相对简单。这种策略适用于内存块大小可预先确定的情况。

- **伙伴系统(Buddy System)**:内存池被划分为大小为2的幂次方的块,分配和回收操作根据内存需求进行合并和分割。

- **Slab 分配器**:主要用于内核内存管理,通过将内存池划分为一组固定大小的块,然后根据对象的大小来分配。

### 2.3 PyTorch中的内存池策略

#### 2.3.1 自动内存管理机制

PyTorch作为一个深度学习框架,使用了自动内存管理机制来处理内存分配和回收。PyTorch的自动内存管理主要依赖于引用计数和垃圾收集机制。当一个张量不再被任何变量引用时,它的内存会被自动回收。

- **引用计数**:每个张量都有一个引用计数器,每当创建一个新的引用时,计数器增加;每当一个引用被销毁时,计数器减少。当计数器为零时,意味着没有任何变量引用该张量,因此可以释放其内存。

- **垃圾收集机制**:PyTorch通过周期性地运行垃圾收集器来清理不再被使用的张量。这一机制确保了即使在有循环引用的情况下,内存也能被正确回收。

#### 2.3.2 缓存和复用机制的实现

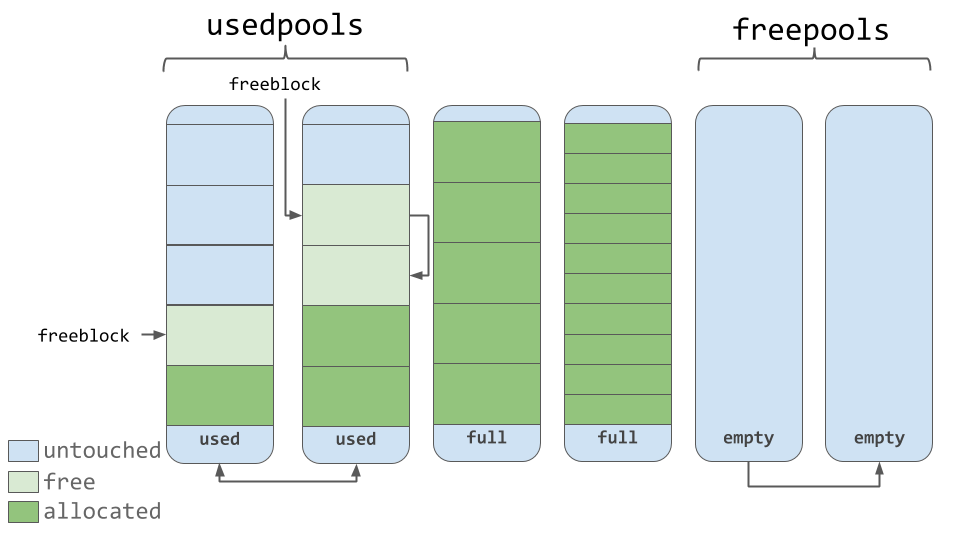

在PyTorch中,缓存和复用机制主要通过内存池实现。该机制包括两个主要部分:

- **缓存池(Cache Pools)**:PyTorch为不同的张量类型和大小维护了多个缓存池。当需要创建一个新的张量时,PyTorch会首先检查缓存池中是否有可用的张量块,如果有,则直接复用,这避免了向操作系统申请新的内存。

- **复用策略**:为了复用内存,PyTorch使用了一种“内部复用”的机制。比如,在内存池中预先分配了一定数量的张量块,当这些张量块不再被使用时,它们不会被释放回操作系统,而是保留在内存池中供未来使用。

通过这些策略,PyTorch能够有效地管理内存资源,提升内存使用效率,这对于训练大型深度学习模型尤为重要。在下一章中,我们将深入了解内存池技术在PyTorch中的具体应用,以及如何进一步优化内存使用。

# 3. 内存池技术在PyTorch中的实践应用

## 3.1 内存分配与释放优化

### 3.1.1 CUDA内存分配策略

在PyTorch中,CUDA内存分配策略是高效处理GPU资源的关键。CUDA内存管理涉及到显存的分配和释放,以及如何在多个操作之间共享显存以优化内存使用。PyTorch通过`torch.cuda`模块提供了一系列API来进行CUDA内存操作。

一个关键的概念是显存的预分配。预分配可以避免运行时频繁的显存分配和释放操作,减少内存碎片的产生,提高内存管理的效率。例如,使用`torch.cuda.empty_cache()`可以清空当前缓存,使显存可用,而`torch.cuda.memory_allocated()`可以返回当前分配的显存大小。

```python

# 示例:使用CUDA内存分配API进行显存预分配

device = torch.device("cuda")

batch_size = 128

input_size = (batch_size, 3, 224, 224) # 假设输入是一个图片批次

# 分配内存

input_tensor = torch.zeros(input_size, device=device, dtype=torch.float32)

# 模型运算...

# ...

# 释放内存

input_tensor = None

torch.cuda.empty_cache()

```

这段代码预分配了一个指定大小的CUDA内存块,并在不再需要时释放它。

### 3.1.2 内存泄漏检测与调试

内存泄漏在进行深度学习模型训练时是一个常见的问题,尤其是在处理大量数据和长时间运行的程序时。内存泄漏指的是程序在申请内存后未能正确释放,导致可用内存量逐渐减少。

PyTorch提供了一些工具来帮助开发者检测内存泄漏,比如`torch.cuda.memory_allocated()`和`torch.cuda.max_memory_allocated()`。还可以使用`nvidia-smi`命令来监控显存使用情况。

```python

import torch

# 在一个循环中分配和释放内存以检测泄漏

for i in range(10):

tensor = torch.ones(1000000, device='cuda')

# 模拟一些计算...

del tensor # 应该释放内存,如果检测到内存泄漏,这个操作应该增加可用的显存

torch.cuda.synchronize() # 确保所有的CUDA操作都已完成

```

在上面的代码中,通过不断分配和释放大块的CUDA内存,可以观察到显存使用是否逐渐增加,从而

0

0