【Hadoop数据压缩】:Gzip算法的局限性与改进方向

发布时间: 2024-10-27 05:00:36 阅读量: 61 订阅数: 32

# 1. Hadoop数据压缩概述

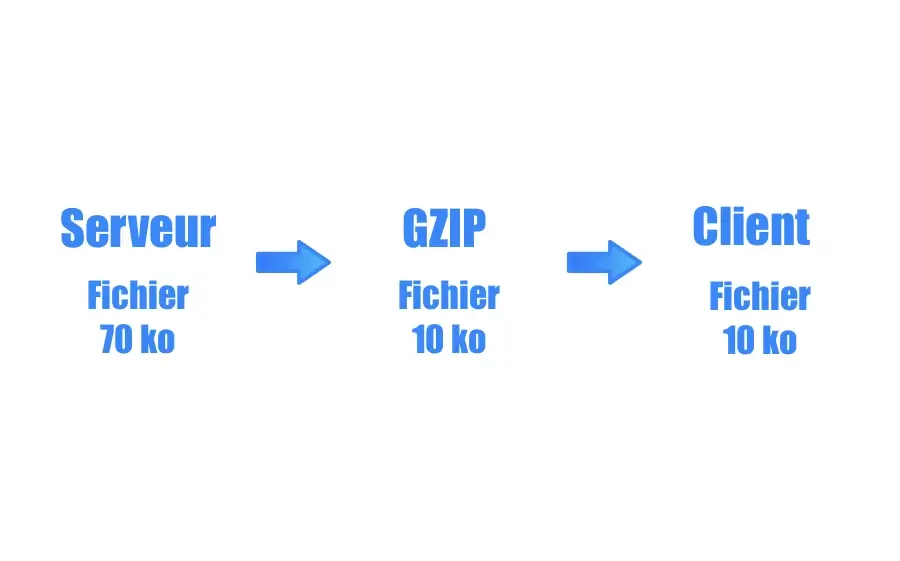

随着大数据量的不断增长,数据压缩已成为提升存储效率和传输速度的关键技术之一。Hadoop作为一个分布式系统,其数据压缩功能尤为重要。本章我们将对Hadoop数据压缩进行概述,深入探讨压缩技术在Hadoop中的应用,并简要分析其重要性与影响。

## 1.1 Hadoop数据压缩的必要性

Hadoop集群处理的数据量巨大,有效的数据压缩可以减少存储成本,加快网络传输速度,提高数据处理效率。压缩不仅可以降低对硬件资源的需求,还能在分布式计算中加快数据的读写速度,从而显著提升整体的计算性能。

## 1.2 数据压缩对Hadoop性能的影响

在Hadoop环境下,数据压缩通常意味着更高的CPU负载,因为数据在压缩和解压缩的过程中需要额外的计算资源。然而,这种资源消耗往往被节省的存储空间和网络带宽所带来的性能提升所抵消。因此,合理地选择和配置数据压缩方法,能够有效平衡计算资源和性能之间的关系。

## 1.3 Hadoop中支持的数据压缩算法

Hadoop原生支持多种压缩算法,包括但不限于Gzip、Bzip2、Deflate等。每种算法都有其特点和应用场景,如Gzip常用于压缩文本文件,而Bzip2适用于压缩大型文件。理解不同压缩算法的特性,对于在Hadoop中进行数据压缩优化至关重要。

# 2. Gzip算法的基础理论

## 2.1 Gzip算法的工作原理

### 2.1.1 DEFLATE压缩算法概述

DEFLATE算法是一种结合了LZ77压缩算法的无损数据压缩方法,主要用于Gzip文件格式中。该算法将输入数据视为一系列字符串(或字节序列),通过查找输入数据中的重复字符串来实现压缩。

#### 压缩过程

1. **字典查找**:DEFLATE使用一个动态字典(滑动窗口),存储之前出现过的字符串。

2. **匹配与存储**:当输入中出现字典里的字符串时,算法输出一个指向字典中匹配字符串的引用。如果字典中没有匹配项,字典会写入新的字符串,并输出该字符串本身。

3. **压缩控制**:为了提高压缩效率,算法还采用了霍夫曼编码,为常见的字符串分配更短的编码。

### 2.1.2 Gzip文件格式详解

Gzip文件格式包含了一个头信息,压缩数据,以及一个尾部信息。头信息包含了文件的元数据,压缩数据是实际压缩后的内容,尾部信息提供了文件完整性校验。

#### 头部信息

头部信息包含了文件魔术字节(用于识别文件类型),版本信息,时间戳,以及未压缩数据的大小等。

#### 压缩数据

这部分是使用DEFLATE算法压缩的数据本身,可以包含多个块,每个块使用自己的字典,以提高压缩效率。

#### 尾部信息

尾部信息包含了校验和,用于检测文件传输或存储过程中是否出现错误。

## 2.2 Gzip算法的压缩过程

### 2.2.1 压缩流程的各个阶段

Gzip压缩可以分为三个主要阶段:读取、压缩和写入。

#### 读取阶段

在这个阶段,Gzip从输入流中读取数据块,并将其存储在缓冲区中。

```python

import gzip

import io

def read_data(input_stream):

with gzip.open(input_stream, 'rt') as gz_***

***

***

```

上述代码展示了如何使用Python的`gzip`库来读取压缩的数据。

#### 压缩阶段

利用DEFLATE算法处理读取的数据,输出压缩的数据块。

```python

def compress_data(data):

with io.BytesIO() as buffer:

with gzip.GzipFile(fileobj=buffer, mode='w') as gz_***

***

***

***

```

上述代码片段展示了如何对数据进行Gzip压缩。

#### 写入阶段

将压缩后的数据写入到输出流中。

### 2.2.2 压缩效率的影响因素

影响Gzip压缩效率的因素包括输入数据的特性、压缩级别以及字典大小等。

#### 输入数据特性

- **数据冗余度**:数据中重复的模式越多,Gzip压缩效率越高。

- **数据类型**:文本数据比二进制数据更适合Gzip压缩。

#### 压缩级别

Gzip提供了不同的压缩级别(从1到9),级别越高,压缩所需时间越多,但压缩率也越高。

```bash

gzip -9 inputfile

```

上述命令将输入文件以最高压缩级别进行压缩。

#### 字典大小

Gzip的字典大小可以调整,更大的字典有助于存储更长的字符串,提升压缩效率,但同时也会消耗更多的内存。

## 2.3 Gzip算法的性能评估

### 2.3.1 压缩率与速度的权衡

评估Gzip算法时,需要权衡压缩率与压缩速度之间的关系。通常情况下,提高压缩级别可以提升压缩率,但也导致压缩速度下降。

```bash

# 测试不同压缩级别的性能

for level in {1..9}; do

time gzip -${level} -c inputfile > /dev/null

done

```

上述脚本测试了不同压缩级别对压缩速度的影响。

### 2.3.2 实际应用中的性能瓶颈

在实际应用中,Gzip压缩可能会遇到瓶颈,比如在处理大型文件或实时数据流时,较高的压缩级别可能导致显著的延迟。

```mermaid

graph LR

A[开始压缩] -->|输入数据| B{数据大小}

B -->|小数据| C[快速压缩]

B -->|大数据| D[慢速压缩]

C --> E[低延迟]

D --> F[高延迟]

```

如上图所示,数据大小直接影响压缩速度与延迟。

在本章中,我们详细探讨了Gzip算法的基础理论。从DEFLATE压缩算法的原理出发,逐步深入到Gzip文件格式的细节,再到压缩过程的各个阶段。通过代码示例、表格、图表等多种形式,我们分析了压缩效率的影响因素,并对性能进行了评估。在接下来的章节中,我们将继续深入了解Gzip算法在Hadoop中的应用,并探讨其局限性及改进方向。

# 3. Gzip算法在Hadoop中的应用与局限

## 3.1 Hadoop环境下的Gzip压缩使用

### 3.1.1 Gzip与Hadoop的集成方式

Gzip算法作为一种广泛使用的数据压缩工具,在Hadoop生态系统中扮演着重要角色。Gzip与Hadoop的集成主要通过MapReduce作业来实现。在MapReduce程序中,可以通过设置TextInputFormat或SequenceFileInputFormat等输入格式来使用Gzip压缩。

在Hadoop作业配置中,可以通过设置`mapreduce.input.lineinputformat.linespermap`属性来调整Map任务处理的数据块大小,从而影响压缩比例和性能。通过这样的集成方式,Hadoop能够有效地处理大量的压缩数据,提高数据传输的效率并减少磁盘I/O操作。

### 3.1.2 Gzip压缩在Hadoop中的配置与优化

在Hadoop中配置Gzip压缩涉及到几个关键步骤,首先需要确保Hadoop集群上的所有节点都安装了Gzip工具。然后,在运行MapReduce作业之前,需要设置`***pression.type`属性为BLOCK,以及`***pression.codec`属性为***press.GzipCodec,这样就可以启用Gzip压缩输出了。

优化方面,可以通过调整Hadoop的IO设置来提高Gzip压缩的效率。例如,可以通过`***pression.block.size`属性来定义压缩块的大小,较小的块大小可能会带来更高的压缩率,但也会增加CP

0

0