Python misc库实践秘籍:如何利用常见功能提高开发效率

发布时间: 2024-10-15 17:38:56 阅读量: 30 订阅数: 36

java计算器源码.zip

# 1. Python misc库概述

Python作为一个高级编程语言,拥有丰富的库来支持开发者的日常工作。misc库,一个不太为人所知的内置库,虽然体积不大,但却包含了多个实用的功能,能够在处理简单任务时提高效率。本章将对misc库的功能进行概述,并通过实例展示其在数据处理和系统操作中的应用。

## 1.1 misc库简介

misc库提供了几个实用的函数和类,它们对于快速开发和脚本编写非常有用。例如,`string.printable`可以生成一个包含所有可打印字符的字符串,这对于需要字符测试或生成的场景非常方便。

## 1.2 常用功能演示

以下是一些misc库中常用的函数和类的演示代码:

```python

import misc

# 生成一个包含所有可打印字符的字符串

printable_chars = misc.string.printable

print(printable_chars)

# 使用misc库进行简单的数学计算

result = misc.math.factorial(5)

print(result) # 输出: 120

# 打印misc库中可用的所有函数和类

print(dir(misc))

```

通过上述代码,我们可以看到misc库的使用非常直观,通过几个简单的函数就能完成特定的任务。在接下来的章节中,我们将深入探讨如何利用misc库进行更复杂的数据处理和系统操作。

# 2. 数据处理与分析

## 2.1 数据清洗

### 2.1.1 去除重复值

在处理数据集时,去除重复值是一项基础且重要的任务。重复值可能会因为数据录入错误或者数据合并过程中产生,这些重复的数据如果不进行清理,会影响数据分析的准确性和效率。

#### *.*.*.* 使用Python去除DataFrame中的重复值

```python

import pandas as pd

# 创建一个包含重复值的DataFrame

data = {'Name': ['John', 'Anna', 'Peter', 'Anna', 'John', 'Peter'],

'Age': [24, 24, 25, 24, 24, 25]}

df = pd.DataFrame(data)

# 打印原始DataFrame

print("原始DataFrame:")

print(df)

# 去除重复值

df_unique = df.drop_duplicates()

# 打印去重后的DataFrame

print("\n去除重复值后的DataFrame:")

print(df_unique)

```

#### 参数说明与逻辑分析

在上述代码中,`drop_duplicates()` 方法用于删除DataFrame中的重复行。默认情况下,该方法会考虑所有列的值。如果只想基于某列或某几列去除重复值,可以使用 `subset` 参数指定列。

**参数说明:**

- `subset`: 用于指定需要考虑的列,默认为所有列。

- `keep`: 控制如何保留重复值,`first` 表示保留第一次出现的值,`last` 表示保留最后一次出现的值,`False` 表示去除所有重复值。

### 2.1.2 缺失值处理

处理数据时,常常会遇到数据缺失的情况,这可能是由于数据未被记录、传输错误或数据损坏等原因造成。缺失值如果不适当处理,将严重影响数据分析的结果。

#### *.*.*.* 使用Python处理缺失值

```python

import pandas as pd

# 创建一个包含缺失值的DataFrame

data = {'A': [1, 2, None, 4],

'B': [5, None, None, 8]}

df = pd.DataFrame(data)

# 打印原始DataFrame

print("原始DataFrame:")

print(df)

# 填充缺失值

df_filled = df.fillna(0)

# 删除包含缺失值的行

df_dropped = df.dropna()

# 打印填充缺失值后的DataFrame

print("\n填充缺失值后的DataFrame:")

print(df_filled)

# 打印删除缺失值后的DataFrame

print("\n删除缺失值后的DataFrame:")

print(df_dropped)

```

#### 参数说明与逻辑分析

在上述代码中,`fillna()` 方法用于填充缺失值,而 `dropna()` 方法用于删除包含缺失值的行。

**参数说明:**

- `fillna(value)`: 用指定的值填充缺失值。

- `dropna(axis, how, thresh)`: 删除包含缺失值的行或列。

- `axis`: 0或'index'表示删除行,1或'columns'表示删除列。

- `how`: 'any'表示任何一个值缺失就删除整行或列,'all'表示所有值都缺失才删除。

- `thresh`: 最小非缺失值的行数或列数。

### *.*.*.* 缺失值的高级处理方法

除了填充和删除,还可以使用其他高级方法处理缺失值,例如使用插值或预测缺失值。

#### *.*.*.*.1 使用插值方法处理缺失值

```python

import pandas as pd

import numpy as np

# 创建一个包含缺失值的DataFrame

data = {'A': [1, None, None, 4],

'B': [5, None, None, 8]}

df = pd.DataFrame(data)

# 使用线性插值填充缺失值

df_interpolated = df.interpolate(method='linear')

# 打印插值后的DataFrame

print("\n使用线性插值填充缺失值后的DataFrame:")

print(df_interpolated)

```

#### 参数说明与逻辑分析

在上述代码中,`interpolate()` 方法用于对缺失值进行插值。该方法提供了多种插值技术,包括线性插值、多项式插值等。

**参数说明:**

- `method`: 插值方法,默认为'linear',其他选项包括'polynomial'、'quadratic'等。

- `order`: 多项式插值的阶数,默认为3。

- `limit_direction`: 插值方向,'forward'、'backward'或'both'。

## 2.2 数据排序与筛选

### 2.2.1 排序方法

在数据分析中,根据某些列对数据进行排序是非常常见的需求。Pandas库提供了多种排序方法,可以根据单列或多列进行排序。

#### *.*.*.* 使用Pandas进行数据排序

```python

import pandas as pd

# 创建一个DataFrame

data = {'Name': ['John', 'Anna', 'Peter', 'Linda'],

'Age': [28, 24, 25, 33]}

df = pd.DataFrame(data)

# 打印原始DataFrame

print("原始DataFrame:")

print(df)

# 根据'Age'列进行升序排序

df_sorted_ascending = df.sort_values(by='Age')

# 根据'Age'列进行降序排序

df_sorted_descending = df.sort_values(by='Age', ascending=False)

# 打印升序排序后的DataFrame

print("\n升序排序后的DataFrame:")

print(df_sorted_ascending)

# 打印降序排序后的DataFrame

print("\n降序排序后的DataFrame:")

print(df_sorted_descending)

```

#### 参数说明与逻辑分析

在上述代码中,`sort_values()` 方法用于根据指定的列对DataFrame进行排序。

**参数说明:**

- `by`: 排序的列名。

- `ascending`: 是否升序排序,默认为True。

### 2.2.2 筛选技巧

筛选数据是数据分析中的另一项重要技能。通过对数据进行筛选,可以快速找到满足特定条件的数据子集。

#### *.*.*.* 使用Pandas进行数据筛选

```python

import pandas as pd

# 创建一个DataFrame

data = {'Name': ['John', 'Anna', 'Peter', 'Linda'],

'Age': [28, 24, 25, 33],

'City': ['New York', 'Los Angeles', 'New York', 'Chicago']}

df = pd.DataFrame(data)

# 打印原始DataFrame

print("原始DataFrame:")

print(df)

# 筛选年龄大于25岁的人

filtered_df = df[df['Age'] > 25]

# 打印筛选后的DataFrame

print("\n筛选年龄大于25岁的人后的DataFrame:")

print(filtered_df)

```

#### 参数说明与逻辑分析

在上述代码中,使用布尔索引的方式对DataFrame进行筛选。布尔索引允许我们根据条件选择满足条件的行。

**参数说明:**

- `条件表达式`: 例如 `df['Age'] > 25` 创建了一个布尔数组,该数组对于DataFrame中每行的'Age'列的值都会返回True或False。

## 2.3 数据统计分析

### 2.3.1 基本统计量计算

数据统计分析是数据分析的核心部分,基本统计量的计算可以帮助我们了解数据的分布情况。

#### *.*.*.* 使用Pandas计算基本统计量

```python

import pandas as pd

# 创建一个DataFrame

data = {'A': [1, 2, 3, 4],

'B': [5, 6, 7, 8]}

df = pd.DataFrame(data)

# 打印原始DataFrame

print("原始DataFrame:")

print(df)

# 计算基本统计量

mean_a = df['A'].mean() # 计算列A的均值

mean_b = df['B'].mean() # 计算列B的均值

std_a = df['A'].std() # 计算列A的标准差

std_b = df['B'].std() # 计算列B的标准差

# 打印计算结果

print(f"\n列A的均值: {mean_a}, 列B的均值: {mean_b}")

print(f"列A的标准差: {std_a}, 列B的标准差: {std_b}")

```

#### 参数说明与逻辑分析

在上述代码中,`mean()` 方法用于计算均值,`std()` 方法用于计算标准差。

**参数说明:**

- `mean()`: 计算列的平均值。

- `std()`: 计算列的标准差,衡量数据的波动程度。

### 2.3.2 高级数据分析方法

除了基本统计量,还有许多高级的统计分析方法可以帮助我们从数据中获取更深入的见解。

#### *.*.*.* 使用Pandas进行分组与聚合

分组与聚合是高级数据分析中的一个重要概念,它允许我们根据某些条件将数据分组,并对每个分组进行聚合操作。

```python

import pandas as pd

# 创建一个DataFrame

data = {'Name': ['John', 'Anna', 'Peter', 'Linda'],

'Age': [28, 24, 25, 33]}

df = pd.DataFrame(data)

# 打印原始DataFrame

print("原始DataFrame:")

print(df)

# 根据'Age'列进行分组并计算每组的平均年龄

grouped = df.groupby('Age')

mean_age = grouped.mean()

# 打印分组后的平均年龄

print("\n分组后的平均年龄:")

print(mean_age)

```

#### 参数说明与逻辑分析

在上述代码中,`groupby()` 方法用于根据指定列进行分组,`mean()` 方法用于计算每个分组的平均值。

**参数说明:**

- `groupby()`: 根据指定的列或列的列表进行分组。

- `mean()`: 对分组后的每个组计算平均值。

通过本章节的介绍,我们可以看到Pandas库提供了丰富的数据处理与分析功能,无论是数据清洗、排序筛选还是统计分析,都可以通过简洁的代码实现高效的数据处理。在本章节中,我们详细介绍了如何使用Pandas去除重复值、处理缺失值、进行数据排序和筛选,以及如何计算基本统计量和使用分组聚合等高级数据分析方法。总结起来,这些方法构成了数据分析的基础工具集,对于任何需要处理和分析数据的场景都至关重要。

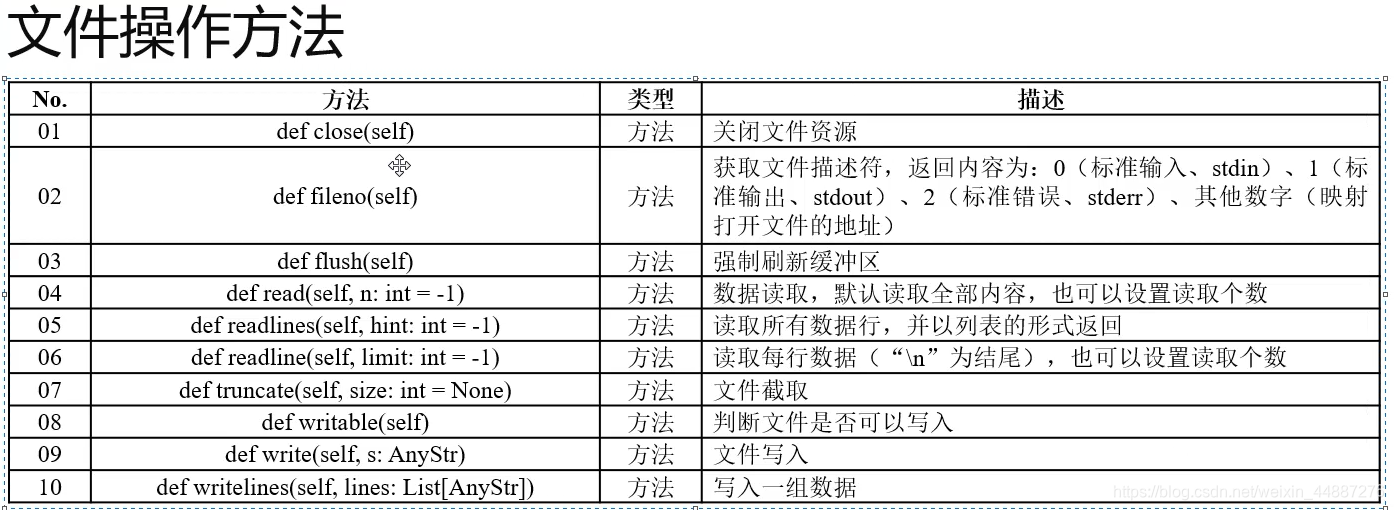

# 3. 文件与目录操作

在本章节中,我们将深入探讨Python中如何进行文件与目录操作,这是日常编程和系统管理中不可或缺的技能。我们会从基础的文件读写开始,逐步深入到目录管理,最后讨论文件系统监控的相关技术和方法。

## 3.1 文件读写

### 3.1.1 文件打开与关闭

在Python中,文件操作的第一步通常是打开一个文件。这个步骤涉及到指定文件路径和模式(如读取、写入或追加)。以下是打开文件的基本方法:

```python

file_path = 'example.txt'

file = open(file_path, 'r') # 打开文件用于读取

# 在这里对文件进行操作...

file.close() # 关闭文件

```

在本例中,我们使用`open()`函数以读取模式打开名为`example.txt`的文件。使用`close()`方法关闭文件是一个好习惯,它可以帮助释放系统资源。不过,更安全的方法是使用`with`语句,它可以自动管理文件的打开和关闭:

```python

with open(file_path, 'r') as ***

* 在这里对文件进行操作...

pass

```

使用`with`语句可以保证文件在代码块执行完毕后自动关闭。

### 3.1.2 文件内容读取与写入

读取文件内容是文件操作的常见需求。以下是如何读取和写入文件内容的示例:

```python

# 读取文件内容

with open(file_path, 'r') as ***

*** 读取整个文件

print(content)

# 写入文件内容

with open(file_path, 'w') as ***

***'新的内容\n') # 写入新的内容

```

在这里,我们使用`read()`方法读取整个文件内容,并使用`write()`方法写入新的内容。当以写入模式打开文件时,如果文件已存在,原有内容会被清空。

### 文件读写操作的参数说明

- `file_path`: 文件路径,可以是相对路径或绝对路径。

- `'r'`: 读取模式,文件指针位于文件开始位置。

- `'w'`: 写入模式,文件指针位于文件开始位置,原有内容会被清空。

- `'a'`: 追加模式,文件指针位于文件末尾,写入的数据会被添加到文件末尾。

### 代码逻辑解读

- `with`语句:创建一个上下文环境,确保文件正确关闭。

- `file.read()`: 读取文件全部内容。

- `file.write()`: 将数据写入文件。

### 代码执行逻辑说明

- `file.close()`: 手动关闭文件,释放系统资源。

- `file.read()`和`file.write()`方法:分别用于读取和写入文件内容。

### 优化方法

- 使用`with`语句自动管理文件的打开和关闭,避免文件未关闭的风险。

- 根据需要选择合适的文件打开模式,`'r'`、`'w'`、`'a'`等。

## 3.2 目录管理

### 3.2.1 创建与删除目录

在处理文件时,我们经常需要创建或删除目录。以下是创建和删除目录的基本操作:

```python

import os

# 创建目录

os.mkdir('new_directory')

# 删除目录

os.rmdir('new_directory')

```

在本例中,我们使用`os.mkdir()`函数创建一个名为`new_directory`的新目录,使用`os.rmdir()`函数删除该目录。

### 3.2.2 文件与目录的复制与移动

文件和目录的复制与移动是另一种常见的操作。以下是如何在Python中进行这些操作的示例:

```python

import shutil

# 复制文件

shutil.copy('source_file.txt', 'destination_directory')

# 移动文件

shutil.move('source_file.txt', 'destination_directory')

```

在这里,我们使用`shutil`模块中的`copy()`和`move()`函数分别复制和移动文件。

### 目录管理操作的参数说明

- `os.mkdir()`: 创建目录,路径为提供的目录名。

- `os.rmdir()`: 删除目录,路径为提供的目录名。

- `shutil.copy()`: 复制文件,第一个参数为源文件路径,第二个参数为目标目录路径。

- `shutil.move()`: 移动文件,第一个参数为源文件路径,第二个参数为目标目录路径。

### 代码逻辑解读

- `os.mkdir()`: 创建一个新的目录。

- `os.rmdir()`: 删除一个空目录。

- `shutil.copy()`: 复制文件到指定目录。

- `shutil.move()`: 将文件移动到指定目录。

### 代码执行逻辑说明

- `os.mkdir()`和`os.rmdir()`: 目录操作函数。

- `shutil.copy()`和`shutil.move()`: 文件操作函数,支持跨目录操作。

### 优化方法

- 使用`os.path.exists()`检查目录是否存在,避免重复创建。

- 使用`shutil.copytree()`和`shutil.move()`批量处理目录复制和移动。

## 3.3 文件系统监控

### 3.3.1 监听文件系统事件

监听文件系统事件对于实现如文件监视器等应用至关重要。以下是使用`watchdog`库进行文件系统监控的示例:

```python

import time

import logging

from watchdog.observers import Observer

from watchdog.events import FileSystemEventHandler

class Handler(FileSystemEventHandler):

def on_modified(self, event):

if not event.is_directory:

print(f'{event.src_path} has been modified')

# 设置日志

logging.basicConfig(level=***)

# 创建事件处理类实例

event_handler = Handler()

observer = Observer()

observer.schedule(event_handler, path='.', recursive=True)

observer.start()

try:

while True:

time.sleep(1)

except KeyboardInterrupt:

observer.stop()

observer.join()

```

在本例中,我们使用`watchdog`库创建一个简单的文件监视器,它会监听当前目录及其子目录下所有文件的变化,并打印出发生变化的文件路径。

### 3.3.2 文件系统性能分析

文件系统性能分析可以帮助我们了解文件操作的效率,从而优化程序性能。以下是如何使用`os`和`time`模块进行基本性能分析的示例:

```python

import os

import time

file_path = 'example.txt'

start_time = time.time()

# 执行文件操作,例如读取文件

with open(file_path, 'r') as ***

***

***'文件操作耗时:{end_time - start_time}秒')

```

在这个例子中,我们记录了执行文件读取操作前后的系统时间,并计算了操作的总耗时。

### 文件系统监控操作的参数说明

- `watchdog.observers.Observer()`: 创建一个监控器实例。

- `watchdog.events.FileSystemEventHandler()`: 创建一个事件处理类实例。

- `observer.schedule()`: 设置监控路径和是否递归监控子目录。

- `observer.start()`: 启动监控器。

- `os.path.exists()`: 检查路径是否存在。

- `time.time()`: 获取当前时间的时间戳。

### 代码逻辑解读

- `Handler`: 自定义事件处理类,响应文件系统事件。

- `Observer`: 监控器,负责监控文件系统事件。

- `time.time()`: 用于计算文件操作的时间。

### 代码执行逻辑说明

- 创建监控器和事件处理类实例。

- 设置监控器监控路径和事件类型。

- 启动监控器并等待事件发生。

- 计算并打印文件操作的耗时。

### 优化方法

- 使用专门的性能分析工具,如`cProfile`,进行更详细的性能分析。

- 对关键代码段进行性能优化,例如缓存数据和使用更快的文件读写方法。

通过本章节的介绍,我们了解了Python中文件与目录操作的基本方法和高级技巧。这些技能对于处理日常编程任务和系统管理都至关重要。在实际应用中,我们可以结合使用这些方法,实现更加复杂和高效的文件处理系统。

# 4. 网络编程与远程通信

## 4.1 网络请求

### 4.1.1 发送HTTP请求

在现代的网络编程中,发送HTTP请求是一个基础且重要的操作。Python中的`requests`库是处理HTTP请求的事实标准库。以下是一个使用`requests`库发送GET请求的简单示例:

```python

import requests

# 发送GET请求

response = requests.get('***')

# 输出响应内容

print(response.text)

```

这段代码首先导入了`requests`库,然后使用`get`方法发送了一个HTTP GET请求到指定的URL,并打印了响应的内容。

#### 参数说明

- `requests.get(url, params=None, **kwargs)`: 发送GET请求,其中`url`是目标URL,`params`是可选的字典,包含URL参数,`**kwargs`表示传递给`Session.request()`方法的参数。

#### 逻辑分析

1. **导入requests库**:这是使用requests库的第一步,它提供了一系列简便的方法来进行HTTP请求。

2. **发送GET请求**:`requests.get()`方法用于发送GET请求,它返回一个`Response`对象,包含服务器的响应内容。

3. **输出响应内容**:`response.text`包含了服务器返回的数据,默认是字符串格式。

### 4.1.2 处理网络响应

处理HTTP响应是网络编程的另一个重要部分。`requests`库返回的`Response`对象包含了服务器响应的全部信息。以下是如何处理HTTP响应的示例:

```python

import requests

# 发送GET请求

response = requests.get('***')

# 检查响应状态码

if response.status_code == 200:

# 解析响应内容

data = response.json()

print(data)

else:

print(f'请求失败,状态码:{response.status_code}')

```

#### 参数说明

- `response.status_code`: 响应的状态码,例如`200`表示成功,`404`表示未找到等。

- `response.json()`: 如果响应的内容是JSON格式,使用`json()`方法可以将其解析为Python字典。

#### 逻辑分析

1. **检查响应状态码**:在处理响应之前,首先检查状态码,确保请求成功。

2. **解析响应内容**:如果响应成功,可以使用`response.json()`方法将JSON格式的响应内容解析为Python数据结构。

通过本章节的介绍,我们了解了如何使用Python的`requests`库发送HTTP请求以及如何处理响应。这些是网络编程中的基础操作,对于进行远程数据获取和交互至关重要。在本章节中,我们详细讨论了发送GET请求和处理网络响应的方法,以及如何解析JSON格式的数据。这些技能对于任何需要与远程服务器通信的Python开发者来说都是必不可少的。总结而言,本章节的内容为网络编程和远程通信打下了坚实的基础,为后续章节中更高级的应用提供了支撑。

# 5. 图像处理与多媒体应用

图像处理与多媒体应用是Python misc库中一个非常实用的领域,它可以帮助开发者处理各种图像和音频视频数据,实现图像识别、图像增强、音频处理、视频分析等功能。本章节将详细介绍图像处理基础、多媒体处理以及图像分析与增强等方面的内容。

## 5.1 图像处理基础

图像处理基础是多媒体应用的重要组成部分,涉及到图像的读取、显示以及基本操作。在这个子章节中,我们将学习如何使用Python misc库中的相关模块来处理图像数据。

### 5.1.1 图像读取与显示

在进行图像处理之前,我们首先需要学会如何读取和显示图像。Python中的`PIL`库(Python Imaging Library)提供了非常方便的图像处理功能。以下是使用`PIL`库读取和显示图像的基本步骤:

1. 导入`PIL`库中的`Image`模块。

2. 使用`Image.open()`函数打开图像文件。

3. 使用`Image.show()`函数显示图像。

```python

from PIL import Image

# 打开图像文件

image_path = 'example.jpg'

image = Image.open(image_path)

# 显示图像

image.show()

```

在这段代码中,我们首先导入了`Image`模块,然后使用`Image.open()`函数打开了一个名为`example.jpg`的图像文件。最后,我们调用`Image.show()`函数来显示这张图像。这是一个非常基础的操作,但它为后续的图像处理工作奠定了基础。

### 5.1.2 基本图像操作

除了读取和显示图像,我们还需要学习如何进行基本的图像操作。这包括图像裁剪、旋转、缩放等。以下是使用`PIL`库进行图像裁剪的一个例子:

```python

# 图像裁剪示例

box = (100, 100, 200, 200) # 定义裁剪区域,左上角坐标和右下角坐标

cropped_image = image.crop(box)

# 显示裁剪后的图像

cropped_image.show()

```

在这个例子中,我们定义了一个裁剪区域`box`,并使用`Image.crop()`函数根据这个区域裁剪出图像的一部分。然后,我们使用`Image.show()`函数显示裁剪后的图像。通过这种方式,我们可以对图像进行各种操作,实现图像处理的基本需求。

### 5.1.3 图像处理的高级应用

除了上述的基础操作之外,图像处理还包括一些高级应用,例如图像滤波、边缘检测、图像分割等。这些操作通常需要更深入的图像处理知识和算法支持。Python中的`OpenCV`库是处理这类问题的强大工具。以下是一个使用`OpenCV`进行边缘检测的示例:

```python

import cv2

# 读取图像

image_path = 'example.jpg'

image = cv2.imread(image_path)

# 转换为灰度图像

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 使用Canny算法进行边缘检测

edges = cv2.Canny(gray_image, threshold1=100, threshold2=200)

# 显示边缘检测结果

cv2.imshow('Edges', edges)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

在这段代码中,我们首先使用`cv2.imread()`函数读取图像,然后将其转换为灰度图像。接着,我们使用`cv2.Canny()`函数进行边缘检测,并使用`cv2.imshow()`函数显示检测结果。这是一个处理图像的高级应用示例,展示了如何利用`OpenCV`库实现图像边缘检测。

## 5.2 多媒体处理

在处理图像的同时,我们还经常需要处理音频和视频文件。这些文件属于多媒体数据,它们通常包含丰富的信息量和复杂的数据结构。

### 5.2.1 音频文件处理

音频文件处理涉及到音频数据的读取、编辑、转换和保存等操作。Python中的`wave`库可以用来读取和写入音频数据,而`pydub`库则提供了更加高级的音频处理功能。以下是使用`pydub`库处理音频文件的一个简单示例:

```python

from pydub import AudioSegment

# 加载音频文件

audio_path = 'example.mp3'

audio = AudioSegment.from_file(audio_path)

# 裁剪音频文件

cropped_audio = audio[10000:20000]

# 导出裁剪后的音频文件

cropped_audio.export("cropped_audio.mp3", format="mp3")

```

在这个例子中,我们首先使用`AudioSegment.from_file()`函数加载了一个MP3音频文件。然后,我们使用切片操作来裁剪音频文件,并使用`AudioSegment.export()`函数将裁剪后的音频导出为一个新的文件。

### 5.2.2 视频文件处理

视频文件处理是多媒体处理中的另一个重要方面。它通常包括视频的读取、帧提取、编辑和渲染等操作。Python中的`moviepy`库提供了处理视频文件的强大功能。以下是使用`moviepy`库进行视频帧提取的一个示例:

```python

from moviepy.editor import VideoFileClip

# 加载视频文件

video_path = 'example.mp4'

video = VideoFileClip(video_path)

# 提取视频的每一帧

frames = [frame for frame in video.iter_frames()]

# 保存每一帧为图片

for i, frame in enumerate(frames):

frame.save(f'frame_{i}.jpg')

video.close()

```

在这段代码中,我们使用`VideoFileClip()`函数加载了一个MP4视频文件,并使用`iter_frames()`函数迭代提取每一帧。然后,我们将每一帧保存为单独的图片文件。

### 5.2.3 音频和视频的综合处理

在实际应用中,我们可能需要将音频和视频结合起来进行处理。例如,我们需要将视频中的音频替换为另一个音频文件。这可以通过`moviepy`库来实现:

```python

from moviepy.editor import VideoFileClip, AudioFileClip

# 加载视频文件和音频文件

video_path = 'example.mp4'

audio_path = 'example.mp3'

video = VideoFileClip(video_path)

audio = AudioFileClip(audio_path)

# 将视频的音频替换为另一个音频文件

new_video = video.set_audio(audio)

# 导出新的视频文件

new_video.write_videofile("new_video.mp4")

```

在这段代码中,我们首先加载了一个视频文件和一个音频文件。然后,我们使用`set_audio()`函数将视频的音频替换为另一个音频文件,并使用`write_videofile()`函数将修改后的视频导出为一个新的视频文件。

## 5.3 图像分析与增强

图像分析与增强是图像处理领域中的高级应用,涉及到图像的特征提取、边缘检测、图像增强等复杂操作。这些技术通常用于图像识别、图像分类、图像复原等任务。

### 5.3.1 边缘检测与特征提取

边缘检测是图像分析中的一个重要步骤,它可以帮助我们识别图像中的边缘和轮廓。Python中的`OpenCV`库提供了多种边缘检测算法,如Canny边缘检测、Sobel边缘检测等。以下是一个使用Sobel算法进行边缘检测的示例:

```python

import cv2

import numpy as np

# 读取图像

image_path = 'example.jpg'

image = cv2.imread(image_path, cv2.IMREAD_GRAYSCALE)

# Sobel边缘检测

edges = cv2.Sobel(image, cv2.CV_64F, 1, 1)

# 显示边缘检测结果

cv2.imshow('Sobel Edges', edges)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

在这段代码中,我们首先使用`cv2.imread()`函数读取图像,并将其转换为灰度图像。然后,我们使用`cv2.Sobel()`函数进行Sobel边缘检测,并使用`cv2.imshow()`函数显示检测结果。

### 5.3.2 图像增强技术

图像增强技术包括对比度调整、亮度调整、直方图均衡化等。这些技术可以帮助我们改善图像的视觉效果,使其更适合进行分析和识别。以下是一个使用直方图均衡化进行图像增强的示例:

```python

import cv2

import numpy as np

# 读取图像

image_path = 'example.jpg'

image = cv2.imread(image_path, cv2.IMREAD_GRAYSCALE)

# 直方图均衡化

equalized_image = cv2.equalizeHist(image)

# 显示增强后的图像

cv2.imshow('Equalized Image', equalized_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

在这段代码中,我们首先使用`cv2.imread()`函数读取图像,并将其转换为灰度图像。然后,我们使用`cv2.equalizeHist()`函数进行直方图均衡化,并使用`cv2.imshow()`函数显示增强后的图像。

### 5.3.3 图像分析的高级应用

图像分析的高级应用通常涉及到图像识别、图像分类等任务。Python中的`tensorflow`和`keras`库提供了强大的工具来构建和训练图像识别模型。以下是使用`tensorflow`和`keras`进行图像分类的一个简单示例:

```python

import tensorflow as tf

from tensorflow.keras import layers, models

# 构建一个简单的卷积神经网络模型

model = models.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.Flatten(),

layers.Dense(64, activation='relu'),

layers.Dense(10, activation='softmax')

])

# 编译模型

***pile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

# 这里假设我们已经有了训练数据和标签

train_images = ...

train_labels = ...

model.fit(train_images, train_labels, epochs=5, batch_size=64)

# 使用模型进行预测

# 假设我们有一张新的图像需要预测

test_image = ...

test_image = test_image.reshape((1, 28, 28, 1))

predicted_label = model.predict(test_image)

```

在这段代码中,我们首先构建了一个简单的卷积神经网络模型,并使用`***pile()`函数编译模型。然后,我们使用`model.fit()`函数对模型进行训练,并使用`model.predict()`函数进行预测。

### 5.3.4 图像增强的案例分析

本章节将通过一个实际案例来分析图像增强的应用。假设我们有一个低对比度的图像,我们希望通过图像增强技术提高其对比度,使其更适合进行分析。以下是使用直方图均衡化进行图像增强的步骤:

1. 读取图像。

2. 转换为灰度图像。

3. 应用直方图均衡化。

4. 显示增强后的图像。

通过这个案例,我们可以学习如何将理论知识应用到实际问题中,实现图像增强的效果。

### 5.3.5 图像分析技术的实践

在本章节中,我们将介绍如何使用Python进行图像分析的实践。我们可以通过构建一个简单的图像识别模型来实践图像分析技术。以下是构建一个简单图像识别模型的步骤:

1. 收集和预处理图像数据。

2. 构建神经网络模型。

3. 训练模型。

4. 使用模型进行预测。

通过这个实践案例,我们可以更深入地理解图像分析技术的应用,并将其应用于实际问题中。

## 结语

在本章节中,我们详细介绍了图像处理与多媒体应用的相关知识,包括图像处理基础、多媒体处理以及图像分析与增强等方面的内容。通过学习这些知识,我们可以更好地理解和应用Python misc库来处理图像和多媒体数据,实现各种图像处理和多媒体应用的需求。

# 6. 杂项工具与高级应用

## 6.1 编码转换工具

### 字符编码转换

在处理文本数据时,经常需要进行字符编码的转换。Python的内置库misc提供了非常方便的工具来进行这种转换。例如,我们将一个字符串从UTF-8编码转换为GBK编码,可以直接使用`encode`和`decode`方法。

```python

# 原始字符串

original_str = "这是一个测试字符串。"

# UTF-8编码转换为GBK

gbk_encoded_str = original_str.encode('utf-8').decode('gbk')

print(gbk_encoded_str)

```

### 数据序列化与反序列化

序列化是指将数据结构或对象状态转换为可以存储或传输的形式的过程。Python中的`pickle`模块可以实现数据的序列化与反序列化。

```python

import pickle

# 序列化数据

original_data = {'name': 'John', 'age': 30}

serialized_data = pickle.dumps(original_data)

# 反序列化数据

deserialized_data = pickle.loads(serialized_data)

print(deserialized_data)

```

## 6.2 调试与性能优化

### Python代码调试技巧

调试是软件开发中不可或缺的一环,Python提供了多种调试工具,如`pdb`。使用`pdb`可以设置断点、单步执行、查看变量等。

```python

import pdb

def my_function():

a = 5

b = 0

c = a / b

pdb.run('my_function()')

```

### 性能分析与优化方法

性能分析是确定程序运行瓶颈的过程。Python的`cProfile`模块可以帮助我们分析程序的性能。

```python

import cProfile

import re

def test():

pattern = ***pile(r'[a-z]+')

text = 'This is a test string for regular expression'

matches = pattern.findall(text)

cProfile.run('test()')

```

通过运行这个脚本,我们可以获得一个性能报告,了解哪些部分占用了较多的时间。

## 6.3 实用案例分析

### 实用工具的应用场景

在实际开发中,我们经常会遇到需要处理CSV文件、压缩文件等场景。Python的`csv`和`zipfile`模块可以方便地进行这类操作。

### 案例详解与代码实现

#### CSV文件处理

```python

import csv

# 读取CSV文件

with open('example.csv', mode='r', encoding='utf-8') as ***

***

***

***

* 写入CSV文件

with open('output.csv', mode='w', encoding='utf-8', newline='') as ***

***

***['Name', 'Age', 'City'])

writer.writerow(['Alice', '24', 'New York'])

```

#### 压缩文件处理

```python

import zipfile

# 压缩文件

with zipfile.ZipFile('archive.zip', 'w') as zipf:

zipf.write('example.txt', 'texts/example.txt')

# 解压缩文件

with zipfile.ZipFile('archive.zip', 'r') as zipf:

zipf.extractall('extracted')

```

通过上述代码示例,我们可以看到如何使用Python内置库misc来进行日常开发中常见的任务。这些工具和方法可以大大提高我们的工作效率。

0

0