【同步与通信】:理解操作系统中的进程同步机制

发布时间: 2024-12-16 05:25:46 阅读量: 3 订阅数: 5

操作系统实验:进程通信与进程同步(CTGU)

参考资源链接:[《操作系统设计与实现(第3版)》PDF完整版:MINIX3详解与教学经典](https://wenku.csdn.net/doc/4jdxtguifz?spm=1055.2635.3001.10343)

# 1. 进程同步机制概述

在多任务操作系统中,进程同步是保证数据一致性和系统稳定性不可或缺的技术。本章将对进程同步机制进行宏观概述,为后续章节的深入分析与应用奠定基础。

## 1.1 进程同步的重要性

进程同步主要解决的是多个进程在同一时刻对共享资源访问时可能出现的冲突问题。随着现代软件系统的规模日益膨胀,进程间协调变得更加复杂,同步机制的合理使用成为了系统设计中的关键要素。

## 1.2 同步与并发的关系

并发是指两个或多个事件在同一时间间隔内发生,而同步则是为了协调这些并发事件的执行顺序,确保资源的合理分配和任务的正确执行。理解同步与并发的关系有助于我们更好地把握进程同步机制的实际应用。

## 1.3 同步机制的目标

同步机制的目标是通过一种控制机制来保证进程按预定的顺序执行,从而避免数据不一致、竞争条件等问题。在本章的后续内容中,我们将详细探讨如何通过不同技术实现这一目标。

# 2. 基础理论与模型

## 2.1 操作系统进程管理基础

### 2.1.1 进程的定义与状态

进程是操作系统进行资源分配和调度的基本单位,是独立运行的活动实体。一个进程通常包括程序代码、处理机状态、变量集合等组成。进程的定义涵盖了它在内存中的代码、数据集以及一个执行线程,还可能包括与其他进程通信的机制。

进程状态通常分为三种:**就绪态**(Ready)、**运行态**(Running)、**等待态**(Waiting)。当进程获得资源和处理机后,它可以处于运行态;当进程在等待某个事件发生时,它处于等待态;当进程拥有了除CPU外的所有必要资源时,它处于就绪态。

### 2.1.2 进程间通信的基本概念

进程间通信(IPC)是指在不同进程间交换信息或数据的过程。进程间通信机制包括管道(Pipes)、消息队列、共享内存、信号量和套接字等。通信机制选择取决于进程间关系、数据传输量、传输速度需求等因素。

进程间通信允许系统中多个独立工作的进程共享资源和协调工作。正确实现IPC能够避免诸如竞争条件、死锁和资源饥饿等问题。

## 2.2 同步与互斥理论

### 2.2.1 同步的概念与作用

同步是指协调并发进程之间的执行顺序,以保证共享资源的正确访问。进程同步的主要目的是控制多个进程访问共享资源的次序,使并发执行的进程之间能够有效协作,完成预定的任务。

没有同步的并发执行可能会导致数据不一致和竞态条件等问题。通过同步机制,我们可以确保进程之间有序地访问共享资源,从而避免这些问题。

### 2.2.2 互斥的基本原理与需求

互斥是系统中确保对共享资源互斥访问的一种同步机制。互斥原理基于"临界区"概念,即同一时刻只允许一个进程访问的一段代码。

互斥的需求是保证多个并发进程中的某一个对共享资源的访问不会被其他进程打断。这有助于防止数据的不一致和系统的不稳定,如数据被破坏或系统崩溃。

## 2.3 同步机制的理论模型

### 2.3.1 信号量模型

信号量是一个用于进程同步和互斥的整数变量,它提供了一种简单的机制来控制对共享资源的访问。信号量的基本操作包括:`wait()`(或P操作),用于申请资源;`signal()`(或V操作),用于释放资源。

信号量模型可以解决以下问题:

- 二进制信号量(互斥锁):用于控制对单个资源的互斥访问。

- 计数信号量:用于控制对一组资源的访问,每个`wait()`操作都会将信号量的值减一,直到信号量的值为零时,其他进程必须等待。

### 2.3.2 管程模型

管程(Monitor)是另一种同步原语,它提供了对多个共享资源的安全访问控制。管程内封装了共享数据和访问这些数据的方法。进程通过调用管程中的方法来执行同步操作。

管程模型通过锁机制提供互斥,通过条件变量来实现进程间的同步。与信号量模型相比,管程模型更加高级,提供了更结构化的同步方式。

### 2.3.3 消息传递模型

消息传递模型是指进程间通过发送和接收消息来交换信息。消息传递机制可以用于同步也可以用于通信,它能够提供一种相对简单的方式来协调进程行为。

消息传递模型的优点包括:

- 易于实现分布式系统中的进程间通信。

- 可以避免竞态条件和死锁。

- 方便进行系统扩展,适应性强。

```mermaid

graph LR

A[开始] --> B[创建消息队列]

B --> C[发送者准备消息]

C --> D[发送消息至队列]

D --> E[接收者从队列中取出消息]

E --> F[处理消息]

F --> G[结束]

```

在消息传递模型中,系统需要维护消息队列的数据结构,以及相关操作如创建、发送和接收消息的实现。这些操作需要保证同步和互斥,以免出现竞态条件。

# 3. 经典同步技术详解

## 3.1 互斥锁(Mutex)

### 3.1.1 互斥锁的工作原理

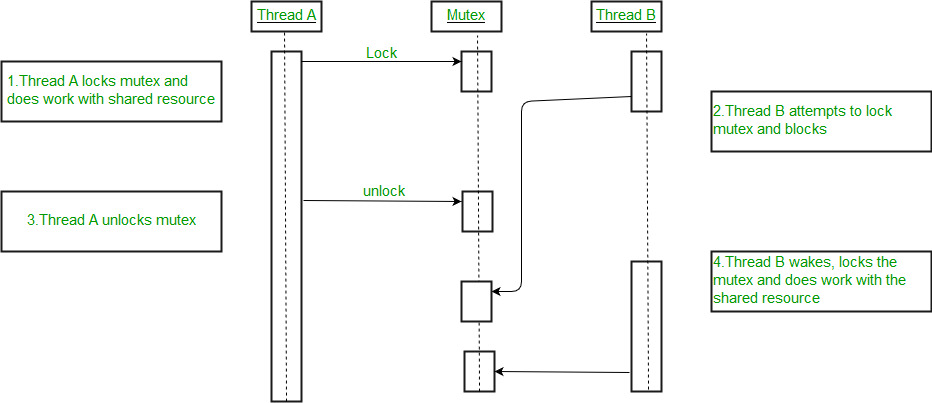

互斥锁(Mutual Exclusion Lock)是一种广泛应用于多线程编程中的同步机制,旨在确保共享资源在同一时刻只被一个线程访问。当一个线程获取到互斥锁时,其他试图进入临界区的线程将会被阻塞,直到锁被释放。这种机制保证了数据的一致性和完整性,避免了竞态条件的发生。

互斥锁的核心实现依赖于操作系统提供的原子操作,确保锁的获取和释放是不可分割的。当一个线程试图获取锁时,如果锁处于空闲状态,则线程成功进入临界区,并将锁的状态设置为已占用。如果锁已经被其他线程占用,当前线程将进入等待状态,直到锁变为可用。

```c

pthread_mutex_t lock = PTHREAD_MUTEX_INITIALIZER;

void *task(void *arg) {

pthread_mutex_lock(&lock);

// 临界区开始

// 线程将执行需要同步的操作

// 临界区结束

pthread_mutex_unlock(&lock);

return NULL;

}

```

### 3.1.2 互斥锁的使用场景与优缺点

互斥锁适用于任何需要保护共享资源免受并发访问破坏的场景。它简单易用,适用于多线程或多进程环境中对共享数据的访问控制。互斥锁的使用场景包括但不限于:

- 数据库访问控制

- 文件系统读写操作

- 共享内存的访问

尽管互斥锁广泛使用,但它也有一些缺点。互斥锁的过度使用可能导致性能下降,特别是在高并发的环境下。当多个线程频繁地争用同一把锁时,线程可能会花费大量时间在等待锁的释放上,造成资源的浪费。此外,如果持有锁的线程在临界区内执行时间过长,会导致其他线程饥饿,增加系统的延迟。

## 3.2 信号量(Semaphore)

### 3.2.1 信号量的实现机制

信号量是一种更为通用的同步机制,它不仅可以实现互斥锁的功能,还可以控制多个线程对资源的并发访问。信号量维护了一个计数器,表示可用资源的数量。线程通过执行特定的操作(如等待 wait 或信号 sig

0

0