R语言机器学习入门指南:用gafit包构建精准预测模型

发布时间: 2024-11-02 10:30:44 阅读量: 22 订阅数: 33

# 1. R语言机器学习基础与gafit包简介

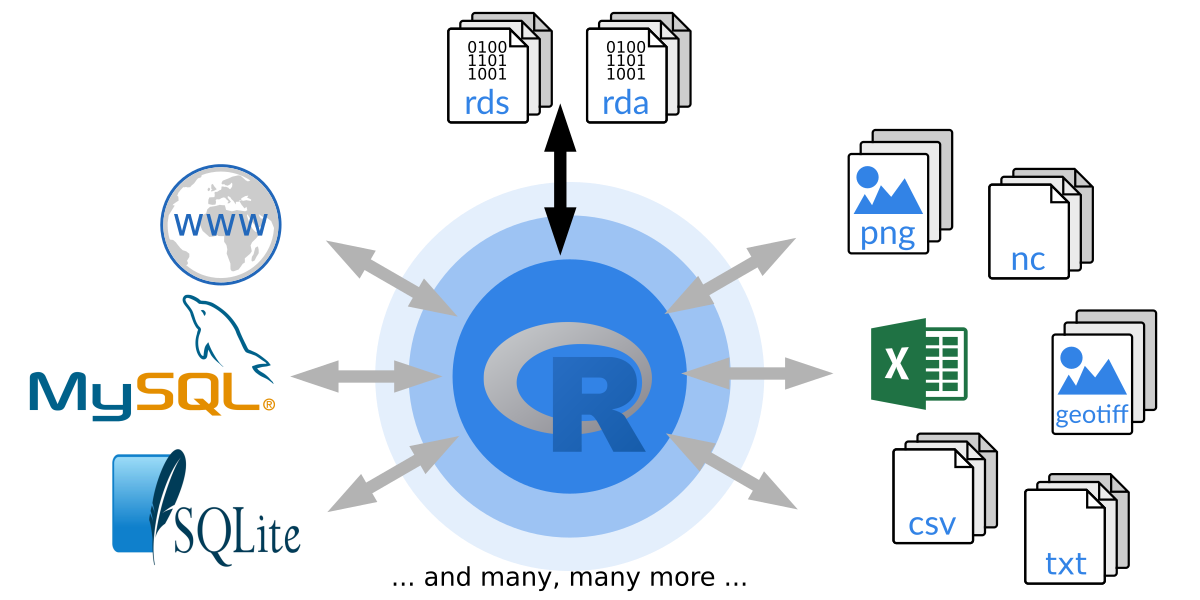

## R语言概述

R语言是一种用于统计计算和图形表示的编程语言,它在数据分析、机器学习和科研领域中广泛应用。R语言拥有丰富的包支持,为处理复杂的数据分析任务提供了强大的工具。

## 机器学习简介

机器学习是人工智能的一个分支,它使计算机能够通过经验自我改进。在R语言中,有多个包可以用于执行机器学习任务,如著名的`caret`、`mlr`以及我们即将深入探讨的`gafit`。

## gafit包简介

`gafit`包提供了一系列用于拟合广义加性模型的函数。这些模型是线性模型的推广,能够描述变量之间的非线性关系。它在处理复杂数据结构时尤为有用,使得在R语言环境中的数据分析和模型构建变得更加灵活高效。在后续章节中,我们将探讨如何使用`gafit`包进行数据预处理、模型构建、诊断与评价等机器学习任务。

# 2. 数据预处理和模型准备

## 2.1 数据预处理基础

### 2.1.1 数据清洗技巧

数据清洗是数据预处理的重要环节,确保了数据分析和模型构建的质量。在R语言中,数据清洗通常包括处理缺失值、异常值以及数据格式的一致性调整。

使用基础R函数或`dplyr`包可以有效地处理缺失值。例如,`na.omit()`函数能去除含有缺失值的数据行,而`is.na()`函数可以帮助识别缺失值位置。对于异常值,可以通过描述性统计量如四分位数来识别并决定是修正还是删除这些值。例如,可以通过`IQR()`函数计算四分位数间距,并排除超出阈值的点。

在处理时间序列数据时,确保所有时间戳的数据类型一致,通常需要转换为POSIXct格式。`as.POSIXct()`函数可以实现这一点,并且可以指定不同的时间格式。

```r

# 示例代码:处理缺失值

data <- na.omit(data) # 去除含有缺失值的行

data[is.na(data)] <- mean(data, na.rm = TRUE) # 缺失值用均值替代

# 示例代码:识别并处理异常值

Q1 <- quantile(data$column, 0.25)

Q3 <- quantile(data$column, 0.75)

IQR <- Q3 - Q1

data <- data[data$column >= (Q1 - 1.5 * IQR) & data$column <= (Q3 + 1.5 * IQR), ]

# 使用`lubridate`处理时间数据

library(lubridate)

data$date <- ymd(data$date) # ymd()将字符串转换为POSIXct格式

```

### 2.1.2 数据标准化和转换方法

数据标准化和转换是减少模型偏差和提高模型性能的关键步骤。标准化一般指的是将数据转换为均值为0、标准差为1的分布,常用的函数有`scale()`。

数据转换包括对数转换、平方根转换等,它们通常用于缓解数据的偏态分布或减少方差不稳定性。比如,使用`log()`函数可以对数据进行对数转换。

```r

# 示例代码:数据标准化

data$normalized_column <- scale(data$column)

# 示例代码:对数转换

data$log_column <- log(data$column + 1) # 加1是为了处理0值

```

## 2.2 探索性数据分析(EDA)

### 2.2.1 可视化技术与gafit结合

探索性数据分析(EDA)是通过统计图表来发现数据集中趋势、模式和异常点的过程。在R中,基础绘图系统和`ggplot2`包提供了丰富的可视化工具。

使用`ggplot2`包可以创建各种复杂的图形,它提供了一种名为`layering`的系统,通过叠加不同层来构建图形。这在分析数据特征和相互关系时尤为有用,例如使用`geom_point()`创建散点图,用`geom_smooth()`添加趋势线。

结合gafit包时,可以将EDA的结果与模型输出相比较,如通过可视化模型预测值和实际值来评估模型的准确性。

```r

# 示例代码:使用ggplot2绘制散点图

library(ggplot2)

ggplot(data, aes(x = independent, y = dependent)) +

geom_point() +

geom_smooth(method = "lm") # 添加线性模型趋势线

```

### 2.2.2 特征选择和相关性分析

特征选择对于提高模型性能至关重要。R语言提供了`cor()`函数来计算两变量之间的相关系数,通过设置阈值可以筛选出与目标变量相关性较高的特征。

此外,`caret`包中的`findCorrelation()`函数可以自动识别并剔除高度相关的特征。而`relaimpo`包可以用来评估特征对模型预测能力的贡献程度。

```r

# 示例代码:计算并筛选特征的相关系数

cor_matrix <- cor(data)

highly_correlated <- findCorrelation(cor_matrix, cutoff = 0.7)

selected_features <- data[-highly_correlated]

# 示例代码:特征重要性评估

library(relaimpo)

importance <- calc.relimp(data$target, data[, -target], type = "lmg")

print(importance)

```

## 2.3 模型构建前的准备工作

### 2.3.1 分割数据集为训练集和测试集

在模型构建前,需要将数据集分割为训练集和测试集。R语言中的`caret`包提供了便捷的函数`createDataPartition()`来划分数据集,以确保分割后的训练集和测试集保持相似的分布。

分割数据集的目的是为了用训练集来构建模型,并使用测试集来评估模型性能。通常,训练集和测试集按照7:3或者8:2的比例进行划分。

```r

# 示例代码:分割数据集为训练集和测试集

set.seed(123) # 设置随机种子以获得可重复的结果

index <- createDataPartition(data$target, p = 0.8, list = FALSE)

train_data <- data[index, ]

test_data <- data[-index, ]

```

### 2.3.2 交叉验证的概念和实践

交叉验证是评估模型泛化能力的一种方法。在R中,可以使用`caret`包实现k折交叉验证。交叉验证通过将数据集分割为k个子集,然后轮流将每个子集作为测试集,其余作为训练集进行模型构建。

通过多次的训练和验证,可以得到一个较为稳定的性能指标。此外,`trainControl()`函数允许我们指定交叉验证的类型和次数。

```r

# 示例代码:k折交叉验证

train_control <- trainControl(method = "cv", number = 10) # 10折交叉验证

model <- train(target ~ ., data = train_data, method = "lm", trControl = train_control)

```

# 第三章:使用gafit包进行线性回归分析

## 3.1 线性回归理论基础

### 3.1.1 线性回归模型的数学原理

线性回归是最基本的回归模型,旨在找出一个或多个自变量与因变量之间的线性关系。其数学表达式为`Y = β0 + β1X1 + β2X2 + ... + ε`,其中`Y`是因变量,`X1, X2, ...`是自变量,`β0`是截距,`β1, β2, ...`是回归系数,而`ε`是误差项。

线性回归模型的估计一般采用最小二乘法(OLS),此方法可找到回归系数的最优估计,使得误差平方和最小。这可以通过线性代数求解正规方程或梯度下降法等算法实现。

## 3.1.2 参数估计和假设检验

参数估计是通过数据找到模型参数的过程,常见的参数估计方法包括极大似然估计和最小二乘估计。在R中,`lm()`函数可以直接进行最小二乘估计。

假设检验用于评估模型参数的统计显著性。常见的检验包括t检验和F检验,分别用于检验单个系数和整个模型的显著性。在R中,`summary()`函数可以输出线性模型的详细统计检验结果。

## 3.2 gafit包的线性回归应用

### 3.2.1 gafit包功能和语法

gafit

0

0