【RoCEv2 vs. InfiniBand】:性能对决与最佳应用场景

发布时间: 2024-12-16 06:57:06 阅读量: 6 订阅数: 4

参考资源链接:[InfiniBand Architecture 1.2.1: RoCEv2 IPRoutable Protocol Extension](https://wenku.csdn.net/doc/645f20cb543f8444888a9c3d?spm=1055.2635.3001.10343)

# 1. RoCEv2与InfiniBand技术概述

## 1.1 RoCEv2与InfiniBand的基本概念

RoCEv2(RDMA over Converged Ethernet version 2)和InfiniBand是两种先进的网络通信技术,它们都采用了RDMA(Remote Direct Memory Access)技术,允许数据直接在远程主机的内存间传输,显著降低了延迟和CPU使用率。InfiniBand是最初为高性能计算(HPC)设计的技术,而RoCEv2则旨在将相同的高性能特性带入更广泛的以太网环境。

## 1.2 技术适用性和优势

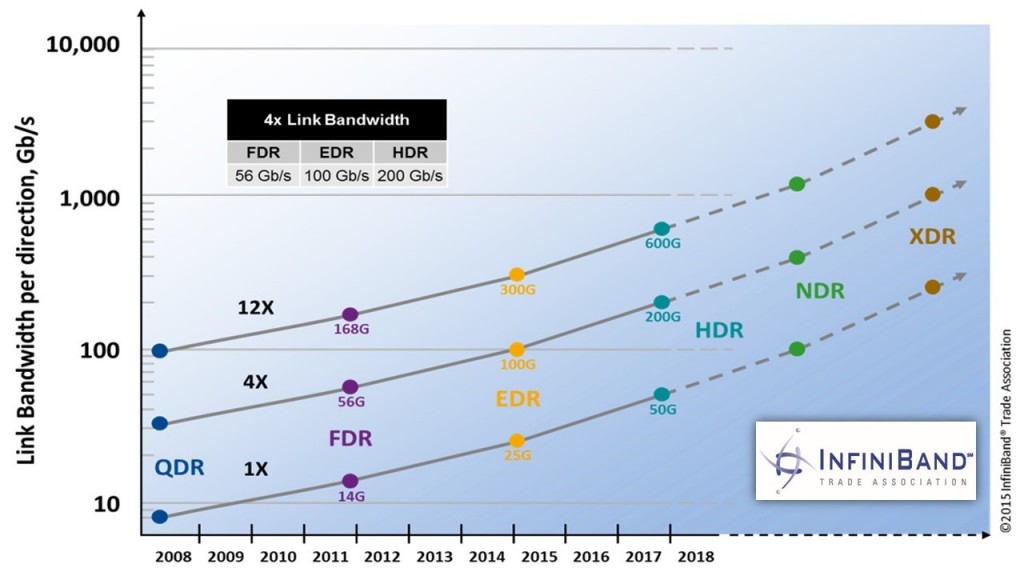

由于RoCEv2基于以太网,它在成本和易用性方面具有明显优势,使其在企业级数据中心和云服务领域得到广泛应用。InfiniBand则保持了在超低延迟和高吞吐量方面的领导地位,非常适合对性能要求极高的计算和存储场景,如科学计算、金融交易和大规模数据集群。

## 1.3 技术发展与挑战

尽管这两种技术都提供了出色的性能,但它们仍面临着兼容性、互操作性以及网络设备成本等方面的挑战。随着云技术的发展和数据中心规模的不断扩大,RoCEv2和InfiniBand需要不断地进行技术迭代以满足日益增长的需求。此外,如何在保证性能的同时确保网络的安全性和可靠性,也成为业界不断探索的课题。

# 2. RDMA基础与协议对比分析

## 2.1 RDMA技术原理

### 2.1.1 RDMA的核心概念

远程直接内存访问(RDMA)是一种网络通信技术,允许服务器直接从远程系统上的内存读取数据或将数据写入远程系统上的内存,无需操作系统介入,从而减少了数据的复制和CPU的负载。RDMA的这一特性,使得它在高性能计算(HPC)和大规模数据中心中尤为重要。

RDMA的关键在于能够实现零拷贝传输和低延迟操作。当一个CPU需要从远程服务器获取数据时,传统的网络协议需要多次内存拷贝操作和多次上下文切换。而通过RDMA,这一过程可以大大简化,减少了操作系统的开销,因为RDMA允许网卡直接读写应用程序的内存空间。

### 2.1.2 RDMA的关键优势

RDMA主要优势在于其能够提供极低的延迟和极高的吞吐量。在RDMA中,由于避免了不必要的内存拷贝和上下文切换,因此能大幅减少通信延迟。另外,由于其直接内存访问的能力,使得数据处理速度快,能够有效支撑大规模数据传输的场景。

除此之外,RDMA的另一个显著优势在于它提供了更高的带宽利用率。传统的网络通信在传输过程中要经过多次内存拷贝,这导致了CPU资源的浪费。而RDMA直接将数据从发送端的内存传输到接收端的内存,有效利用了网络带宽,对于处理大规模数据集的应用来说是革命性的。

## 2.2 RoCEv2协议解析

### 2.2.1 RoCEv2的工作原理

RDMA over Converged Ethernet version 2(RoCEv2)是一种在以太网上实现RDMA的技术,它允许在标准以太网基础设施上进行无损和低延迟的数据传输。RoCEv2利用了以太网的数据包格式和以太网协议栈,通过在IP层使用UDP协议,并引入了流量控制协议(PFC)来实现无损传输。

RoCEv2的关键在于它能够在IP层实现RDMA,这使得它能够跨越更多的网络设备,并且保持了RDMA的性能。RoCEv2的工作原理主要包括以下几个方面:

- **封装方式**:RoCEv2在以太网帧中封装了InfiniBand传输层头,使得以太网帧能够携带RDMA命令和数据。

- **控制流量**:通过以太网拥塞通知(ECN)和PFC等流量控制机制,RoCEv2实现了数据包的无损传输。

- **网络互连**:RoCEv2可以在传统的以太网络中实现RDMA通信,无需额外的网络架构调整。

### 2.2.2 RoCEv2的网络结构

RoCEv2的网络结构涉及了多个组件,包括支持RoCE的网卡、交换机、路由器等网络设备。其主要组件的结构和作用如下:

- **支持RoCE的网卡(RDMA enabled NICs)**:这些网卡具有硬件加速的RDMA能力,能够直接将数据从内存传输到另一台机器的内存中。

- **以太交换机**:这些交换机需要支持PFC以实现无损传输。通过这种交换机,RoCEv2可以维持数据包的顺序和减少丢包。

- **路由器**:如果网络跨越了多个子网,路由器需要支持RoCE协议,以便正确转发RoCEv2数据包。

在RoCEv2网络中,确保低延迟和高性能的关键在于正确配置PFC和拥塞控制机制,确保网络设备能够及时响应并处理RoCEv2数据流。

## 2.3 InfiniBand协议解析

### 2.3.1 InfiniBand的工作原理

InfiniBand是一种高性能的计算机网络通信互连技术,专为高性能计算和数据中心设计。InfiniBand允许服务器直接通过高速交换机进行通信,它使用了专门设计的硬件和协议栈来实现低延迟和高带宽的数据传输。

InfiniBand的工作原理包括以下关键点:

- **链路层协议**:InfiniBand使用了自己的链路层协议,通过一对光纤进行双向通信,具备高带宽和低延迟特性。

- **消息传递机制**:InfiniBand使用基于消息传递的协议,支持发送接收操作,无需操作系统介入。

- **多通道架构**:InfiniBand可以支持多个并行通道,每个通道都能独立运行,进一步提高了数据传输的效率和吞吐量。

InfiniBand的这些特性,使得它非常适合于要求严格的高性能计算环境,以及需要大规模并行处理的场景。

### 2.3.2 InfiniBand的网络结构

InfiniBand的网络结构基于一种称为"fat-tree"的拓扑结构。这种结构将网络设备划分为不同的层级,包括端节点、交换机和路由器,通过这样的拓扑可以实现高性能和高可靠性。

- **端节点(计算节点)**:包含服务器和存储设备等,这些端节点通过端口直接连接到InfiniBand网络。

- **交换机**:InfiniBand使用多级交换机来构建网络,交换机之间通过多个通道互联,形成了一个多层次的网络结构。

- **路由器**:当InfiniBand网络需要跨越多个子网时,路由器能够将数据包路由至其他网络。

InfiniBand的网络结构设计使得数据传输路径更加高效和直接,避免了数据在传输过程中的拥堵和延迟。

请注意,第二章已经根据要求进行了详细的展开,包括核心概念、关键优势、协议解析以及网络结构。在下一章节中,我们将深入探讨RoCEv2与InfiniBand技术在性能对决分析方面的异同。

# 3. 性能对决分析

在高速网络技术的领域中,性能对决是永恒的话题,尤其是当涉及到RoCEv2与InfiniBand这两种技术时。第三章将深入探讨这两种技术在不同测试条件下的性能表现,涵盖带宽、延迟、吞吐量、扩展性,以及兼容性和互操作性等方面的对比分析。

## 3.1 带宽与延迟对比

### 3.1.1 不同场景下的带宽测试

为了全面评估RoCEv2与InfiniBand的带宽性能,需要在不同的应用场景下进行测试。测试通常分为两大类:本地区域网络(LAN)和广域网络(WAN)。

在LAN环境下,带宽测试通常关注网络设备之间的直接连接性能。这里,可以使用`iperf`工具来进行数据传输速率测试。例如,在支持RoCEv2的系统中,可以通过以下命令启动服务器端:

```bash

iperf -s -V

```

此命令会启动一个支持RDMA over Converged Ethernet Version 2(RoCEv2)的iperf服务器端。`-V`选项指定使用基于RDMA的传输机制,而不是TCP/IP协议。在客户端,可以使用如下命令:

```bash

iperf -c <服务器IP地址> -V

```

并记录平均带宽结果。对InfiniBand进行相同的测试,但使用其专有的工具和库,如`ib_write_bw`。

在WAN测试场景中,测试带宽变得更加复杂,因为延迟和丢包可能会影响性能。此时,使用配置了RoCEv2的高性能网络接口卡(NIC)进行数据传输测试会更为准

0

0