性能监控新视角:使用Python platform模块揭秘系统瓶颈

发布时间: 2024-10-11 15:29:27 阅读量: 43 订阅数: 45

# 1. 性能监控的重要性与挑战

随着信息技术的快速发展,企业业务系统越来越复杂,性能监控成为保证业务连续性和用户体验的关键。性能监控不仅仅是对系统资源的简单跟踪,它涉及到对应用性能、用户体验和系统健康状态的全面监控。然而,实施有效的性能监控策略面临着诸多挑战。首先,随着IT架构的多样化,跨平台兼容性成为一大难题。其次,系统资源瓶颈的准确识别和处理需要深入的技术支持。再者,随着业务规模的增长,监控系统需要能够扩展并处理大规模的监控数据。本章将深入探讨性能监控的重要性,并分析在实施过程中所遇到的挑战,为后续章节关于Python platform模块的应用和实践打下基础。

## 1.1 监控对业务连续性的支撑

性能监控是确保企业信息系统稳定运行的关键,它能够提前发现潜在的系统故障,并提供维护和优化的依据。通过实施监控,企业可以实时跟踪系统性能指标,如响应时间、吞吐量和资源使用率,从而为业务连续性提供坚实保障。

## 1.2 监控面临的挑战

在性能监控的实施过程中,企业和IT专业人士经常面临以下挑战:

- **跨平台兼容性问题**:不同操作系统和硬件平台的性能监控方法可能截然不同,给统一监控带来难度。

- **大规模数据处理**:随着业务量的增加,监控系统需要处理的性能数据量呈指数级增长,这对数据采集、存储和分析提出了更高要求。

- **资源瓶颈的快速识别与响应**:识别系统中的性能瓶颈并迅速作出响应,要求监控系统具有高效的数据分析和智能告警功能。

随着技术的进步,如云计算、大数据分析和人工智能等技术的应用,性能监控领域也在不断演进,使得性能监控更加智能化和自动化。在接下来的章节中,我们将深入探讨Python platform模块如何在这些挑战面前发挥作用,以及如何通过实践应用来优化系统性能。

# 2. Python platform模块概述

在当前IT行业飞速发展的时代,Python凭借其简洁的语法、强大的库支持和丰富的应用场景,已成为不少开发者首选的编程语言之一。特别是,当我们涉及系统级别的性能监控时,Python提供了诸多内置库以简化开发工作,而`platform`模块就是这样一个功能强大的库。在本章节中,我们将深入探讨`platform`模块的设计目标、应用场景、核心功能,以及如何利用它来进行性能监控,并分析它的优势。

## 2.1 platform模块的设计目标与应用范围

### 2.1.1 设计目标解读

`platform`模块的设计目标是提供一个跨平台的接口,以便开发者可以轻松获取运行Python脚本的系统信息。它旨在抽象出各种操作系统间的差异,从而让开发者无需关心底层的操作系统细节,就可以获取到关于系统的详细信息。这些信息可以是关于操作系统的名称、版本,也可以是计算机硬件的规格,例如CPU类型、内存大小等。

### 2.1.2 应用场景分析

由于`platform`模块提供的系统信息涉及多个层面,它的应用场景十分广泛。例如,自动化脚本需要根据不同的操作系统进行不同的处理,或者需要在某些操作前确认系统资源是否足够。除此之外,性能监控工具经常需要使用`platform`模块来获取系统级信息,以便对系统的健康状况进行实时监控和分析。

## 2.2 platform模块的核心功能

### 2.2.1 系统信息的获取

`platform`模块提供了多种函数用于获取系统信息,其中包括操作系统类型、版本、机器架构、主机名等。这些信息对于性能监控至关重要,因为它们可以帮助开发者或系统管理员了解当前环境的配置,以便做出更合理的优化和调整决策。

```python

import platform

# 获取操作系统名称

os_name = platform.system()

print(f"Operating System: {os_name}")

# 获取操作系统版本

os_version = platform.version()

print(f"Operating System Version: {os_version}")

# 获取硬件架构

machine = platform.machine()

print(f"Machine Type: {machine}")

# 获取完整的主机名

hostname = platform.node()

print(f"Hostname: {hostname}")

```

在上面的代码块中,我们使用了`platform`模块的几个函数来获取系统的关键信息,并将结果输出到控制台。这些信息是性能监控的起点,可以帮助我们确定监控的范围和侧重点。

### 2.2.2 资源监控的实现

除了获取系统信息,`platform`模块还提供了监控系统资源的函数。通过这些函数,我们可以了解当前系统的内存使用情况、处理器的频率和负载等关键性能指标。

```python

# 获取系统物理内存总量

physical_memory = platform.total报酬_memory()

print(f"Total Physical Memory: {physical_memory} bytes")

# 获取系统的处理器频率

processor_frequency = platform.processor()

print(f"Processor Frequency: {processor_frequency} MHz")

# 获取系统的处理器负载

# 注意:此处的loadavg函数返回的是一个元组,其中包含过去1分钟、5分钟和15分钟的平均负载

load_average = platform.loadavg()

print(f"Load Average: {load_average}")

```

在上述代码中,我们获取了系统的物理内存总量、处理器频率和处理器负载。这些数据对于监控系统的实时性能非常有用,可以帮助我们快速识别出潜在的性能瓶颈。

## 2.3 使用platform模块进行性能监控的优势

### 2.3.1 优势一:跨平台兼容性

`platform`模块的一个显著优势就是其强大的跨平台兼容性。无论是Windows、Linux、MacOS还是其他Unix-like系统,`platform`模块都能提供一致的接口来获取系统信息,这对于开发跨平台应用或者监控工具的开发者而言非常重要。

### 2.3.2 优势二:丰富的API支持

除了系统信息的获取,`platform`模块还提供了许多针对不同功能的API。开发者可以利用这些API来完成从获取系统硬件信息到检测网络状态的各种任务。这使得`platform`模块成为性能监控开发中不可或缺的一部分。

通过本章节的介绍,我们对`platform`模块的设计目标、应用范围、核心功能以及其在性能监控中的优势有了初步的了解。在接下来的章节中,我们将进一步深入探讨如何将`platform`模块应用于实际的性能监控实践中,包括如何利用它进行系统瓶颈检测、与外部监控工具的集成、以及性能数据的可视化和报告。

# 3. Python platform模块的实践应用

## 3.1 基于platform模块的系统瓶颈检测

在深入了解了platform模块的基础知识之后,我们便可以开始利用这个模块进行一些实际的性能监控任务。首先,我们将探索如何使用platform模块来检测系统瓶颈。

### 3.1.1 CPU和内存的监控策略

在系统性能监控中,CPU和内存是最常监控的资源。Python的platform模块提供了一系列函数来获取这些资源的使用情况。

```python

import platform

def monitor_cpu_memory():

# 获取CPU逻辑核心数

cpu_count = platform.cpu_count()

print(f"逻辑核心数: {cpu_count}")

# 获取系统内存的详细信息

memory_info = platform.virtual_memory()

print(f"总内存: {memory_info.total / (1024 ** 3):.2f} GB")

print(f"可用内存: {memory_info.available / (1024 ** 3):.2f} GB")

print(f"内存使用率: {memory_info.percent}%")

monitor_cpu_memory()

```

在上述代码中,`platform.cpu_count()` 用于获取CPU的逻辑核心数,而 `platform.virtual_memory()` 则提供了关于系统内存的丰富信息,包括总内存大小、可用内存大小以及内存使用率等。输出这些信息可以帮助我们了解系统资源的当前状况,并为后续的性能优化提供依据。

### 3.1.2 磁盘和网络I/O监控方法

除了CPU和内存之外,磁盘和网络I/O也是重要的性能监控指标。为了获取这些信息,我们可以使用平台模块相关的子模块。

```python

import psutil # psutil是一个跨平台库,用来获取系统运行的进程和系统利用率(包括CPU、内存、磁盘、网络等)

def monitor_disk_network_io():

# 磁盘I/O信息

disk_io = psutil.disk_io_counters()

print(f"读取次数: {disk_io.read_count}, 写入次数: {disk_io.write_count}")

# 网络I/O信息

net_io = ***_io_counters()

print(f"发送字节: {net_io.bytes_sent}, 接收字节: {net_io.bytes_recv}")

monitor_disk_network_io()

```

在这个例子中,我们使用了 `psutil` 库,它是一个功能强大的跨平台库,能够提供更为详细的性能监控数据。通过调用 `psutil.disk_io_counters()` 和 `***_io_counters()`,我们可以获得磁盘和网络的读写次数和发送接收字节等信息,这些都对监控系统性能瓶颈至关重要。

## 3.2 集成外部工具以增强监控功能

platform模块虽然提供了基本的系统信息获取功能,但在实际应用中往往需要与其他工具和框架集成,以实现更为复杂和高效的性能监控。

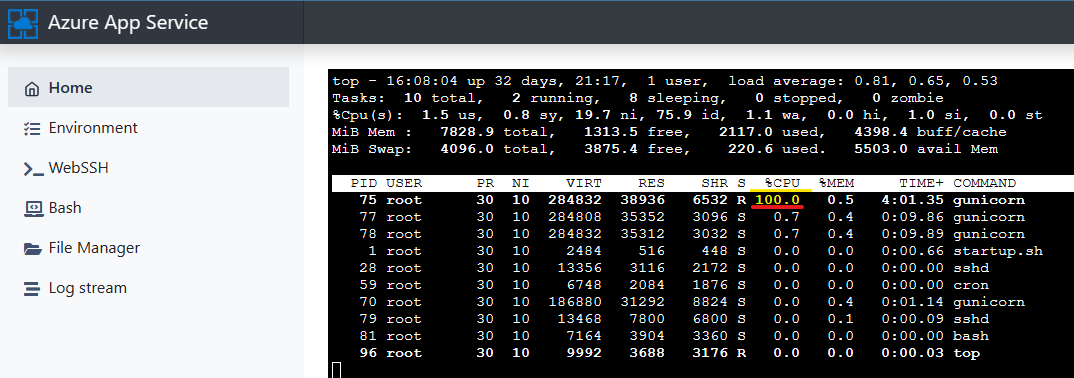

### 3.2.1 集成命令行工具

有些情况下,系统内置的命令行工具可以提供平台模块所没有的信息,或者提供更为详细的数据。例如,`top`、`htop`、`iostat` 等工具在Linux系统中广泛被用来监控系统资源使用情况。

要集成这些工具,可以使用 `subprocess` 模块来运行外部命令并获取输出。

```python

import subprocess

def run_top():

process = subprocess.Popen(['top', '-b', '-n', '1'], stdout=subprocess.PIPE)

output, err = ***municate()

print(output.decode())

run_top()

```

这里,`subprocess.Popen` 创建了一个子进程来运行 `top` 命令,并将输出重定向到标准输出。`-b` 参数表示批处理模式,`-n 1` 表示执行一次后退出,这样我们可以在Python脚本中获取 `top` 命令的一次输出,并通过打印输出来进行进一步的分析。

### 3.2.2 集成监控服务和框架

随着监控需求的提高,集成完整的监控服务和框架变得十分必要。例如,Prometheus是一种广泛使用的监控系统,它提供了强大的数据收集和查询功能。

要将Python应用集成到Prometheus中,我们需要使用它的客户端库,比如 `prometheus_client`,来实现应用数据的暴露。

```python

from prometheus_client import Gauge, start_http_server

def monitor_prometheus():

# 创建一个Gauge指标来记录应用的内存使用量

memory_usage_gauge = Gauge('app_memory_usage', 'App Memory Usage in Bytes')

# 更新指标的值

memory_info = platform.virtual_memory()

memory_usage_gauge.set(memory_info.used)

# 启动Prometheus HTTP服务器

start_http_server(8000)

print("Prometheus HTTP server running on port 8000")

monitor_prometheus()

```

上述代码创建了一个Gauge类型的指标 `app_memory_usage`,用于记录应用内存使用量。然后,我们通过 `platform.virtual_memory()` 获取内存信息,并使用 `set` 方法更新指标值。最后,通过调用 `start_http_server` 函数启动一个HTTP服务器,Prometheus可以定时抓取暴露的指标数据,从而实现对应用性能的持续监控。

## 3.3 性能数据的可视化与报告

在收集性能数据之后,如何有效地展示这些数据也是一门学问。数据可视化可以帮助我们更直观地理解系统状态和性能趋势。

### 3.3.1 数据可视化工具的选择与应用

有多种工具可供选择来进行数据可视化。例如,Matplotlib是一个广泛使用的Python绘图库,它可以帮助我们制作出精美的图表。

```python

import matplotlib.pyplot as plt

def visualize_data(memory_data):

plt.figure(figsize=(10,5))

plt.plot(memory_data, label='Memory Usage')

plt.title('Memory Usage Over Time')

plt.xlabel('Time')

plt.ylabel('Memory Usage (bytes)')

plt.legend()

plt.show()

# 假设我们有一段时间内的内存使用数据

time_points = list(range(1, 11))

memory_data = [i *** for i in time_points] # 示例数据

visualize_data(memory_data)

```

这里,我们模拟了一段时间内内存使用量的数据,并使用Matplotlib绘制了一个内存使用趋势的折线图。通过这张图表,我们能够清晰地看到内存使用随时间的变化趋势。

### 3.3.2 动态报告生成的技巧

报告生成是数据可视化的高级应用。我们可以使用ReportLab库来生成包含图表和数据的动态报告。

```python

from reportlab.pdfgen import canvas

from reportlab.lib.pagesizes import letter

def create_report(data, filename):

c = canvas.Canvas(filename, pagesize=letter)

c.drawString(100, 750, "Memory Usage Report")

for i, mem in enumerate(data):

c.drawString(100, 730 - i*20, f"Time Point {i+1}: {mem} bytes")

c.save()

# 假设我们有一段时间内的内存使用数据

time_points = list(range(1, 11))

memory_data = [i *** for i in time_points] # 示例数据

create_report(memory_data, 'memory_report.pdf')

```

上面的代码片段创建了一个PDF报告,其中包含了内存使用数据的时间点和具体数值。ReportLab允许我们绘制文本、图形和其他复杂结构,非常适合生成复杂的业务报告。

通过这些实用的实践应用,我们可以将Python的platform模块和其他工具结合起来,进行高效的系统瓶颈检测、性能数据的可视化与报告生成,最终帮助我们更深入地理解和解决实际中的性能问题。

# 4. 深入分析平台性能瓶颈

在探讨如何深入分析平台性能瓶颈之前,让我们先建立一个关于系统性能瓶颈的综合理解框架。理解系统资源如何被消耗,以及在哪些条件下会出现瓶颈,对于有效的系统性能管理至关重要。

## 分析系统资源瓶颈的原理

### 瓶颈产生的原因和影响

系统瓶颈通常是指系统中性能最差的环节,当需求超过这个环节的最大处理能力时,就会导致整个系统的性能下降。对于计算机系统而言,常见的瓶颈包括CPU处理能力、内存容量、存储IO速率和网络带宽等。

例如,CPU瓶颈通常发生在中央处理单元(CPU)过于繁忙时,无法及时处理所有到达的计算任务。类似地,内存瓶颈则是由于系统内存不足,导致频繁的磁盘交换操作,显著降低了系统的响应速度。

瓶颈的产生可能是由不合理的系统配置、资源分配不足、或是单点故障等因素造成的。它们对系统产生的影响可能包括服务延迟增加、吞吐量下降、甚至系统崩溃。

### 资源瓶颈的识别方法

为了有效识别系统资源瓶颈,可以采取多种监控与分析手段。这里是一些常用的资源瓶颈识别方法:

1. **性能指标监控**:通过监控关键性能指标,例如CPU使用率、内存消耗、磁盘I/O和网络传输速率,可以直观地看到资源使用情况,及时发现异常高负载。

2. **实时监控工具**:利用如`top`, `htop`, `iostat`, `netstat`等工具,可以实时查看系统资源的使用情况。

3. **系统日志分析**:检查系统日志文件,寻找与性能下降相关的错误或警告信息,这可以帮助定位到特定的瓶颈原因。

4. **压力测试**:通过模拟高负载情况,可以测试出系统在极限状态下的表现,从而揭示潜在的性能瓶颈。

## 使用platform模块解决实际问题

### 实际案例分析

考虑到一个需要监控和优化的Web服务器,我们如何使用`platform`模块来帮助诊断和解决性能瓶颈问题呢?

首先,我们可以编写一个Python脚本,使用`platform`模块来获取系统的关键信息:

```python

import platform

# 获取操作系统相关信息

os_info = platform.platform()

print("操作系统信息:", os_info)

# 获取处理器信息

processor_info = platform.processor()

print("处理器信息:", processor_info)

# 获取系统内存信息

memory_info = platform.machine()

print("内存信息:", memory_info)

```

### 解决方案的设计与实现

一旦我们通过`platform`模块获取了基本的系统信息,接下来需要结合实际监控到的性能数据,设计解决方案。比如,我们发现CPU使用率异常高,这时可以进一步深入分析CPU密集型进程:

```python

import psutil

import platform

# 获取CPU使用率

def get_cpu_usage():

return psutil.cpu_percent(interval=1)

# 获取所有进程信息

def get_processes():

return psutil.process_iter(['pid', 'name', 'cpu_percent'])

# 示例:获取当前CPU使用率

print("当前CPU使用率:", get_cpu_usage())

# 示例:获取所有进程并打印相关信息

for proc in get_processes():

print(***)

```

在这段代码中,`psutil`是一个跨平台库,可以提供系统运行的进程和系统利用率信息。通过与`platform`模块结合使用,我们能够更全面地理解系统的性能状态。

## 性能优化策略与最佳实践

### 优化策略的理论基础

性能优化策略通常包括软硬件升级、资源合理分配、代码优化等。理论基础是理解不同系统资源的限制以及它们之间的相互作用,从而做出明智的优化决策。

一种常见的策略是使用缓存技术,包括数据缓存和文件缓存,来减少对磁盘IO的依赖,这对于缓解存储瓶颈尤为重要。

### 实际操作中的最佳实践

在实际操作中,最佳实践可能包括:

1. **代码层面**:优化算法,减少不必要的资源消耗,如I/O操作,CPU密集型计算等。

2. **资源层面**:合理配置系统资源,如动态分配内存、合理安排进程优先级等。

3. **架构层面**:使用负载均衡,分布式处理等技术,来避免单个节点成为瓶颈。

最后,考虑到各种场景,我们需要将理论与实际相结合,不断调整和改进优化策略。通过持续监控和反馈,我们可以逐步提高系统的整体性能和稳定性。

# 5. 系统监控与性能优化的未来展望

随着技术的快速发展,系统监控和性能优化领域也在不断进化。对未来的展望不仅包括新兴技术的融合,还有针对特定编程语言的工具和实践的发展。以下是关于系统监控与性能优化未来的几个关键点。

## 新兴技术在性能监控领域的应用前景

### 云计算和大数据技术的影响

云计算提供了可扩展的资源,使性能监控能够处理更大规模的数据。云服务提供商通过高级的监控服务,如AWS CloudWatch、Azure Monitor等,提供了实时监控、自动警报和大规模数据分析的功能。这些服务使得企业能够更有效地进行资源分配和容量规划。

大数据技术的发展也为性能监控带来了新的机遇。利用大数据分析,企业能够挖掘出影响系统性能的深层次原因,从大量的监控数据中发现模式和趋势,并据此做出更加准确的决策。

### 人工智能与机器学习在监控中的角色

人工智能(AI)和机器学习(ML)正在改变性能监控的面貌。通过机器学习,监控系统可以自动识别异常行为,预测潜在的系统故障,并推荐优化措施。例如,智能告警系统可以通过学习正常行为模式来减少误报,提高响应效率。

AI还可以在性能瓶颈分析中扮演重要角色。通过对历史数据的学习,AI算法能够识别出影响性能的关键因素,并提出针对性的优化建议。

## Python在性能监控中的未来趋势

### Python社区的发展对监控工具的影响

Python社区以其活跃和开放而闻名,社区成员持续为性能监控领域贡献新的库和工具。随着社区的不断壮大,我们可以预期将有更多高性能、易用的监控工具被开发出来。

例如,基于Python的开源监控解决方案Prometheus已经成为云原生监控的事实标准之一。随着这些解决方案的不断成熟和丰富,Python在性能监控领域的地位将会越来越重要。

### 预期的Python监控库和工具的演变

随着Python 3的普及和性能的提升,我们有理由相信,未来的监控库和工具将更加专注于跨平台的兼容性、高效率的数据处理能力以及更直观的用户界面。

同时,为了满足自动化和智能化的需求,未来的Python监控工具可能会集成更多的AI和ML功能,提供自适应的性能优化建议和更加精确的故障预测。

## 持续学习与适应监控领域的变化

### 学习资源和方法推荐

持续学习是适应技术发展不可或缺的一部分。对于性能监控和优化领域,以下是一些推荐的学习资源和方法:

- 在线课程和教程:例如Coursera、edX和Udemy提供的相关课程。

- 官方文档:阅读Python官方文档以及流行的监控工具文档。

- 书籍:一些经典的书籍如《Python高性能编程》和《Python监控之道》提供了深入的理论和实践指导。

- 社区和论坛:通过Stack Overflow、Reddit和GitHub等平台与行业内的专家交流。

### 适应行业变化的个人与企业策略

为了适应快速变化的监控领域,个人和企业需要采取灵活的策略:

- 对个人而言,保持好奇心和学习的热情,定期更新知识储备,并通过实际项目来实践所学。

- 对企业而言,投资于员工培训,并鼓励团队之间的知识分享。同时,企业应该保持对新技术的敏感性,适时引入新工具和技术。

监控与优化是保障系统稳定性和性能的关键环节。随着技术的不断进步,监控工具和方法也在不断演化。对于IT行业的从业者来说,了解这些趋势,并不断适应和学习新技术,是持续提升自身竞争力的重要途径。

0

0