GraphPad Prism 5数据处理高招:如何预处理数据获得更佳图表

发布时间: 2024-12-20 17:50:49 阅读量: 20 订阅数: 28

# 摘要

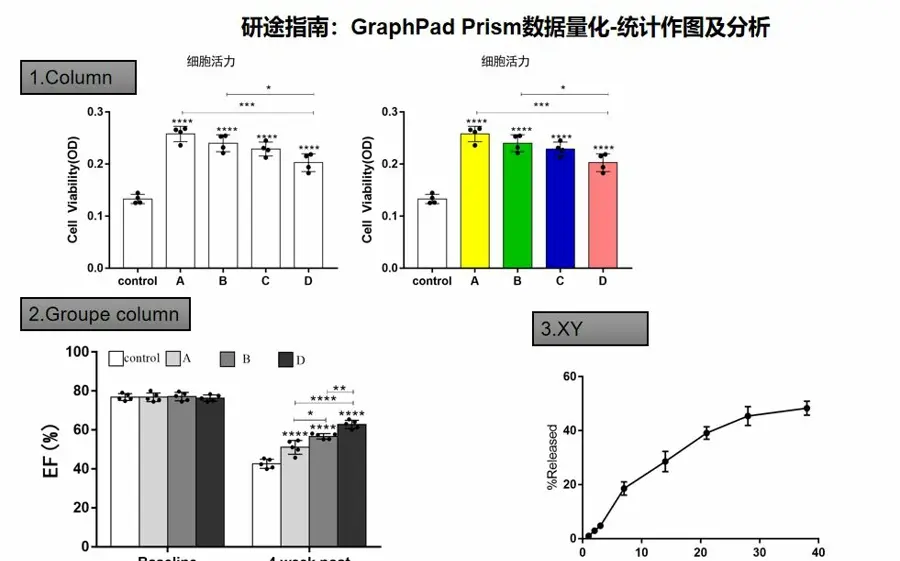

GraphPad Prism 5是一个集数据处理和图表制作于一体的软件工具,被广泛应用于科学研究中。本文首先介绍GraphPad Prism 5的基础知识和数据处理的基本概念,随后详细阐述了数据预处理的理论与方法,包括数据清洗和转换技术,以及数据输入与管理的实践操作。第三章深入探讨了软件中数据预处理的具体实践,包括数据排序、筛选和变换等操作,并通过案例分析展示了预处理在实验数据分析中的应用。第四章则聚焦于预处理数据的可视化展示和在统计分析前的数据转换实例。第五章介绍了高级数据处理功能,包括自动化脚本和宏的应用以及多变量数据集的处理。最后一章展望了GraphPad Prism 5数据处理的进阶案例与技术发展趋势,强调数据科学在该软件中的应用前景。本文旨在为科研人员提供一套完整的GraphPad Prism 5数据处理与图表制作指南。

# 关键字

GraphPad Prism 5;数据处理;数据预处理;数据可视化;统计分析;自动化脚本

参考资源链接:[GraphPad Prism 5作图教程:折线图、柱状图与生存图详解](https://wenku.csdn.net/doc/6s00vqoqwu?spm=1055.2635.3001.10343)

# 1. GraphPad Prism 5简介与数据处理基础

GraphPad Prism 5 是一款广受欢迎的统计和图形绘制软件,其操作简便,界面友好,特别适用于生物医学领域的数据分析和图表绘制。本章将带您初步了解 GraphPad Prism 5 的界面布局和基本功能,同时,我们将探讨数据处理的基础知识,为您提供必要的统计背景知识和数据组织技巧。

## 1.1 GraphPad Prism 5 界面概览

GraphPad Prism 5 的界面设计旨在让数据处理和图形绘制变得直观易懂。软件分为几个主要的区域:

- 数据表(Data Tables):用于输入和管理数据。

- 结果和图表(Results and Charts):展示数据分析和图形输出。

- 菜单栏和工具栏(Menu Bar and Toolbars):提供对软件功能的访问。

- 工作表(Sheets):用于组织不同类型的数据和分析。

用户通过这些界面组件,可以轻松地进行数据输入、分析和图形编辑,实现高效的数据处理。

## 1.2 数据处理基础

数据处理是任何数据分析项目的核心部分。了解数据处理的基础对于利用GraphPad Prism 5 进行科学研究具有重要意义。

- **数据集的结构与类型**:根据研究目的的不同,数据集可以被划分为定量数据和定性数据,以及实验组和对照组等不同类别。

- **数据的度量尺度**:理解区间尺度、比例尺度、序数尺度和名义尺度对于正确选择统计测试和图形类型至关重要。

- **数据整理与组织**:数据的整洁和组织程度直接影响到后续分析的准确性和效率。GraphPad Prism 5 提供了多样的数据整理和管理工具,帮助用户有效地组织数据。

通过掌握这些基础知识,您将能够更加自信地进行数据输入、处理和分析,并在GraphPad Prism 5 中绘制出高质量的图形。

# 2. 数据预处理的理论与方法

### 2.1 数据预处理的重要性

数据预处理是数据分析过程中至关重要的一环,它涉及到数据的质量、完整性、可用性等方面,直接影响到后续分析结果的准确性和可靠性。在进行数据挖掘、统计分析或机器学习任务之前,对原始数据进行预处理是不可或缺的步骤。

#### 2.1.1 数据质量对分析结果的影响

数据质量包括数据的准确性、一致性、完整性和时效性。质量差的数据会导致分析结果出现偏差,甚至产生误导性的结论。例如,在机器学习模型中,如果数据存在大量的噪声或异常值,模型可能会学到这些噪声特征,导致泛化能力差。

#### 2.1.2 数据预处理的目标和原则

数据预处理的目标是将原始数据转化为适合分析的形式,确保数据质量符合分析要求。原则包括但不限于确保数据的一致性、消除冗余、处理缺失值、识别并处理异常值,以及数据的标准化和归一化。

### 2.2 数据清洗技术

数据清洗的目的是移除数据集中的不一致性、噪声和不相关数据,提高数据质量。以下是几种常见的数据清洗技术。

#### 2.2.1 缺失值的处理策略

缺失值是数据分析中常见的问题。处理缺失值的策略包括删除含有缺失值的记录、填充缺失值、或者使用特定的算法预测缺失值。删除记录可能会损失大量数据,因此多数情况下会采用填充或预测方法。

```python

import pandas as pd

from sklearn.impute import SimpleImputer

# 假设df是含有缺失值的DataFrame

imputer = SimpleImputer(strategy='mean') # 使用均值填充缺失值

df['column_name'] = imputer.fit_transform(df[['column_name']])

```

#### 2.2.2 异常值的识别与处理

异常值可能是噪声也可能是有用的信号。首先需要对异常值进行识别,常用的识别方法包括箱型图、Z分数等。处理异常值的方法有删除、修正、或者使用鲁棒统计技术。

#### 2.2.3 数据的标准化与归一化

标准化(Standardization)和归一化(Normalization)是数据预处理中常用的技术,用于将数据缩放到特定范围。标准化使数据符合标准正态分布,而归一化则是将数据缩放到[0, 1]区间。

```python

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 数据标准化示例

scaler = StandardScaler()

df['standardized_column'] = scaler.fit_transform(df[['column_to_standardize']])

# 数据归一化示例

scaler = MinMaxScaler(feature_range=(0, 1))

df['normalized_column'] = scaler.fit_transform(df[['column_to_normalize']])

```

### 2.3 数据转换技术

数据转换技术是通过数学变换将数据转换成更有意义的形式。这里介绍几种常见的数据转换方法。

#### 2.3.1 数据变换的目的与方法

数据变换的目的是使数据更接近正态分布,增强数据的线性特征,或者减少变量间的依赖关系。常见的变换包括对数变换、平方根变换和Box-Cox变换。

#### 2.3.2 对数变换、幂次变换的应用

对数变换适用于减少数据的偏斜度,通常用于具有偏斜分布的数据。幂次变换可以调整数据的分布形态,使分布更接近正态分布。

```python

import numpy as np

# 对数变换示例

df['log_transformed'] = np.log(df['variable_to_transform'] + 1)

# 幂次变换示例

df['power_transformed'] = df['variable_to_transform'] ** transformation_power

```

#### 2.3.3 离散变量到连续变量的转换

在某些情况下,将离散变量转换为连续变量可以增加数据的表达力,使分析更加灵活。例如,使用独热编码(One-hot Encoding)或标签编码(Label Encoding)。

```python

from sklearn.preprocessing import OneHotEncoder

# 独热编码示例

encoder = OneHotEncoder()

encoded_features = encoder.fit_transform(df[['categorical_column']]).toarray()

```

数据预处理的每一步都是为了提高数据的可用性和分析结果的可靠性,为后续的数据分析工作打下坚实的基础。接下来的章节,我们将探讨如何在GraphPad Prism 5中应用这些理论和技术。

# 3. GraphPad Prism 5中的数据预处理实践

## 3.1 数据输入与管理

### 3.1.1 输入数据的基本步骤

GraphPad Prism 5 提供了一个用户友好的界面来输入数据。其过程通常涉及以下几个基本步骤:

1. 打开 GraphPad Prism 并创建一个新的数据表。

2. 根据需要选择数据表的布局,如单变量、双变量、列表、X-Y等。

3. 通过“数据”菜单输入数据。可以直接在数据表中输入数据,也可以从其他应用程序复制粘贴数据。

4. 如果需要,可以为数据集添加标签,以便于管理。

5. 输入完毕后,可以保存项目,以便之后的数据分析和图表制作。

### 3.1.2 数据集的管理技巧

随着数据量的增加,有效的数据集管理变得至关重要。以下是一些管理技巧:

- 使用项目(Project

0

0