字符串处理的秘密武器:stringr进阶指南,让你成为R语言文本分析大师

发布时间: 2024-11-02 23:13:43 阅读量: 41 订阅数: 26

字符串比较与处理:给定两个字符串 s 和 t 的实用指南.zip

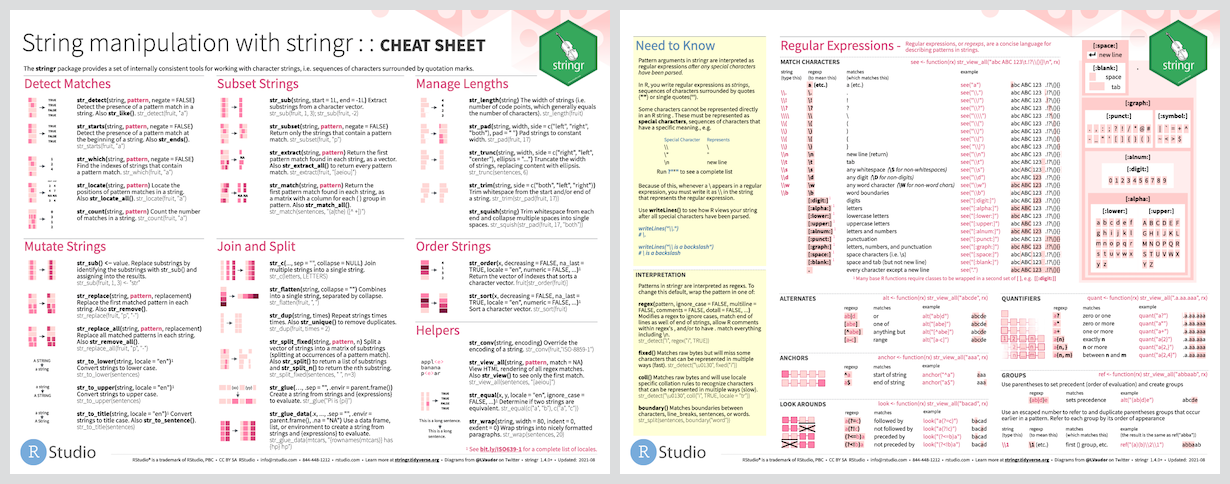

# 1. stringr包概述与基础应用

在数据分析和文本处理的过程中,经常需要对字符串进行操作。R语言中的`stringr`包是一个功能强大、易于使用的字符串处理工具集合,它提供了一系列简洁的函数来简化字符串的操作。本章将对`stringr`包进行概述,并介绍如何使用它来执行基础字符串操作。

## 1.1 stringr包简介

`stringr`是R语言中`tidyverse`生态系统的一部分,主要用于字符串操作,它的设计灵感来源于`stringi`包,但更注重一致性和简洁性。`stringr`包提供了一系列前缀为`str_`的函数,便于记忆且易于使用。

## 1.2 安装与加载stringr包

在使用`stringr`之前,需要先安装该包,然后在R脚本中加载。可以通过以下命令完成安装和加载操作:

```r

install.packages("stringr")

library(stringr)

```

## 1.3 基础应用示例

以下是一个使用`stringr`包进行基础字符串操作的简单示例。我们将创建一个字符串向量,并使用`stringr`中的函数来提取和处理数据。

```r

# 创建一个字符串向量

fruit <- c("apple", "banana", "orange", "grape")

# 使用str_length()获取字符串长度

lengths <- str_length(fruit)

# 使用str_detect()检测字符串是否包含特定字符

contains_a <- str_detect(fruit, "a")

# 使用str_replace()替换字符串中特定模式

replaced <- str_replace(fruit, "a", "z")

# 输出结果

lengths

contains_a

replaced

```

通过上述示例,我们可以看到`stringr`包能够以简单直观的方式完成字符串的长度计算、模式匹配和替换等操作。这些基础应用是`stringr`包中最常用的函数,为后续更复杂的应用打下了坚实的基础。

在后续章节中,我们将深入探讨`stringr`包中更高级的字符串操作技巧,如字符匹配、字符串合并与分割、文本替换与重排等。通过学习,你将能够高效地解决实际工作中的文本处理问题。

# 2. 深入理解stringr的字符串操作

字符串操作是数据处理和文本分析中的基础而核心的部分。stringr包作为R语言中处理字符串的强大工具,提供了简洁而强大的函数来处理字符串。本章将深入探讨stringr包中字符串操作的各种功能和用法,旨在帮助读者更加高效地进行文本处理。

## 2.1 stringr中的字符匹配功能

字符匹配是字符串操作中最常见的任务之一。stringr中包含多种函数,它们可以帮助用户实现精确匹配和近似匹配,以及构建和应用正则表达式。我们分两部分来看这些功能如何应用。

### 2.1.1 精确匹配和近似匹配

精确匹配是最简单的匹配形式,通常用于查找和提取与特定模式完全一致的字符串片段。stringr包中的`str_detect`、`str_subset`等函数提供了这样的功能。

```r

library(stringr)

# 检测字符串中是否包含特定模式

str_detect("hello world", "world") # 返回 TRUE

```

代码说明:`str_detect`函数检查向量中的字符串是否包含指定的模式(这里是"world")。此例中,返回了逻辑向量TRUE,表明"hello world"中确实包含"world"。

相比之下,近似匹配则涉及到模糊匹配,使用正则表达式中的特殊字符来定义匹配模式。例如,`.`代表任意单个字符,`*`代表零个或多个前面的字符。stringr中的`str_detect`同样可以用于执行近似匹配。

```r

# 使用正则表达式进行近似匹配

str_detect("example", "ex.*") # 返回 TRUE,.*表示任意字符出现任意次

```

### 2.1.2 正则表达式的构建与应用

正则表达式是字符串处理的灵魂,stringr提供了众多函数支持正则表达式的使用。构建复杂的正则表达式并应用这些模式于字符串匹配、提取、替换等操作是stringr强大功能的体现。

```r

# 构建并应用复杂的正则表达式

str_extract_all("The rain in SPAIN stays mainly in the plain.", "\\b[a-zA-Z]+\\b")

# 返回向量中包含所有单词

```

在这个示例中,使用了正则表达式`\\b[a-zA-Z]+\\b`来匹配字符串中的所有单词。`\\b`表示单词边界,`[a-zA-Z]+`表示一个或多个英文字母。

## 2.2 stringr的字符串合并与分割

字符串的合并与分割是日常文本处理中的常见任务,stringr提供了便捷的函数来实现这些操作。

### 2.2.1 字符串的连接操作

字符串的连接通常指的是将多个字符串片段合并成一个单一的字符串。在stringr中,`str_c`函数提供了高效的字符串合并功能。

```r

# 连接字符串片段

str_c("Hello", "World") # 返回 "HelloWorld"

str_c("Hello", "World", sep = " ") # 返回 "Hello World"

```

代码说明:`str_c`默认无分隔符地连接字符串片段,通过`sep`参数可以自定义分隔符。

### 2.2.2 使用正则表达式分割字符串

分割字符串是通过指定一个或多个分隔符将字符串拆分成子字符串的过程。`str_split`函数允许使用正则表达式作为分隔符,提供灵活的分割选项。

```r

# 使用正则表达式分割字符串

str_split("one,two,three", ",") # 按逗号分割

str_split("one-two-three", "-") # 按连字符分割

```

## 2.3 stringr中的文本替换与重排

文本替换和重排是文本处理中的高级技巧,它们可以用于纠正文本中的错误、格式化文本以及整理数据。

### 2.3.1 替换字符串中的模式

替换字符串中的模式是文本编辑中常见的需求,`str_replace`和`str_replace_all`函数在stringr中专门用于此任务。

```r

# 替换字符串中的模式

text <- "The rain in SPAIN stays mainly in the plain."

str_replace_all(text, "SPAIN", "SPAIN") # 将"SPAIN"替换为"SPAIN"

```

### 2.3.2 字符串的排序和重排技巧

字符串排序和重排通常用于整理数据或改善文本的可读性。stringr提供了`str_order`和`str_sort`函数来实现这一目标。

```r

# 字符串排序

str_sort(c("b", "a", "c")) # 返回 "a", "b", "c"

```

代码说明:`str_sort`函数默认按照字典顺序对字符串进行排序,支持自定义排序规则。

在本章中,我们详细探讨了stringr包提供的字符串匹配、合并与分割、替换与重排等操作,同时介绍了其基础用法。字符串操作的熟练掌握对于数据清洗、文本分析以及日常的数据处理工作至关重要。在下一章中,我们将探索stringr在数据清洗中的高级用法,并了解它如何与dplyr包整合使用,进一步提升数据处理的效率和质量。

# 3. stringr在数据清洗中的高级用法

数据清洗是任何数据分析工作的基础阶段,它确保了数据质量,有助于后续分析的准确性和有效性。`stringr` 包在数据清洗中扮演了重要的角色,它提供了一系列用于处理字符串数据的函数,可以帮助我们快速识别和修正数据中的不一致性、格式问题以及不完整性。本章将深入探讨`stringr`在数据清洗中的高级用法。

## 3.1 处理缺失值与异常值

数据集中常常会存在缺失值或异常值,这些值如果不加处理,会对分析结果产生负面影响。在本节中,我们将学习如何使用`stringr`包识别和处理这些值。

### 3.1.1 识别和替换缺失值

在R中,缺失值通常被表示为`NA`。我们可以使用`stringr`包中的函数来检测和替换这些缺失值。这里使用`str_detect`函数来识别含有缺失值的字符串:

```r

library(stringr)

library(dplyr)

# 假设我们有一个数据框df,其中包含字符串数据

df <- tibble(text = c("This is a complete sentence.", NA, "This has NAs"))

# 使用str_detect识别含NA的行

na_rows <- df %>%

filter(str_detect(text, "NA"))

# 接下来我们可以选择替换这些NA值或进行其他处理

df <- df %>%

mutate(text = ifelse(is.na(text), "Missing", text))

```

在上述代码中,我们首先检测了数据框`df`中哪些行含有字符串"NA"(这里假定我们的数据中"NA"代表缺失值),然后使用`mutate`函数结合`ifelse`语句将这些行的缺失值替换为"Missing"字符串。

### 3.1.2 检测和处理异常值

异常值可能是数据录入错误或不符合预期的数据点。通过`stringr`我们可以用正则表达式来检测异常模式,并据此进行处理:

```r

# 检测文本中包含非标准字符的异常值

异常检测 <- df %>%

filter(str_detect(text, "[^a-zA-Z0-9 ]+"))

# 替换异常值

df <- df %>%

mutate(text = str_replace_all(text, "[^a-zA-Z0-9 ]+", ""))

```

在上述代码中,`str_detect`函数的正则表达式`[^a-zA-Z0-9 ]+`用来匹配任何非字母数字和非空格的字符。这些被认为是异常值,随后我们用`str_replace_all`函数将这些异常字符替换为空字符串。

## 3.2 数据类型转换和标准化

数据清洗的另一个关键步骤是数据类型的转换和标准化,以确保数据的一致性和准确性。

### 3.2.1 转换字符串到其他数据类型

将字符串转换为其他数据类型在数据分析中是必要的。例如,将日期字符串转换为`Date`类型:

```r

# 假设我们有日期字符串

date_strings <- c("2023-01-01", "2023-01-15", "yesterday")

# 将字符串转换为Date类型

df <- tibble(dates = date_strings)

df <- df %>%

mutate(dates = dplyr::case_when(

str_detect(dates, "\\d{4}-\\d{2}-\\d{2}") ~ as.Date(dates),

TRUE ~ as.Date(Sys.Date() - 1:3)

))

# 查看转换后的结果

print(df)

```

这段代码中,我们首先识别日期字符串的格式,然后使用`dplyr::case_when`与`str_detect`结合将格式正确的日期字符串转换为`Date`对象,而对于非标准格式的日期,则使用系统日期作为基准进行推算。

### 3.2.2 标准化文本格式

文本数据的标准化有助于减少数据的复杂性和歧义。这可能包括大写转换、缩写展开等:

```r

# 标准化文本:统一为小写

df <- df %>%

mutate(text_lower = str_to_lower(text))

# 展开缩写词

df <- df %>%

mutate(text_expanded = str_replace_all(text_lower, "u.s.", "united states"))

```

这段代码演示了如何使用`str_to_lower`函数将文本转换为小写,并使用`str_replace_all`函数来展开缩写词。

## 3.3 stringr与dplyr的整合使用

在数据清洗过程中,`stringr`经常与`dplyr`整合使用,以创建流畅的数据处理管道。这种整合使用可以极大地提升数据分析的效率和可读性。

### 3.3.1 与dplyr结合进行数据处理

`dplyr`是R语言中强大的数据操作工具,当`stringr`与之结合时,可以执行复杂的字符串操作,并保持数据处理的整洁:

```r

# 使用dplyr管道操作进行数据清洗

df <- df %>%

filter(!is.na(text)) %>%

mutate(text = str_replace_all(text, "\\W+", " ")) %>%

mutate(text = trimws(text))

```

在这段代码中,我们首先使用`filter`移除含有NA的行,然后使用`mutate`和`str_replace_all`移除字符串中的非单词字符,并使用`trimws`去除字符串两端的空格。

### 3.3.2 在管道操作中的应用实例

为了进一步展示`stringr`与`dplyr`的整合使用,这里给出一个处理字符串长度的实例:

```r

# 计算并替换过短或过长的字符串

df <- df %>%

mutate(length = str_length(text),

text = case_when(

length < 10 ~ paste0(text, " (too short)"),

length > 50 ~ paste0(substr(text, 1, 50), "... (too long)"),

TRUE ~ text

))

```

在这段代码中,我们使用`str_length`函数来计算字符串长度,并用`mutate`创建一个新列`length`。然后,使用`case_when`根据字符串长度决定是否进行处理。对于过短的字符串,我们在其后添加"(too short)",对于过长的字符串,我们截取其前50个字符并在末尾添加省略号。

## 实际数据案例

为了更深入理解如何应用`stringr`于数据清洗,接下来,我们将以一个具体的数据清洗案例来说明。

### 示例数据集

假设我们有一组来自社交媒体的用户评论数据,该数据集中包含了用户ID、评论文本以及评论日期等信息。我们希望对这些数据进行清洗,以便于后续的分析工作。

首先,创建一个示例数据框:

```r

# 创建示例数据框

comments <- tibble(

user_id = c("user_1", "user_2", "user_3", NA),

comment = c("I love this product!",

"This product is okay, but not great.",

"I am disappointed with the quality of this item.",

"great product!"),

comment_date = c(Sys.Date() - 1, Sys.Date(), Sys.Date(), NA)

)

# 显示示例数据框

print(comments)

```

### 数据清洗步骤

1. **处理缺失值**:

我们可以使用之前介绍的方法来检测和替换数据框中的NA值。

2. **标准化文本**:

- 将所有评论文本转换为小写,以便于比较和处理。

- 移除评论文本中的所有标点符号。

3. **日期格式转换**:

- 将评论日期字符串转换为日期格式。

4. **创建新变量**:

- 基于评论文本的长度,创建一个表示评论长度是否适当的二元变量。

```r

# 应用stringr和dplyr进行数据清洗

clean_comments <- comments %>%

filter(!is.na(user_id), !is.na(comment), !is.na(comment_date)) %>%

mutate(comment_lower = str_to_lower(comment),

comment_punct = str_replace_all(comment_lower, "\\W+", " "),

comment_length = str_length(comment_punct),

comment_date = as.Date(comment_date),

comment_length_appropriate = ifelse(comment_length > 10 & comment_length < 100, TRUE, FALSE)) %>%

select(user_id, comment = comment_punct, comment_date, comment_length, comment_length_appropriate)

# 显示清洗后的数据框

print(clean_comments)

```

在这个示例中,我们首先使用`filter`函数排除任何包含NA值的行。然后,我们继续使用`mutate`函数应用`str_to_lower`来转换文本为小写,`str_replace_all`来移除标点符号,并创建了两个新变量:`comment_length`表示文本长度,`comment_length_appropriate`表示文本长度是否在合理范围内。最后,我们通过`select`函数选择我们需要的列。

这个案例说明了`stringr`在数据清洗中的强大能力,尤其在处理文本数据方面。通过组合使用不同的`stringr`函数,我们能够创建一个干净且准备就绪的数据集,进而可以用于各种分析任务。

# 4. stringr在文本分析中的进阶应用

在文本分析的领域中,`stringr` 包提供了一系列强大的工具,以实现从基本文本处理到复杂的文本挖掘功能。在本章节中,我们将深入探讨 `stringr` 在文本分析中的高级用法,包括正则表达式的高级技巧、字符串的统计与摘要,以及自然语言处理的相关操作。

## 4.1 正则表达式在文本分析中的威力

正则表达式是文本分析的核心,它允许我们定义复杂的文本模式,用于匹配、提取和替换字符串中的特定信息。在这一小节中,我们将深入探讨如何利用正则表达式进行有效的文本分析。

### 4.1.1 构建复杂的文本模式

正则表达式可以匹配简单字符,也可以配合多种特殊字符和符号构建复杂模式,这些模式可以用于从文本中提取有用信息。

```r

# 代码示例:使用正则表达式匹配电子邮件地址

library(stringr)

text <- "*** for further details."

email_pattern <- "([a-zA-Z0-9._-]+@[a-zA-Z0-9._-]+\.[a-zA-Z]{2,})"

emails <- str_extract_all(text, email_pattern)

emails <- unlist(emails)

print(emails)

```

该代码通过构建正则表达式 `([a-zA-Z0-9._-]+@[a-zA-Z0-9._-]+\.[a-zA-Z]{2,})` 来匹配电子邮件地址。注意,这里使用了圆括号来创建一个捕获组,这样匹配的结果就可以被 `str_extract_all` 函数提取出来。

### 4.1.2 正则表达式的分组与引用技巧

在正则表达式中,分组功能不仅可以用来提取子字符串,还可以通过引用进行复杂的文本替换。

```r

# 代码示例:使用分组和后向引用替换字符串中的日期格式

text <- "The meeting is on 2023-03-14 and 2023/03/15."

pattern <- "(\\d{4})[-/](\\d{2})[-/](\\d{2})"

replacement <- "\\2-\\1-\\3"

new_text <- str_replace_all(text, pattern, replacement)

print(new_text)

```

此段代码演示了如何使用正则表达式的分组 `(\\d{4})[-/](\\d{2})[-/](\\d{2})` 和后向引用 `\\2-\\1-\\3` 来格式化文本中的日期。圆括号定义了三个捕获组,它们在替换字符串中通过反斜杠和数字进行引用。

## 4.2 stringr的字符串统计与摘要

在文本分析中,获取字符串的统计信息和摘要对于理解文本内容至关重要。`stringr` 提供了简单直接的方法来进行这些操作。

### 4.2.1 字符串长度与频率分析

字符串长度对于理解文本结构和内容量非常关键。`str_length` 函数可以返回字符串中字符的数量。频率分析可以使用 `str_count` 函数来统计特定模式在字符串中出现的次数。

```r

# 代码示例:分析字符串长度和字符出现频率

text <- "Frequency analysis is a powerful technique in text analysis."

length <- str_length(text)

count_a <- str_count(text, "a")

count_space <- str_count(text, " ")

print(paste("The length of the text is:", length))

print(paste("The letter 'a' occurs", count_a, "times"))

print(paste("Spaces occur", count_space, "times"))

```

在上述代码中,我们首先计算了给定文本的长度,然后统计了字母 "a" 和空格 " " 的出现频率。这为理解文本的基本特征提供了基础。

### 4.2.2 文本摘要的生成方法

文本摘要的生成通常是通过提取关键词或短语来概括文本内容。`stringr` 可以与 `tm` 包一起用来生成简单的文本摘要。

```r

# 代码示例:生成文本摘要

library(tm)

text <- "This is a sample text for generating a text summary."

corpus <- Corpus(VectorSource(text))

dtm <- DocumentTermMatrix(corpus)

findFreqTerms(dtm, lowfreq = 1)

```

这段代码展示了如何使用 `tm` 包结合 `stringr` 来创建文本摘要。首先,创建一个语料库和文档-术语矩阵,然后使用 `findFreqTerms` 函数找出出现频率超过最低阈值的术语。

## 4.3 利用stringr进行自然语言处理

自然语言处理(NLP)是使计算机能够理解和解释人类语言的一种技术。`stringr` 提供了一些基本工具,能够辅助进行一些NLP任务,例如分词、词频统计、词性标注等。

### 4.3.1 分词与词频统计

分词是将文本拆分为单独的词语单元,而词频统计则是统计这些词语单元在文本中出现的次数。

```r

# 代码示例:对文本进行分词并统计词频

text <- "Natural language processing is a field of artificial intelligence"

words <- str_split(text, boundary("word"))

word_freq <- table(unlist(words))

print(word_freq)

```

在这段代码中,我们使用 `str_split` 函数以单词边界作为分隔符对文本进行分词,然后使用 `table` 函数计算每个单词的出现频率。

### 4.3.2 词性标注与命名实体识别

词性标注是指识别文本中每个单词的语法角色(名词、动词等),而命名实体识别(NER)是识别文本中的专有名词或重要实体(人名、地点、组织等)。

```r

# 代码示例:使用stringr进行词性标注和命名实体识别

library(openNLP)

text <- "Steve Jobs was a co-founder of Apple Inc."

model <- Maxent_POS_Token_Annotator()

# 分词和词性标注

word_annotator <- Maxent_Word_Token_Annotator()

a1 <- annotate(text, list(word_annotator, model))

pos_tags <- sapply(a1$features, function(x) x[[1]])

print(pos_tags)

# 命名实体识别

ner_model <- Maxent_NE_Token_Annotator()

a2 <- annotate(text, ner_model)

ner_tags <- sapply(a2$features, function(x) x[[1]])

print(ner_tags)

```

在该代码示例中,我们使用了 `openNLP` 包中的模型来进行词性标注和命名实体识别。虽然这超出了 `stringr` 的直接功能范围,但是 `stringr` 可以帮助准备和处理用于这些NLP任务的文本数据。

总结而言,`stringr` 的高级文本分析功能为处理和理解文本数据提供了强大的支持。从复杂的正则表达式匹配到生成文本摘要,再到辅助进行NLP任务,`stringr` 成为文本分析项目中不可或缺的工具。

# 5. stringr的性能优化与问题解决

## 5.1 stringr的性能评估与提升

### 5.1.1 分析stringr操作的性能瓶颈

在处理大量文本数据时,性能瓶颈是不可避免的。stringr作为一个强大的字符串处理库,其性能主要受以下几个因素影响:

- **字符串的长度**:操作长字符串比短字符串要慢。

- **复杂度**:正则表达式的复杂度直接影响匹配和替换的效率。

- **数据集的大小**:数据集越大,处理起来通常越耗时。

- **函数的选择**:某些stringr函数比其他的更高效。

为了找出stringr操作中的性能瓶颈,可以使用R语言的`microbenchmark`包。例如,比较`str_detect`和`grepl`函数在不同数据集大小下的性能:

```R

library(microbenchmark)

library(stringr)

# 创建一个简单的测试数据集

test_strings <- rep("This is a string", 1000)

# 测试str_detect和grepl的性能

benchmark_results <- microbenchmark(

str_detect = str_detect(test_strings, "string"),

grepl = grepl("string", test_strings),

times = 100

)

print(benchmark_results)

```

### 5.1.2 提升stringr处理效率的策略

在识别了性能瓶颈后,可以采取以下策略来提升stringr的处理效率:

- **预先编译正则表达式**:使用`regex`函数预编译正则表达式,避免在每次操作时重复编译。

```R

compiled_pattern <- regex(pattern = "pattern", TRUE)

result <- str_detect(strings, compiled_pattern)

```

- **使用更高效的数据结构**:例如,在可能的情况下使用`vectors`代替`data frames`。

- **并行处理**:对于大型数据集,可以使用`furrr`或`foreach`等包来并行处理字符串操作。

- **避免复杂正则表达式**:简化复杂的正则表达式可以显著提高执行速度。

## 5.2 常见错误的诊断与解决

### 5.2.1 辨识并解决常见的stringr错误

在使用stringr进行数据处理时,常见的错误主要包括:

- **错误的正则表达式**:正则表达式语法错误,导致`str_detect`等函数返回非预期结果。

- **数据类型不匹配**:尝试对非字符串类型的数据使用stringr函数。

- **参数设置错误**:如`ignore_case`设置为`TRUE`时,必须确保使用的正则表达式正确处理大小写问题。

诊断这些错误可以通过阅读错误信息和检查函数参数来实现。使用`str()`函数检查数据类型,确保数据是字符型。

### 5.2.2 调试技巧与最佳实践

当遇到stringr操作的问题时,以下是一些调试技巧和最佳实践:

- **使用`str_view`和`str_view_all`函数**:在调试正则表达式时,这些函数可以帮助查看具体匹配的情况。

```R

# 查看匹配的字符串部分

str_view("I like programming in R", "R$")

```

- **检查数据集**:确保处理的数据集没有异常值或缺失值。

- **读取官方文档和社区讨论**:有时候问题可能已经有人遇到并解答。

- **编写测试用例**:在函数和脚本开发过程中,使用测试用例可以提前发现潜在的问题。

通过采用上述策略和实践,可以有效地诊断和解决stringr在使用过程中遇到的性能和错误问题,进一步优化数据处理流程。在下一章节,我们将深入了解stringr在实际案例中的应用,通过实战演练来巩固和提升我们的字符串处理能力。

# 6. stringr案例研究与实战演练

在前几章中,我们已经探讨了stringr包的基础知识、高级用法、在数据清洗和文本分析中的应用以及性能优化。本章将深入实际案例,让读者通过实战演练来巩固和扩展对stringr的理解。

## 6.1 从头开始构建文本分析项目

### 6.1.1 项目设置与数据导入

在开始任何项目之前,建立一个清晰的项目设置是至关重要的。这包括确定项目范围、收集相关数据以及导入数据到R环境中。

假设我们要分析社交媒体上的用户评论,以了解公众对特定产品的情感倾向。首先,我们需要使用`readr`包导入数据集:

```R

library(readr)

library(stringr)

# 假设数据文件为 CSV 格式

data <- read_csv("path_to_your_data.csv")

```

### 6.1.2 文本预处理与特征提取

导入数据后,下一步是进行文本预处理,这是文本分析的核心步骤。预处理包括去除标点符号、转换为小写、去除停用词等。

```R

# 定义一个简单的文本预处理函数

preprocess_text <- function(text) {

text %>%

str_replace_all("[[:punct:]]", "") %>%

str_to_lower() %>%

str_replace_all("\\bthe\\b", "") %>% # 移除停用词 "the"

# 可以继续添加其他预处理步骤...

}

# 应用预处理函数到数据集中的文本字段

data$cleaned_text <- preprocess_text(data$text_column)

# 查看处理后的文本

head(data$cleaned_text)

```

通过上述步骤,我们已经将原始文本数据转换成了更适合分析的格式。下一步,我们将提取文本特征,为建立情感分析模型做准备。

## 6.2 分析实战:社交媒体文本情感分析

### 6.2.1 构建情感分析模型

情感分析是理解文本情感倾向的过程,这通常需要一个训练好的模型。我们将使用`tidytext`包来构建一个基础的情感分析模型。

```R

library(tidytext)

# 加载情感字典

afinn <- get_sentiments("afinn")

# 将预处理后的文本分割为单个词汇

data$words <- data$cleaned_text %>%

str_split(" ") %>%

unlist()

# 使用情感字典打分

data$sentiment_score <- data$words %>%

inner_join(afinn, by = "word") %>%

summarise(total_score = sum(value)) %>%

pull(total_score)

```

### 6.2.2 使用stringr进行模型评估

模型建立后,我们需要对其进行评估,以便了解其性能。stringr可以帮助我们处理和分析模型的输出结果。

```R

# 假设data$sentiment_score包含了每个评论的情感得分,我们可以使用stringr来处理这个结果

data$predicted_sentiment <- case_when(

data$sentiment_score >= 1 ~ "positive",

data$sentiment_score <= -1 ~ "negative",

TRUE ~ "neutral"

)

# 使用stringr来统计情感倾向的分布

sentiment_distribution <- data$predicted_sentiment %>%

str_c(collapse = ",") %>%

str_split(",") %>%

table() %>%

as.data.frame()

# 输出情感分布的表格

sentiment_distribution

```

通过上述步骤,我们不仅构建了一个简单的情感分析模型,而且使用stringr对模型的预测结果进行了评估和分析。

## 6.3 stringr在数据可视化中的应用

### 6.3.1 创建文本相关的可视化图表

在文本分析项目中,数据可视化是传达分析结果的关键环节。stringr可以用来生成供可视化的标签或其他文本元素。

```R

library(ggplot2)

# 创建一个情感分布的条形图

ggplot(sentiment_distribution, aes(x = Var1, y = Freq, fill = Var1)) +

geom_col() +

labs(title = "Sentiment Distribution in Social Media Comments",

x = "Sentiment", y = "Count")

```

### 6.3.2 结合ggplot2进行高级可视化

为了进一步增强可视化效果,我们可以结合ggplot2包,使用stringr来增强图表中的文本元素。

```R

# 使用stringr调整x轴文本旋转角度

ggplot(sentiment_distribution, aes(x = Var1, y = Freq, fill = Var1)) +

geom_col() +

theme(axis.text.x = element_text(angle = 45, hjust = 1)) + # 将x轴文本旋转45度

labs(title = "Sentiment Distribution in Social Media Comments",

x = "Sentiment", y = "Count")

```

以上步骤展示了如何将stringr与ggplot2结合,创建出更加美观且信息丰富的可视化图表。

通过以上案例,读者应当对如何运用stringr包进行实战演练有了更加深入的了解。在实际应用中,还应考虑数据规模、预处理步骤的复杂性以及模型的选择,这些都是决定项目成功与否的关键因素。

0

0