MySQL数据库事务处理详解:ACID特性与隔离级别,保障数据一致性

发布时间: 2024-07-16 23:08:51 阅读量: 30 订阅数: 40

# 1. MySQL事务基础**

事务是数据库系统中的一组操作,要么全部执行成功,要么全部回滚失败。事务保证了数据的完整性和一致性,是数据库系统中至关重要的概念。

MySQL事务具有以下特性:

- **原子性(Atomicity):**事务中的所有操作要么全部执行成功,要么全部回滚失败,不存在中间状态。

- **一致性(Consistency):**事务执行前后,数据库必须保持一致的状态,即满足所有业务规则和约束条件。

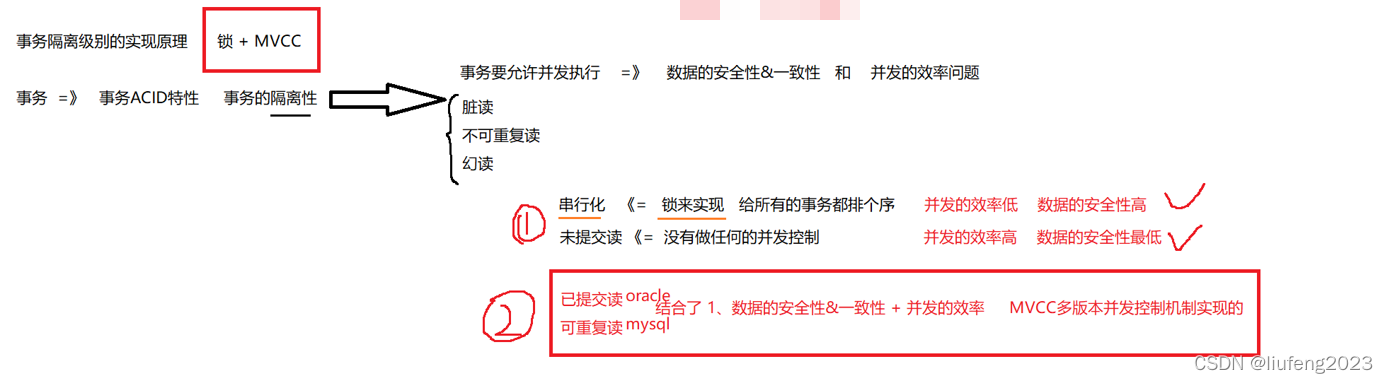

# 2. ACID特性与隔离级别**

## 2.1 ACID特性

ACID特性是数据库事务的四个基本属性,它们共同保证了数据库事务的可靠性和一致性。

### 2.1.1 原子性

原子性是指一个事务中的所有操作要么全部成功,要么全部失败。如果事务中任何一个操作失败,整个事务都会被回滚,数据库的状态不会发生任何变化。

### 2.1.2 一致性

一致性是指事务执行后,数据库必须处于一个一致的状态。这意味着事务执行前后,数据库中数据的完整性约束和业务规则都必须得到满足。

### 2.1.3 隔离性

隔离性是指同时执行的多个事务不会相互影响。每个事务都独立运行,就像它是在一个单独的数据库中执行一样。

### 2.1.4 持久性

持久性是指一旦事务提交,对数据库所做的更改就会永久保存,即使系统发生故障或崩溃。

## 2.2 隔离级别

隔离级别定义了事务之间隔离的程度。MySQL支持四种隔离级别:

### 2.2.1 读未提交

读未提交隔离级别允许事务读取其他事务未提交的更改。这可能会导致脏读,即读取到其他事务尚未提交的数据。

### 2.2.2 读已提交

读已提交隔离级别保证事务只能读取其他事务已提交的更改。这消除了脏读,但可能会导致不可重复读和幻读。

### 2.2.3 可重复读

可重复读隔离级别保证事务在整个执行过程中可以看到相同的数据快照。这消除了不可重复读,但可能会导致幻读。

### 2.2.4 串行化

串行化隔离级别是最严格的隔离级别。它保证事务按照串行顺序执行,就像它们一个接一个地执行一样。这消除了幻读,但会严重影响并发性。

**隔离级别比较表**

| 隔离级别 | 脏读 | 不可重复读 | 幻读 | 并发性 |

|---|---|---|---|---|

| 读未提交 | 可能 | 可能 | 可能 | 最高 |

| 读已提交 | 不可能 | 可能 | 可能 | 中等 |

| 可重复读 | 不可能 | 不可能 | 可能 | 低 |

| 串行化 | 不可能 | 不可能 | 不可能 | 最低 |

0

0