揭秘CUDA并行编程入门:解锁图像处理性能提升的7个关键步骤

发布时间: 2024-08-09 23:16:59 阅读量: 42 订阅数: 24

【CUDA编程】opencv4 + CUDA 并行图像处理:图像均值滤波和图像反色

# 1. CUDA并行编程概述**

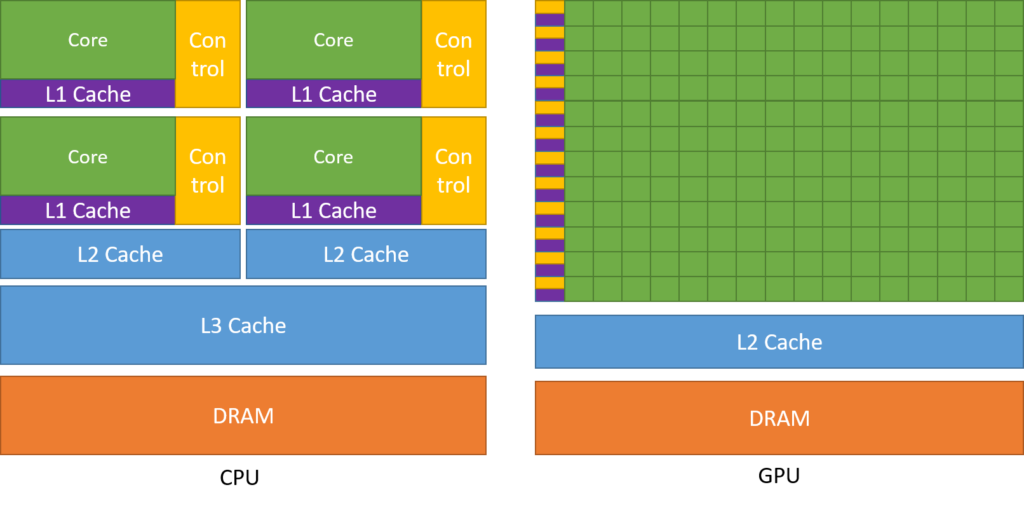

CUDA(Compute Unified Device Architecture)是一种并行计算平台,它利用图形处理单元(GPU)的强大计算能力来加速各种计算密集型任务。与传统CPU相比,GPU具有大量并行处理单元,使其能够同时处理大量数据。

CUDA并行编程是一种利用CUDA平台的编程范式。它允许程序员将计算任务分解成许多较小的任务,这些任务可以并行地在GPU上执行。通过利用GPU的并行性,CUDA程序可以显著提高性能,尤其是在处理大数据集或需要大量计算的任务时。

# 2. CUDA编程基础**

## 2.1 CUDA架构和编程模型

### CUDA架构

CUDA(Compute Unified Device Architecture)是一种由NVIDIA开发的并行计算平台,它允许程序员利用图形处理单元(GPU)的并行处理能力。CUDA架构主要由以下组件组成:

- **主机(Host):**运行CUDA程序的CPU。

- **设备(Device):**执行CUDA程序的GPU。

- **全局内存(Global Memory):**由主机和设备共享的大型内存区域。

- **共享内存(Shared Memory):**由同一线程块内的所有线程共享的小型内存区域。

- **寄存器(Registers):**由单个线程使用的快速内存区域。

### CUDA编程模型

CUDA编程模型采用分层结构,包括:

- **主机代码:**在主机上运行的串行代码,负责初始化设备、分配内存和启动内核函数。

- **内核函数(Kernel):**在设备上运行的并行代码,由大量线程并发执行。

- **线程块(Thread Block):**线程的集合,在共享内存和寄存器上具有局部性。

- **网格(Grid):**线程块的集合,在全局内存上具有局部性。

## 2.2 CUDA内核函数和线程组织

### CUDA内核函数

内核函数是CUDA程序中执行并行任务的函数。它由主机代码启动,并在设备上并发执行。内核函数的语法如下:

```

__global__ void kernel_name(参数列表) {

// 内核函数代码

}

```

### 线程组织

在CUDA中,线程被组织成线程块和网格。线程块是一个二维结构,由线程组组成。网格是一个三维结构,由线程块组组成。

线程组织的示意图如下:

```

Grid

├── Thread Block 1

│ ├── Thread 1

│ ├── Thread 2

│ ├── ...

│ └── Thread N

├── Thread Block 2

│ ├── Thread 1

│ ├── Thread 2

│ ├── ...

│ └── Thread N

└── ...

└── Thread Block M

├── Thread 1

├── Thread 2

├── ...

└── Thread N

```

### 线程索引和块索引

每个线程都有一个唯一的线程索引和块索引。线程索引用于识别线程在块中的位置,而块索引用于识别块在网格中的位置。

```

__threadIdx__ int tidx; // 线程索引

__blockIdx__ int bidx; // 块索引

```

### 代码示例

以下代码示例演示了CUDA内核函数和线程组织:

```

__global__ void add_arrays(int *a, int *b, int *c, int size) {

int tidx = __threadIdx__.x;

int bidx = __blockIdx__.x;

int idx = bidx * blockDim.x + tidx;

if (idx < size) {

c[idx] = a[idx] + b[idx];

}

}

```

在这个示例中,内核函数 `add_arrays` 将两个数组 `a` 和 `b` 的元素相加,并将结果存储在数组 `c` 中。每个线程负责处理数组中的一个元素,线程索引 `tidx` 和块索引 `bidx` 用于计算每个线程负责的元素索引。

# 3. CUDA图像处理实战

### 3.1 图像处理基础知识

**图像表示**

图像由像素组成,每个像素具有颜色和位置信息。在CUDA中,图像通常表示为二维数组,其中每个元素代表一个像素。

**图像格式**

常见的图像格式包括:

* **RGB:**每个像素由三个通道(红色、绿色、蓝色)表示。

* **RGBA:**RGB加一个alpha通道(透明度)。

* **灰度:**每个像素仅由一个通道(亮度)表示。

**图像处理操作**

常见的图像处理操作包括:

* **滤波:**应用卷积核来平滑、锐化或检测图像中的边缘。

* **变换:**旋转、缩放或平移图像。

* **颜色空间转换:**在RGB、HSV或其他颜色空间之间转换图像。

### 3.2 CUDA图像处理算法

**并行图像处理**

CUDA并行编程模型非常适合图像处理,因为图像可以分解为大量独立的像素,可以并行处理。

**CUDA图像处理算法示例**

* **图像平滑:**使用高斯滤波器平滑图像。

* **图像锐化:**使用拉普拉斯滤波器锐化图像。

* **边缘检测:**使用Sobel算子检测图像中的边缘。

* **图像变换:**使用仿射变换或透视变换旋转、缩放或平移图像。

#### 代码示例:图像平滑

```cpp

__global__ void smoothImage(float *image, float *smoothedImage, int width, int height) {

int x = blockIdx.x * blockDim.x + threadIdx.x;

int y = blockIdx.y * blockDim.y + threadIdx.y;

if (x >= width || y >= height) {

return;

}

// 计算高斯滤波器权重

float weight = exp(-(x - width / 2) * (x - width / 2) / (2 * sigma * sigma) - (y - height / 2) * (y - height / 2) / (2 * sigma * sigma));

// 计算平滑后的像素值

smoothedImage[y * width + x] += image[y * width + x] * weight;

}

```

**参数说明:**

* `image`: 输入图像数据。

* `smoothedImage`: 输出平滑后的图像数据。

* `width`: 图像宽度。

* `height`: 图像高度。

* `sigma`: 高斯滤波器的标准差。

**逻辑分析:**

该内核函数使用高斯滤波器平滑图像。它遍历每个像素,计算高斯滤波器权重并将其应用于像素值。权重根据像素与图像中心的距离计算。

# 4.1 内存管理和优化

### 4.1.1 CUDA内存模型

CUDA内存模型分为以下几种类型:

| 内存类型 | 特点 |

|---|---|

| **全局内存 (Global Memory)** | 存储在设备上的全局数据,所有线程都可以访问。 |

| **共享内存 (Shared Memory)** | 存储在设备上的共享数据,同一线程块内的线程可以访问。 |

| **常量内存 (Constant Memory)** | 存储在设备上的只读数据,所有线程都可以访问。 |

| **纹理内存 (Texture Memory)** | 存储在设备上的优化纹理数据,用于纹理采样。 |

| **寄存器 (Registers)** | 存储在设备上的快速局部变量,每个线程都有自己的寄存器。 |

### 4.1.2 内存访问性能优化

**全局内存访问优化**

* **合并全局内存访问:**将多个全局内存访问合并为一次访问,减少内存带宽消耗。

* **使用纹理内存:**对于纹理数据,使用纹理内存可以提高访问效率。

* **预取全局内存:**使用 `__ldg()` 函数预取全局内存数据,减少内存访问延迟。

**共享内存访问优化**

* **减少共享内存使用:**只在必要时使用共享内存,避免不必要的内存开销。

* **优化共享内存访问模式:**使用 coalesced 访问模式,将同一线程块内的线程对共享内存的访问合并为一次访问。

* **使用共享内存同步:**使用 `__syncthreads()` 函数同步共享内存访问,确保线程之间的正确执行顺序。

**寄存器访问优化**

* **使用寄存器变量:**将频繁访问的数据存储在寄存器中,减少全局内存访问。

* **优化寄存器分配:**使用编译器选项优化寄存器分配,减少寄存器争用。

* **使用 `__local()` 变量:**使用 `__local()` 变量存储局部数据,避免寄存器争用。

### 4.1.3 内存管理函数

CUDA提供了以下内存管理函数:

| 函数 | 用途 |

|---|---|

| `cudaMalloc()` | 分配全局内存 |

| `cudaFree()` | 释放全局内存 |

| `cudaMemcpy()` | 复制内存 |

| `cudaMemset()` | 设置内存 |

| `cudaMemcpyToSymbol()` | 将内存复制到符号 |

| `cudaMemcpyFromSymbol()` | 将符号复制到内存 |

### 代码示例:

```c++

// 分配全局内存

float* data = nullptr;

cudaMalloc(&data, sizeof(float) * N);

// 复制数据到全局内存

cudaMemcpy(data, hostData, sizeof(float) * N, cudaMemcpyHostToDevice);

// 使用共享内存

__shared__ float sharedData[1024];

// 使用寄存器变量

register float regData;

```

# 5.1 深度学习与 CUDA

### 深度学习简介

深度学习是一种机器学习技术,它使用多层神经网络来学习数据中的复杂模式。与传统机器学习方法不同,深度学习算法可以自动从数据中提取特征,无需人工特征工程。

### CUDA 在深度学习中的应用

CUDA 在深度学习中发挥着至关重要的作用,因为它提供了并行计算能力,可以显著加速神经网络的训练和推理。以下是一些 CUDA 在深度学习中的主要应用:

- **神经网络训练:** CUDA 可以并行执行神经网络的训练算法,如反向传播和梯度下降。这可以大大缩短训练时间,特别是对于大型数据集和复杂模型。

- **推理:** 一旦神经网络训练完成,CUDA 可以用于快速推理,即预测新数据的输出。这对于实时应用至关重要,如图像分类和自然语言处理。

- **模型并行化:** 对于大型神经网络,CUDA 可以通过模型并行化来提高性能。这种技术将模型划分为多个部分,并在不同的 GPU 上并行执行。

### CUDA 深度学习库

有许多 CUDA 深度学习库可用于简化开发过程。其中一些最流行的库包括:

- **cuDNN:** NVIDIA 开发的高性能深度学习原语库,提供卷积、池化和激活函数等基本操作的优化实现。

- **TensorFlow:** 一个开源机器学习库,提供用于构建和训练深度学习模型的高级 API。TensorFlow 与 CUDA 无缝集成,允许用户利用 GPU 加速。

- **PyTorch:** 另一个开源机器学习库,提供动态计算图功能。PyTorch 也与 CUDA 集成,允许用户轻松地并行化深度学习模型。

### 代码示例:使用 CUDA 训练神经网络

以下是一个使用 CUDA 训练简单神经网络的代码示例:

```python

import torch

import torch.nn as nn

import torch.optim as optim

# 定义神经网络模型

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.fc1 = nn.Linear(28 * 28, 128)

self.fc2 = nn.Linear(128, 10)

def forward(self, x):

x = x.view(x.size(0), -1)

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

# 创建模型并将其移至 GPU

model = Net().cuda()

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 训练模型

for epoch in range(10):

# 将数据移至 GPU

data = data.cuda()

target = target.cuda()

# 前向传播

output = model(data)

# 计算损失

loss = criterion(output, target)

# 反向传播

optimizer.zero_grad()

loss.backward()

# 更新权重

optimizer.step()

```

### 参数说明

- `model.cuda():`将模型移至 GPU。

- `data.cuda():`将数据移至 GPU。

- `target.cuda():`将目标移至 GPU。

- `output = model(data):`前向传播,计算模型输出。

- `loss = criterion(output, target):`计算损失。

- `optimizer.zero_grad():`将梯度清零。

- `loss.backward():`反向传播,计算梯度。

- `optimizer.step():`更新权重。

### 逻辑分析

此代码使用 PyTorch 和 CUDA 训练了一个简单的神经网络。模型首先被移至 GPU,然后数据和目标也被移至 GPU。然后,模型进行前向传播,计算输出。接下来,计算损失,并使用反向传播计算梯度。最后,使用优化器更新权重。此过程重复执行多个 epoch,直到模型训练完成。

# 6. CUDA项目实战**

CUDA项目实战是检验CUDA编程能力的最佳方式。本章将介绍两个CUDA项目实战,分别涉及图像处理和高性能计算领域。

**6.1 图像处理项目**

**项目目标:**实现一个CUDA图像处理程序,用于对图像进行灰度转换和高斯模糊处理。

**步骤:**

1. **创建CUDA项目:**使用CUDA Toolkit创建新的CUDA项目。

2. **加载图像:**从磁盘加载输入图像。

3. **分配设备内存:**为图像数据分配设备内存。

4. **将图像数据复制到设备:**将图像数据从主机内存复制到设备内存。

5. **创建CUDA内核:**编写CUDA内核函数来执行灰度转换和高斯模糊操作。

6. **启动内核:**使用`cudaLaunchKernel`函数启动内核。

7. **将结果复制回主机:**将处理后的图像数据从设备内存复制回主机内存。

8. **保存图像:**将处理后的图像保存到磁盘。

**代码示例:**

```c++

// 灰度转换内核

__global__ void grayscale(unsigned char* image, int width, int height) {

int x = blockIdx.x * blockDim.x + threadIdx.x;

int y = blockIdx.y * blockDim.y + threadIdx.y;

if (x < width && y < height) {

image[y * width + x] = (image[y * width + x] * 0.2126 +

image[y * width + x] * 0.7152 +

image[y * width + x] * 0.0722);

}

}

// 高斯模糊内核

__global__ void gaussianBlur(unsigned char* image, int width, int height) {

int x = blockIdx.x * blockDim.x + threadIdx.x;

int y = blockIdx.y * blockDim.y + threadIdx.y;

if (x < width && y < height) {

// 计算高斯权重

float weight[9] = {

0.00390625, 0.015625, 0.0234375, 0.015625, 0.00390625,

0.0234375, 0.09375, 0.15625, 0.09375, 0.0234375,

0.015625, 0.0625, 0.109375, 0.0625, 0.015625

};

// 计算模糊后的像素值

float sum = 0.0f;

for (int i = -2; i <= 2; i++) {

for (int j = -2; j <= 2; j++) {

if (x + i >= 0 && x + i < width && y + j >= 0 && y + j < height) {

sum += image[(y + j) * width + (x + i)] * weight[i + 2 + (j + 2) * 3];

}

}

}

image[y * width + x] = sum;

}

}

```

**6.2 高性能计算项目**

**项目目标:**实现一个CUDA程序,用于计算矩阵乘法。

**步骤:**

1. **创建CUDA项目:**使用CUDA Toolkit创建新的CUDA项目。

2. **生成随机矩阵:**生成两个随机矩阵。

3. **分配设备内存:**为矩阵数据分配设备内存。

4. **将矩阵数据复制到设备:**将矩阵数据从主机内存复制到设备内存。

5. **创建CUDA内核:**编写CUDA内核函数来执行矩阵乘法。

6. **启动内核:**使用`cudaLaunchKernel`函数启动内核。

7. **将结果复制回主机:**将计算结果从设备内存复制回主机内存。

8. **验证结果:**验证计算结果是否正确。

**代码示例:**

```c++

// 矩阵乘法内核

__global__ void matrixMultiply(float* A, float* B, float* C, int n) {

int i = blockIdx.x * blockDim.x + threadIdx.x;

int j = blockIdx.y * blockDim.y + threadIdx.y;

if (i < n && j < n) {

float sum = 0.0f;

for (int k = 0; k < n; k++) {

sum += A[i * n + k] * B[k * n + j];

}

C[i * n + j] = sum;

}

}

```

0

0