Python调用MATLAB自然语言处理集成:跨语言自然语言处理任务,拓展语言处理能力

发布时间: 2024-06-09 02:51:39 阅读量: 73 订阅数: 47

使用 Python 分析处理自然语言

# 1. 跨语言自然语言处理概述**

跨语言自然语言处理 (NLP) 涉及在不同语言之间处理和分析文本数据。它允许组织跨越语言障碍进行有效沟通,并从多语言数据中提取有价值的见解。

跨语言 NLP 的关键挑战包括:

- **语言差异:**不同语言具有独特的语法、语义和文化背景,需要专门的处理技术。

- **数据稀疏性:**特定语言的文本数据可能有限,导致训练和评估模型的困难。

- **翻译错误:**机器翻译工具可能产生不准确或有偏差的翻译,影响 NLP 任务的性能。

# 2. Python和MATLAB自然语言处理库

### 2.1 Python自然语言处理库

Python拥有丰富的自然语言处理库,可满足各种NLP任务的需求。以下介绍三个最流行的库:

#### 2.1.1 NLTK

NLTK(Natural Language Toolkit)是一个广泛使用的Python NLP库,提供了一系列工具,包括:

- 文本分词和词性标注

- 句法分析和语义分析

- 机器学习算法和预训练模型

- 语料库和资源

**代码块:**

```python

import nltk

# 文本分词

text = "Natural Language Processing is a subfield of linguistics, computer science, and artificial intelligence concerned with the interactions between computers and human (natural) languages."

tokens = nltk.word_tokenize(text)

print(tokens)

# 词性标注

tagged_tokens = nltk.pos_tag(tokens)

print(tagged_tokens)

```

**逻辑分析:**

* `nltk.word_tokenize()`函数将文本分词为单词或符号。

* `nltk.pos_tag()`函数对单词进行词性标注,确定每个单词的词性(例如,名词、动词、形容词)。

#### 2.1.2 spaCy

spaCy是一个高性能的NLP库,专注于速度和准确性。它提供以下功能:

- 预训练的语言模型

- 文本分词、词性标注和句法分析

- 命名实体识别

- 关系提取

**代码块:**

```python

import spacy

# 加载预训练模型

nlp = spacy.load("en_core_web_sm")

# 文本分词和词性标注

doc = nlp("Natural Language Processing is a subfield of linguistics, computer science, and artificial intelligence concerned with the interactions between computers and human (natural) languages.")

for token in doc:

print(token.text, token.pos_)

# 命名实体识别

for ent in doc.ents:

print(ent.text, ent.label_)

```

**逻辑分析:**

* `spacy.load()`函数加载预训练的语言模型。

* `doc = nlp()`对文本进行处理,生成一个`Doc`对象,其中包含分词、词性标注和句法分析信息。

* `doc.ents`属性包含识别出的命名实体。

#### 2.1.3 Gensim

Gensim是一个专注于主题建模和词嵌入的NLP库。它提供以下功能:

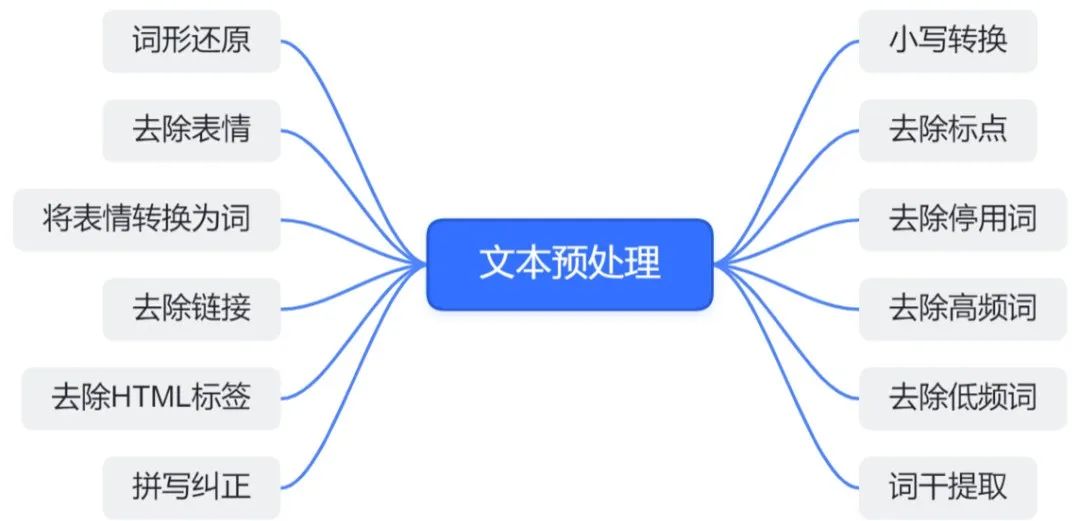

- 文本预处理和特征提取

- 主题建模(LDA、LSI)

- 词嵌入(Word2Vec、GloVe)

0

0