Python API性能优化技巧:提升响应速度的5大关键技术

发布时间: 2024-12-06 22:17:30 阅读量: 10 订阅数: 12

# 1. Python API性能优化概述

## 简介

在当今快速发展的IT领域中,Python凭借其简洁的语法、强大的库支持以及跨平台的特性,被广泛应用于Web开发、数据分析、人工智能等众多领域。然而,随着业务的不断扩展和用户量的持续增加,如何确保Python API应用的性能和效率成为开发者面临的重要挑战。性能优化不单是提高代码执行速度那么简单,它还包括了内存管理、网络请求处理、代码优化以及系统架构调整等多方面的工作。

## 性能优化的重要性

性能优化对于任何应用都至关重要,尤其是对那些需要处理大量并发请求、高频率数据交互的API服务。良好的性能优化可以减少延迟,提高吞吐量,节省服务器资源,从而降低运维成本并提升用户体验。此外,优秀的性能优化还能帮助API服务更好地应对突发的流量高峰,保证服务的稳定性和可靠性。

## 性能优化的挑战

Python虽然在开发效率上占尽优势,但其在性能方面却常受到诟病,尤其是在运行效率和资源消耗上。Python的全局解释器锁(GIL)和动态类型系统,在带来开发便利的同时,也限制了多线程的并行处理能力。这些特性使得Python在多核处理器上的并行化处理不如其他多线程语言高效。因此,针对Python API的性能优化,需要采取特别的策略和技术,来克服这些固有的限制。接下来的章节将详细介绍如何通过不同的方法和工具来识别和优化Python API的性能瓶颈。

# 2. 理解Python API性能瓶颈

Python以其简洁易读的语法和强大的标准库吸引了大量的开发者,但当涉及到性能敏感的应用时,开发者常常需要面对性能瓶颈的问题。理解并优化这些性能瓶颈对于提高应用的响应速度和处理能力至关重要。

### 2.1 识别性能瓶颈的方法论

#### 2.1.1 性能分析工具的使用

要有效识别性能瓶颈,首先需要掌握一些性能分析工具。Python社区提供了多种工具来帮助开发者进行性能分析,包括但不限于cProfile、line_profiler、memory_profiler等。

- **cProfile** 是Python内置的一个性能分析工具,它可以提供函数调用的统计信息,帮助开发者了解程序运行期间各个函数的调用次数、耗时等信息。

```python

import cProfile

cProfile.run('your_function()') # Replace 'your_function()' with the actual function you want to profile.

```

- **line_profiler** 是一个可以提供逐行性能分析的工具,它对于深入分析性能问题特别有用,因为它可以告诉你每一行代码的运行时间。

```python

# First, you need to install line_profiler with `pip install line_profiler`.

# Then, decorate the function you want to profile with @profile and run `kernprof -l -v your_script.py`.

from line_profiler import LineProfiler

def my_function():

# Your function code here

pass

lp = LineProfiler()

lp_wrapper = lp(my_function)

lp_wrapper()

```

- **memory_profiler** 专注于内存使用情况,它可以帮助开发者识别程序中内存消耗过高的部分。

```python

# You need to install the package using pip install memory_profiler.

# Then decorate the function with @profile and run `mprof run your_script.py`.

from memory_profiler import profile

@profile

def my_memory_hogging_function():

# Your function code here

pass

```

#### 2.1.2 性能瓶颈的诊断流程

诊断性能瓶颈需要一系列的步骤,包括:

- **收集性能数据**:使用上述工具或第三方服务(如New Relic, Datadog)收集性能数据。

- **分析性能数据**:查看哪些函数或代码块消耗了大量的时间和内存资源。

- **确定瓶颈**:根据分析结果确定真正的性能瓶颈。瓶颈可能是由于算法效率低下、数据库查询慢、网络延迟、I/O操作频繁等原因造成的。

- **优化**:对确定的瓶颈实施优化措施,比如改进算法、优化数据库查询、使用缓存、异步编程等。

- **验证**:优化后需要重新收集性能数据并进行分析,以验证优化是否有效。

### 2.2 代码层面的性能优化

#### 2.2.1 算法和数据结构优化

在算法和数据结构层面优化性能是提高程序运行效率的根本途径。

- **使用高效的数据结构**:例如,在需要频繁插入和删除操作的场景中使用`deque`而不是`list`。

- **避免不必要的计算**:比如使用缓存或记忆化技术(memoization)避免重复计算。

- **时间复杂度和空间复杂度的权衡**:有时候为了换取更快的执行时间,需要使用更多的内存空间,反之亦然。

#### 2.2.2 循环优化技巧

在Python中,循环是执行重复任务的主要方式之一,而循环优化可以显著提升性能。

- **避免在循环中重复计算**:将循环外可以预先计算的值移到循环外。

- **减少循环内部操作**:例如,使用列表推导式替代循环创建列表。

- **使用内置函数**:内置函数通常是用C编写的,比Python中的等效实现要快。

```python

# Bad practice - calculating len() in each iteration

for i in range(len(some_list)):

# Some operations here

# Good practice - calculate it once outside the loop

some_list_length = len(some_list)

for i in range(some_list_length):

# Some operations here

```

### 2.3 系统层面的性能优化

#### 2.3.1 多进程与多线程的应用

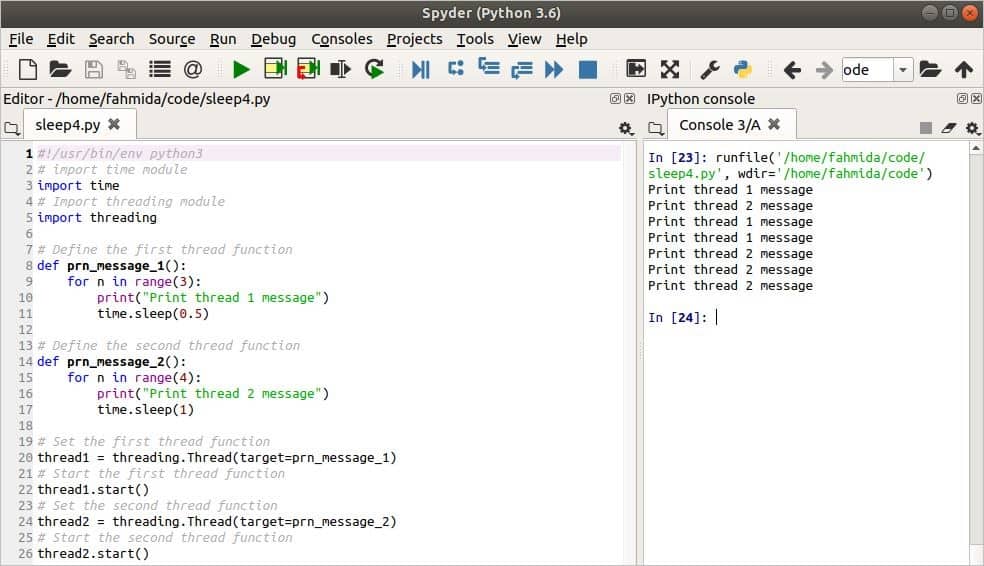

Python的全局解释器锁(GIL)限制了同一时刻只有一个线程执行Python字节码。因此,多进程通常比多线程更适合计算密集型任务。

- **多进程模型**:使用`multiprocessing`库启动多个进程,每个进程拥有自己的Python解释器和内存空间。

- **多线程模型**:适用于I/O密集型任务,使用`threading`库可以更简单地实现并发。

```python

from multiprocessing import Process

import os

def worker():

""" запускаемая функция рабочего процесса """

print(f'Process ID: {os.getpid()}')

if __name__ == '__main__':

num_processes = 4

processes = []

for _ in range(num_processes):

p = Process(target=worker)

p.start()

processes.append(p)

for p in processes:

p.join()

```

#### 2.3.2 异步IO和事件驱动模型

对于I/O密集型任务,异步IO模型可以大幅提升性能,它允许程序在等待I/O操作完成时继续执行其他任务,而不是阻塞。

- **asyncio** 是Python中处理异步IO的标准库,可以使用`async/await`语法编写异步代码。

- **事件驱动模型** 适用于需要处理大量并发连接的服务器端程序,如web服务器。

```python

import asyncio

async def main():

print('Hello ...')

await asyncio.sleep(1)

print('... World!')

# Python 3.7+

asyncio.run(main())

```

以上内容涵盖了识别和分析Python API性能瓶颈的关键方法和工具,以及在代码层面和系统层面优化性能的实践策略。掌握这些知识对于开发高效稳定的Python应用至关重要。接下来的章节将深入探讨内存管理和优化策略,进一步提升Python API的性能。

# 3. 内存管理与优化策略

内存是计算机中的一种重要资源,其分配、使用和回收直接影响到程序的性能。在Python API性能优化中,内存管理是一个不容忽视的环节。良好的内存管理不仅可以提升程序运行效率,还能延长程序运行周期。本章节将从Python内存管理机制讲起,深入探讨内存优化技术,并指导如何选择合适的数据结构进行优化。

## 3.1 Python内存管理机制

### 3.1.1 内存分配与回收机制

Python采用自动内存管理机制,开发者无需手动分配和释放内存。这一机制通过引用计数(reference counting)和垃圾回收(garbage collection)两种技术实现。

**引用计数**是一个简单的计数器,它记录着有多少对象引用了该数据。当对象的引用计数降至零时,意味着没有任何变量引用该对象,它变成了垃圾,可以被回收。虽然这种方法直观有效,但它无法处理循环引用的问题。为了解决这一缺陷,Python使用了垃圾回收器。

**垃圾回收器**通常采

0

0