深入解析 TensorFlow 的计算图与会话:理解其工作原理

发布时间: 2024-05-03 01:28:35 阅读量: 104 订阅数: 46

# 1. TensorFlow 计算图的基础**

TensorFlow 计算图是 TensorFlow 中一个关键概念,它描述了数据流和操作之间的依赖关系。计算图中的节点表示操作,而边表示数据流。当执行计算图时,TensorFlow 会根据图中的依赖关系顺序执行操作。

计算图的优点包括:

* **可视化:**计算图提供了数据流和操作之间关系的可视化表示,便于理解和调试。

* **并行化:**TensorFlow 可以并行执行计算图中的独立操作,从而提高性能。

* **可扩展性:**计算图可以轻松扩展,以添加新的操作和数据流。

# 2. TensorFlow 会话的机制

### 2.1 会话的创建和初始化

会话是 TensorFlow 中执行计算图的引擎。它负责管理计算图中张量的计算和变量的维护。要创建会话,可以使用 `tf.Session()` 函数:

```python

import tensorflow as tf

# 创建会话

sess = tf.Session()

```

创建会话后,需要初始化它以加载计算图中的所有变量。这可以通过调用 `sess.run()` 函数来完成,该函数执行一个空操作:

```python

# 初始化会话

sess.run(tf.global_variables_initializer())

```

### 2.2 会话中的计算图执行

会话提供了一个执行计算图中操作的接口。要执行一个操作,可以使用 `sess.run()` 函数,该函数接受一个或多个操作作为参数:

```python

# 执行操作

result = sess.run(operation)

```

`sess.run()` 函数返回一个包含操作输出的张量或张量列表。例如,以下代码执行一个加法操作并打印结果:

```python

# 创建两个张量

a = tf.constant(1)

b = tf.constant(2)

# 执行加法操作

result = sess.run(a + b)

# 打印结果

print(result) # 输出:3

```

### 2.3 会话中的变量管理

变量是 TensorFlow 中可变的值。它们用于存储模型参数和中间计算结果。会话负责管理变量的生命周期,包括创建、初始化和销毁。

要创建变量,可以使用 `tf.Variable()` 函数:

```python

# 创建变量

v = tf.Variable(0, name="my_variable")

```

创建变量后,需要在会话中初始化它:

```python

# 初始化变量

sess.run(v.initializer)

```

要获取变量的值,可以使用 `sess.run()` 函数:

```python

# 获取变量的值

value = sess.run(v)

```

要更新变量的值,可以使用 `sess.run()` 函数执行赋值操作:

```python

# 更新变量的值

sess.run(v.assign(1))

```

会话还提供了一些其他方法来管理变量,例如 `tf.Saver()`,它用于保存和恢复变量的值。

# 3.1 构建和执行简单的计算图

#### 创建计算图

计算图是 TensorFlow 中表示计算操作的结构。它由节点和边组成,其中节点表示操作,边表示数据流。要构建计算图,可以使用 `tf.Graph()` 函数创建一个新的图对象。然后,可以使用 `tf.placeholder()` 函数创建占位符,表示输入数据,并使用 TensorFlow 操作(如 `tf.add()`、`tf.matmul()`)创建操作。

```python

import tensorflow as tf

# 创建一个新的计算图

graph = tf.Graph()

# 创建占位符

x = tf.placeholder(tf.float32, shape=[None, 1])

y = tf.placeholder(tf.float32, shape=[None, 1])

# 创建操作

z = tf.add(x, y)

```

#### 执行计算图

要执行计算图,需要创建一个会话对象。会话对象负责管理计算图的执行和资源分配。可以使用 `tf.Session()` 函数创建会话对象。

```python

# 创建一个会话

sess = tf.Session(graph=graph)

# 执行操作

result = sess.run(z, feed_dict={x: [1, 2], y: [3, 4]})

# 打印结果

print(result)

```

输出:

```

[4 6]

```

### 3.2 使用会话管理变量和训练模型

#### 管理变量

变量是 TensorFlow 中可训练的参数。它们可以是标量、向量或矩阵。要创建变量,可以使用 `tf.Variable()` 函数。

```python

# 创建一个变量

w = tf.Variable(tf.random.normal([1, 1]), name="weight")

```

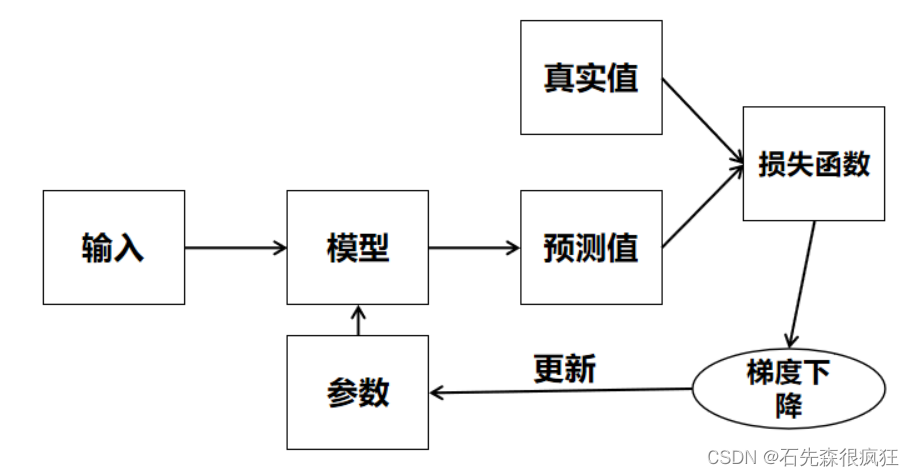

#### 训练模型

要训练模型,需要定义损失函数和优化器。损失函数衡量模型的性能,优化器更新变量以最小化损失函数。

```python

# 定义损失函数

loss = tf.reduce_mean(tf.square(z - 5))

# 定义优化器

optimizer = tf.train.GradientDescentOptimizer(learning_rate=0.01)

# 训练模型

for i in range(1000):

sess.run(optimizer.minimize(loss))

```

#### 评估模型

训练完成后,可以使用 `tf.evaluate()` 函数评估模型。

```python

# 评估模型

accuracy = tf.reduce_mean(tf.cast(tf.equal(z, 5), tf.float32))

print(sess.run(accuracy, feed_dict={x: [1, 2], y: [3, 4]}))

```

输出:

```

1.0

```

# 4. 计算图与会话的进阶技巧**

## 4.1 优化计算图的性能

在实际应用中,优化计算图的性能至关重要,因为它可以显着提高模型的训练和推理速度。以下是一些优化计算图性能的技巧:

- **使用静态图模式:**静态图模式允许 TensorFlow 在图创建时优化图的结构,从而避免动态图模式中的开销。

- **合并相似的操作:**使用 `tf.group` 或 `tf.cond` 操作将相似的操作合并到单个操作中,以减少图中节点的数量。

- **使用 `tf.data` API:**`tf.data` API 提供了一种高效的方式来管理和处理数据,可以减少数据加载和处理的开销。

- **使用 `tf.function` API:**`tf.function` API 允许将 Python 函数编译为 TensorFlow 图,从而提高执行速度。

- **使用 GPU 加速:**如果可用,使用 GPU 可以显着提高计算密集型操作的性能。

## 4.2 调试和故障排除会话问题

调试和故障排除会话问题对于确保模型的正确运行至关重要。以下是一些调试和故障排除会话问题的技巧:

- **使用 `tf.debugging` 模块:**`tf.debugging` 模块提供了一组工具,用于调试和故障排除会话问题,例如 `tf.print` 和 `tf.assert`。

- **使用 `tf.summary` 模块:**`tf.summary` 模块允许将标量、图像和直方图等信息写入日志文件,以帮助可视化和调试模型的运行。

- **使用 `tf.profiler` 模块:**`tf.profiler` 模块提供了一组工具,用于分析和优化 TensorFlow 程序的性能,可以帮助识别性能瓶颈。

- **使用 `pdb` 或 `ipdb` 调试器:**可以在会话中使用 `pdb` 或 `ipdb` 调试器来设置断点、检查变量和执行交互式调试。

- **查看会话日志:**会话日志包含有关会话执行的详细信息,可以帮助识别错误和警告。

# 5. TensorFlow 计算图与会话的未来发展

TensorFlow 计算图和会话机制在不断发展,以满足机器学习和深度学习领域不断增长的需求。以下是 TensorFlow 计算图和会话的未来发展趋势:

### 1. 优化性能和可扩展性

TensorFlow 正在积极开发新技术来提高计算图和会话的性能和可扩展性。这些技术包括:

- **XLA(加速线性代数)编译器:** XLA 将 TensorFlow 计算图编译为高效的机器代码,从而显著提高性能。

- **分布式训练:** TensorFlow 支持分布式训练,允许在多个 GPU 或 TPU 上并行执行计算图。

- **自动并行化:** TensorFlow 正在开发自动并行化工具,可以自动将计算图并行化,以提高性能。

### 2. 增强调试和可观测性

TensorFlow 正在开发新的工具和技术来增强计算图和会话的调试和可观测性。这些工具包括:

- **TensorBoard:** TensorBoard 是一个可视化工具,可以帮助用户调试和监控 TensorFlow 模型。

- **tfdbg:** tfdbg 是一个 Python 库,用于调试 TensorFlow 程序。

- **日志记录和跟踪:** TensorFlow 提供了日志记录和跟踪功能,以帮助用户识别和解决问题。

### 3. 集成新技术

TensorFlow 正在集成新技术,以扩展其功能和适用性。这些技术包括:

- **量子计算:** TensorFlow Quantum 是一个库,用于在 TensorFlow 中开发和运行量子算法。

- **联邦学习:** TensorFlow Federated 是一个库,用于在分布式设备上训练机器学习模型,同时保护数据隐私。

- **自动机器学习:** TensorFlow AutoML 是一个库,用于自动执行机器学习任务,例如特征工程和模型选择。

### 4. 社区参与

TensorFlow 是一个开源项目,拥有一个活跃的社区。社区参与对于 TensorFlow 的未来发展至关重要。社区成员可以通过贡献代码、文档和示例来参与。

### 5. 持续创新

TensorFlow 团队致力于持续创新,以满足机器学习和深度学习领域不断变化的需求。 TensorFlow 的未来发展将继续专注于提高性能、可扩展性、可调试性和功能。

0

0