CPU设计优化秘籍:提升性能的10大策略

发布时间: 2025-01-10 03:23:04 阅读量: 8 订阅数: 9

# 摘要

本文系统地探讨了CPU设计优化的基础知识、理论研究、实践应用、编程与编译器优化,以及先进技术和未来趋势。通过分析CPU架构、性能指标、理论优化模型以及微架构改进策略、功耗管理技术和缓存优化,本文为CPU性能的提升提供了多维度的视角。同时,文章深入讨论了并行编程模型、编译器优化技术以及性能分析工具,并探讨了新型处理器架构、优化工具与方法、跨学科创新如何在CPU设计中发挥作用。本文旨在为研究者和工程师提供一个全面的CPU设计优化指南,强调了持续创新与跨学科合作在推动CPU技术发展中的重要性。

# 关键字

CPU设计;微架构改进;功耗管理;并行编程;编译器优化;性能分析;新型处理器架构;跨学科创新

参考资源链接:[计算机组成原理与系统结构:包健版课后习题详解](https://wenku.csdn.net/doc/7r8hnpr97o?spm=1055.2635.3001.10343)

# 1. CPU设计优化基础

CPU作为计算机的核心组件,其设计优化是提升系统性能的关键所在。本章节旨在为读者提供CPU设计优化的入门知识,为深入理解后续章节内容打下基础。本章内容将包含:

## 1.1 CPU基本工作原理

CPU通过执行指令来处理数据,每一条指令都由一系列操作构成,例如数据获取、算术运算和结果存储等。了解CPU如何读取、解码、执行指令,并最终得到结果,是学习CPU设计优化的前提。

## 1.2 优化的目标与方法

优化CPU设计的目标通常包括提高速度、减少能耗和降低成本。方法可以从硬件架构调整、算法优化和软件编译器优化等不同层面进行。本章将概述这些优化方法的基本概念。

## 1.3 编程与软件优化的协同

虽然硬件是性能的基础,但软件层面上的优化同样不可或缺。合理地编写代码以及利用编译器优化可以极大程度上提升CPU的执行效率。本章还会介绍与CPU优化相关的一些编程实践。

总结来说,本章为理解后续章节的深入CPU优化技术、架构设计以及编程实践提供坚实的基础,为之后的技术和方法探索铺垫道路。

# 2. 理论研究与分析

## 2.1 CPU架构概述

### 2.1.1 CPU基本组成

CPU(中央处理单元)是计算机系统中的核心部件,它负责指令的执行和数据的处理。一个典型的CPU架构包括算术逻辑单元(ALU)、控制单元(CU)、寄存器组、高速缓存(Cache)、总线接口以及外部接口。算术逻辑单元是执行所有算术和逻辑运算的硬件部分。控制单元负责协调整个处理器的操作,解析指令并执行相应的操作。寄存器是存储临时数据和指令的小型快速存储区域。高速缓存则用于减少处理器访问主内存的时间,提高数据访问速度。

```mermaid

graph TD

A[CPU] --> B[ALU]

A --> C[CU]

A --> D[寄存器组]

A --> E[Cache]

A --> F[总线接口]

A --> G[外部接口]

```

### 2.1.2 流水线与超线程技术

流水线技术是通过将指令的执行过程分割成多个阶段,让多个指令的不同阶段可以并行处理,从而提高CPU的执行效率。超线程技术,又称为多线程技术,是一种可以在单个CPU核心中模拟双核心或多核心的技术,它允许一个物理CPU核心在不同线程之间切换执行,以更好地利用CPU资源。

## 2.2 CPU性能指标

### 2.2.1 吞吐量、延迟和功耗

CPU性能通常用吞吐量、延迟和功耗来衡量。吞吐量是单位时间内CPU完成任务的数量,延迟是指完成单个任务所需的平均时间,功耗则是CPU在运行中消耗的电力量。这三个指标之间存在相互影响,例如,为了降低延迟,可能会牺牲一些吞吐量,而为了提升吞吐量可能会增加功耗。

### 2.2.2 性能评估方法

性能评估的方法有多种,常见的有基准测试、性能分析工具和模拟器等。基准测试通常使用标准化的工作负载来衡量CPU的性能。性能分析工具可以提供详细的运行时信息,帮助开发者识别性能瓶颈。模拟器可以在没有物理硬件的情况下模拟CPU的运行环境,以评估不同的设计改变对性能的影响。

## 2.3 理论优化模型

### 2.3.1 Amdahl定律与Gustafson定律

Amdahl定律是评估并行计算系统性能的一个理论模型,它指出,对于一个计算任务,其加速比受限于程序中不可并行化的部分。而Gustafson定律则是对Amdahl定律的一种补充,认为随着问题规模的增加,程序中可并行化的部分也会增加,从而使得加速比提高。这两个定律对于理解并行计算的潜在性能和优化方向具有指导意义。

### 2.3.2 CPU设计的性能模型

CPU设计的性能模型通常是用来分析和预测CPU性能的数学模型。这些模型考虑了CPU的各个组成部分,如ALU、寄存器、缓存等,以及它们之间的交互影响。通过构建和分析这些模型,可以对CPU设计进行理论上的优化,并对性能进行预估。

通过上述章节内容,我们可以了解到CPU架构的基本组成,性能指标的重要性以及理论优化模型的作用。这些知识为我们深入理解CPU设计优化的实践应用打下了坚实的基础。在下一章节中,我们将探讨CPU设计优化的具体实践,包括微架构改进策略、功耗管理技术和缓存优化等。

# 3. 设计优化实践

## 3.1 微架构改进策略

微架构是CPU设计的核心,它包括了处理器的指令执行、数据处理、指令调度和寄存器管理等关键部分。优化微架构,可以在不改变芯片制造工艺的前提下,显著提高处理器性能和效率。

### 3.1.1 增加指令级并行度

指令级并行度(Instruction-Level Parallelism, ILP)是衡量CPU能否同时执行多条指令的能力。现代处理器通过以下方法来提高ILP:

- **超标量架构**:这种设计允许CPU在每个时钟周期内同时发射多条指令到不同的执行单元。

- **乱序执行**(Out-of-Order Execution, OoOE):它允许指令的执行顺序不同于程序中指令的顺序,以减少执行单元空闲和等待的时间。

### 3.1.2 提高分支预测准确性

分支预测是处理器预测程序执行路径的技术,可以减少因为分支指令导致的流水线停顿。分支预测的准确性直接关联到CPU性能。

- **历史表法**:维护一个历史表来记录之前分支的结果,以此作为预测当前分支行为的依据。

- **双模预测器**:结合动态预测和静态预测的优点,对不同类型的分支采用不同的预测策略。

```mermaid

graph TD

A[开始分支预测] --> B{分支指令}

B --是跳转指令--> C[使用历史表预测]

B --不是跳转指令--> D[使用静态预测]

C --> E{预测结果}

D --> E

E --正确--> F[继续执行]

E --错误--> G[重新填充流水线]

F --> H[执行下条指令]

G --> B

```

## 3.2 功耗管理技术

随着芯片集成度的不断提高,功耗管理成为处理器设计中的重要问题。高效的功耗管理技术能够在保持性能的同时减少能耗,延长设备的电池寿命。

### 3.2.1 动态电压频率调整

动态电压频率调整(Dynamic Voltage and Frequency Scaling, DVFS)是一种降低处理器功耗的技术。通过动态调整CPU的电压和频率,以适应当前的性能需求。

- **频率调整**:根据任务负载,调整CPU的工作频率。

- **电压调整**:与频率调整相结合,降低电压减少能耗。

```mermaid

graph LR

A[开始DVFS] --> B{检测任务负载}

B --负载高--> C[增加频率和电压]

B --负载低--> D[降低频率和电压]

C --> E[执行高负载任务]

D --> F[执行低负载任务]

E --> G[监控负载]

F --> G

```

### 3.2.2 低功耗设计技术

低功耗设计技术包括处理器组件的优化设计,比如使用低功耗的晶体管、优化寄存器和存储器等。

- **优化晶体管设计**:使用低阈值电压晶体管可以减少静态功耗。

- **优化存储结构**:例如使用静态随机存取存储器(SRAM)作为缓存,相比于动态随机存取存储器(DRAM),SRAM在读写操作上能耗更低。

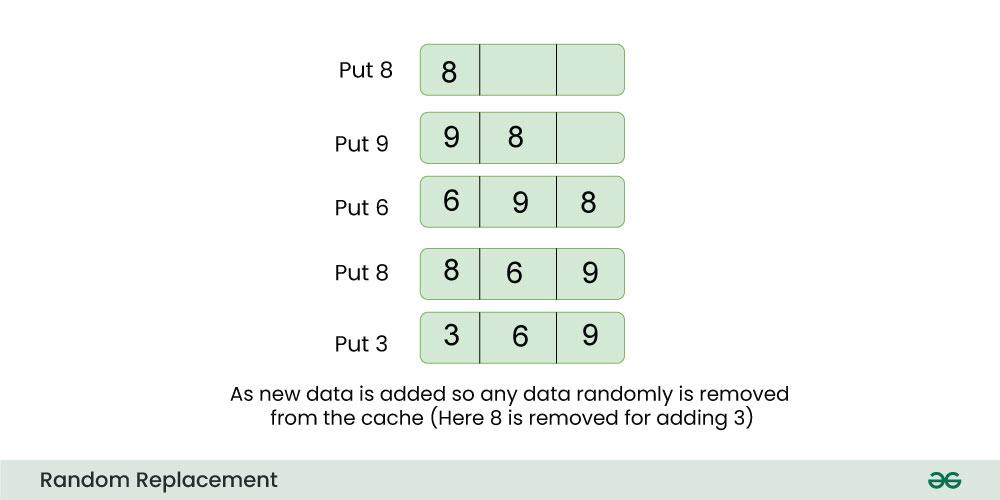

## 3.3 缓存优化

缓存是CPU和主存之间的快速存储层,用于减少处理器访问慢速主存的次数。缓存的设计和优化直接影响到CPU的性能。

### 3.3.1 缓存层次结构设计

缓存层次结构设计通过在CPU内部建立多级缓存,以提供更快的访问速度和更大的存储容量。

- **L1缓存**:最快的缓存,直接集成在CPU核心内部。

- **L2缓存**:容量比L1大,速度稍慢。

- **L3缓存**:通常比L1和L2大得多,用于整个CPU核心间共享数据。

### 3.3.2 预取策略与缓存一致性问题

预取是提前从主存中加载数据到缓存的技术,而缓存一致性问题涉及到保证多个缓存副本数据同步的问题。

- **预取策略**:CPU利用算法预测接下来将要访问的数据,并提前将其加载到缓存中。

- **缓存一致性机制**:如MESI协议,用于维护不同缓存间的同步。

```markdown

| 缓存级别 | 位置 | 容量 | 速度 | 距离CPU核心距离 |

|----------|--------------|-------|--------|------------------|

| L1 | 核心内部 | 最小 | 最快 | 最近 |

| L2 | 核心内部 | 中等 | 中等 | 较近 |

| L3 | 核心之间共享 | 最大 | 较慢 | 最远 |

```

```c

// 缓存预取代码示例

void prefetch_data(void* address) {

// 这里的代码是示意性的,实际上编译器和硬件会负责预取

int* data = (int*)address;

// 提前将数据加载到缓存中

*data;

}

```

在本章中,我们深入了解了CPU微架构的改进策略,包括增加指令级并行度和提高分支预测准确性,这两者直接影响处理器的执行效率和性能。另外,我们探讨了功耗管理技术,如DVFS和低功耗设计,这些技术在保证性能的同时,有效地减少能耗。缓存优化部分涉及缓存层次结构的设计和预取策略,这些优化措施有助于缩短数据访问时间,同时保证数据的一致性。在下一章节中,我们将转向编程和编译器层面的优化,探索如何通过软件手段进一步提高CPU的执行效率。

# 4. 编程与编译器优化

## 4.1 并行编程模型

并行编程模型是利用多个计算资源(例如CPU核心)来同时执行计算任务的编程方法。在这一部分,我们将深入探讨并行编程中的关键概念和技术。

### 4.1.1 多线程与SIMD技术

多线程是并行编程中一种常见的技术,它允许多个执行线程同时在单个CPU核心或多个核心上运行。每个线程可以看作是独立的执行路径,通过时间分片或同时执行的方式,提高程序的并发性和整体性能。

SIMD(单指令多数据)是一种处理器设计技术,它可以同时处理多个数据元素,是并行计算的基础之一。在现代CPU中,SIMD扩展如SSE、AVX等被广泛支持,使得一次可以处理多个数据点,显著提升向量和矩阵计算的性能。

#### 应用实例

例如,在图像处理应用中,通过多线程可以将图像的不同区域分配给不同的线程处理,而SIMD技术可以在一个时钟周期内对多个像素值执行相同的操作。这样不仅实现了数据的并行处理,也充分利用了现代CPU的并行计算能力。

### 4.1.2 并行计算框架和API

为了简化并行编程的复杂性,众多并行计算框架和API被开发出来,如OpenMP、MPI、CUDA和OpenCL等。这些工具为开发者提供了易于使用且高效的并行计算抽象。

#### 应用实例

以OpenMP为例,程序员可以使用简单的编译器指令和运行时库函数来创建多线程程序。如下代码展示了如何使用OpenMP指令来并行化一个简单的累加操作:

```c

#include <omp.h>

#include <stdio.h>

int main() {

int sum = 0;

int n = 1000000;

#pragma omp parallel for reduction(+:sum)

for (int i = 0; i < n; ++i) {

sum += i;

}

printf("Sum is %d\n", sum);

return 0;

}

```

此代码段中,`#pragma omp parallel for`指令指示编译器将for循环并行化。`reduction(+:sum)`指定了并行区域完成后的累加操作。

## 4.2 编译器优化技术

编译器优化技术是提升程序性能的重要手段,它在源代码编译阶段进行,自动将程序转换成更高效的执行形式。

### 4.2.1 代码优化级别与方法

编译器通常提供多个优化级别,如GCC中的`-O1`、`-O2`和`-O3`。这些级别控制了编译器执行的优化类型和数量。高级别优化包括循环展开、函数内联、指令调度等,这些优化可以显著提高程序性能。

#### 应用实例

使用GCC编译器进行优化时,开发者可以选择适当的优化级别来平衡编译时间和运行时性能。例如:

```bash

gcc -O2 my_program.c -o my_program

```

此命令将源文件`my_program.c`编译并优化到第二级别,生成优化后的可执行文件`my_program`。

### 4.2.2 编译器优化技术的应用案例

编译器优化技术在多种场景下得到应用。例如,在数学库函数中,编译器通过自动向量化来利用SIMD指令集,大幅提升计算密集型函数的性能。

#### 应用实例

考虑一个简单的数值积分计算,使用编译器优化功能:

```c

#include <stdio.h>

#include <stdlib.h>

double integrate(double (*func)(double), double a, double b, int n) {

double h = (b - a) / n;

double sum = 0.0;

for (int i = 0; i < n; ++i) {

sum += func(a + i * h);

}

sum *= h;

return sum;

}

double my_function(double x) {

return x * x;

}

int main() {

double result = integrate(my_function, 0, 1, 1000000);

printf("Integral result: %f\n", result);

return 0;

}

```

在这个例子中,编译器将能够对`integrate`函数进行向量化,利用SIMD指令集高效处理循环中的函数调用。注意,为了使向量化顺利进行,应尽量保证函数`my_function`和循环本身不含分支语句,避免循环展开时条件分支的出现。

## 4.3 性能分析工具

性能分析工具帮助开发者识别程序中的性能瓶颈,并提供优化建议。

### 4.3.1 常用性能分析工具介绍

在性能分析工具方面,gprof、Valgrind、Perf等是经常使用的工具,它们能够提供函数调用次数、执行时间等重要指标。

#### 应用实例

以`gprof`为例,开发者可以使用`-pg`编译选项来编译程序:

```bash

gcc -pg -O2 my_program.c -o my_program

```

运行编译出的程序后,会生成`gmon.out`文件,再用`gprof`工具分析:

```bash

gprof my_program gmon.out > report.txt

```

这样会生成一个性能分析报告`report.txt`,其中包含了函数调用统计信息和程序性能瓶颈的详细分析。

### 4.3.2 性能调优流程与实例

调优流程通常包括识别瓶颈、分析原因、修改代码、重新分析等步骤。这一过程是迭代进行的,直到达到理想的性能目标。

#### 应用实例

假设我们已经通过`gprof`识别到一个性能瓶颈——某个关键函数执行过慢。分析可能表明,该函数包含大量循环计算,且循环内部存在不必要的数组访问。针对这个问题,我们可以进行以下优化:

- 循环展开,减少循环控制开销。

- 利用局部性原理,优化数组访问模式,减少缓存未命中率。

- 应用编译器指令,如`__builtin_prefetch`,来手动预取数据到缓存。

代码修改后,我们重新编译并运行`gprof`来验证性能提升。

## 4.4 高级性能分析与调优技术

本部分将探讨更高级的性能分析与优化技术,如使用代码剖析工具进行热点检测,以及针对特定硬件架构的优化方法。

### 4.4.1 热点检测与分析

热点检测是识别程序中执行时间最长的代码段的过程。通过识别这些热点,开发者可以集中精力优化影响最大的部分。

#### 应用实例

使用`Valgrind`的`Callgrind`工具,开发者可以运行程序并收集执行数据:

```bash

valgrind --tool=callgrind ./my_program

```

`Callgrind`工具会生成分析文件,使用`KCachegrind`可以进行可视化的分析和理解程序性能。

### 4.4.2 架构特定优化

针对特定硬件架构进行的优化可以极大提升性能。例如,某些处理器可能有针对特定数学运算的优化指令,或者特定的数据传输和内存访问模式优化。

#### 应用实例

针对某一特定CPU架构,开发者可能需要利用特定的硬件特性,如Intel AVX指令集。可以通过编译器的特定标志启用这些指令集:

```bash

gcc -mavx my_program.c -o my_program

```

这样编译出的程序能够利用AVX指令集进行高效的向量计算。

### 4.4.3 编译器和编译选项的影响

不同的编译器和编译选项可以产生显著不同的代码优化结果。正确选择编译器和优化级别是性能调优的关键步骤。

#### 应用实例

考虑两个不同的编译器,GCC和Clang,它们可能针对相同的代码产生不同的优化效果:

```bash

gcc -O3 -march=native my_program.c -o my_program

clang -O3 -march=native my_program.c -o my_program

```

执行上述命令将使用GCC和Clang以最大程度的优化本地硬件架构编译出程序。通过比较两者的运行时间,我们可以评估哪种编译器更适合自己特定的应用场景。

## 4.5 性能调优的实际案例分析

通过具体案例分析,本小节将展示如何运用前面章节中介绍的理论和工具进行实际的性能调优。

### 4.5.1 案例研究:多线程Web服务器性能优化

在本案例中,我们将分析一个多线程Web服务器的性能瓶颈,并讨论如何利用多线程和编译器优化技术提升其性能。

#### 应用实例

假设我们有一个多线程Web服务器,它处理HTTP请求的代码段成为性能瓶颈。通过多线程来处理不同的HTTP请求,可以提高服务器的并发性能。同时,通过调整编译器优化选项,可以进一步提升单个线程的处理速度,例如:

```bash

gcc -O2 -fopenmp web_server.c -o web_server

```

在此命令中,`-fopenmp`选项启用了OpenMP支持,允许编译器将代码中的并行区域自动转换为多线程代码。

### 4.5.2 案例研究:编译器内联函数优化

内联函数是编译器优化的一种形式,将函数调用替换为函数体的副本,减少了函数调用的开销。

#### 应用实例

考虑一个计算密集型的小函数`calculate`:

```c

inline double calculate(double x) {

return sqrt(x) + log(x);

}

```

编译器通过内联优化,可以避免函数调用的开销,同时提供更好的机会进行进一步的优化,比如在编译时进行常数折叠等。

### 4.5.3 案例研究:SIMD向量化优化

本案例将展示如何通过编译器的SIMD向量化优化来提升计算密集型程序的性能。

#### 应用实例

假设有一个处理大型数据集的数学函数`process_data`,可以使用SIMD指令集优化:

```c

void process_data(double *input, double *output, int n) {

for (int i = 0; i < n; i++) {

output[i] = sqrt(input[i]);

}

}

```

通过合适的编译器标志启用向量化:

```bash

gcc -O3 -msse4.2 -ftree-vectorize -funsafe-math-optimizations process_data.c -o process_data

```

这将启用SSE4.2指令集并尽可能地进行向量化。在支持SSE4.2的处理器上,这将显著加快循环的执行速度。

## 4.6 小结

在本章节中,我们介绍了并行编程模型、编译器优化技术以及性能分析工具的概念、应用和案例。我们通过分析具体实例,探讨了如何识别性能瓶颈,并展示了通过多线程、SIMD向量化以及编译器优化来提升程序性能的方法。此外,我们还讨论了性能调优流程和实际案例分析,以帮助读者更好地理解如何将理论知识应用到实际开发中。

# 5. 先进技术和未来趋势

## 5.1 新型处理器架构

随着传统处理器架构的性能逐渐接近物理极限,研究人员和工程师们正转向开发新型架构以继续推进计算能力。其中,光处理技术和量子计算是两个最具革命性的研究方向。

### 5.1.1 光处理技术

光学处理器使用光子代替电子进行信息的传递和处理,这在理论上可以大幅减少能量损失,并提高数据传输的速度。以下是一些关键点:

- **光互连**:利用光纤替代传统铜线,进行芯片间或板间的数据传输。

- **光学逻辑门**:使用光学器件实现逻辑运算,减少能耗,并提高运算速度。

- **集成技术**:研究如何将光学组件与电子组件集成在同一芯片上,以构建混合光电子处理系统。

### 5.1.2 量子计算与CPU设计

量子计算利用量子比特(qubits)的叠加和纠缠特性,解决特定计算问题的效率远高于传统计算机。它在特定任务上展现出巨大潜力,如:

- **量子位的稳定性**:如何在维持量子态的同时进行计算,是量子计算机研究的一个重要课题。

- **量子算法**:针对量子计算机开发的新算法,例如著名的Shor算法和Grover算法。

- **量子编程模型**:构建量子计算的编程模型和软件栈,使其更接近实用性。

## 5.2 优化工具与方法

CPU设计的优化不只局限于硬件本身,还包括软件工具和算法的创新。AI技术和自适应系统已经开始在这一领域发挥作用。

### 5.2.1 AI在CPU设计中的应用

人工智能正被用来优化CPU的设计流程,例如:

- **性能预测**:使用机器学习模型预测CPU设计的性能参数,从而辅助设计决策。

- **自动化设计**:通过强化学习等AI技术,自动寻找最佳的CPU设计配置。

- **故障检测与诊断**:利用深度学习模型,快速定位和修复设计中的问题。

### 5.2.2 自适应和自组织系统在CPU设计中的潜力

自适应系统能够根据运行环境动态调整其行为,而自组织系统则通过局部规则实现复杂全局行为。在CPU设计中,这些系统可以:

- **动态功耗管理**:根据当前负载和能效比,动态调整CPU的工作频率和电压。

- **故障容忍**:构建能够自我修复的CPU系统,在检测到错误时自动进行恢复。

- **性能优化**:利用自适应算法优化处理器内部资源的分配,以适应不同的工作负载。

## 5.3 跨学科创新

不同学科的结合推动了CPU设计技术的创新。生物启发计算和材料科学是其中两个前沿领域。

### 5.3.1 生物启发的计算模型

研究者受到自然界生物体的启发,开发了一系列计算模型,如:

- **神经网络模型**:受大脑神经网络启发,实现高效的信息处理。

- **基因算法**:利用遗传学原理,模拟自然选择过程,求解优化问题。

- **群体智能**:研究如蚁群、鸟群等群体行为,将群体智慧应用到计算任务中。

### 5.3.2 材料科学与CPU性能的提升

材料科学的进步为CPU性能的提升提供了新的可能性,例如:

- **先进半导体材料**:采用石墨烯、氮化镓等新型半导体材料替代传统的硅材料。

- **量子点和纳米线**:利用纳米技术制造更小、更快、更节能的电子器件。

- **自旋电子学**:开发基于电子自旋而非电荷的新型逻辑器件,减少能耗,提高性能。

通过借鉴自然界的原理和利用新材料,研究人员有望突破当前的技术瓶颈,为CPU设计带来革命性的变化。

0

0