【GPU加速】:在Python中使用TensorFlow的终极指南(实用型+稀缺性)

发布时间: 2024-12-06 22:39:08 阅读量: 43 订阅数: 11

为电脑配置GPU加速(win10+python3.6+tensorflow-gpu1.12.0)

# 1. TensorFlow和GPU加速简介

## 1.1 TensorFlow的起源和发展

TensorFlow,由Google Brain团队开发,是一个开源的机器学习框架。自2015年首次发布以来,它已经成为AI社区中的主流工具之一。TensorFlow以其灵活性和可扩展性,以及丰富的API和社区支持,在处理大规模数据集和复杂模型时表现出色。

## 1.2 GPU加速的重要性

随着深度学习技术的发展,模型复杂度和数据量不断增长,对计算资源的需求急剧增加。图形处理单元(GPU)凭借其并行计算能力,在执行矩阵运算和提升计算效率方面,相较于CPU拥有明显优势。GPU加速已经成为现代AI和深度学习研究不可或缺的一部分。

## 1.3 TensorFlow与GPU的结合

TensorFlow充分利用GPU的强大计算能力,为研究人员和开发者提供了高效的深度学习解决方案。使用GPU加速,不仅能够显著减少模型训练和推理的时间,还可以支持更大规模的神经网络,从而推动了AI应用的快速发展和创新。接下来的章节将详细探讨TensorFlow的安装、配置以及如何与GPU结合进行加速计算。

# 2. TensorFlow的安装和配置

## 2.1 TensorFlow的安装

### 2.1.1 CPU版本TensorFlow的安装

安装TensorFlow的CPU版本较为简单,因为大多数现代操作系统都支持必要的依赖。在本章节中,我们将详细介绍如何在不同操作系统上安装TensorFlow CPU版本,并给出解决常见问题的建议。

在Linux系统中,可以通过Python的包管理器pip来安装TensorFlow。通常,我们建议创建并激活一个虚拟环境来隔离安装的包。以下是通过Python虚拟环境安装TensorFlow CPU版本的步骤:

```bash

# 创建并激活虚拟环境

python3 -m venv tf_cpu_env

source tf_cpu_env/bin/activate # 在Unix或MacOS上

tf_cpu_env\Scripts\activate # 在Windows上

# 安装TensorFlow CPU版本

pip install tensorflow

```

安装完成后,可以运行下面的代码来验证TensorFlow是否安装成功:

```python

import tensorflow as tf

print(tf.__version__)

```

如果输出了TensorFlow的版本号,则表示安装成功。

安装过程中可能会遇到一些问题,例如权限错误或依赖问题。如果遇到权限错误,建议使用`--user`参数以用户模式安装TensorFlow,例如`pip install tensorflow --user`。依赖问题通常可以通过更新pip到最新版本来解决。

### 2.1.2 GPU版本TensorFlow的安装

对于希望利用GPU进行深度学习计算的用户,GPU版本的TensorFlow是必须的。在安装GPU版本之前,需要确保已经正确安装了CUDA和cuDNN,并且它们与所选择的TensorFlow版本兼容。以下是安装TensorFlow GPU版本的步骤:

```bash

# 假设CUDA和cuDNN已经安装并配置好环境变量

# 创建并激活虚拟环境

python3 -m venv tf_gpu_env

source tf_gpu_env/bin/activate # 在Unix或MacOS上

tf_gpu_env\Scripts\activate # 在Windows上

# 安装TensorFlow GPU版本

pip install tensorflow-gpu

```

安装完成后,需要验证安装的TensorFlow是否能够正确地使用GPU:

```python

import tensorflow as tf

# 检查可用设备

print(tf.config.list_physical_devices('GPU'))

```

如果系统输出了GPU设备列表,则意味着TensorFlow已经能够使用GPU进行计算。

安装TensorFlow GPU版本时,需要注意CUDA和cuDNN的版本与TensorFlow版本的兼容性。通常,TensorFlow会指定支持的CUDA和cuDNN版本范围。当下载和安装CUDA及cuDNN时,应确保下载的版本与TensorFlow官方文档推荐的版本一致。

## 2.2 TensorFlow的环境配置

### 2.2.1 CUDA和cuDNN的安装

CUDA是NVIDIA的并行计算平台和编程模型,允许开发者使用NVIDIA的GPU进行通用计算。cuDNN是专门为深度神经网络设计的GPU加速库。在本小节中,我们将介绍如何在不同操作系统上安装CUDA和cuDNN。

在Linux系统上,NVIDIA官方提供了.run安装文件。以下是在Linux系统上安装CUDA和cuDNN的步骤:

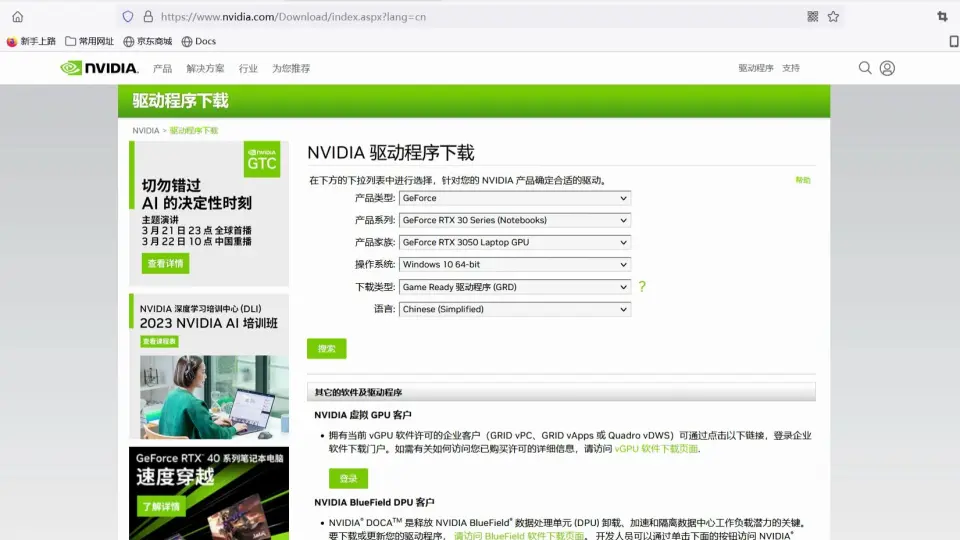

1. 访问NVIDIA官方网站下载CUDA Toolkit和cuDNN的相应版本。

2. 运行下载的.run文件,并按照提示进行安装。安装过程中可能会要求接受许可协议,并指定安装路径。

3. 更新环境变量,使系统能够识别CUDA和cuDNN。

```bash

# 更新.bashrc或.zshrc文件,添加以下内容

export LD_LIBRARY_PATH="$LD_LIBRARY_PATH:/usr/local/cuda/lib64:/usr/local/cuda/extras/CUPTI/lib64"

export PATH="$PATH:/usr/local/cuda/bin"

```

安装完成后,应检查CUDA和cuDNN是否正确安装:

```bash

# 检查CUDA版本

nvcc --version

# 检查cuDNN版本

cat /usr/local/cuda/include/cudnn.h | grep CUDNN_MAJOR -A 2

```

在Windows系统上,通常需要下载.exe安装程序,并通过图形化界面完成安装。CUDA安装程序会自动更新环境变量,但是安装完成后,仍需要手动重启计算机以确保环境变量正确设置。

### 2.2.2 TensorFlow的GPU支持验证

安装完TensorFlow及其依赖后,验证TensorFlow能否使用GPU是非常重要的步骤。可以通过查看TensorFlow是否能够识别到GPU设备来验证:

```python

import tensorflow as tf

# 检查可用设备

gpus = tf.config.list_physical_devices('GPU')

if gpus:

try:

# 设置第0个GPU为默认设备

tf.config.set_visible_devices(gpus[0], 'GPU')

logical_gpus = tf.config.list_logical_devices('GPU')

print(f"{len(gpus)} Physical GPU(s) and {len(logical_gpus)} Logical GPU(s)")

except RuntimeError as e:

print(e)

else:

print("No GPU found")

```

如果上述代码运行后输出了逻辑GPU的数量,则表示TensorFlow已经能够使用GPU。

通过本章节的介绍,我们了解了如何在不同的操作系统上安装TensorFlow,以及如何配置环境以利用GPU加速。接下来,我们将深入探讨GPU加速的理论基础,并了解如何在TensorFlow中操作GPU。

# 3. 理解GPU加速

## 3.1 GPU加速的理论基础

### 3.1.1 CPU和GPU的结构差异

在开始深度了解GPU加速之前,理解CPU(中央处理器)和GPU(图形处理器)的基本结构差异至关重要。CPU通常由少量的核心组成,每个核心都能够处理一系列复杂任务,因此它更适合执行复杂算法和顺序执行的任务。CPU的设计强调了强大的单线程性能,以及高速缓存和复杂的控制逻辑来处理不同的任务。

与之相对的,GPU拥有数百个更简单的处理核心,它们可以并行处理成千上万的数据点。GPU核心设计上用于处理图形渲染任务,但同样适用于其他可以并行化的计算任务,比如机器学习模型的训练和执行。GPU由于拥有大量的并行处理单元,它在执行大量相似计算时表现突出。

### 3.1.2 GPU加速的优势和适用场景

GPU加速指的是利用GPU强大的并行处理能力来加速应用程序的执行。与传统的CPU相比,GPU在执行可以并行化的计算密集型任务时,能够提供显著的性能提升。GPU加速的优势主要体现在以下几个方面:

1. **大量并行操作**:数据并行处理,对于需要处理大规模数据集的算法,比如机器学习和深度学习的训练,GPU能够显著提高运算速度。

2. **高吞吐量**:在同时执行成百上千个计算线程时,GPU能够保持高吞吐量。

3. **能量效率**:虽然单个GPU核心的性能可能不如CPU核心,但GPU的高核心数量能够实现更高的能效比。

GPU加速适用于多个领域,其中最典型的是深度学习和科学计算领域。机器学习模型训练、大数据分析、模拟和渲染等领域都可以通过GPU加速获得显著的性能提升。因此,随着人工智能的快速发展,GPU加速已经成为许多企业和研究机构计算能力的关键部分。

## 3.2 TensorFlow中的GPU操作

### 3.2.1 TensorFlow中的GPU节点

在TensorFlow中,GPU节点是那些需要在GPU硬件上执行的计算单元。TensorFlow利用NVIDIA的CUDA(Compute Unified Device Architecture)平台进行GPU编程,因此要求在运行TensorFlow应用之前,系统需要正确安装并配置CUDA环境。

要在TensorFlow中使用GPU节点,首先需要创建一个TensorFlow操作(Op),然后指定该操作要在GPU上执行。以下是一个基本的TensorFlow GPU节点的示例代码:

```python

import tensorflow as tf

# 创建两个常量节点并指明在GPU上执行

with tf.device('/gpu:0'):

a = tf.constant([1.0, 2.0, 3.0, 4.0, 5.0, 6.0], shape=[2, 3], name='a')

b = tf.constant([1.0, 2.0, 3.0, 4.0, 5.0, 6.0], shape=[3, 2], name='b')

c = tf.matmul(a, b)

# 运行session并评估结果

with tf.Session(config=tf.ConfigProto(log_device_placement=True)) as sess:

print(sess.run(c))

```

在这段代码中,`tf.device('/gpu:0')`指明了后续操作应运行在编号为0的GPU上。`tf.matmul(a, b)`是一个矩阵乘法操作,它在TensorFlow中默认会被分配到GPU上执行,前提是当前系统已经正确配置了GPU和CUDA环境。

### 3.2.2 GPU内存管理和优化

当运行大规模的深度学习模型时,GPU内存的管理就变得至关重要。在TensorFlow中,管理GPU内存涉及到多个方面,包括了解如何初始化GPU内存、如何配置内存增长,以及如何避免潜在的内存泄漏问题。

1. **初始化GPU内存**:TensorFlow允许开发者在创建session时预分配GPU内存,这通过传递一个配置对象给`tf.Session()`来完成。例如,使用`tf.ConfigProto`并设置`allow_soft_placement`为`True`可以在GPU内存不足时自动回退到CPU。

2. **配置内存增长**:TensorFlow提供了`tf.contrib.factorization.GPUOptions`,其中的`per_process_gpu_memory_fraction`选项可以用来限制分配给TensorFlow的GPU内存比例,从而避免超出GPU内存限制。

3. **避免内存泄漏**:内存泄漏是GPU加速应用中常见的问题。通常,避免内存泄漏需要仔细监控并管理GPU内存的分配和释放。TensorFlow提供了一些工具和方法来帮助调试和诊断内存泄漏问题,例如使用`tf_debug`工具。

通过上述方法,开发者可以更好地管理GPU内存,优化资源使用,避免因内存不足而导致的程序崩溃问题。

## 3.3 实际应用案例

### 3.3.1 实际应用案例展示

一个具体的实际应用案例是使用TensorFlow进行图像识别。利用卷积神经网络(CNN)对大规模图像数据集进行训练和验证时,GPU加速可以显著缩短训练时间。以下是一个简化的流程,展示了如何应用GPU加速进行图像识别训练:

1. **准备数据集**:选择一个大型的图像数据集,如ImageNet,加载数据到内存中,并对数据进行预处理,如归一化和大小调整。

2. **设计CNN模型**:设计一个卷积神经网络架构,包括多个卷积层、池化层和全连接层。

3. **设置GPU训练**:指定模型中哪些层在GPU上运行。在TensorFlow中,可以使用`tf.device('/gpu:0')`语句来明确指定。

4. **训练模型**:在GPU上执行训练过程,持续调整权重直到模型在验证集上的表现达到满意的准确度。

5. **评估模型性能**:使用测试集评估模型的性能。确保在不同的数据子集上验证模型的泛化能力。

### 3.3.2 解决方案和经验分享

在实际应用中,GPU加速并不总是可以达到预期效果,可能因各种问题遇到性能瓶颈。解决这些问题通常需要仔细监控和调试。以下是一些解决方案和经验分享:

1. **性能监控**:使用TensorFlow提供的性能分析工具,如`tf.profiler`,来监控训练过程中的性能瓶颈。确保所有GPU资源都被充分利用,并检查是否有计算密集型操作限制了性能。

2. **模型优化**:在设计CNN模型时,考虑使用更高效的层结构和操作,比如使用深度可分离卷积代替标准卷积层,以减少计算量和内存需求。

3. **避免过拟合**:在GPU加速训练时,模型很容易过拟合。使用正则化技术和数据增强方法可以提高模型的泛化能力。

4. **并行化策略**:当处理多个独立任务时,可以考虑使用TensorFlow的分布式策略,通过并行化多个GPU来进一步提升训练速度。

以上介绍了理论基础、TensorFlow中GPU的操作方法以及实际应用案例,接下来将深入探讨如何在实践中有效地应用GPU加速来提升深度学习模型的训练性能。

# 4. TensorFlow的GPU实践

## 4.1 GPU加速的数据处理

### 4.1.1 使用GPU进行数据预处理

在深度学习的训练过程中,数据预处理是非常重要的一环。由于数据预处理往往涉及大量的计算和数据移动,使用CPU处理这部分工作会导致训练过程的瓶颈。而通过GPU加速数据预处理,可以显著提高效率,缩短模型训练的准备时间。

在TensorFlow中,可以利用GPU来执行数据预处理的操作,这通常通过tf.data API来实现。tf.data API允许我们以可扩展、可重用的方式构建高效的数据管道。以下是一个使用GPU进行数据预处理的示例代码块:

```python

import tensorflow as tf

def preprocess_image(image, label):

# 这里假设有图像预处理的操作,例如归一化、大小调整等

image = tf.image.resize(image, [224, 224]) / 255.0

return image, label

# 创建一个tf.data.Dataset对象

dataset = tf.data.Dataset.from_tensor_slices((images, labels))

dataset = dataset.map(preprocess_image, num_parallel_calls=tf.data.experimental.AUTOTUNE)

dataset = dataset.batch(32)

dataset = dataset.prefetch(tf.data.experimental.AUTOTUNE)

# 使用dataset来训练模型

for epoch in range(num_epochs):

for step, (batch_x, batch_y) in enumerate(dataset):

# 训练过程

pass

```

在这个例子中,`preprocess_image`函数定义了如何对单个图像及其标签进行预处理。使用`map`函数将此预处理函数应用于数据集中的每个元素,并利用`num_parallel_calls=tf.data.experimental.AUTOTUNE`参数来自动调整并行调用的数量,以充分利用GPU资源。

### 4.1.2 实现数据管道的GPU加速

为了进一步优化数据处理流程,TensorFlow提供了`tf.data.experimental.prefetch_to_device`工具,它可以让数据预加载到GPU内存中,以减少GPU因等待CPU数据加载而空闲的情况。这一点对于GPU加速尤为重要,因为数据传输往往是造成延迟的关键因素。

```python

dataset = tf.data.Dataset.from_tensor_slices((images, labels))

dataset = dataset.map(preprocess_image, num_parallel_calls=tf.data.experimental.AUTOTUNE)

dataset = dataset.batch(32)

dataset = dataset.prefetch_to_device("/device:GPU:0", buffer_size=4)

```

通过这种方式,数据管道可以更加流畅地在CPU和GPU之间进行数据的传输和预处理。`buffer_size`参数指定了预取的缓冲区大小,它应该根据系统的内存大小进行调整。

## 4.2 GPU加速的模型训练

### 4.2.1 理解TensorFlow的GPU训练过程

在GPU训练过程中,模型的计算图会在GPU上执行,而计算图是由一系列节点组成的,每个节点表示一个操作(op)。当一个操作需要在GPU上执行时,TensorFlow会自动将该操作及其依赖的输入数据移动到GPU内存中。一旦数据和操作都位于同一个设备上,它们就可以高效地并行执行。

TensorFlow通过定义计算设备的抽象层来管理资源,使得开发者无需直接管理底层的内存和执行细节。以下是一个简单的模型训练代码片段:

```python

with tf.device('/device:GPU:0'):

# 定义模型结构

model = tf.keras.models.Sequential([

tf.keras.layers.Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=(224, 224, 3)),

tf.keras.layers.MaxPooling2D(pool_size=(2, 2)),

# ...更多层...

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(10, activation='softmax')

])

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 使用GPU训练模型

model.fit(dataset, epochs=num_epochs)

```

在这个代码片段中,`tf.device('/device:GPU:0')`上下文管理器确保了所有在此块中定义的操作和数据移动都会被导向指定的GPU设备。模型的定义、编译以及后续的训练过程都在GPU上进行。

### 4.2.2 优化GPU训练性能的策略

为了提高GPU训练的性能,可以采取多种策略。首先,合理选择批次大小是关键,因为这会影响GPU内存的使用和训练效率。其次,可以采用梯度累积的方法,将小批次的数据多次累加,从而达到一个较大批次的效果,这在内存有限的情况下尤为有用。

```python

# 梯度累积示例

累积梯度 = 0

累积次数 = 4

for step, (batch_x, batch_y) in enumerate(dataset):

with tf.GradientTape() as tape:

predictions = model(batch_x, training=True)

loss_value = loss_function(batch_y, predictions)

# 累积梯度

gradients = tape.gradient(loss_value, model.trainable_variables)

for g in gradients:

g *= 1 / 累积次数 # 在这里除以累积次数

累积梯度 = [a + b for a, b in zip(累积梯度, gradients)]

# 当累积次数达到后,进行优化器步骤

if (step + 1) % 累积次数 == 0:

optimizer.apply_gradients(zip(累积梯度, model.trainable_variables))

累积梯度 = [tf.zeros_like(g) for g in model.trainable_variables] # 清空累积梯度

# 注意:梯度累积会影响学习率,可能需要相应调整

```

此外,还可以采取减少CPU到GPU的数据传输次数、使用预训练模型和参数冻结等策略。在实际应用中,这些策略可以组合使用,根据具体的训练需求和硬件环境进行调整。

## 4.3 实例分析:深度学习模型的GPU加速

### 4.3.1 分类模型的GPU加速

为了演示如何在实际的深度学习任务中应用GPU加速,我们可以选择一个分类任务来作为示例。以下是一个简单的图像分类任务,使用的是TensorFlow内置的MNIST数据集:

```python

import tensorflow as tf

from tensorflow.keras.datasets import mnist

from tensorflow.keras import layers, models

# 加载数据集

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()

train_images = train_images.reshape((60000, 28, 28, 1)).astype('float32') / 255

test_images = test_images.reshape((10000, 28, 28, 1)).astype('float32') / 255

# 训练GPU加速的模型

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10, activation='softmax'))

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

model.fit(train_images, train_labels, epochs=5, batch_size=64)

```

在这个例子中,我们使用了三个卷积层来构建一个简单的卷积神经网络(CNN),并通过`model.fit`方法使用GPU来加速整个训练过程。

### 4.3.2 生成模型的GPU加速

生成对抗网络(GAN)是一种更为复杂的深度学习模型,它包括生成器和判别器两个部分,训练过程更为复杂。然而,即使在如此复杂的模型中,GPU加速依旧是提升性能的关键。

```python

# GAN的生成器模型示例

from tensorflow.keras import layers

def build_generator(z_dim):

model = models.Sequential()

model.add(layers.Dense(256, input_dim=z_dim))

model.add(layers.LeakyReLU(alpha=0.01))

model.add(layers.Dense(512))

model.add(layers.LeakyReLU(alpha=0.01))

model.add(layers.Dense(1024))

model.add(layers.LeakyReLU(alpha=0.01))

model.add(layers.Dense(28 * 28 * 1, activation='tanh'))

model.add(layers.Reshape((28, 28, 1)))

return model

# GAN的判别器模型示例

def build_discriminator(img_shape):

model = models.Sequential()

model.add(layers.Flatten(input_shape=img_shape))

model.add(layers.Dense(512))

model.add(layers.LeakyReLU(alpha=0.01))

model.add(layers.Dense(256))

model.add(layers.LeakyReLU(alpha=0.01))

model.add(layers.Dense(1, activation='sigmoid'))

return model

# 这里省略了训练GAN的代码

```

在这个GAN的例子中,生成器和判别器都是需要大量计算的深度神经网络。通过GPU加速,可以在合理的时间内完成模型的训练过程。

本章节通过理论和实践相结合的方式,介绍了如何在TensorFlow中利用GPU进行数据处理和模型训练,以实现深度学习任务的高效加速。下一章节将深入探讨TensorFlow在多GPU和分布式GPU训练方面的应用,以及如何进行性能的进一步优化。

# 5. TensorFlow GPU加速的进阶应用

## 5.1 多GPU和分布式GPU训练

### 5.1.1 多GPU训练的基本概念

多GPU训练是利用多块GPU同时处理计算任务,以提升模型训练速度和吞吐量。在TensorFlow中,可以通过创建多个计算设备来实现多GPU训练。实践中,多GPU训练可以是单机多卡或跨多台机器的多卡训练。

在单机多GPU训练中,我们需要定义一个策略(如MirroredStrategy),它将计算任务镜像到所有可用的GPU上,确保每个GPU处理任务的一致性。而分布式训练则涉及到更复杂的网络通信和数据同步问题,需要在多个节点之间分配计算任务。

### 5.1.2 分布式GPU训练的实现

分布式GPU训练要求对TensorFlow的分布式计算架构有更深刻的理解。在分布式训练中,需要设置一个主节点(Chief)和多个工作节点(Worker)。Chief负责整体的协调工作,而Worker则执行计算任务。TensorFlow提供了tf.distribute.Strategy API来简化分布式训练的设置。

```python

import tensorflow as tf

strategy = tf.distribute.MirroredStrategy()

with strategy.scope():

# 在分布式策略的作用域内定义模型

model = tf.keras.Sequential([...])

model.compile(loss=tf.keras.losses.SparseCategoricalCrossentropy(),

optimizer=tf.keras.optimizers.Adam(),

metrics=['accuracy'])

```

在上述代码块中,通过`tf.distribute.MirroredStrategy()`定义了一个分布式策略,并在该策略的作用域内创建和编译了模型。这种策略会自动镜像模型到所有可用的GPU,并处理梯度同步和参数更新。

## 5.2 高级性能调优

### 5.2.1 性能监控工具的使用

为了进行有效的性能调优,我们需要使用一些性能监控工具。TensorFlow提供了内置的性能分析工具tf.keras.callback.TensorBoard,它能够记录训练过程中的各种数据,并在TensorBoard可视化界面中展示。

```python

tensorboard_callback = tf.keras.callbacks.TensorBoard(log_dir='./logs',

histogram_freq=1,

write_graph=True,

write_grads=True,

update_freq='epoch',

profile_batch='5,10')

model.fit(train_dataset, epochs=10, callbacks=[tensorboard_callback])

```

上述代码块展示了如何在训练过程中添加TensorBoard回调,以便记录日志和监控性能。通过配置不同的参数,可以控制TensorBoard记录的数据类型和频率,例如`histogram_freq`用于控制直方图更新的间隔,`profile_batch`用于指定进行性能分析的批次。

### 5.2.2 延迟和吞吐量优化技巧

延迟和吞吐量是衡量训练效率的重要指标。要优化它们,需要理解模型的瓶颈所在,可能涉及到数据输入、计算效率或硬件资源的限制。

1. **减少数据预处理时间:** 使用多进程技术来预处理数据,确保数据加载不会成为瓶颈。

2. **计算优化:** 使用更高效的模型结构或算法,例如使用轻量级模型或减少不必要的计算。

3. **硬件利用:** 充分利用GPU的内存和计算资源,如合理设置批量大小(batch size)和学习率。

4. **避免GPU计算空闲:** 使用适当的并行化和批处理技术,尽量避免GPU的计算单元空闲。

5. **减少CPU到GPU的数据传输:** 优化数据格式和传输方式,减少内存拷贝操作。

在实践中,可以使用tf.data API创建高效的数据管道,并利用TensorFlow Profiler来分析模型的执行时间和资源占用情况,进而找到性能瓶颈并进行针对性优化。

```python

# 示例代码:使用tf.data API优化数据管道

train_dataset = tf.data.Dataset.from_tensor_slices((train_images, train_labels)).shuffle(buffer_size=10000).batch(32)

model.fit(train_dataset, epochs=10)

```

本章节介绍了TensorFlow中多GPU和分布式GPU训练的基本概念和实现方法,以及性能监控工具的使用和优化技巧,旨在帮助读者深入理解并应用这些高级特性以提升GPU训练的效率和效果。

# 6. 案例研究与未来展望

在第六章中,我们将深入探讨TensorFlow GPU加速的实例应用,分析成功的案例,并预测其未来的发展趋势。通过真实世界的应用场景,我们可以更直观地了解GPU加速技术如何帮助解决实际问题,并提炼出有益的经验分享。此外,本章也会对GPU加速技术的未来发展进行展望,包含新硬件特性、社区和生态系统的发展等方面。

## 6.1 TensorFlow GPU加速成功案例分析

在实际应用中,TensorFlow的GPU加速已经为许多企业和研究机构带来了显著的性能提升。让我们一起分析几个成功的案例。

### 6.1.1 实际应用案例展示

**案例一:大规模图像识别系统**

在这个案例中,一家大型的互联网公司利用TensorFlow的GPU加速来提升图像识别系统的性能。通过在GPU集群上运行多个模型,他们能够处理每天数十亿张的图片数据,并且大幅度缩短了训练时间。

代码示例:

```python

import tensorflow as tf

# 假设我们有一个简单的模型定义

def build_model():

model = tf.keras.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(224, 224, 3)),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(10, activation='softmax')

])

return model

# 构建并编译模型

model = build_model()

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 假设我们加载了大规模数据集

# (train_images, train_labels), (test_images, test_labels) = load_dataset()

# 使用GPU进行模型训练

with tf.device('/GPU:0'):

model.fit(train_images, train_labels, epochs=10)

```

在这个案例中,通过使用`tf.device('/GPU:0')`,我们指定了模型训练应该在GPU上执行。这将大幅提高训练效率。

**案例二:实时语言翻译服务**

一个全球知名的科技公司需要在他们的即时通讯软件中提供实时语言翻译服务。为了达到实时翻译的要求,他们采用TensorFlow的GPU加速功能,实现了快速的模型推断和翻译过程。

代码示例:

```python

# 加载预先训练好的翻译模型

translator_model = tf.saved_model.load('/path/to/model')

@tf.function(input_signature=[tf.TensorSpec([None], tf.string)])

def translate_TEXT(text_input):

result = translator_model.signatures["serving_default"](text_input)

return result

# 假设我们有一个翻译函数来处理输入文本

def translate(text):

# 使用GPU进行翻译处理

with tf.device('/GPU:0'):

return translate_TEXT([text])

# 使用翻译函数

translated_text = translate('Hello TensorFlow!')

```

在此代码段中,`translate_TEXT`函数使用TensorFlow的`@tf.function`装饰器被编译成一个高效的执行图。当调用`translate`函数进行实时翻译时,我们指定在GPU上执行此操作。

### 6.1.2 解决方案和经验分享

从上面的案例中,我们可以提取一些有价值的经验和解决方案:

- **优化数据管道**:确保数据预处理、加载和处理都能够充分利用GPU的能力。这可能包括使用多线程或异步IO来减少GPU的空闲时间。

- **模型并行化和分布式训练**:当单个GPU无法满足需求时,可以使用多GPU并行化训练模型。同时,利用分布式训练可以进一步扩展计算能力。

- **监控和调试**:在GPU加速应用中,监控和调试是不可或缺的。使用TensorFlow Profiler和NVIDIA的Nsight工具可以帮助开发者理解GPU的使用情况并找到瓶颈。

## 6.2 TensorFlow GPU加速的未来趋势

随着硬件技术的不断进步和软件生态系统的持续优化,TensorFlow GPU加速技术未来的发展趋势令人期待。

### 6.2.1 新硬件和新特性展望

随着新一代GPU的推出,TensorFlow的性能将继续得到提升。例如,NVIDIA的Ampere架构GPU提供了更高的计算能力和新的特性,如Tensor Cores和结构化稀疏性加速。此外,Google的TPU(Tensor Processing Unit)也为深度学习提供了专用硬件加速。

### 6.2.2 社区和生态系统的持续发展

TensorFlow社区正在不断壮大,新的库、工具和功能被不断推出。例如,TF Extended (TFX)提供了端到端的机器学习平台,而TF Hub为研究人员和开发者提供了大量可复用的模型组件。社区的贡献和持续的创新将推动TensorFlow及其GPU加速功能继续向前发展。

在这一章中,我们通过实际案例展示了TensorFlow GPU加速的强大能力,同时也展望了其未来的发展。下一章将介绍如何在项目中有效地使用TensorFlow进行GPU加速,并提供一些实用技巧。

0

0