Python test库:构建完美测试用例的4大高级技巧

发布时间: 2024-10-14 12:35:14 阅读量: 31 订阅数: 25

python自动化之-项目测试用例设计+读取Excel测试用例-代码

# 1. Python测试库概述

Python作为一种广泛使用的编程语言,其在软件测试领域的应用同样日益增多。测试库提供了丰富的工具和接口,帮助测试人员更高效地执行测试任务。在Python的世界中,有一些主流的测试库被频繁使用,包括`unittest`、`pytest`和`nose2`等。这些库不仅支持基本的测试用例编写,还提供了强大的扩展功能,如参数化测试、测试固件管理、测试报告生成等。

`unittest`是Python标准库的一部分,它提供了一套完整的单元测试框架。`pytest`是一个第三方库,以其简洁的语法和强大的功能受到开发者的青睐。`nose2`则是`nose`的继任者,提供了更多的测试发现和运行特性。

在本章中,我们将对这些库进行简要介绍,并讨论它们的基本使用方法和优势。通过对比它们的特点,我们可以更好地理解如何选择合适的库来满足不同的测试需求。

# 2. 测试用例设计原则

在软件测试过程中,设计良好的测试用例是保证软件质量和性能的关键。本章节将深入探讨测试用例设计的原则,包括基本要素、数据设计以及组织和管理等方面,旨在帮助测试工程师构建有效的测试策略。

## 2.1 测试用例的基本要素

### 2.1.1 测试用例的结构

测试用例是软件测试的基本单元,它由一系列的步骤、输入、预期结果和实际结果组成。一个标准的测试用例通常包含以下要素:

- **测试用例标识符**:唯一标识一个测试用例的编号或名称。

- **测试用例描述**:对测试用例的简要说明,包括测试目的和测试范围。

- **前置条件**:执行测试用例之前需要满足的条件。

- **测试步骤**:执行测试用例的具体步骤。

- **输入数据**:在执行测试步骤时需要使用的数据。

- **预期结果**:测试步骤执行后所期望的结果。

- **实际结果**:测试步骤执行后实际获得的结果。

- **测试环境**:执行测试用例时的软硬件环境。

- **测试数据**:与测试用例相关的数据集合,如测试数据库、配置文件等。

测试用例的结构设计应简洁明了,便于理解和执行。下面是一个简单的测试用例示例:

```markdown

### 测试用例标识符:TC001

### 测试用例描述:验证用户登录功能

#### 前置条件:用户已注册,且处于未登录状态

#### 测试步骤:

1. 打开登录页面

2. 输入用户名:testuser

3. 输入密码:test123

4. 点击登录按钮

#### 预期结果:登录成功,跳转到主页

#### 实际结果:待执行测试后填写

#### 测试环境:浏览器Chrome,操作系统Windows 10

```

### 2.1.2 测试用例的编写准则

编写测试用例时,应遵循以下准则以确保其有效性:

- **具体性**:测试步骤和预期结果应详细明确,避免模糊不清的描述。

- **可重复性**:任何测试人员都应能够根据测试用例的描述重复相同的测试步骤。

- **独立性**:每个测试用例应独立于其他测试用例,不应依赖于特定的测试环境或前置条件。

- **可验证性**:预期结果应当是可验证的,即可以通过自动化的工具或手动检查来确认测试结果的正确性。

- **完整性**:测试用例应覆盖所有相关的功能和边界条件。

## 2.2 测试数据的设计

### 2.2.1 数据驱动测试的原理

数据驱动测试(Data-Driven Testing, DDT)是一种测试方法,它将测试输入和预期结果分离出来,存储在外部数据源中。这样做的好处是:

- **提高测试效率**:通过重用相同的测试逻辑,只需编写一次测试脚本。

- **增强可维护性**:当输入数据变更时,无需修改测试脚本,只需更新数据源。

- **支持复杂测试场景**:可以轻松处理大量数据和复杂的数据组合。

数据驱动测试的原理可以简单概括为:

1. **分离测试逻辑和数据**:将测试逻辑(测试步骤)与测试数据(输入数据和预期结果)分离。

2. **存储数据**:将测试数据存储在外部数据源中,如Excel、数据库或CSV文件。

3. **参数化测试脚本**:在测试脚本中使用参数来引用外部数据源中的数据。

4. **执行测试**:遍历数据源中的每一行数据,使用参数化的测试脚本执行测试。

### 2.2.2 测试数据生成技术

测试数据的生成是数据驱动测试中的关键环节,常见的测试数据生成技术包括:

- **随机生成**:使用随机数生成器产生测试数据,适用于测试边界值和异常值。

- **组合生成**:从预定义的数据集中选择不同的组合,用于测试数据的有效性和无效组合。

- **规则生成**:根据业务规则或算法生成测试数据,确保数据的业务逻辑正确性。

- **真实数据复制**:从生产环境中复制真实用户数据,用于回归测试或性能测试。

## 2.3 测试用例的组织和管理

### 2.3.1 测试套件的构建

测试套件是一组相关的测试用例的集合,它可以组织为一个或多个测试类。构建测试套件的目的在于:

- **分类管理**:将功能相似的测试用例归类在一起,便于管理和执行。

- **批量执行**:可以一次性执行整个测试套件,提高测试效率。

- **报告生成**:生成统一的测试报告,方便查看和分析测试结果。

在Python中,使用unittest库构建测试套件的示例代码如下:

```python

import unittest

# 定义测试类

class TestLogin(unittest.TestCase):

# 定义测试用例

def test_valid_login(self):

# 测试逻辑

pass

def test_invalid_login(self):

# 测试逻辑

pass

# 定义另一个测试类

class TestRegistration(unittest.TestCase):

# 测试逻辑

def test_valid_registration(self):

pass

# 构建测试套件

def suite():

test_suite = unittest.TestSuite()

test_suite.addTest(unittest.makeSuite(TestLogin))

test_suite.addTest(unittest.makeSuite(TestRegistration))

return test_suite

if __name__ == "__main__":

runner = unittest.TextTestRunner()

runner.run(suite())

```

### 2.3.2 测试报告和日志记录

测试报告和日志记录是测试过程中的重要组成部分,它们为测试结果提供了详细的记录和分析。

- **测试报告**:通常包括测试概览、通过/失败的测试用例、测试覆盖率、执行时间等信息。

- **日志记录**:记录测试过程中的详细信息,如测试步骤的执行、错误信息、日志级别等。

使用unittest库,可以生成简单的测试报告和日志记录,示例代码如下:

```python

import unittest

class TestLogin(unittest.TestCase):

def test_login_success(self):

print("Login successful")

def test_login_failure(self):

print("Login failed")

# 定义测试套件

def suite():

test_suite = unittest.TestSuite()

test_suite.addTest(unittest.makeSuite(TestLogin))

return test_suite

if __name__ == "__main__":

# 设置日志级别和格式

unittest.main(level='INFO', verbosity=2)

```

在本章节中,我们介绍了测试用例设计的基本原则,包括测试用例的结构、测试数据的设计以及测试用例的组织和管理。通过理解这些原则和实践方法,测试工程师可以更有效地设计和执行测试用例,从而提高软件测试的质量和效率。

# 3. 测试用例的高级技巧

在本章节中,我们将深入探讨如何提升测试用例的质量和效率,通过高级技巧来增强我们的测试策略。我们将首先介绍参数化测试的概念和实现方法,然后探讨模块化和可重用性的重要性,最后讲解异常处理在测试中的应用。

#### 3.1 参数化测试

参数化测试是一种提高测试用例可维护性和复用性的技术,它允许我们用不同的输入数据多次执行同一个测试逻辑。

##### 3.1.1 参数化测试的原理

参数化测试的核心思想是将测试数据从测试逻辑中分离出来,通过参数的形式传递给测试函数。这样做的好处是可以用一套测试逻辑来验证多种情况,从而减少重复代码,提高测试覆盖率。

##### 3.1.2 使用unittest库进行参数化

在Python的`unittest`框架中,可以使用`unittest.TestCase`类的`subTest`方法来进行参数化测试。下面是一个简单的例子:

```python

import unittest

class TestParameterized(unittest.TestCase):

def test_example(self):

data = [(1, 2, 3), (4, 5, 9), (7, 8, 15)]

for a, b, expected in data:

with self.subTest(a=a, b=b):

self.assertEqual(a + b, expected)

if __name__ == '__main__':

unittest.main()

```

在这个例子中,我们定义了一个`test_example`方法,它使用了一个包含多个元组的列表,每个元组代表一组输入值和预期的输出。通过`subTest`方法,我们可以为每组数据运行一次测试,如果任何一组数据失败了,`unittest`会报告失败的子测试。

##### 3.1.3 使用pytest进行参数化

`pytest`是一个非常强大的Python测试框架,它提供了内建的参数化功能。下面是如何使用`pytest`进行参数化的例子:

```python

import pytest

@pytest.mark.parametrize("a,b,expected", [

(1, 2, 3),

(4, 5, 9),

(7, 8, 15)

])

def test_addition(a, b, expected):

assert a + b == expected

```

在这个例子中,`pytest.mark.parametrize`装饰器用于定义测试函数`test_addition`的参数化数据。我们可以看到,代码的可读性和简洁性都得到了提升。

#### 3.2 模块化和可重用性

模块化和可重用性是软件开发中的重要概念,它们同样适用于测试用例的设计。

##### 3.2.1 模块化的概念和优势

模块化是指将一个复杂系统分解成多个模块,每个模块负责系统的一部分功能。在测试用例设计中,模块化可以帮助我们组织和管理测试代码,使其更加清晰和易于维护。

##### 3.2.2 测试函数的模块化策略

测试函数的模块化通常涉及到将相关的测试逻辑封装在一个函数中,并确保该函数能够独立运行。例如:

```python

def test_validate_user_input():

# 测试逻辑

pass

```

这样的模块化策略有助于我们在不同的测试场景中重用测试逻辑,提高代码的复用率。

##### 3.2.3 测试类的重用方法

测试类的重用涉及到创建可以被多个测试共享的基础测试类。例如:

```python

class BaseTestCase(unittest.TestCase):

# 共享的测试逻辑

pass

class TestFeatureA(BaseTestCase):

# 特定功能的测试

pass

class TestFeatureB(BaseTestCase):

# 另一个特定功能的测试

pass

```

这种策略有助于减少重复代码,并且当共享的测试逻辑需要修改时,只需要修改一处即可。

#### 3.3 异常处理和测试

异常处理是测试中不可忽视的一部分,它帮助我们验证代码在面对错误输入或异常情况时的健壮性。

##### 3.3.1 异常处理的重要性

在软件开发中,异常处理是保证程序稳定运行的关键。在测试中,我们不仅需要验证功能的正确性,还需要验证代码在遇到错误或异常时的表现。

##### 3.3.2 测试异常的技巧

测试异常通常涉及到模拟异常的发生,并验证代码是否能够正确处理这些异常。例如:

```python

import pytest

def test_division_by_zero():

with pytest.raises(ZeroDivisionError):

1 / 0

```

在这个例子中,我们使用`pytest`的`raises`函数来测试除以零时是否会抛出`ZeroDivisionError`异常。

##### 3.3.3 错误和失败的区分

在测试中,错误(error)和失败(failure)是两个不同的概念。错误通常是指测试代码中的问题,而失败是指被测试的代码行为与预期不符。理解这两者的区别有助于我们更有效地进行故障排查。

通过本章节的介绍,我们可以看到,高级的测试技巧可以帮助我们编写更加强大和灵活的测试用例。参数化测试提高了测试的可复用性,模块化和可重用性策略简化了测试代码的管理,而异常处理则确保了测试的全面性。在接下来的章节中,我们将继续探讨如何优化测试用例的性能,并实现测试的自动化和集成。

# 4. 测试用例的性能优化

## 4.1 性能测试基础

### 4.1.1 性能测试的定义和目标

性能测试是一种软件测试方法,用于确定系统、子系统或组件在特定条件下的性能特征。这些特征可能包括响应时间、吞吐量、稳定性、资源消耗和可扩展性。性能测试的目标是验证系统是否满足性能要求,并识别性能瓶颈和改进领域。

### 4.1.2 性能测试的类型

性能测试可以分为几种类型,包括负载测试、压力测试、稳定性测试和并发测试。每种测试类型都有其特定的目的和方法:

- **负载测试**:确定系统在预期最大负载下的性能。

- **压力测试**:确定系统在超过预期最大负载时的表现。

- **稳定性测试**:验证系统在长时间运行下的性能和稳定性。

- **并发测试**:检查多用户同时访问系统时的性能。

### 4.1.3 性能测试的工具

性能测试通常需要使用专门的工具来模拟用户负载并收集性能数据。一些常用的性能测试工具包括:

- **JMeter**:一个开源的负载和性能测试工具,适用于各种应用程序和服务。

- **LoadRunner**:由HP开发的性能测试工具,可以测试多种协议和应用程序类型。

- **Gatling**:一个基于Scala的高性能、开源的负载测试工具。

### 4.1.4 性能测试的流程

性能测试的流程可以概括为以下步骤:

1. **定义性能测试目标**:明确要测试的性能指标。

2. **设计性能测试场景**:根据测试目标设计测试用例。

3. **搭建测试环境**:配置测试所需的软硬件环境。

4. **实施性能测试**:执行测试用例并收集性能数据。

5. **分析测试结果**:分析性能数据,确定系统性能瓶颈。

6. **优化和调整**:根据测试结果优化系统并调整配置。

### 4.1.5 性能测试的挑战

性能测试面临的挑战包括但不限于:

- **环境配置**:确保测试环境与生产环境尽可能相似。

- **测试数据的准备**:生成真实、有效的测试数据。

- **并发用户模拟**:准确模拟并发用户的行为和负载。

- **性能瓶颈分析**:准确识别性能瓶颈并提出有效的优化方案。

### 4.1.6 性能测试的实践案例

以下是一个使用JMeter进行负载测试的实践案例:

```markdown

### 使用JMeter进行负载测试的实践案例

#### 1. 定义测试目标

确定需要测试的API的响应时间、吞吐量等性能指标。

#### 2. 设计测试场景

设计测试场景,包括用户数量、请求类型等。

#### 3. 搭建测试环境

安装并配置JMeter和相关的插件。

#### 4. 实施性能测试

使用JMeter创建测试计划,配置线程组、监听器等组件,并执行测试。

#### 5. 分析测试结果

通过JMeter的监听器和聚合报告分析测试数据,识别性能瓶颈。

#### 6. 优化和调整

根据分析结果对系统进行优化,例如增加服务器资源或调整代码。

#### 7. 总结

总结性能测试的结果,并记录优化前后的性能数据。

```

## 4.2 性能测试用例设计

### 4.2.1 性能测试场景设计

设计性能测试场景时,需要考虑以下因素:

- **用户行为**:模拟用户的真实行为模式。

- **数据集**:使用真实和合理的数据集。

- **测试目标**:明确每个场景的性能目标。

- **监控指标**:确定要监控和记录的性能指标。

### 4.2.2 性能测试指标

性能测试的指标包括:

- **响应时间**:系统对请求的响应时间。

- **吞吐量**:单位时间内处理的请求数量。

- **资源消耗**:CPU、内存、磁盘和网络资源的使用情况。

- **错误率**:请求失败的比例。

- **成功率**:请求成功的比例。

### 4.2.3 性能测试报告

性能测试报告应该包括:

- **测试概览**:测试目的、环境、时间等基本信息。

- **测试结果**:详细的性能数据和图表。

- **瓶颈分析**:性能瓶颈的详细分析和解释。

- **优化建议**:基于测试结果提出的优化建议。

## 4.3 性能优化实践

### 4.3.1 代码级别的性能优化

代码级别的性能优化通常涉及以下方面:

- **算法优化**:选择更高效的算法和数据结构。

- **循环优化**:减少循环中的计算量,避免不必要的循环。

- **数据库查询优化**:优化SQL查询,使用索引等。

- **内存管理**:避免内存泄漏,优化内存分配和释放。

### 4.3.2 测试过程的性能优化

测试过程中的性能优化可以包括:

- **测试数据生成**:使用高效的数据生成工具和方法。

- **并发用户模拟**:使用并发测试工具模拟真实用户负载。

- **测试脚本优化**:优化测试脚本,减少不必要的操作和资源消耗。

### 4.3.3 测试工具的选择和使用

选择合适的测试工具对于性能优化至关重要。以下是一些选择测试工具时应考虑的因素:

- **支持的协议**:工具是否支持测试的应用程序使用的协议。

- **可扩展性**:工具是否支持大型测试和复杂场景。

- **易用性**:工具是否易于学习和使用。

- **社区支持**:工具是否有活跃的社区和丰富的资源。

- **成本**:考虑工具的成本和预算。

### 4.3.4 优化案例分析

以下是一个优化Web应用响应时间的案例分析:

```markdown

### 优化Web应用响应时间的案例分析

#### 1. 问题识别

识别应用中响应时间过长的环节。

#### 2. 性能瓶颈分析

使用性能分析工具(如gprof或Valgrind)分析瓶颈原因。

#### 3. 优化方案制定

根据分析结果,制定具体的优化方案。

#### 4. 代码修改和测试

修改代码并进行回归测试,验证优化效果。

#### 5. 性能监控

在生产环境中监控应用的性能,确保优化效果。

#### 6. 总结

记录优化过程和结果,为未来优化提供参考。

```

通过本章节的介绍,我们了解了性能测试的基础知识、性能测试用例的设计以及性能优化的实践方法。性能优化是一个持续的过程,需要结合实际的测试结果和生产环境的数据进行不断的调整和改进。

# 5. 测试用例的自动化和集成

## 5.1 测试自动化框架

### 5.1.1 测试自动化的概念

测试自动化是指使用特定的软件工具,将手动执行的测试用例转换为自动执行的过程。这种方式可以显著提高测试效率,减少重复性工作,并且在持续集成和持续交付的软件开发流程中发挥关键作用。

### 5.1.2 自动化测试框架的选择

选择合适的自动化测试框架是实现测试自动化成功的关键。常见的自动化测试框架包括Selenium、Appium、JUnit、TestNG等。选择时需要考虑以下因素:

- **测试需求**:框架应支持所需的测试类型,如UI测试、API测试等。

- **社区和支持**:活跃的社区和良好的技术支持可以解决遇到的问题。

- **学习曲线**:框架的学习曲线应尽可能平缓,以便团队成员快速上手。

- **工具集成**:框架应能与其他开发工具如版本控制系统、持续集成工具等集成。

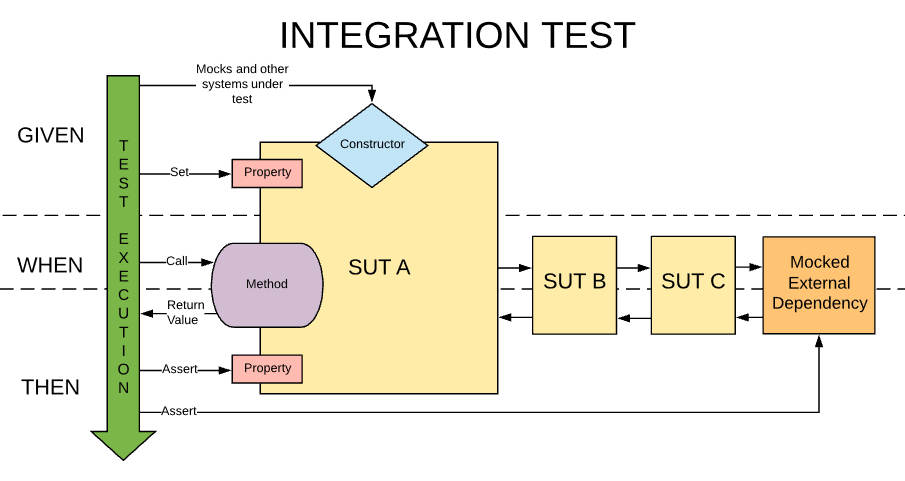

## 5.2 集成测试的策略

### 5.2.1 集成测试的类型

集成测试是在单元测试之后进行的测试,目的是验证不同模块或组件之间能否正确协同工作。常见的集成测试类型包括:

- **自顶向下**:从系统的顶层开始,逐步向下集成。

- **自底向上**:从系统的底层模块开始,逐步向上集成。

- **三明治集成**:结合自顶向下和自底向上,先集成核心模块,再集成周边模块。

### 5.2.2 集成测试的步骤和技巧

集成测试的步骤通常包括:

1. **环境准备**:确保测试环境搭建正确,所有依赖项可用。

2. **测试计划**:制定详细的集成测试计划,包括测试用例和测试数据。

3. **执行测试**:按照测试计划执行集成测试,并记录结果。

4. **问题定位**:对失败的测试用例进行分析,定位问题所在。

技巧方面,可以考虑以下几点:

- **分阶段集成**:将大型系统分解为多个模块,分阶段进行集成。

- **持续集成**:使用持续集成工具如Jenkins,自动化集成测试过程。

- **回归测试**:确保每次集成后的系统功能不受影响。

## 5.3 持续集成与测试

### 5.3.1 持续集成的概念和优势

持续集成(CI)是一种软件开发实践,要求开发人员频繁地将代码变更集成到主分支上。这样可以快速发现并解决集成问题,提高软件质量。CI的优势包括:

- **快速反馈**:及时发现代码中的问题。

- **降低风险**:减少集成问题带来的风险。

- **自动化流程**:自动化构建和测试流程,提高效率。

### 5.3.2 持续集成环境的搭建

搭建持续集成环境通常需要以下步骤:

1. **选择CI工具**:如Jenkins、Travis CI、CircleCI等。

2. **配置构建服务器**:安装必要的软件,配置环境变量。

3. **编写构建脚本**:定义编译、测试、打包等构建步骤。

4. **集成源代码管理**:将构建脚本集成到源代码管理系统,如Git。

### 5.3.3 持续集成中的测试实践

在持续集成中,测试是不可或缺的一环。以下是实践中的关键点:

- **自动化测试**:包括单元测试、集成测试、性能测试等。

- **测试报告**:生成测试报告,以便于问题追踪和质量评估。

- **反馈机制**:将测试结果反馈给开发人员,及时修复问题。

```mermaid

graph TD

A[开始] --> B[选择CI工具]

B --> C[配置构建服务器]

C --> D[编写构建脚本]

D --> E[集成源代码管理]

E --> F[自动化测试]

F --> G[生成测试报告]

G --> H[反馈机制]

H --> I[结束]

```

以上就是关于测试用例的自动化和集成的详细介绍。通过本章内容,我们可以了解到测试自动化框架的选择、集成测试的策略以及持续集成与测试的实践。这些知识和技巧对于提高软件测试的效率和质量具有重要意义。

0

0