【深度学习盲点】:揭秘模型解释性障碍,打造可解释的AI未来

发布时间: 2024-09-02 02:51:37 阅读量: 112 订阅数: 47

深度学习:培养学生的思维品质.pdf

# 1. 深度学习模型解释性的必要性

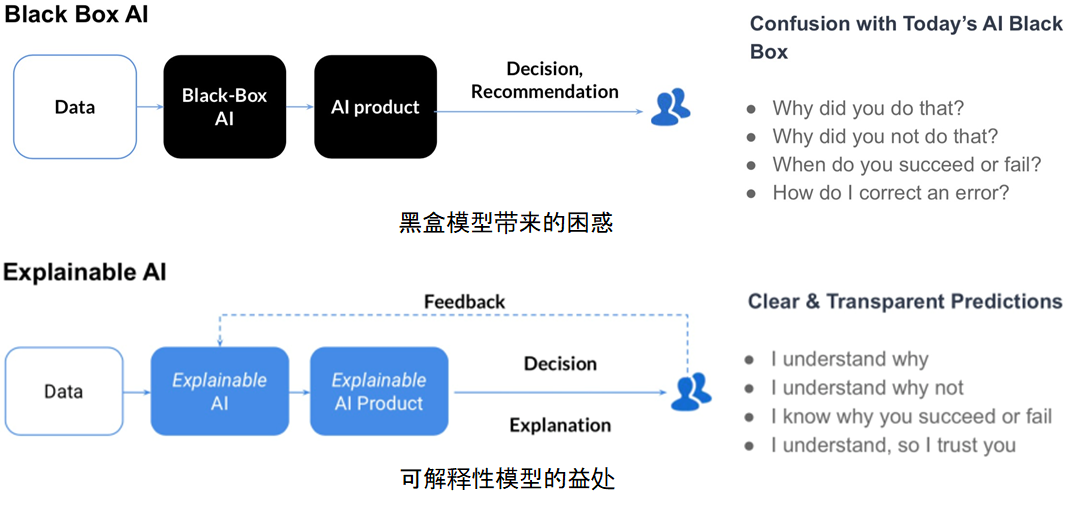

随着人工智能技术的快速发展,深度学习模型在各个领域得到了广泛的应用,从医疗诊断到自动驾驶,从金融风险评估到个性化推荐系统。然而,深度学习模型由于其复杂性和黑盒特性,常常让开发者和用户对其决策过程感到困惑,这种困惑直接导致了对模型的信任缺失。因此,深度学习模型的解释性变得尤为重要。

解释性不仅仅是帮助我们理解模型是如何工作的,它还涉及到如何增强模型的透明度,建立用户和AI系统之间的信任。此外,解释性在满足伦理法规要求、提升模型的可靠性和公正性方面也扮演着关键角色。

在这一章中,我们将深入探讨深度学习模型解释性的必要性,并分析它对AI技术发展的长远影响。我们将简要介绍模型透明度和信任的重要性,以及解释性对AI伦理和法规的影响,为理解深度学习模型解释性的重要性奠定基础。

# 2. 深度学习中的解释性理论基础

深度学习领域的快速发展带来了对复杂模型的广泛应用,但随着模型的深度和复杂度的提升,模型的决策过程变得更加不透明,即所谓的“黑盒”问题。为了建立用户对AI模型的信任,确保AI系统的公正性和责任性,模型解释性的研究变得尤为重要。本章节将深入探讨解释性在AI中的角色和重要性、模型解释性面临的障碍,以及解释性理论框架的构成。

## 2.1 解释性在AI中的角色和重要性

### 2.1.1 模型透明度和信任的建立

透明度是建立信任的关键要素之一。在AI决策过程中,如果缺乏透明度,用户可能会对AI做出的决策持怀疑态度。解释性提供了一种方法,将复杂模型的决策逻辑翻译成易于理解的形式,让用户能够理解AI的决策过程,从而建立起对模型的信任。

**案例分析:** 在医疗领域,使用深度学习模型进行疾病预测时,医生和患者需要了解模型的决策依据来建立信任。通过解释性技术,医生可以了解哪些因素对预测结果有重大影响,从而做出更明智的决策。

### 2.1.2 解释性对AI伦理和法规的影响

随着人工智能的广泛应用,伦理和法规问题日益凸显。解释性可以帮助确保AI系统符合伦理和法规要求,尤其是在涉及隐私、偏见和公平性的问题上。

**法规遵从:** 例如,在欧洲通用数据保护条例(GDPR)中,数据主体有权获得对其个人数据处理的解释。这意味着任何使用AI处理个人数据的组织都需要能够解释其模型的决策。

## 2.2 深度学习模型解释性障碍

### 2.2.1 黑盒模型的问题

深度学习模型,特别是神经网络,常常因为其复杂的内部结构而被视为“黑盒”。这种复杂性使得理解模型的内部工作机制变得非常困难。

**挑战:** 解释这些模型的挑战在于找到一种方法,能够在不牺牲太多性能的情况下,揭示模型的内部决策逻辑。

### 2.2.2 模型复杂性与可解释性之间的权衡

在深度学习中,模型的性能往往与其复杂性成正比。增加网络的深度和宽度可以提高预测精度,但同时也会降低模型的可解释性。因此,研究者在设计模型时需要在性能和可解释性之间进行权衡。

**权衡策略:** 一些策略如模型简化、蒸馏技术和模块化设计,被提出以在保持模型性能的同时提高其可解释性。

## 2.3 解释性理论框架

### 2.3.1 本地解释与全局解释的差异

在深度学习中,解释性可以分为本地解释(对单个预测的解释)和全局解释(对整个模型的解释)。

- **本地解释**关注于解释模型对特定输入的预测,例如,通过梯度上升法强调对分类结果影响最大的像素。

- **全局解释**则尝试理解整个模型的工作原理,这通常通过模型简化或提取高级特征来实现。

### 2.3.2 常见的解释性模型和方法

解释性模型和方法是多样的,主要可以分为以下几类:

- **模型特异性方法**:这类方法依赖于模型的内部结构,如神经网络的反向传播机制。

- **模型不可知方法**:这类方法不依赖于模型的内部结构,可以应用于任何类型的模型,例如局部可解释模型-附加树(LIME)。

- **可视化技术**:这类技术通过图像展示模型的特征激活,帮助解释模型预测结果的原因。

**代码示例:** 以下是一个使用LIME对图像分类模型进行本地解释的Python代码示例:

```python

import lime

import lime.lime_image

from keras.applications.vgg16 import VGG16, preprocess_input, decode_predictions

from keras.preprocessing import image

import numpy as np

# 加载预训练的VGG16模型

model = VGG16()

# 加载一张图片

img_path = 'path_to_image.jpg'

img = image.load_img(img_path, target_size=(224, 224))

# 预处理图片

x = image.img_to_array(img)

x = np.expand_dims(x, axis=0)

x = preprocess_input(x)

# 生成局部解释

explainer = lime.lime_image.LimeImageExplainer()

explanation = explainer.explain_instance(np.array(img), model.predict, top_labels=5, hide_color=0, num_samples=1000)

# 显示解释结果

temp, mask = explanation.get_image_and_mask(***_labels[0], positive_only=True, num_features=10, hide_rest=True)

img_bound = np.zeros((224, 224, 3))

img_bound[:, :, :] = (0, 0, 0)

img_bound[mask == 255] = img

print(explanation.local_pred[0])

# 显示图片

from skimage.segmentation import mark_boundaries

import matplotlib.pyplot as plt

plt.imshow(mark_boundaries(img_bound.astype('uint8'), temp))

plt.show()

```

在上面的代码示例中,LIME用于解释一个预训练的VGG16模型对特定图片的预测结果。代码首先加载并预处理了图片,然后通过LIME生成了该图片的局部解释。解释结果以图像的形式展示,其中高亮的部分表示对模型预测结果影响最大的区域。

通过这些方法,我们可以更深入地理解深度学习模型的决策机制,从而在必要时对模型做出调整,确保其更加符合预期的可解释性要求。

# 3. 深度学习模型解释性技术实践

## 3.1 特征重要性评估方法

### 3.1.1 基于梯度的方法

在深度学习模型中,理解各个特征对于模型输出的贡献程度是至关重要的。一种流行的方法是使用梯度相关的技术来评估特征的重要性。具体来说,梯度可以衡量损失函数相对于输入特征的敏感度,因而可以用来评价特征对预测结果的影响。

例如,对于图像识别任务,可以使用Saliency Maps方法。它通过计算模型输出对于输入图像的梯度来强调图像中的重要部分。

```python

import torch

import torchvision.models as models

from torchvision.utils import make_grid

import matplotlib.pyplot as plt

from PIL import Image

import requests

from io import BytesIO

# 加载预训练的模型和图像

model = models.resnet50(pretrained=True)

model.eval()

url = '***'

response = requests.get(url)

img = Image.open(BytesIO(response.content))

# 将图片转换为模型输入的张量格式

def image_to_tensor(image):

preprocess = ***pose([

transforms.Resize(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),

])

return preprocess(image).unsqueeze(0)

tensor_img = image_to_tensor(img)

tensor_img.requires_grad_(True)

# 通过模型预测和反向传播得到梯度

output = model(tensor_img)

output[0,torch.argmax(output)].backward()

# 提取梯度并可视化

gradients = tensor_img.grad[0]

saliency = torch.mean(gradients, dim=0)

saliency = torch.clamp(saliency, min=0)

# 将梯度可视化并显示图像

saliency_map = torch.unsqueeze(saliency, 0)

plt.imshow(saliency_map.detach().numpy().squeeze())

plt.show()

```

在这个代码示例中,首先加载了一个预训练的ResNet50模型。然后,对一张狗的图片进行了预处理,使其符合模型的输入要求。接着,通过模型得到预测并计算梯度。最后,可视化了梯度结果,突出显示了图像中的关键区域。参数说明包括图像预处理的具体步骤,这些步骤对于确保梯度计算的准确性至关重要。

### 3.1.2 基于扰动的方法

基于扰动的方法是另一种评估特征重要性的技术。与基于梯度的方法不同,基于扰动的方法通过在输入数据上进行小的改变,然后观察输出结果的变化,来评估特征的重要性。

比如,一个简单直观的方法是,随机地将输入特征置零或者替换为平均值,观察预测结果的变化。如果置零某个特征后,预测结果的变动较大,那么这个特征就被认为是重要的。

```python

# 以简单的线性模型为例展示扰动法

import numpy as np

# 假设x是输入特征,y是目标变量

x = np.random.rand(10) # 随机生成一些特征

y = 2 * x[0] + 3 * x[1] + 0.5 * x[2] + np.random.randn() * 0.1 # 假设真实的模型是 y = 2x1 + 3x2 + 0.5x3

# 扰动特征并重新预测

x_permuted = np.copy(x)

x_permuted[0] = 0 # 将第一个特征置零

y_permuted = 2 * x_permuted[0] + 3 * x_permuted[1] + 0.5 * x_permuted[2] + np.random.randn() * 0.1

# 计算预测变化

print("原始预测值:", y)

print("扰动后的预测值:", y_permuted)

print("预测变化:", y_permuted - y)

```

在这个例子中,首先随机生成了一个输入特征向量`x`和目标变量`y`。然后,通过将`x`的第二个元素置零(假设x[0]是重要的特征),我们得到了一个新的预测值。通过比较原始预测值和扰动后的预测值之间的差异,可以对特征的重要性进行定量分析。参数说明涉及了原始特征向量和目标变量的生成过程,以及如何通过简单操作模拟特征扰动。

## 3.2

0

0