【习题集:计算机组成原理】:答案的全面解析与深入理解

24年王道计算机组成原理基础考点讲解课件

摘要

本文系统地介绍了计算机组成原理的基础知识,详细解析了数据表示、处理单元、存储系统、指令系统、微程序控制以及输入输出系统等关键概念。通过分析不同的存储器结构、指令集架构和总线技术,本文阐述了优化计算机性能的各种策略,并对高速缓存、虚拟内存、指令流水线等技术进行了深入探讨。此外,本文还提供了现代计算机系统架构的实例分析,讨论了性能评估方法和系统优化策略,以及如何解决习题集中的经典问题,旨在加深理解并应用所学知识。

关键字

计算机组成原理;数据表示;处理单元设计;存储系统优化;指令集架构;性能评估;系统优化策略

参考资源链接:《计算机组成原理》(白中英版)课后习题及答案解析

1. 计算机组成原理基础概述

计算机科学的核心在于如何通过物理硬件执行高级逻辑操作。本章旨在为读者提供计算机组成原理的基础知识,为深入理解数据表示、存储系统、指令系统和输入输出系统等复杂概念打下坚实基础。

1.1 计算机硬件基本结构

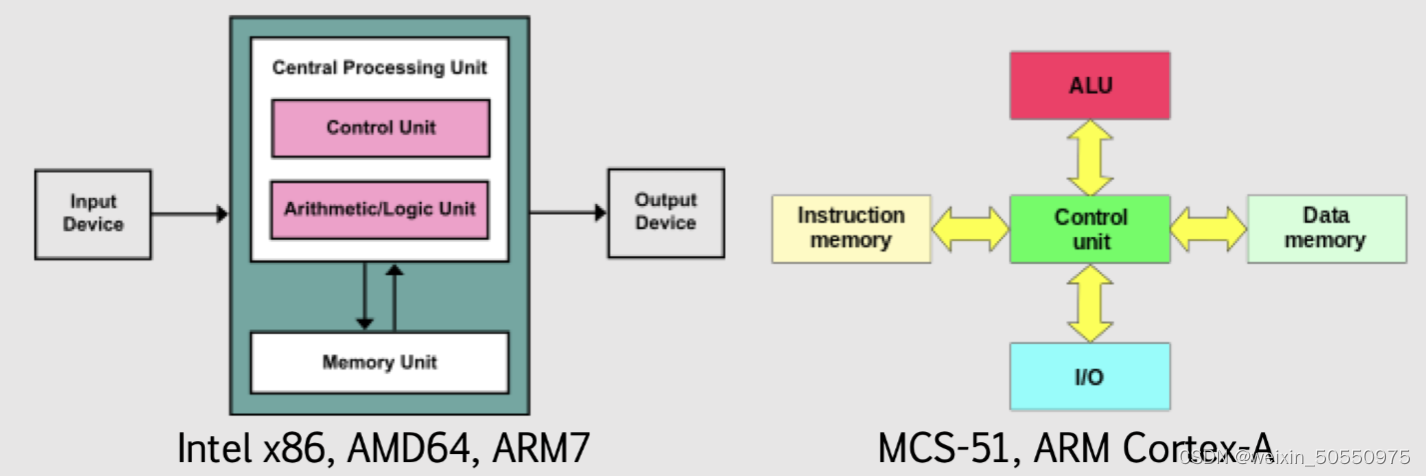

计算机硬件基本结构包括输入设备、输出设备、中央处理单元(CPU)以及主存储器。这些组件协同工作,使得计算机能够执行各种计算任务。CPU作为整个系统的“大脑”,负责解释和执行指令,它自身又由运算器、控制器和寄存器组构成。

1.2 数据的流动与处理

在计算机内部,所有的数据都以二进制形式存在,这些数据在不同的硬件组件之间流动,并在CPU内部的运算器和控制单元进行处理。理解这些数据的流动和处理机制是深入研究计算机组成原理的前提。

1.3 硬件与软件的协作

硬件是计算机的物质基础,而软件定义了其功能和用途。软件指令通过计算机语言被翻译成机器语言,由硬件执行。软件和硬件之间的这种协作关系是现代计算机科学的核心原理之一。

本章为理解后续章节内容提供了必要的背景知识,为深入探讨计算机科学的各个方面奠定了基础。

2. 数据表示与处理单元解析

2.1 数据在计算机中的表示方法

2.1.1 二进制系统基础

在计算机科学中,二进制是一种基础的数值表示方法,其仅包含两个数字:0和1。计算机使用二进制系统是因为它能够使用两种稳定的状态来表示数据,这通常对应于电子电路中的两种电压级别,例如高电压代表1,低电压代表0。这种表示方法简化了逻辑电路设计,使计算机硬件能够高效地执行运算和存储数据。

为了理解二进制系统,我们可以从其数学基础开始。在二进制中,每一位(bit)的位置代表了2的幂次方,从右向左数,第一位是2的0次方(即1),第二位是2的1次方(即2),以此类推。因此,二进制数1011可以表示为:

1 * (2^3) + 0 * (2^2) + 1 * (2^1) + 1 * (2^0) = 8 + 0 + 2 + 1 = 11(十进制)

这意味着,即使在计算机中处理的是二进制数,我们也可以轻松地将它们转换为十进制数,以便更好地理解和分析。此外,二进制数在计算机中可以通过位操作指令进行快速处理,例如位与(AND)、位或(OR)、位非(NOT)和位异或(XOR)操作。

二进制系统的另一个关键特性是其位的组合能力。例如,在一个字节(byte)中,我们有8位,这允许表示2^8即256种不同的值。这为计算机提供了广泛的数值范围,能够精确地表示各种数据类型,包括整数、字符和颜色值等。

2.1.2 数据编码与字符表示

计算机内部处理的不仅仅是数字,还包括各种字符和符号。为了在二进制系统中表示这些复杂的字符,我们需要使用编码方案。ASCII(American Standard Code for Information Interchange)是一种常见的字符编码方案,它为每个字符分配了一个唯一的7位二进制数。由于计算机处理的是8位一组的数据,因此ASCII通常使用一个字节来存储一个字符,额外的位用作校验或保留。

随着计算机的国际化需求,ASCII的7位编码空间已经不能满足要求,因此产生了扩展的字符集,如Unicode。Unicode为每个字符分配了一个唯一的、标准的数值,通常用一个或多个字节表示。这使得它能够表示世界上几乎所有的文字系统,包括中文、阿拉伯文和日文等。

Unicode具有多种编码形式,最常用的是UTF-8。UTF-8是一种变长的字符编码,它能够用1到4个字节表示一个字符,这使得UTF-8非常灵活并且向后兼容ASCII。由于其兼容性和效率,UTF-8已经成为互联网上最广泛使用的字符编码。

2.2 运算器与逻辑单元设计

2.2.1 基本算术逻辑单元(ALU)结构

算术逻辑单元(ALU)是处理器中最关键的部分之一,它负责执行所有的算术和逻辑运算。ALU的核心由一系列逻辑门(如AND门、OR门和NOT门)以及算术组件(如全加器和半加器)构成。这些基本组件能够组合起来执行更复杂的操作,例如整数的加法、减法、乘法、除法以及逻辑比较等。

ALU的设计要点之一是确保其能够高效地处理数据。这通常涉及到数据路径的优化,即确保数据能够在ALU的不同组件之间快速传输。另一个要点是控制单元的集成,控制单元负责解读指令并生成相应的控制信号,以指导ALU完成指定的操作。

为了提高性能,现代处理器内部的ALU通常被设计为能够并行处理多个操作。例如,它们可能包含多个算术逻辑部件(Arithmetic Logic Units, ALUs),每个都能独立完成运算任务,以此来实现指令级并行(Instruction-Level Parallelism, ILP)。

2.2.2 运算器的设计要点和性能分析

在设计ALU时,工程师必须平衡运算速度、功耗、成本和复杂度等多个因素。一个关键的设计目标是尽可能缩短运算延迟,这意味着在有限的时钟周期内完成运算。这通常涉及到运算路径的优化,以减少信号通过ALU的传输时间。

由于ALU是处理器中最为繁忙的部分之一,设计时还需要考虑其功耗。为了减少功耗,可能会采用各种节能技术,比如动态电压和频率调整(DVFS)、管脚复用技术和低功耗设计技术。

此外,ALU的设计还应具备良好的可扩展性,以便能够适应未来技术的发展。这意味着,它需要能够支持更高精度的运算,更复杂的指令集和更大的数据宽度。为了实现这一点,ALU通常会设计成模块化的组件,方便在未来进行升级和优化。

为了评估ALU的性能,工程师们会执行一系列测试,包括基准测试和实际应用场景的模拟。这些测试能够揭示ALU在不同工作负载下的表现,从而识别可能的性能瓶颈。对ALU的性能分析可以帮助设计师识别并改进设计中的不足之处,以构建出更加强大的处理器。

2.3 控制单元的工作原理

2.3.1 微操作序列与指令周期

控制单元(CU)是处理器中的另一个重要部分,它负责管理CPU内部各部件的操作,确保指令能够正确执行。控制单元的核心功能是生成一系列微操作(micro-operations),这些微操作是执行指令所需要的最基本步骤。

指令周期是控制单元工作的基础,它描述了CPU处理一条指令所需经历的阶段。一条指令的周期包括:取指(instruction fetch)、译码(decode)、执行(execute)、访问内存(memory access,如果需要的话),以及写回结果(write-back)。每个阶段都会伴随着特定的控制信号,这些信号由控制单元发出,控制数据路径中的数据流动。

取指阶段,控制信号使程序计数器(PC)的内容被送到地址总线上,以便从内存中读取指令。译码阶段,控制单元将从指令寄存器(IR)中取出的指令进行译码,生成相应的控制信号以驱动ALU或其他功能单元。执行阶段,这些控制信号决定了ALU进行哪种运算,或者是否需要从内存或I/O端口读写数据。

2.3.2 控制信号生成与控制单元设计

控制信号生成是控制单元中最复杂的部分之一,这涉及到指令译码逻辑的设计和时序控制。现代CPU使用复杂的微程序(microprogrammed)控制单元来生成控制信号。微程序控制单元包含一个存储了控制信号序列的存储器,这些控制信号序列被称为微程序。

当一条指令被译码后,控制单元会查找对应的微程序,并按照微程序中的步骤生成控制信号。微程序控制单元的另一个关键部分是微指令寄存器(micro-instruction register),它存储当前正在执行的微指令,并将其送往相应的控制逻辑生成所需的控制信号。

为了实现高效的控制信号生成,控制单元需要采用优化的微指令设计,确保指令之间的快速切换。此外,硬件优化技术,如流水线和超线程,也对控制单元的设计提出了新的挑战。控制单元的设计必须适应这些高级技术,以确保处理器能够充分利用现代技术的优势,实现性能的最大化。

控制单元的设计还应考虑到故障检测和恢复机制,以确保处理器在出现问题时能够正确地处理异常情况。这些机制可能包括错误检测和纠正代码(Error Detection and Correction, EDAC),以及状态保存和恢复逻辑。

通过上述章节的介绍,我们对数据表示、ALU和控制单元的结构和功能有了深入的理解。这些基础知识点不仅对理解