Hadoop大数据平台:分布式计算的利器,处理海量数据,挖掘数据价值

发布时间: 2024-07-01 15:28:32 阅读量: 75 订阅数: 28

用-Hadoop-进行分布式数据处理

# 1. Hadoop概述**

Hadoop是一个开源分布式计算框架,专为处理海量数据而设计。它提供了分布式文件系统(HDFS)和MapReduce编程模型,使组织能够高效地存储和处理大数据集。

Hadoop的优势在于其可扩展性、容错性和成本效益。它可以部署在廉价的商品硬件上,并随着数据量的增加而轻松扩展。此外,Hadoop的容错性确保了即使在节点故障的情况下,数据也能安全可靠地存储。

# 2. Hadoop核心组件

Hadoop是一个分布式计算框架,由多个核心组件组成,共同提供大数据处理和分析的能力。本章将深入探讨Hadoop的三个主要组件:Hadoop分布式文件系统(HDFS)、Hadoop MapReduce框架和Hadoop YARN资源管理框架。

### 2.1 Hadoop分布式文件系统(HDFS)

#### 2.1.1 HDFS架构和原理

HDFS是一个分布式文件系统,用于存储和管理大数据。它采用主从架构,由一个NameNode和多个DataNode组成。NameNode负责管理文件系统元数据,如文件位置和块信息,而DataNode负责存储实际的数据块。

#### 2.1.2 HDFS数据块管理

HDFS将文件划分为固定大小的块(默认512MB),并将其存储在DataNode上。每个块都有多个副本,以提高数据可靠性。NameNode维护块的位置信息,并负责副本管理。

### 2.2 Hadoop MapReduce框架

#### 2.2.1 MapReduce编程模型

MapReduce是一个编程模型,用于处理大数据集。它将计算任务分为两个阶段:

- **Map阶段:**将输入数据映射到键值对,并生成中间结果。

- **Reduce阶段:**对中间结果进行聚合、排序或其他操作,生成最终结果。

#### 2.2.2 MapReduce作业调度

Hadoop MapReduce框架负责调度和管理MapReduce作业。它将作业分解为多个任务,并将其分配给集群中的节点。框架还负责任务监控、容错和进度跟踪。

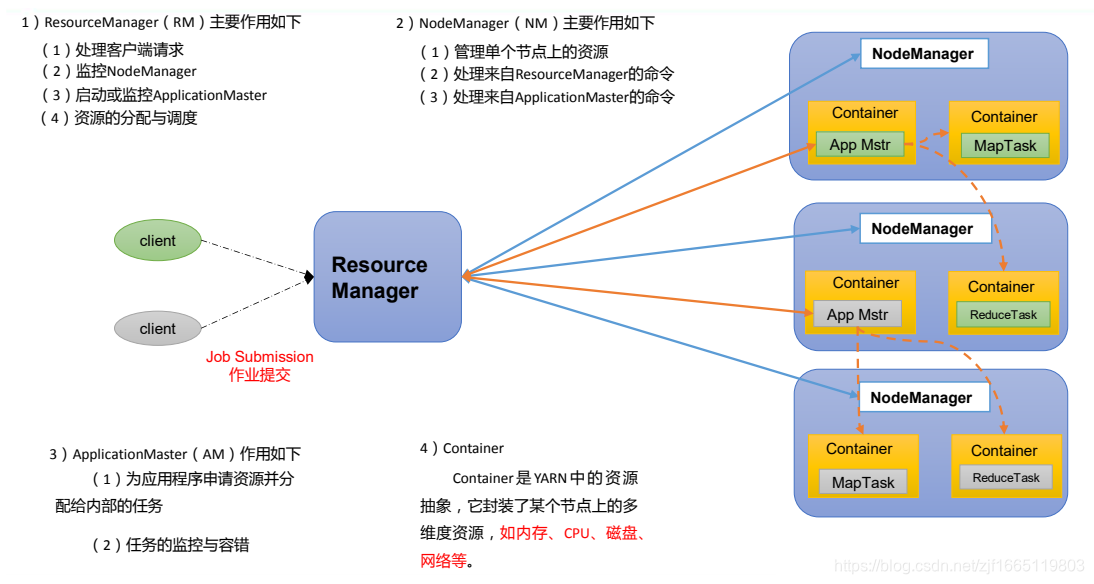

### 2.3 Hadoop YARN资源管理框架

#### 2.3.1 YARN架构和原理

YARN是一个资源管理框架,用于管理Hadoop集群中的资源。它将资源管理与作业调度分离,提高了集群利用率和灵活性。YARN由ResourceManager和NodeManager组成,ResourceManager负责资源分配,而NodeManager负责资源监控和管理。

#### 2.3.2 YARN资源调度算法

YARN采用公平调度算法,为作业分配资源。它考虑了作业优先级、资源需求和集群利用率等因素,以确保资源的公平分配和高效利用。

### 扩展性说明

**代码块:**

```java

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.hdfs.DistributedFileSystem;

import org.apache.hadoop.hdfs.protocol.HdfsFileStatus;

public class HdfsExample {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 创建分布式文件系统对象

DistributedFileSystem dfs = DistributedFileSystem.get(conf);

// 获取文件状态

HdfsFileStatus fileStatus = dfs.getFileStatus(new Path("/user/hadoop/input.txt"));

// 打印文件信息

System.out.println("文件大小:" + fileStatus.getLen());

System.out.println("块大小:" + fileStatus.getBlockSize());

System.out.println("副本数:" + fileStatus.getReplication());

}

}

```

**逻辑分析:**

该代码示例演示了如何使用HDFS API读取文件信息。它首先创建了一个配置对象,然后使用该配置对象创建了一个分布式文件系统对象。接下来,它使用该文件系统对象获取指定路径的文件状态。最后,它打印文件大小、块大小和副本数等文件信息。

**表格:**

| Hadoop组件 | 功能 |

|---|---|

| HDFS | 分布式文件系统 |

| MapReduce | 编程模型和作业调度 |

| YARN | 资源管理框架 |

**Mermaid流程图:**

```mermaid

sequenceDiagram

participant User

participant ResourceManager

participant NodeManager

User->ResourceManager: Submit MapReduce job

ResourceManager->NodeManager: Allocate resources for job

NodeManager->ResourceManager: Report resource usage

ResourceManager->NodeManager: Monitor job progress

NodeManager->ResourceManager: Report job completion

```

**参数说明:**

- `conf`:Hadoop配置对象

- `dfs`:分布式文件系统对象

- `fileStatus`:文件状态对象

- `path`:文件路径

# 3. Hadoop实践应用

### 3.1 Hadoop大数据存储和处理

#### 3.1.1 HDFS数据读写操作

**HDFS数据读

0

0